基于视频识别的远程课堂学习投入度分析研究

邓 伟,夏磊杰,刘清堂,张 思,魏艳涛

(华中师范大学 人工智能教育学部,湖北,武汉 430079)

一、研究背景

(一)同步课堂的远程学情感知问题

近年来,随着教育信息化建设的推进和智慧录播课堂的普及,同步课堂、在线学习等教学方式为分享优质教学资源,促进城乡教育均衡发展,实现教育过程与教育结果公平提供了可行路径[1]。然而同步课堂在实施过程中,师生处于隔离状态,输入班的学生与输出班的教师基本难以有效交流,大大影响了学生的参与意识[2]和教学效果。师生相互情绪的感知是教学交互的基础[3]。由于视频传输技术现状和教师教学负荷问题[4],异地课堂中教师难以通过远程视频实时掌握远端课堂的学生情绪[5]。许多研究者认识到了情绪感知与教学交互对提升同步课堂质量的重要作用[3],但大部分研究都通过教学设计和教学管理来加强同步课堂应用中教学交互[5-10],鲜有研究是从同步课堂中教师实时了解远端学情的需求出发。

在同步直播课堂中,为了提升教学效果,对远端学生的学习投入度进行实时测量和干预成为研究的热点。但是,目前远程课堂学习投入度的测量以教师主观经验为主,缺乏基于真实行为数据的客观表征,以及实时计算方法[3]。

本文从智能技术赋能课堂视频测评的视角入手,在阐释学生非言语行为表征课堂学情,分析学习行为投入度智能计算技术的现状及趋势的基础上,为基于视频识别的远程课堂学习投入度分析提供技术路径和实践经验。

(二)课堂非言语学习行为对课堂学情的表征

鉴于在同步远程课堂教学中学生不可能随便言语的特点,非言语行为成了远程课堂学生内心状况和意向的主要表露形式。Whitehill等[11]探讨了面部表情在教学中自动反馈的思想,探索了如何有效地使用自动实时面部表情识别来评估单个学生所感知的授课难度。海伦[12]列出了具体的头部运动可以在社会互动中所传递的“是/否”和各种意图的信号等。关于眼神,有学者提出人类眼睛注视最重要的一个方面是发出视觉注意力的信号[13]。身体姿势可以非言语表达我们的感受。[14]Mehrabian和Friar[15]报告说,大约55%的非语言交流是通过肢体语言来表达的。Thrasher和Marjolein[16]探讨了使用身体姿势和运动特征来捕捉听者的情感状态。胡小红[17]、韩丽等[18]利用表情识别技术来感知学生的情绪,设计了一个人脸检测与表情分析系统,该系统对课堂关注度、参与度、疑难度及活跃时间均可获得较准确的情感数据。以上研究表明,身体姿势和行为是学习情绪、状态的象征。在同步课堂直播环境下,受摄像头跟踪区域及分辨率限制,教师不能仔细地阅读异地学生的表情[19]。相比于细微的面部变化,人体姿势、动作提供了更大的研究领域[20]。

(三)在线学习投入度识别研究

迄今为止,对投入度多维框架的研究已相对成熟[21-22],其中,Fredricks等将投入度划分为行为、情感、认知三个维度,受到了研究者的广泛认可[23-24]。行为投入度通常用来描述学生学习时相关行为表现出的沉浸于学习的程度,如认真上课、完成任务、与同伴交流等。情感投入和认知投入反映了学生的内在投入,难以直接观察,而课堂行为投入可以通过外显行为来观察,如记录姿态、手势、表情的图像信息,记录操作行为、学习时长的在线日志数据等。

Ashwin和Guddeti[25]根据课堂视频中学生的脸部表情、手部姿势、身体姿势将学生的行为投入度分为四个等级,采用一种新的卷积网络框架进行行为投入度预测,使用三种数据的准确率达到71%,而仅使用手部姿势时准确率不足40%。Zaletelj和Košir[26]使用Kinect传感器收集课堂中学生的骨骼、视线、面部等信息,设计面部和身体姿势特征,并利用机器学习算法预测学生的高中低三种注意力水平,准确率达到了0.753。曹晓明等[27]收集被试学习中国大学MOOC课程时的脸部图像、脑电波数据和学习日志,使用Resnet深度神经网络融合三种特征预测学生的投入度,达到了87%的准确率,而单一使用脑电数据时准确率仅为60%。Whitehill等[11]利用webcam记录学生的面部表情,用于训练识别高-低投入度的模型,证实了采用机器学习技术评价投入度的方式准确率与人类观察者相当,2AFC值为0.729。总之,多模态比起单模态具备信息优势,但两者在投入度自动测量性能上都还有很大提升空间。

相比于在线日志数据、传感器数据,采集课堂视频数据的过程不会对教学产生干预,使得利用视频数据测量学习投入度的方法更适合同步课堂。课堂视频图像提供了很多学生的非言语信息,如头部姿势、面部表情、身体姿势、手部姿势等,这些非言语信息隐蔽但能客观地反映学生的投入度状态[11,25,26]。

(四)本文研究内容

教师只有感知远程视频中学生的情绪和学习状态,才能为远程教学交互和干预提供依据。本研究拟采用人工智能技术,来计算课堂教学视频中学生的投入度状态,为同步课堂的远程学情信息获取和教师教学干预提供技术和数据支持。

为了计算课堂教学视频中的学情状态,我们首先建立了课堂环境的投入度自动评价模型,然后研究机器学习方法来实现教学视频中的学生行为及学习投入度自动识别,最后将自动化远程学生行为投入度计算用于课堂视频分析,以探索本研究的效果和作用。

二、基于非语言行为的课堂学习行为投入度编码

研究者试图建立多维度的行为指标体系来评价学习投入的程度,如:李银玲等[28]将参与度分为表层参与和深层参与,表层参与为在线学习中学生的发帖回帖,浏览课程、论坛、资源,作业提交和分享的数量和占比,深层参与更注重参与的质量,通过发帖内容的个人陈述、反思、分享、互动情况进行人工分析与权重分配。杨九民等[8]根据学习者的在线互动行为将参与度分成高、中、低三个层次,通过将学生的发言内容确定为不同的互动类型并分配权重进行学生投入度的评价。张琪等[29]从信息交换活动过程出发,通过建立包含持续性、反思性、主动性、专注性的周期反馈循环模型来表征学习行为投入的水平。

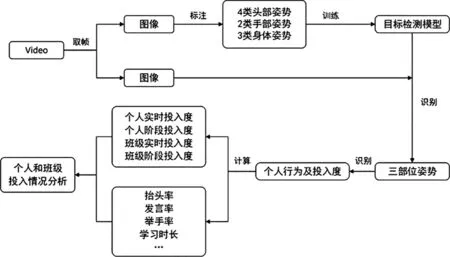

课堂学习者的外显行为包含了与教师、同伴、教学环境的交互,反映了学习者内部的认知和情感[8,23,28,29]。为了增强学生行为投入度的可解释性,本文采用学生的头部、手部和身体姿势来识别学生行为并预测行为投入度;基于这三种非语言线索来建立行为投入度评价体系,行为投入度标注方法,以及行为投入度分析方法。图1表示了采用本文方法预测和分析学生行为投入度的过程。

图1 行为投入度识别与分析流程图

(一)行为投入度测量维度

1.头部姿势:大脑是身体的中枢,有研究表明头部方向与视线注意力的方向密切相关[30],头部朝向学习资料、黑板、教师、同伴等不同方位代表了学生不同的行为并反映出不同的学习状态,如头部朝向教师反映了学生与教师的视线互动,朝向黑板的某位置则反映了学生正注意该部分内容,朝向地面可能反映其未学习的状态。已有学者基于头部姿态分析学生的投入度,如:左国才等[31]从学生侧脸专注度、学生抬头低头专注度、眼睛张合度专注度三个方面判断学生是否专注听课;Zaletelj等[26]将视线分成四个类别作为识别投入度的特征之一;唐康等[32]用抬头率指标来判别课堂的专注度。但是,单一的头部线索也存在局限,如低头无法简单判别为关注学习资料还是不听课状态,头部方向和视线方向也存在不一致的情况。本文将学生的头部姿态分成抬头、低头、回头和侧脸四种。

2.手部姿势:手势通常可指手臂、手掌、手指的姿势,这里我们仅使用了手臂姿势。课堂中,师生的言语行为常常伴随着手臂的举起、摆动,教师能通过手势引导学生注意力,增强语言感染力,辅助自身表达内容等,而学生的举手行为则被认为是学生参与和有效教学设计的重要指标[30,33]。本文将手部姿势分成平放和举手两种,重点考虑学生意图发言而产生的举手行为,不考虑其发言、讨论时或无意的手部姿态。

3.身体姿势:身体姿势是一个范围较大的概念,Randhavane等[34]使用学生的步态识别情绪,Mota和Picard[35]通过在座位上安装传感器收集学生的背部、臀部数据来识别学习者的兴趣水平,学生的身体姿态反映了情感和注意力状态。本文将学生的身体姿势分为站立、坐(无书本遮挡),坐(有书本遮挡),将其作为行为识别的辅助线索,站立发生在学生发言时,相比坐的状态表现了较高的投入水平。

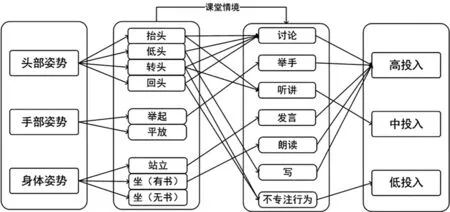

综上所述,单一姿态对投入程度的表征较为模糊(如抬头不一定比低头表示更高的投入度),而结合课堂情境和学生的多种行为可以给出更为合理的投入度估计。实际上,本文的投入度框架也是对课堂投入度人工评价过程的一种模拟,即利用课堂环境和三种非言语信息判断学生的行为,并据此给出投入度的判断。

本文根据三种非言语信息的不同组合推理出教学场景中最常出现的7类简单行为,各行为对应的投入度水平的打分方法见下文。如图2,通过头部、手部、身体姿态等局部姿态的不同组合,加上课堂情境信息来推断学生学习。图2表示了局部姿态、主要行为、行为投入度之间的关系。

图2 视觉局部姿态、主要行为、投入度水平的关系推理

(二)投入度评分方法

我们招募了22名教育技术专业学生为7类主要行为进行投入度评分,如果多名评分者对于某类行为评分的一致性较高,则该行为反映的投入程度可以用特定范围的值予以度量。首先将行为投入度E划分为四个等级,E∈{0-3};选择7类行为的单人图片,每一类图片5张,5张图片差异地表现了同一类行为,共35张图片,打乱顺序后由22名学生根据图像进行打分。数据筛选后,经过spss分析,得到21位评分者的α值为0.974,对于各类别,评分者的α值均在0.9以上,说明各类行为的投入度评分都具有较高的可信度。最后将每类行为的平均投入度水平作为最终的投入度值,定义0~1分为低投入,1~2分为中投入,2~3分为高投入,为了方便绘图和评分,将评分归一化后如表1所示。

表1 主要行为与投入度表

在图像中,头部姿势、手部姿势、身体姿势作为行为表现的主体,是投入度评分时最主要的信息依据。虽然对于各行为,评分者间都具有较高的一致性,但是行为内部还是存在细微的差异,如讨论发生时,评分者对转身、旁听、正面姿态的学生给予了不同的评分,这说明行为和姿态划分的粒度还有待细化,更多的视觉信息如眼神、表情等也被评分者下意识地关注。

(三)课堂学习行为投入度分析框架

已有投入度自动测量研究多是针对在线学习情境下的个体学习者。本研究将从个人和群体(班级),实时和阶段性两组相对概念去分析学生的投入度。对授课教师而言,分析个人投入度有助于把握个人学习情况,可用于促进个性化学习;分析班级投入度有助于把握整个班级上课的状态,如班级投入度的变化情况反映教学策略的效果;分析实时投入度有助于把握学生投入度动态变化情况,如进行学生之间的投入度变化的对比、不同教学活动下学生的投入度变化的对比;分析阶段性投入度统计有助于更宏观层面的分析。

1.个人实时投入度。个人实时投入度是指单个学生瞬时的投入度水平。根据图1和图2,目标检测模型会首先识别出单个学生各部位的姿态,并结合课堂整体情况来判断行为及给出实时投入度分值。

2.个人阶段性投入度。个人阶段性投入度是指以一堂课为时间单位统计个人投入度水平。在一堂课时间内统计学习时间、举手总次数、抬头率等课堂投入度指标,并为这些指标分配权重,来计算个人阶段性投入度得分。在这里,我们根据表1的投入度水平和式(1)进行计算。如一堂课40分钟,每隔24秒检测一次,每个人被检测到的行为数量为100个,“举手”3个,“发言”1个,“记笔记”60个,“听讲”36个,则个人总体投入度得分为(1*3+0.81*1+0.9*60+0.3*36)/100=0.69。以全程听讲作为基准,定义0.3以下为“不投入”,0.3~0.5为“比较投入”,0.5~0.75为“很投入”,0.75~1.0为“非常投入”,则可得到该学生的阶段性投入度水平为“很投入”。

个人阶段性投入度得分=∑(行为i的数量*对应投入度水平)/行为数量

(1)

式中i是行为类别,包括举手、听讲、发言等,共七类。

3.班级实时投入度。本文提出的班级投入度与小组投入度(group engagement)不同。小组投入度更加关注成员之间,成员与环境之间的互动[36-38]。由于现阶段人工智能技术无法准确识别成员之间的互动细节,本文班级投入度关注整个班级学生的投入度统计,即根据所有学生的单独表现计算班级投入度。班级实时投入度是指整个班级瞬时的投入度水平,可用式(2)计算得到。当进行分组活动时,也可以根据该公式简单得出各个小组的投入度水平。

班级实时投入度得分=∑个人实时投入度水平/班级人数

(2)

4.班级阶段性投入度。班级阶段性投入度是指以一堂课为时间单位的班级投入度水平,运用于以班级为单位开展的分析工作,如不同教师、不同课程情况下班级阶段性投入度比较。计算方式如式(3)。

班级阶段性投入度得分=∑班级实时投入度水平/时刻数

(3)

三、课堂教学视频中的教学行为识别流程

(一)数据收集

本研究使用的数据均来自于真实的课堂教学视频,包含了中学(初中和高中)和小学课堂,视频时长在45分钟,数量为50个。我们选取摄像头面向学生的视角,视频分辨率为1920*1080,质量较高。视频中学生数量在20~50人不等。

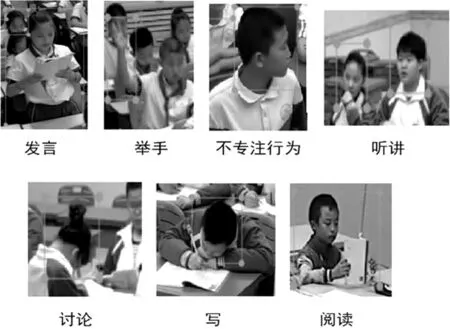

(二)数据标注

先对教学视频进行取图像帧操作,接着对图像中学生的三种姿态进行位置标注和类别标注。根据课堂观察,我们采取30秒取一帧图像的方式,这样可以避免短时间内动作变化不明显的问题。最后标注了500张静态图像,得到约15000个目标行为,7类主要行为的标注情况如图3所示。

图3 七类主要行为标注方法

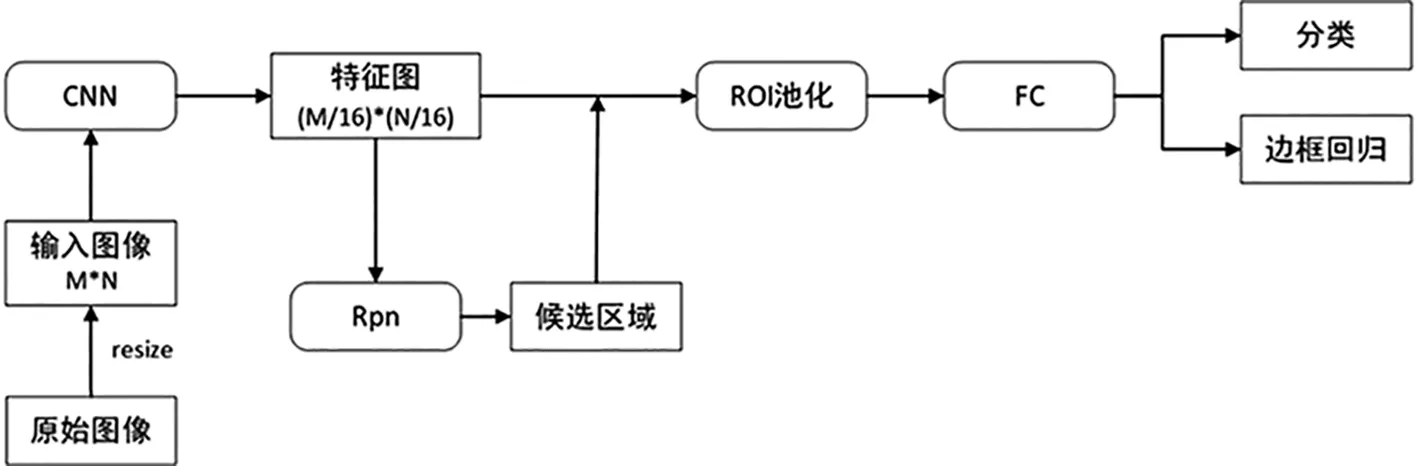

(三)学习行为目标检测网络

Ren等[39]提出的Faster R-cnn网络是深度学习时代经典的目标检测算法,其网络架构如图4所示。Faster R-cnn实现目标检测的过程是先将输入的图像统一大小(M*N),经过骨干卷积网络(VGG16)提取特征图(此处大小为M/16*N/16),使用区域提取网络(RPN)提取候选区域,通过ROIPooling层统一提取的特征区域大小,最后通过后续的全连接层进行分类和边框回归。本研究采用该框架进行学习行为识别,最终达到每帧0.2秒的检测速率,基本可以满足需求。另外,该框架对不同尺度的目标均有较好的效果,适用于真实课堂个体的身体部位尺度较小的现状。

图4 Faster R-cnn网络结构图

四、课堂教学视频中的教学投入度统计与可视化

选取十个课堂视频作为测试集,将每个视频每隔30秒取一帧,进行行为的检测率、识别准确率,教学行为统计,以及投入度统计与可视化表示实验。

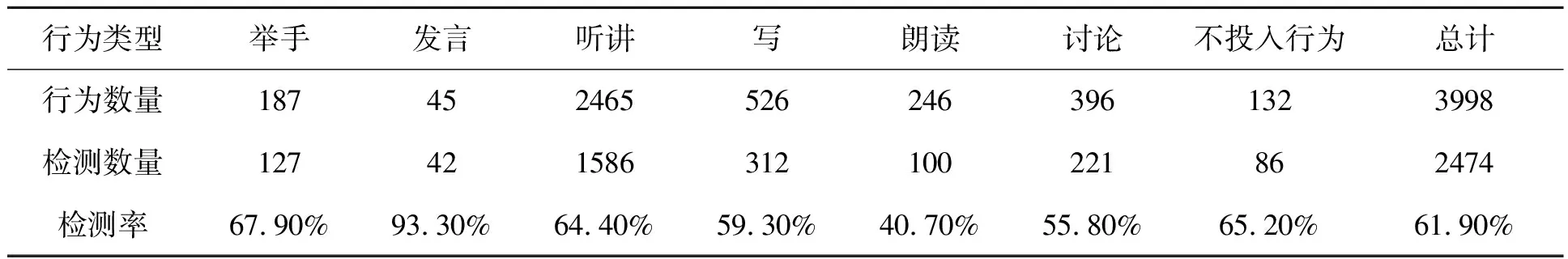

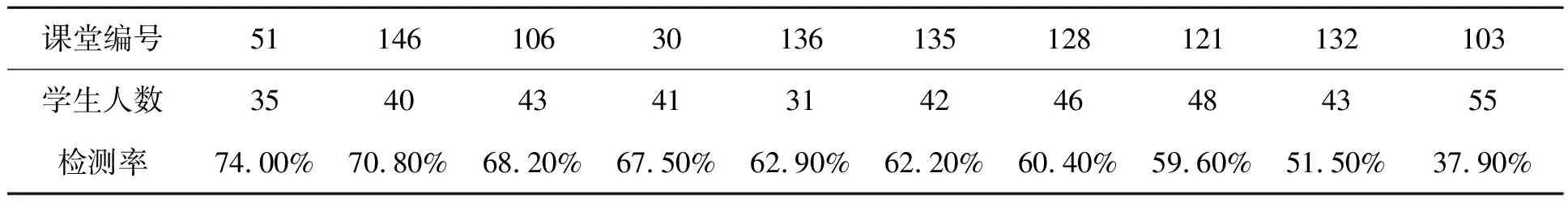

(一)行为检测率

为了对每一个学生进行个性化的投入度分析,需要提高目标行为的检测率。真实课堂环境下学生人数不同,行为遮挡情况也不同,我们统计了不同人数的课堂的检测效果,比较人数对该算法的影响。此外我们还比较了不同行为之间检测率是否有差异。结果如表2、表3所示。

表2 行为检测率统计表

表3 十堂课行为检测率统计表

通过分析结果发现:该方法的平均检测率为61.9%,说明行为检测的性能还有待增强;不同人数的课堂检测率没有明显的差异,而与课堂中行为的尺度和遮挡情况有较大的关联,如136号课堂人数较少但分布密集、尺度较小,检测率也较低;行为检测率与决定该行为的局部姿势有关,头部抬起相比头部低下更容易被检测到,所以听讲行为比写行为的检测率高;发言行为在七类行为中具有最高的检测率,达到93.3%,原因是识别发言行为主要依据“站立的姿势”这一特征,最不容易被遮挡;举手行为只比听讲行为的检测率略高,说明“手部举起”这一特征并不容易被检测到。所以本文方法在摄像视角适当,课堂人数少,座位排布分散等遮挡不严重的情况下表现更好。

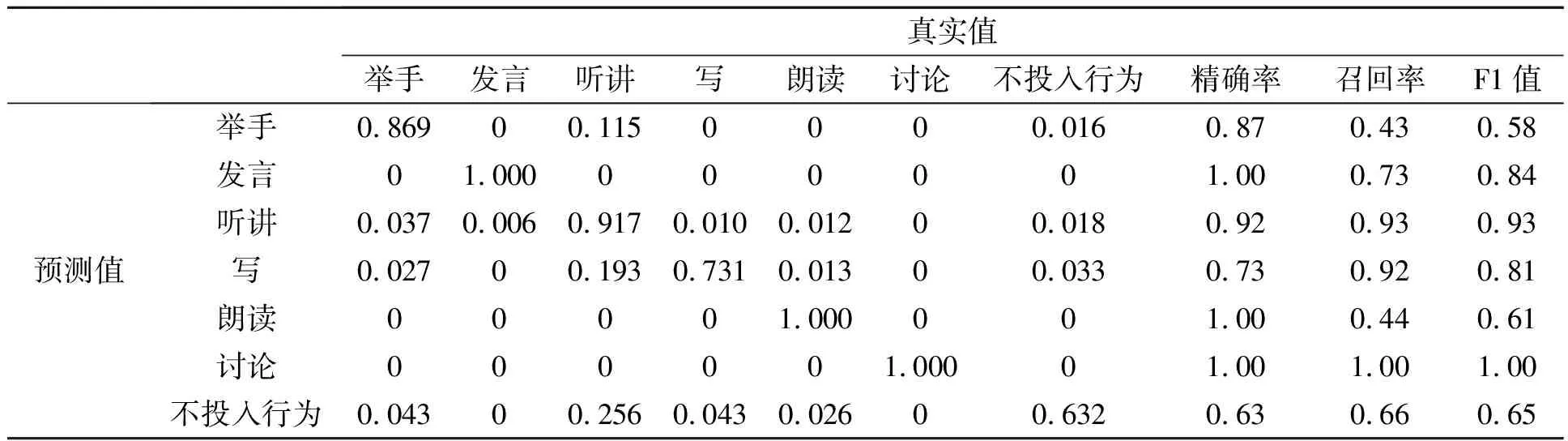

(二)行为识别精度

如表4是各行为的预测值和真实值组成的混淆矩阵,并显示了各行为的精确率、召回率和F1值。

精确率=预测该类正确的数量/预测为某类的总数量

(4)

召回率=预测该类正确的数量/真实为某类的总数量

(5)

F1值=2*精确率*召回率/(精确率+召回率)

(6)

表4 行为混淆矩阵

从表4可发现,除不投入行为,其他行为的精确率都较高,尤其是发言、听讲、朗读和讨论行为。写行为的预测中19.3%为听讲行为,说明低头和抬头的角度范围是有重叠的,当略微低头时就容易出现预测失误。

(三)投入度分析

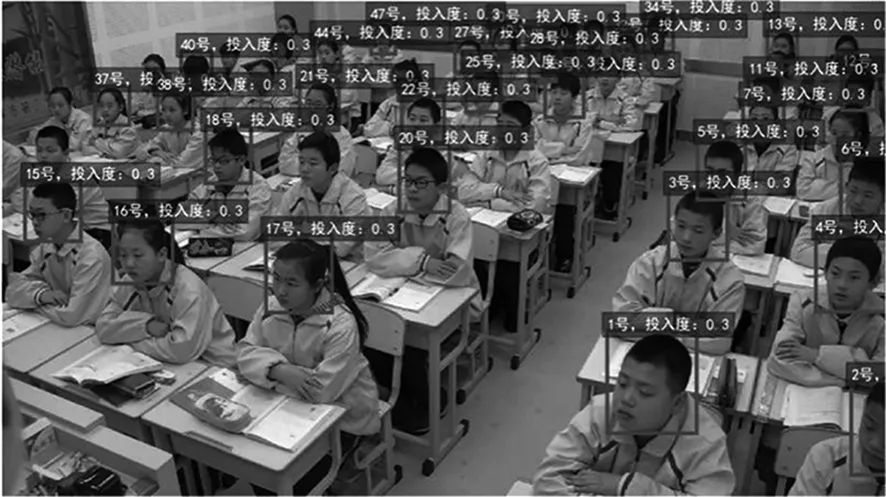

根据行为识别结果和表1可以得出每个学生的实时投入度,通过自动记录每个学生各个时刻的投入度水平和计算个人阶段性投入度水平,进而计算出班级实时投入度和阶段性投入度,图5是投入度识别结果,可以看到该时刻各个学生投入度水平和身份跟踪结果。

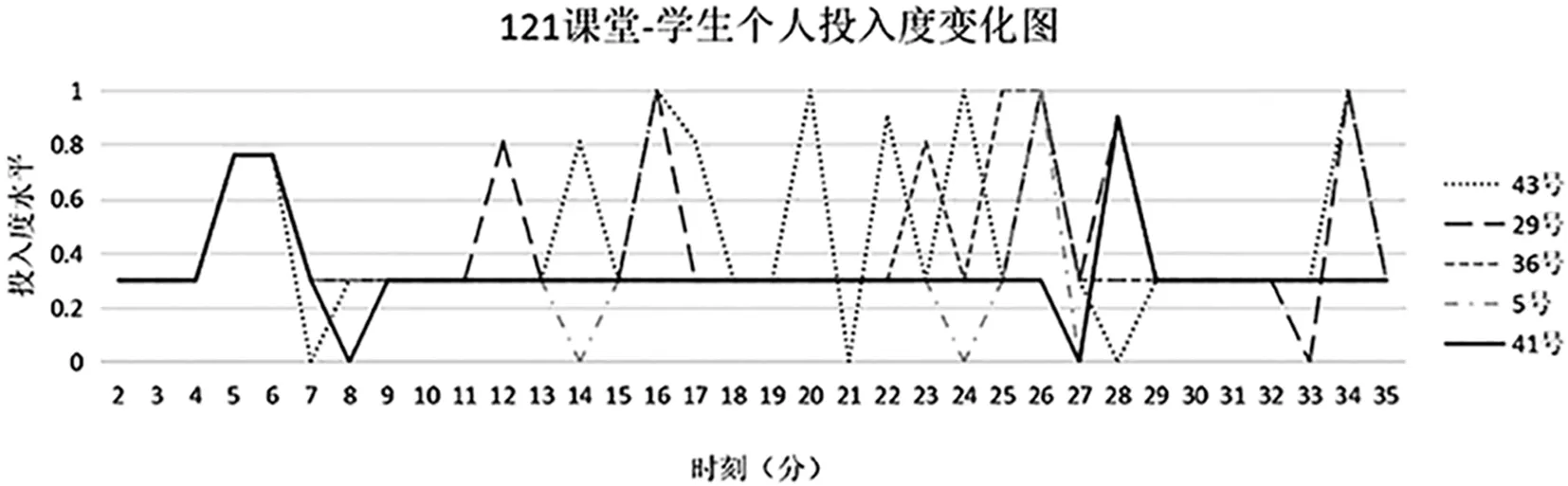

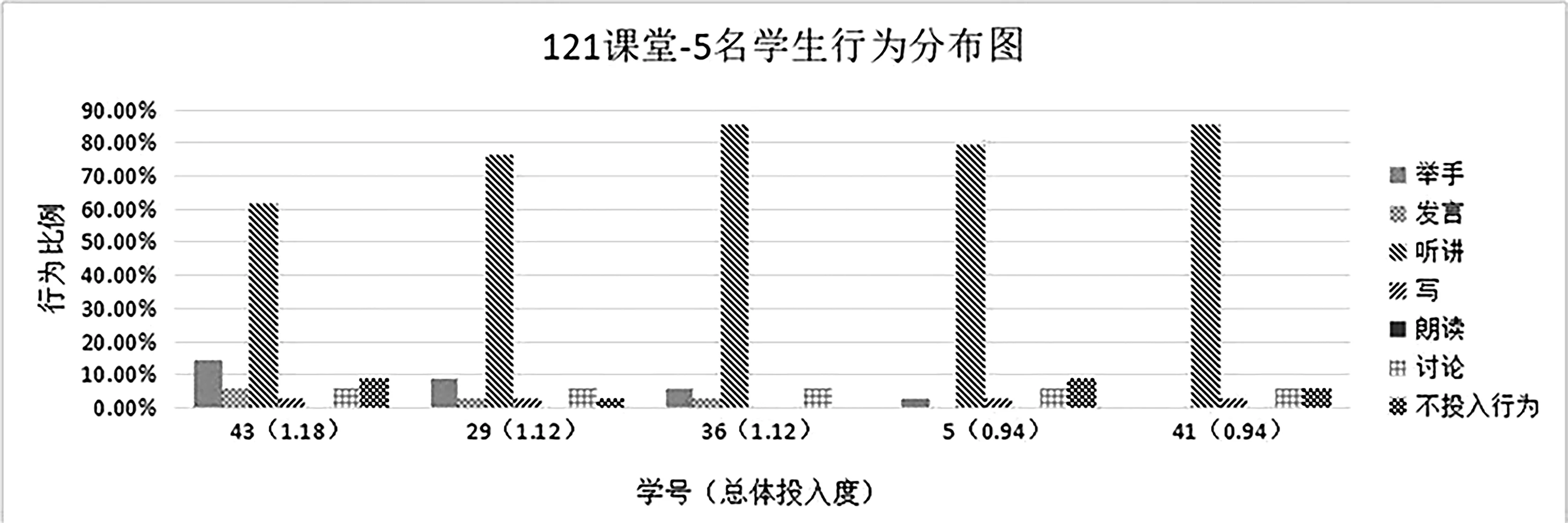

1.个人实时投入度和个人阶段性投入度。图6、图7是5位学生整堂课的投入度实时变化曲线和个人阶段性投入度结果,我们发现43号、29号、36号的投入度较高,因为其课堂表现较为活跃,多次举手、发言,其个人阶段性投入度较高,而5号、41号不仅举手、发言较少,还有多次不投入的行为,故个人阶段性投入度较低。

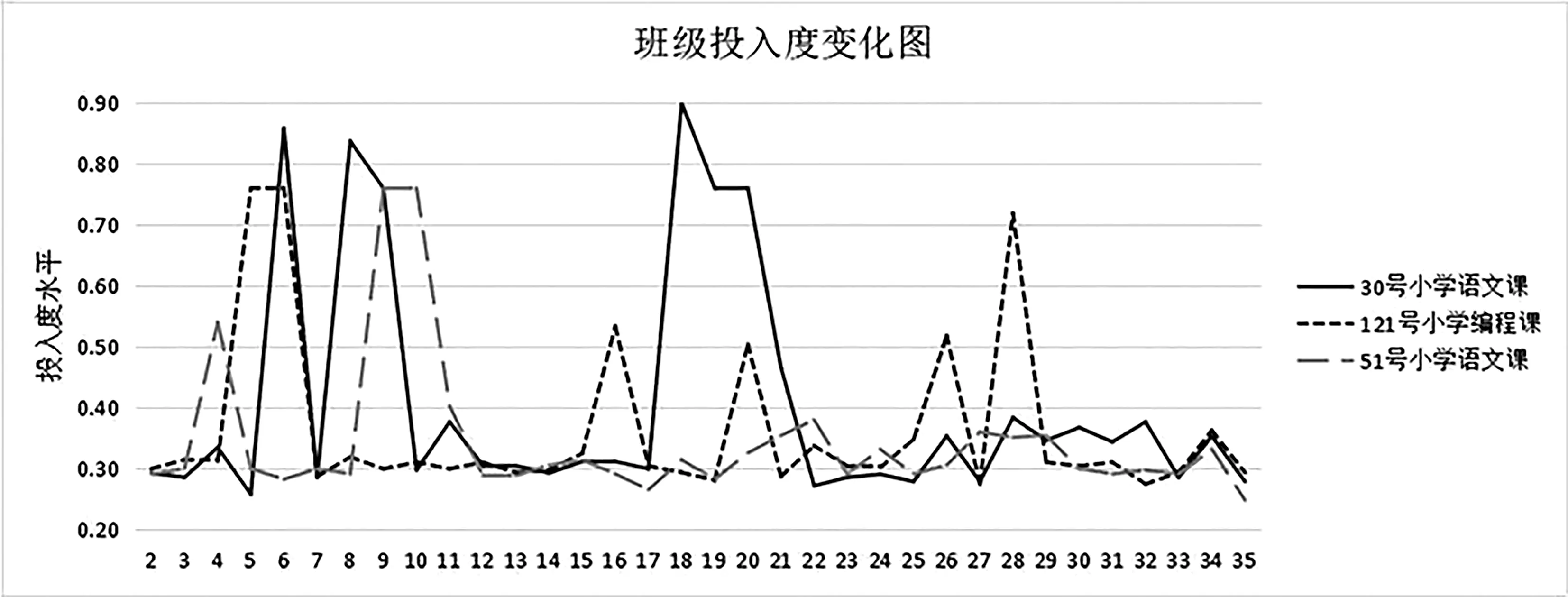

2.班级实时投入度。图8是30号、121号、51号课堂的班级投入度的实时变化曲线,三者的阶段性投入度为0.41、0.36、0.34。投入度高峰(0.7以上)的出现往往代表了群体活动的开展,如讨论、朗读、应答(举手),投入度中峰(0.4~0.7)的出现代表了部分学生参与活动,原因可能是教师提问但并非所有学生都参与了回答。投入度低峰(0.3~0.4)的出现代表了少数学生参与活动,原因可能是只有少部分学生的举手和发言。对比三条曲线,三堂课的投入度呈低水平-高水平的周期式浮动(以0.3为基准),这可能与教师教学活动设计有关。三位教师都注重课程导入环节,在开始阶段就抓住学生的注意;121号课堂教师全程都比较注意和学生的互动,提问难易结合,出现了多次投入度中峰和高峰;30号课堂的投入度高峰较多,缺乏中峰,说明教师注重全体的活动,但提问的难度高;51号课堂教师的后半程没有投入度中高峰的出现,投入度多次低于0.3基准,该教师需要把握课堂节奏,照顾到更多的学生。

图5 实时投入度识别与跟踪效果

图6 121号课堂5名学生行为投入度曲线图

图7 121号课堂5名学生行为分布图

图8 班级投入度变化图

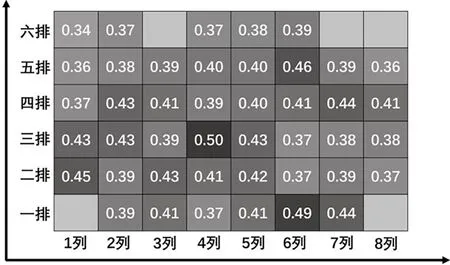

3.学生阶段性投入度空间分布。图9是30号课堂学生阶段性投入度的空间分布情况,从热图中可以看到前排的学生投入度较后排更高,处于边缘的学生投入度明显较中央学生投入度更低,因为边缘学生更容易被教师忽略,不专注时也不易被察觉,这种情况可能导致了这些学生有更松懈的心态。

图9 30号课堂学生阶段性投入度热图

五、总结与展望

本文对课堂投入度计算进行了探索,提出了一种依据学生头部姿势、手部姿势、身体姿势计算课堂投入度的方法;采用了Faster R-cnn网络检测课堂学生行为,结果显示具有较好的目标检测率、识别准确率和目标跟踪性能;实验证明本文提出的课堂投入度自动分析技术可以计算课堂中个人和班级的实时投入度和阶段投入度。

本研究的成果可以用于同步课堂中教师对远程课堂学情进行快捷感知,也可以作为教师和管理者进行多学科、多班级、多学生、多教师、多时段比较分析的工具,帮助教师和管理者把握学生的投入度情况、改善教学策略、实现教师评价等目标。

课堂视频含有丰富的教学信息,作为一种无干预的数据收集方式,对于开展传统课堂的投入度自动评价有很大帮助。在本研究的人工智能图像识别中,课堂学生之间的拥挤遮挡是阻碍识别准确率提高的主要因素;在多信息的利用上,对视频资源的挖掘还远远不足,时序信息、声音、文本信息有待进一步补充。本文方法仅仅研究了课堂行为投入度的智能识别,对投入度识别后展开教学干预及实践验证是后续的重要研究方向。