基于虚拟现实技术的移动机器人视觉伺服控制系统设计

田锦秀

(西安城市建设职业学院 机电信息学院,西安 710114)

0 引言

移动机器人是指能够在空间中自主移动的机械设备,主要通过机械或电子控制系统实现移动和导航,可以根据任务需求装配不同的功能模块[1]。移动机器人广泛应用于工业、医疗、家庭服务、安保等领域,可以自主执行任务,提高效率和安全性。随着人工智能和机器人技术的不断发展,移动机器人的应用范围和任务也越来越广泛,但是在复杂和不确定的环境中,移动机器人的运动控制和路径规划仍是一个难以解决的问题。视觉伺服控制可以通过机器视觉技术实现对移动机器人姿态和位置的实时检测和估计,从而实现移动机器人的精确控制和路径规划。除此之外,视觉伺服控制还可以帮助机器人克服环境中的障碍物,在特定的环境中进行定位和导航,提高移动机器人的工作效率和精确度。为此,研究移动机器人视觉伺服控制具有重要意义。

目前相关领域学者针对机器人视觉伺服控制系统进行研究,文献[2]设计了工业机器人手眼视觉伺服控制系统。采用Kalman滤波器对复合图像雅克比矩阵进行在线估计,利用Lyapunov原理,构建视觉伺服控制器,从而有效跟踪图像运动目标,并通过平面二连杆机器人仿真实验分析验证了该系统的可行性。文献[3]设计了基于雅克比矩阵的高压带电作业机器人视觉伺服控制系统。采用雅可比矩阵,计算作业机器人执行器操作空间和关节速度间的关系,以及执行速度和视觉图像特征变化间的关系,将其结合得到复合雅克比矩阵,再利用PID控制器,构建机器人视觉伺服控制系统,实现参数自适应调整,该系统具有较好的控制性能。但上述两种系统仍存在控制效果较差、控制精度低的问题。

虚拟现实技术是一种通过计算机生成的模拟环境,使用户能够与虚拟环境进行交互和沉浸式体验的技术,其核心目标是提供一种逼真的、交互性强的虚拟体验,虚拟现实技术在许多领域都有广泛的应用,如游戏和娱乐、教育和培训、医疗保健、建筑和设计、航空航天、军事仿真等。为此,设计一种基于虚拟现实技术的移动机器人视觉伺服控制系统,以期能够提升系统的视觉伺服控制精度。

1 移动机器人视觉伺服控制硬件系统设计

1.1 虚拟环境的I/O设备

虚拟现实技术的运行需要以真实环境作为参考样本,并利用输入设备将真实环境中的图像信号和姿态信号输入到虚拟环境中,并通过输出设备输出虚拟成像结果。虚拟现实技术选择三维视觉传感器作为虚拟环境的输入设备,该设备由成像芯片和镜头等部分组成,其中成像芯片选用的是CMOS芯片,设置三维视觉传感器的运行速度与图像刷新的速度一致。利用三维跟踪器,可以使虚拟现实用户的运动与视觉系统进行再匹配与追踪。将虚拟环境的输入设备与移动机器人相连接,虚拟环境输入设备的连接电路如图1所示。

图1显示了虚拟现实技术中所使用的三维视觉传感器的连接方式,系统中设置的虚拟环境输入设备共两个,用来模拟移动机器人的双目视觉。虚拟现实环境的输出设备选择立体显示器和音响设备,用两个显示器分别显示图像,这两块屏幕上的影像是由计算机控制,屏幕上的影像有细微的差异。移动机器人合成两幅影像,从而得到更好地沉浸式视觉效果。

1.2 位姿传感器

位姿传感器用来对控制移动机器人实时运动状态进行检测,为控制量的计算提供初始数据。为保证传感器能够实现对多维度姿态数据的采集,采用多传感器组合的方式形成位姿传感器,其结构如图2所示。

设计系统使用的传感器包括三轴加速度传感器、三轴角速度传感器和三轴磁力计三个部分,将传感器采集的原始数据传送至嵌入式板上,然后对其进行姿态分析,从而获得当前模块的俯仰角、横滚角、航向角、气压、高度和温度等数据,系统位姿传感器通常都会保留一个通信接口,它可以将分析到的数据信息发送到PC、单片机等设备中[4]。为了满足系统的功能需求,在机器人移动时,必须要对其进行实时的偏航角信息进行检测,以4~7 V为电源,工作电流大约40 mA,同时还保留了2个UART接口,数据传输率为115 200 bps,可以用USB转TTL模块将数据发送至PC机上[5]。通过选取合适的传感器,可以获得被测机器人的位姿数据,然后再由位姿资料处理装置STM32F103T8进行位姿数据的处理,从而获得可用的位姿数据。

1.3 视觉图像处理器

在移动机器人视觉伺服控制过程中,需要采集大量的视觉图像,为视觉图像处理工作提供硬件支持。首先需要确定采集的图像类型、分辨率、帧率以及采集频率等参数,然后采用Sony IMX219图像传感器采集图像信号,最后选择一台工业控制计算机,对图像序列进行处理和分析,其使用Inteli3处理器,最高主频1.6 GHz,8 GB的内存,确保了图像处理的速度,并且保留2个网口,2个USB3.0接口,4个COM接口,4个COM接口,这使工业控制计算机能够与大量的外设进行连接。

1.4 伺服控制器

伺服控制器是移动机器人视觉伺服控制系统控制功能的执行元件,控制器由驱动设备、处理器等部分组成。由于虚拟现实环境的构建,使得移动机器人的运动不受空间环境的限制,扩大了移动机器人的活动范围[6]。选用直流电机作为移动机器人的动力执行机构,机器人对运动速度的控制处于开环状态,需要根据姿态传感器反馈的机器人实时运动速度,完成机器人运动速度的闭环控制。在载荷作用下,能够维持恒定的速度,从而实现了对机械臂相对高精度的运动控制。伺服驱动电机具备完备的电流保护,可有效防止因过流或过温而导致的硬体损坏。伺服控制器内部的处理器选择AT91SAM7S256芯片,该芯片使用32位RISC架构,可快速实现比较复杂的控制算法。芯片具有256 kB的片上FLASH和64 kB的RAM存储器空间,具备运行嵌入式实时操作系统μc/OS-II的能力[7]。芯片中有大量的周边元件,如USART、SPI、TWI等,同时还提供了多种可编程的时钟,便于对回路进行定时操作。控制芯片采用LQFP封装,仅有64个管脚,许多管脚用作供电和信号线,可用于一般I/0接口较少[8]。针对这一缺陷,采用可编程逻辑器件EPM570T144I5来进行输入输出扩展。ARM7通过串行的接口,能够控制CPLD上的一组通用I/O接口,并且能够将每个端口与内部的脉冲发生器连接,使其发出设定宽度和相应的脉冲,来控制伺服驱动电机的运作。伺服控制器元件连接如图3所示。

图3 伺服控制器元件连接示意图

另外,在实际控制过程中,控制器、传感器以及移动机器人之间采用网络进行通信发送命令。

2 移动机器人视觉伺服控制系统软件功能设计

在硬件设备的支持下,对移动机器人的视觉伺服控制功能进行设计,从位姿、运动参数等方面实现对移动机器人的控制,保证机器人能够在虚拟现实环境中按照指定方式完成相应的移动任务。以立体标定方法、视觉图像成像原理、图像预处理方法、图像拼接与三维重构方法、虚拟现实技术的碰撞检测技术、伺服控制逻辑为主要设计方法,实现移动机器人视觉伺服控制系统软件功能设计。

2.1 搭建移动机器人数学模型

在设计系统控制功能之前,首先需要确定移动机器人的基本运动原理,因此,从运动学和动力学两个方面,构建机器人的数学模型。假设移动机器人存在纯滚动无滑动运动,则移动机器人的运动学模型可以表示为:

(1)

式中,(x(t),y(t))为t时刻的移动机器人位置坐标,θ(t)表示移动机器人的姿态角,υ(t)为移动机器人在t时刻的线速度[9],ω(t)为移动机器人在t时刻的角速度,Q为机器人载荷总重量,M为机器人惯性量度,ϑline(t)和ϑhorn(t)分别为机器人的线转矩和角转矩[10]。在移动状态下,移动机器人的动力学特性满足如下规律:

(2)

式中,FDrive-Front和FDrive-Rear分别为驱动电机对前轮和后轮的驱动力,Ff为移动机器人与地面之间的摩擦力,m为移动机器人的质量,d为前轮与后轮之间的距离[11]。通过运动学和动力学模型的融合,得出移动机器人数学模型的搭建结果。

2.2 标定移动机器人视觉相机

(3)

式中,Jleft表示双目视觉相机的左侧旋转矩阵,Uleft表示左侧平移矩阵,Jright表示右侧旋转矩阵,Uright表示右侧平移矩阵。进行立体标定时,利用视觉相机提取包含标定板的图像并进行识别,可以得到空间中点与其对应的摄像机成像平面上点的对应关系,从而得出矩阵Z和U的求解结果[12]。根据左、右视觉相机之间的实际位置距离,确定矩阵Z和U的实际值,并与求解出的矩阵结果进行比对,判断当前视觉相机的成像结果是否存在偏差,通过偏差的校正实现对移动机器人视觉相机的标定。

2.3 生成移动机器人实时视觉图像

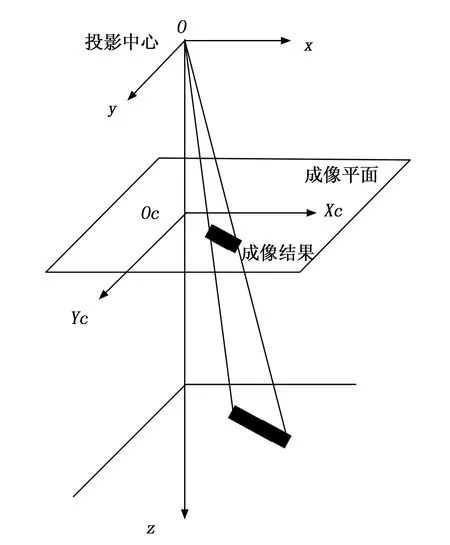

利用标定完成的视觉传感器设备根据移动机器人的移动情况,生成实时视觉图像。视觉图像的成像原理如图4所示。

图4 移动机器人实时视觉图像成像原理图

利用图4表示成像原理,假设实际空间中任意一点(xtrue,ytrue,ztrue)在成像空间中的成像结果可以表示为:

(4)

式中,f为视觉传感器的成像焦距。在考虑视觉相机标定结果的情况下,可以将视觉相机的成像结果表示为:

(5)

式中,Lx和Ly分别为任意点在成像平面上物理长度在水平和竖直方向上的分量,φ为成像角度,(xc,yc)表示像素坐标系中相机感光板的中心坐标,Aw表示设定相机外参矩阵[13]。移动机器人的成像视场为:

(6)

式中,R和dthing分别为视野宽度和物距。在实际的成像过程中,设置视觉传感器的更新速度、采集频率等参数,得出移动机器人实时视觉图像的生成结果。

2.4 初始图像预处理

为保证移动机器人视觉伺服控制效果,以提升图像质量为目的,针对移动机器人初始采集的图像,采取一系列预处理步骤,包括灰度化、图像滤波、畸变校正等。将RGB图像转化成灰度图像可以有效减少数据量。对一幅彩色图像进行灰度处理,即将一幅彩色图像中的一幅图像转化为一幅灰度图像[14]。灰度图像是用来量化亮度的,一般分为0~255的256个等级,其中 0 最暗,255 最亮。初始视觉图像的灰度化处理结果为:

IGrayscale=W(0.299×IR+0.587×IG+0.114×IB)

(7)

式中,IR、IG和IB分别为图像中红、绿、蓝色彩分量[15]。设计系统中采用高斯滤波处理方式,其处理过程如下:

(8)

式中,σ为高斯滤波同性扩散系数。初始视觉图像中的畸变可以分为径向畸变和切向畸变两个部分,其中径向畸变是因为光线经过镜头时,在透镜的边缘附近的光会比在透镜的中央附近的光扭曲得更厉害。因此,当光线到达像面时,其初始位置发生了偏差,从而引起像面上物体的坐标发生了改变。透镜的径向失真往往导致影像出现“枕状”或“桶状”的失真。视觉图像径向畸变的校正过程为:

(9)

式中,κcheck1、κcheck2和κcheck3分别为畸变校正系数,j为旋转矩阵向量。另外,切向畸变的产生通常是由于摄像机中镜头和成像平面不能保持完全平行,根据切向畸变的形成原理,确定相应的校正系数,并得出相应的切向畸变校正处理结果。将初始采集的机器人视觉图像中的所有像素代入到上述公式中,通过上述环节的处理得出移动机器人视觉图像的预处理结果。

2.5 构建机器人虚拟移动环境

以移动机器人实时生成的视觉图像及其处理结果为处理对象,生成相应的虚拟现实环境,虚拟现实环境构建流程如图5所示。

图5 虚拟现实环境构建流程图

为保证构建的虚拟现实环境与机器人移动环境一致,采用图像拼接与三维重构的方式构建虚拟环境。在图像拼接过程中,由于移动机器人的采样频率较高,因此连续两个时刻采集的图像之间存在较大程度的重复,因此可以根据图像之间的重叠情况进行拼接处理。利用公式(10)提取视觉图像中任意一点的特征向量。

(10)

式中,β为视觉图像中的像素点的亮度值,τ(x,y)为像素点的位置坐标,那么整幅视觉图像的全局特征可以表示为:

τ(I)=gdet[τ(x,y)]-0.04(gtrace[τ(x,y)])2

(11)

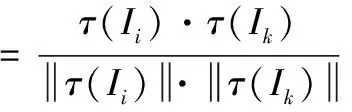

式中,gdet和gtrace分别为局部极大值和极小值的检索函数。按照上述方式可以得出所有视觉图像的特征提取结果,并将其代入到公式(12)中,计算任意两幅视觉图像之间的特征匹配度。

(12)

若公式(12)的计算结果高于阈值s0,则认为视觉图像i和k之间存在重叠情况,通过调整图像特征区域对特征匹配度进行反复计算,当计算得出s(i,k)取值为1时,说明当前区域为两幅视觉图像的重叠区域,将两者进行重合处理,完成二者的拼接工作。若计算得出s(i,k)的值低于s0,则表示两幅图像之间不存在重叠情况,则直接进入下一组图像的匹配工作[16]。反复执行上述操作,直至移动机器人采集的视觉图像全部拼接完成为止。在二维拼接视觉图像的基础上,通过对成像点距离的分析,确定图像像素点的深度值。移动机器人对图像中任意一点实际感知深度的计算公式如下:

(13)

式中,dcamera和dperpendicular分别表示的是移动机器人中左右两视觉传感器之间的距离以及主视传感器与目标物体之间的垂直距离,而ξvision代表图像视差。公式(13)的计算结果即为当前图像像素点在虚拟现实环境中的深度坐标。将视觉图像中各个物体的二维坐标与求解的深度坐标相结合,即可得出该物体在虚拟环境中的三维坐标,通过多像素的三维重构,得出机器人移动环境中所有物体结构的虚拟模型生成结果,将纹理图片贴在物体模型表面[17]。由于移动机器人处于实时运动的状态,因此相应的虚拟现实环境需要根据机器人的移动位置进行动态更新,将移动机器人车体的绝对坐标转换为参考坐标,根据虚拟现实环境中的物体与机器人之间的距离,确定对应虚拟场景是否显示,进而驱动虚拟现实场景实时更新。最终对虚拟现实场景进行渲染输出,得出机器人虚拟移动环境的搭建结果。

2.6 虚拟环境下规划移动机器人行动路线

2.6.1 目标物体的视觉定位与跟踪

通过对视觉图像特征的提取,实时检测移动机器人抓取目标的位置。根据抓取目标状态可以将其分为静态目标和动态目标,静态目标位置不会随时间变化而发生变化,定位结果如下:

(14)

式中,γi为视觉图像的边缘特征,Ibackground表示的是视觉图像中的背景区域,求解结果表示目标空间位置,可以进一步展开成坐标形式。而动态目标的定位与静态目标一致,但需要定期重复定位操作,并用最新的定位结果与原始结果进行覆盖。

2.6.2 生成机器人初始移动路线

假设移动机器人的初始位置为(x0,y0,z0),目标位置为(xstop,ystop,zstop),则初始生成的机器人移动路线可以表示为:

(15)

在初始移动路线下,机器人所经过的空间路径长度为:

(16)

在此基础上,由机器人的初始位置至终止位置所插补步数可以表示为:

(17)

式中,ΔL为等距直线插补时的步长。那么在已知虚拟环境下移动机器人目标位置的情况下,即可生成移动机器人在虚拟环境中的初始移动路线。

2.6.3 利用虚拟现实技术检测碰撞状态

利用虚拟现实技术中的碰撞检测功能,判断初始生成的机器人移动路线与虚拟环境静态物体之间是否存在碰撞现象。采用层次包围盒方法执行碰撞检测任务,包围盒的每一条直线都是与其坐标轴线相平行的,它是一个最小的矩形平面[18]。基于碰撞检测的应用,常采用的基本思路是将复杂的几何体用一个简单的包围盒进行围合。设置包围盒的中心位置为:

(18)

式中,b1(i)、b2(i)和b3(i)表示物体表面三角形面片三个顶点的矢量,nplane为包围盒包围的三角面片数。当检测两个物体的碰撞时,先判断盒周围根节点的相交情况,不能相交,那么就不会有物体与之碰撞,若相交,就会遍历根节点之下的子节点,若有相交,就会对包围盒中的两个多边形进行精确地检验。

2.6.4 机器人移动路线调整与更新

若检测得出初始生成的机器人移动路线与虚拟现实环境之间存在碰撞行为,则需要利用公式(18)调整碰撞点的位置。

(19)

式中,(xcollide(i),ycollide(i),zcollide(i))和(xnew(i),ynew(i),znew(i))表示的是调整前后碰撞路径节点的坐标值,参数λx、λy和λz对应的是三个空间方向上的调整量[19]。按照上述方式对初始移动路线中的所有碰撞节点进行调整,并将调整后的节点接入到初始路线中,并与碰撞节点的前后节点进行连接与插补。根据机器人的实时移动位置,调整移动路线的初始位置,实现对移动路线的实时更新。

2.7 实现移动机器人视觉伺服控制功能

在视觉伺服控制器的支持下,按照伺服控制逻辑,生成视觉伺服控制指令,如图6所示。

视觉伺服控制的目标就是减小移动机器人实际运动中的移动机器人参数和预期间误差,从姿态、移动速度、位置三个方面执行伺服控制任务,以移动速度控制为例,具体控制量可以表示为:

Δv=(xnew(i),ynew(i),znew(i))(vtarget-vt)

(20)

式中,vtarget和vt分别表示移动机器人的目标移动速度和t时刻的实际移动速度,利用硬件系统中的位姿传感器可以直接得出变量vt的具体取值。若公式(20)计算结果为负数,则执行减速控制操作,若速度控制量Δv取值为正,则执行加速控制操作[20]。同理可以得出移动机器人位置与姿态的伺服控制结果。在虚拟现实环境下,通过对视觉图像的分析,确定控制目标参数,并将伺服控制器输出的控制指令直接作用在移动机器人上,直至移动机器人到达目标位置或完成目标任务。

针对移动机器人运动控制精度低的问题,基于其运动学和动力学特征,建立移动机器人数学模型,采用立体标定方式标定移动机器人的视觉相机,提高图像采集的精准度,以此为基础生成实时视觉图像,并对取向进行灰度化、图像滤波、畸变校正等预处理,提高图像的质量。根据高质量图像生成相应的虚拟现实环境,在此环境下规划移动机器人行动路线,并及时更新移动路线,提高机器人的伺服控制能力,最后按照伺服控制逻辑,生成视觉伺服控制指令,指导移动机器人完成目标任务,实现移动机器人视觉伺服控制系统设计。

3 系统测试

为了验证设计的基于虚拟现实技术的移动机器人视觉伺服控制系统中控制功能能否满足预期,进行系统测试。此次实验分别从控制精度和控制效果两个方面进行验证,其中控制精度测试就是测试移动机器人位置、姿态角、移动速度等运动参数与控制目标之间的误差,而控制效果就是测试在控制系统作用下,移动机器人与外界环境之间的碰撞情况。

3.1 准备移动机器人样机

实验选择Dr Robot型号的移动机器人作为系统的控制对象,该机器人带有一个可移动底盘和四个自由度铰接手臂,能够执行多种抓取任务。Dr Robot移动机器人自重35 kg,与地面之间的最大摩擦力为30 N,因此可以在坡度为45°以下的地面上自由移动。在开始试验之前,需要对移动机器人样机的各个功能进行检测,判断移动机器人各个元件之间是否能够协同运行、移动机器人是否能够成功接收相关控制信息、移动机器人是否能够根据控制指令执行相应任务,在确定移动机器人样机调试成功的情况下,执行系统测试实验的下一步操作。

3.2 选择虚拟现实场景实现工具

为支持设计视觉伺服控制系统中虚拟现实技术的运行,设置虚拟现实场景的开发工具为Multigen creator三维建模软件,Multigen creator具有建模、变换、动画及物体运动模糊等功能,其可以与Visual C++等编程工具一起工作,还能够快速地生成一个具有真实效果的大型三维场景模型,并使用Open Flight作为图形数据描述格式。Open Flight用于告知图像生成者绘制出实时3D场景的时间,是一种对场景数据进行组织的方式。将Multigen creator工具下载至主测计算机中,通过解码、解压等步骤,保证虚拟现实场景实现工具能够在主测计算机中正常运行。

3.3 生成移动机器人视觉伺服控制任务

在虚拟环境中随机生成虚拟目标,结合移动机器人样机在虚拟环境中的初始位置,规划移动机器人的视觉伺服控制路线,移动机器人的视觉伺服位置控制路线如图7所示。

图7 移动机器人的视觉伺服位置控制路线

在此基础上,标记移动机器人移动过程中的实时姿态角和速度参数。按照上述方式,生成6个虚拟目标,并形成相应的6组视觉伺服控制任务。在控制效果测试过程中,在相同的虚拟环境下,生成随机障碍物,随机障碍物可以分为静态障碍物和动态障碍物两种,在有障碍环境下调整初始控制任务,得出有障碍物场景下的任务生成结果。

3.4 描述系统测试过程

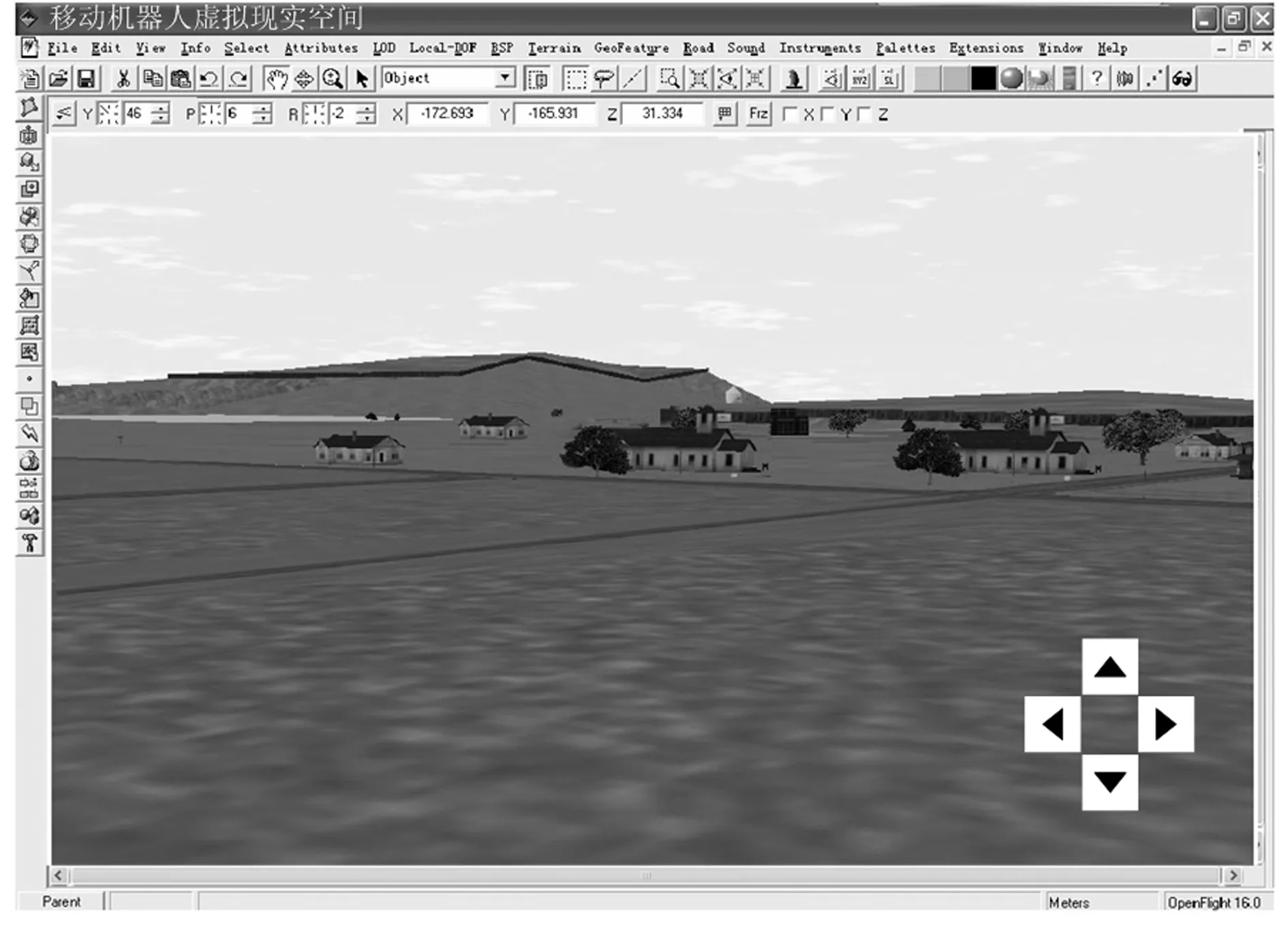

将硬件系统中的相关元件设备安装到移动机器人内部,将视觉传感器帧速率设置30FPS,分辨率设定为640×480。通过实时图像的采集与虚拟现实技术的运行,输出移动机器人的虚拟现实活动环境,如图8所示。

图8 移动机器人虚拟现实活动环境生成结果

将基于虚拟现实技术的移动机器人视觉伺服控制系统的软件功能部分以程序代码的方式输入到主测计算机中,得出控制结果。移动机器人视觉伺服控制系统运行界面如图9所示。

图9 移动机器人视觉伺服控制系统运行界面

当系统检测到移动机器人与目标位置相同时,判定移动机器人完成视觉伺服控制任务,自动退出控制程序,并记录机器人移动过程中的所有数据。此次系统测试实验中设置文献[2]系统(基于改进BP神经网络的机器人视觉伺服控制系统)和文献[3]系统(基于Udwadia-Kalaba方法的机器人伺服控制系统)作为对比系统,按照上述方式完成对比系统的开发,并得出相应的控制结果。

3.5 设置系统测试指标

设置位置、姿态角和移动速度控制误差作为系统控制误差的量化测试指标,其中位置控制误差的测试结果如下:

εseat=|xcontrol-xtarget|+|ycontrol-ytarget|+|zcontrol-ztarget|

(21)

式中,(xcontrol,ycontrol,zcontrol)和(xtarget,ytarget,ztarget)分别表示控制系统下移动机器人的实际位置和虚拟目标位置。

姿态角和移动速度控制误差的数值结果为:

(22)

式中,θcontrol、θtarget、vcontrol和vtarget分别为移动机器人姿态角和移动速度的控制值与目标值。另外,控制效果的量化测试指标为碰撞次数,其测试结果为:

Ncollide=Nobstacle+NFixed objects

(23)

式中,Nobstacle和NFixed objects分别为移动机器人与障碍物以及固定物体之间的碰撞次数。最终计算得出位置、姿态角和移动速度控制误差越小,表明系统的控制精度越高,而碰撞次数越少,表明系统的控制效果越好。

3.6 系统测试结果与分析

3.6.1 控制精度

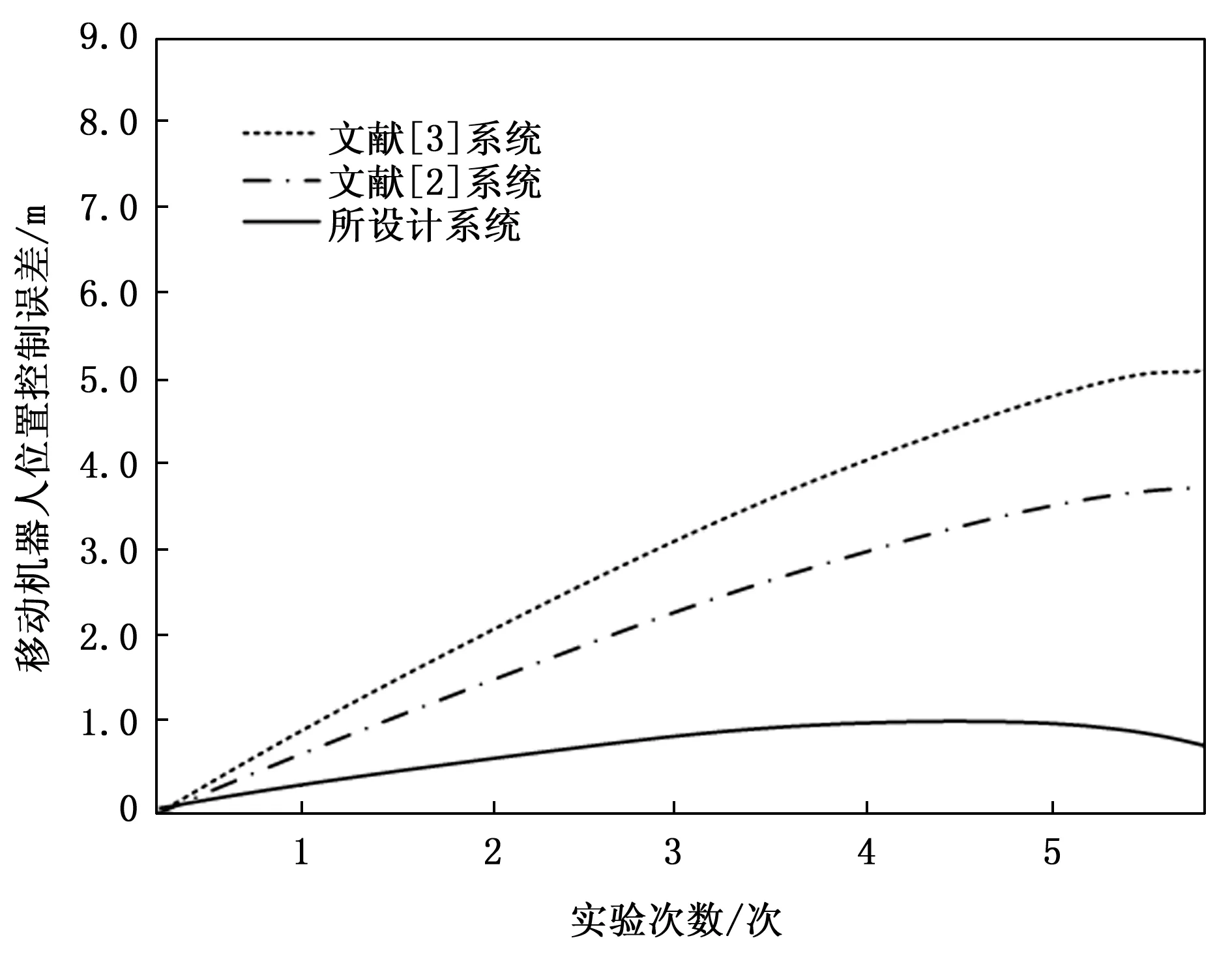

采集控制系统作用下移动机器人实时位置数据,并将其与位置控制目标数据输入到公式(21)中,获得移动机器人位置控制误差测试对比结果如图10所示。

图10 移动机器人位置控制误差测试对比结果

从图10中可以看出,与文献[2]系统和文献[3]系统相比,所设计系统的移动机器人位置控制误差较小。由此可知,所设计系统的移动机器人视觉伺服控制精度较高。

根据上述数据,利用公式(22)计算得到移动机器人姿态角和移动速度控制误差测试数据如表1所示。

表1 移动机器人姿态角和移动速度控制误差测试数据表

根据表1中的数据可知,文献[2]系统和文献[3]系统的平均姿态角控制误差分别为0.43°和0.55°,平均移动速度控制误差均为0.48m/s,而所设计系统的平均姿态角和移动速度控制误差分别为0.05°和0.12m/s。由此可知,所设计系统的移动机器人姿态角和移动速度控制误差较小,能够有效提高移动机器人视觉伺服控制精度。

3.6.2 控制效果

在此基础上,进一步进行移动机器人的碰撞检测,通过公式(23)的计算得出碰撞次数的测试结果,如表2所示。

表2 移动机器人碰撞次数测试结果

根据表2中的数据可知,在静态障碍物场景和动态障碍物场景下,与文献[2]系统和文献[3]系统相比,所设计系统的移动机器人碰撞次数较少,表明所设计系统具有较好的移动机器人视觉伺服控制效果。

4 结束语

为实现移动机器人的精确控制和路径规划,设计了基于虚拟现实技术的移动机器人视觉伺服控制系统。通过虚拟环境的I/O设备、位姿传感器、视觉图像处理器以及伺服控制器元件,设计系统硬件部分。搭建移动机器人数学模型,标定移动机器人视觉相机,生成移动机器人实时视觉图像并进行预处理,构建机器人虚拟移动环境,完成目标定位、路线生成、碰撞检测、路线调整等,实现视觉伺服控制。通过系统测试验证了该系统能够为机器人的移动提供虚拟环境,并在一定程度上提升控制精度。