基于多智能体博弈强化学习的无人机智能攻击策略生成模型

赵芷若, 曹 雷, 陈希亮, 赖 俊, 章乐贵

(中国人民解放军陆军工程大学指挥控制工程学院, 江苏 南京 210007)

0 引 言

伴随着机械化时代的结束和信息化、智能化时代的到来,现代战争战斗力生成模式的发生域由物理域迈向信息域和认知域。在智能化时代,如何通过人工智能技术取得决策优势,加快观察,判断,决策,行动(observe, orient, decide, act, OODA)循环,使对手陷入OODA死循环,值得深入思考[1-3]。

智能化、无人化作战作为未来战争关注的焦点,迫切需要协同配合、自组织和快速决策[4-5]。构建无人机智能攻击策略生成模型的重点,主要体现在以下两个方面。

(1) 训练空中无人机的寻路和隐蔽能力,在避开敌人的侦察和火力打击的前提下,精准定位目标位置并实施精确打击;

(2) 训练空中无人机的协同配合和自组织、自适应能力,在最小化我方损失的原则下完成作战任务。

近年来,在单智能体领域,由深度学习与强化学习结合而产生的Atari游戏和围棋的虚拟玩家均达到了人类顶级玩家的水平。在多智能体领域,基于值函数分解的多智能体深度强化学习算法,如值函数分解法[6]、混合多智能体值分解算法[7]等也在星际争霸游戏中取得了很好的成绩。从单智能体到多智能体,问题的复杂度大大增加,却也更贴近军事需要,因为真实的战场空间存在大量需要协同组织与配合的基础作战单元。由于传统的单智能体强化学习方法只能对单个作战单元进行建模,如果将其直接应用于多智能体系统,即将其他智能体视为环境的一部分,那么将会违反强化学习的基本假设,产生环境不平稳的问题,从而不再适用。相比之下,多智能体强化学习方法在军事对抗问题的建模及训练和辅助决策上更有研究价值。另一方面,军事对抗问题也属于博弈问题,可以利用博弈论中的相关知识对其进行评估和优化。

目前,多智能体博弈强化学习作为多智能体和博弈论的结合体,在解决大规模智能体之间的交互计算困难[8]、学习对手的策略[9]、完成实时策略(real time strategy, RTS)游戏中的微观管理任务[10]和提升算法的鲁棒性[11]方面均取得了不错的成果。随着研究的深入,越来越多的博弈论方法被用来分析多智能体问题,产生了平均场多智能体强化学习算法[12]、基于对手意识的学习算法[13]和多智能体深度确定性策略梯度算法[14]等多智能体博弈强化学习方法。因此,将多智能体博弈强化学习方法应用于无人机智能攻击策略生成已成为人工智能作战模拟仿真领域的关键技术之一。

目前,多智能体博弈的成功主要来自两个领域的技术组合:深度强化学习和博弈论。前者用于在交互式环境中训练具有特定目标的智能体,但无法直接被应用于多智能体场景[15];后者为分析多智能体的行为而生,但更多偏向理论研究,算法应用只局限于较小的范围[16]。

强化学习[17]是让智能体以最大化奖励函数为目标,在试错中学习的算法,非常适合解决序贯决策类问题。深度学习[18]是用神经网络从原始输入中提取高级特征的一类机器学习算法。在深度学习普及之前,强化学习需要用人工提取特征来表示复杂博弈的状态信息,神经网络可以作为一个自适应函数近似器,允许强化学习扩展到高维状态空间[19]和续动作空间[20]。深度强化学习是上述两种算法的结合,兼具二者的优点。

本文尝试使用多智能体博弈强化学习方法来解决无人机智能攻击策略的生成与优化问题。将无人机智能攻击策略生成问题建模为马尔可夫博弈过程,尝试采用强化学习和博弈论相结合的方法来求解和优化无人机智能攻击策略,通过利用与仿真环境交互的“试错”数据来直接学习策略,不需要人为构建推理模型,在此基础上利用博弈论中“颤抖的手完美”[21-22]策略进行优化。

1 无人机智能攻击策略训练模型

1.1 基于马尔可夫随机博弈的无人机智能攻击策略生成过程建模

单智能体强化学习可以使用马尔可夫决策过程(Markov decision process, MDP)进行描述,而多智能体强化学习(multi-agent reinforcement learning, MARL)则需要使用马尔可夫博弈[23-24]过程来描述。无人机智能攻击策略训练问题,可认为是在连续动作和状态空间上的实时决策问题,可以依照马尔可夫博弈过程进行建模。具体地,定义了一个元组并用数学语言进行形式化描述:(N,S,a1,a2,…,aN,T,γ,r1,r2,…,rN)。其中:N为智能体个数;S为多智能体的联合系统状态;a1,a2,…,aN为智能体的动作集合;T为状态转移函数,T:S×a1×…×an×S′→[0,1],即根据当前系统状态和联合动作,给出下一个状态的概率分布;ri(s,a1,…,aN,s′)表示智能体i在状态S时,执行联合动作后,到达下一个状态S′所获得的奖励,奖赏函数一般是关于环境和动作的函数;γ表示折扣因子,γ∈[0,1]。

在多智能体博弈中,智能体的学习目标是找到联合最优策略,最大化累积回报值。

1.2 无人机智能攻击场景建模

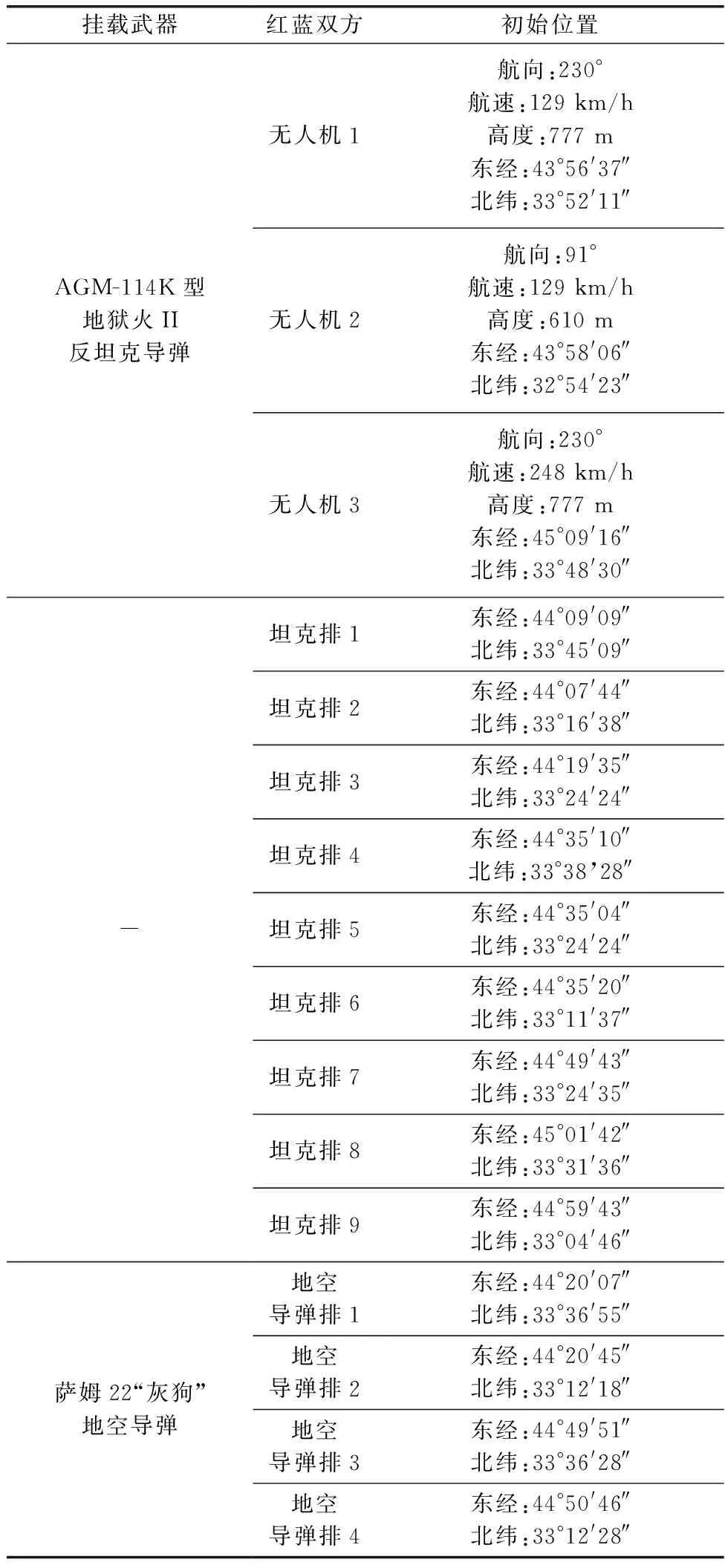

本文构建了3vs.9的无人机反坦克对抗场景。对抗双方为红方和蓝方。其中,红方是由3架MQ-1C型“灰鹰”无人机组成的三机编队(使用 MARL 算法进行仿真);蓝方是由4个地空导弹排(萨姆-22“灰狗”地空导弹)和9个坦克排(4辆T-72型主战坦克)组成的防空编队(使用固定战术规则)。

交战空域设置为矩形二维平面环境。双方均设置固定出发点。红方无人机在指定对抗空域内进行空对地打击。蓝方地空导弹排在地面按规则对红方战机进行侦察,一旦感知红方战机威胁并当红方战机进入蓝方地空导弹排火力打击范围内,就伺机歼灭之。在目标歼灭或丢失后继续侦察搜索。由于红方无人机的飞行高度高于蓝方坦克的射程范围,故蓝方坦克无法对红方无人机构成威胁;红方无人机的任务是避开地空导弹排的火力打击范围,并歼灭蓝方所有坦克。

1.3 无人机飞行模型

假设无人机的飞行高度固定,无人机只在二维平面上飞行,其运动模型如下:

式中:x,y分别表示平面直角坐标系下的坐标分量;v表示速度矢量,vx,vy分别表示无人机在两个方向上的速度分量;φ表示航向角。

无人机飞行轨迹受到最小航迹AB和最小转弯半径Rmin的限制[25]。其中,最小航迹表示无人机在改变飞行姿态前须保持直飞的最短距离。无人机的飞行轨迹如图1所示。

图1 无人机飞行轨迹图Fig.1 Unmanned aerial vehicle flight trajectory

A,B,C,D这4个点分别对应初始位置、转向开始位置、转向结束位置和终止位置。

1.4 状态空间设定

状态空间包括无人机、坦克排、地空导弹排的生存状态、速度、海拔、经度、纬度,具体定义如下:

式中:i,j,k分别表示第i,j,k个无人机、坦克排和地空导弹排。

1.5 动作空间设定

由于红方无人机是空中移动目标,所有红方无人机的可选动作集合包括开火和移动两种选择,红方无人机根据雷达侦测情况择机开火,每个时刻均发生位移;而所有蓝方无人机都是地面固定目标,所以蓝方的可选动作集合只有开火一种选择。蓝方根据雷达侦测结果开火打击,一旦侦测到红方无人机立即开火。红方无人机、蓝方坦克和地空导弹排之间的打击效果依如下规则。

当满足以下两个条件时,制定无人机摧毁坦克:

(1) 设红方无人机的雷达探测半径为ruav,火力打击范围为fuav,蓝方地空导弹排的雷达探测半径为rmissile,火力打击范围为fmissile。

(2) 设红方无人机发现目标后的射击概率为puav,命中率为ρuav;蓝方地空导弹排发现目标后的射击概率为pmissile,命中率为pmissile。

当满足以下两个条件时,判定无人机摧毁坦克:

(1) 无人机的机载火控雷达的扫描区域持续覆盖坦克;

(2) 无人机同时满足空对地导弹发射概率puav,发射导弹满足命中概率ρuav。

同理,当满足以下两个条件时,判定地空导弹摧毁无人机:

(1) 地空导弹排的火控雷达的扫描区域持续覆盖无人机;

(2) 地空导弹同时满足地对空导弹发射概率pmissile,发射导弹满足命中概率ρmissile。

1.6 奖赏函数设计

由于红方无人机采用多智能体博弈强化学习方法训练,蓝方坦克和地空导弹排使用固定规则训练。因此,奖赏函数只针对红方无人机的任务进行设计。红方无人机的任务是在最小化自身损失的情况下,摧毁所有蓝方坦克。具体地,当红方无人机摧毁一辆蓝方坦克时,奖励为正值,当红方无人机被蓝方地空导弹摧毁时,奖励为负值,红方无人机完成作战任务或者全军覆没后分别得到全局最大(最小)的奖励值。

2 基于多智能体博弈强化学习的无人机智能攻击策略生成框架和训练流程

多智能体近端策略优化(multi-agent proximal policy optimization, MAPPO)算法是多智能体强化学习的常用算法之一。在MAPPO中,策略参数集为θ={θ1,θ2,…,θN},所有红方无人机的策略集合为π={π1,π2,…,πN},单个无人机期望收益的梯度J(θi)为

档案信息化数据运行管理需要油田企业持续性地投入一定的资金,油田企业应当注重为档案管理工作开展提供保障。除了要做好前期信息化管理系统的建设外,还要注意后期系统维护和定期进行设备更换等工作。特别是一些办公软件,使用一段时间后需要及时更新,这样才能最大化地发挥油田档案信息化数据运行管理的实际价值。此外,档案管理人员还要定期做好系统维护,这样也可以减少信息化数据运行管理系统的故障率,无形中降低了使用成本。

由于在实际情况中,指挥员在选择策略时可能发生失误而做出错误的决策,因此需要对算法进行优化。针对这个问题,本文借鉴博弈论中“颤抖的手完美”思想,在MAPPO算法的基础上进行改进。“颤抖的手完美”思想的定义如下:可能发生失误的小概率被称作一个颤抖。根据这个概念,即使其他参与人以较小的概率采取均衡路径以外的行动,构成均衡的策略仍然必须是参与人的最优反应(也就是说,其他参与人的手会“颤抖”)。具体地,在多智能体博弈深度强化学习均衡解的探索过程中,根据动作值函数选择了动作后,会以很小的概率随机选择动作替代原本应该执行的值函数最大的动作。

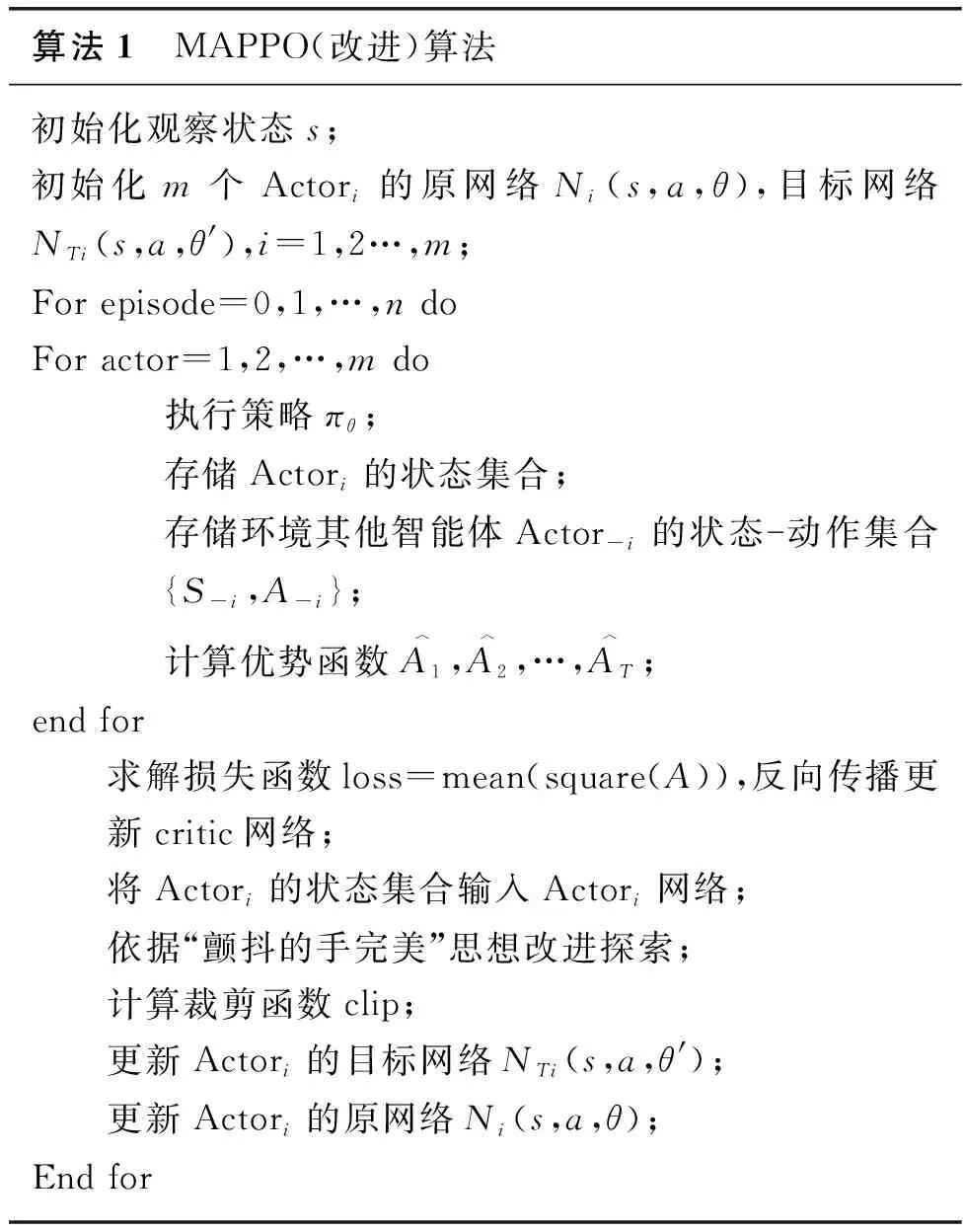

本文采用MAPPO算法和“颤抖的手完美”思想对上述3vs.9无人机反坦克作战想定建模并优化。每个智能体(红方无人机)维护一张Q值网络,通过与环境不断交互获取奖励,学习并更新状态动作值。此外,算法还设置了经验回放机制用于存储红方战机在环境中的训练经验,并以分层抽样方式从经验池中抽取经验以提升学习效率,直至每个智能体在当前状态下,不能通过改变动作获取更大的奖励,奖励值收敛。在本实验的场景下,红方3架无人机具有相同的目标函数和奖赏函数,相互之间是完全合作的关系。本实验通过状态动作值函数迭代方式求累积回报最大值并选取使累积回报最大的动作,在不断迭代的过程中寻找智能体(红方无人机)的最佳策略。该方法在保持原MAPPO[26-28]算法框架不变的情况下,在每个智能体i选择动作时,通过“颤抖的手完美”增加探索,从而实现对基础算法的优化,Critic的动作输入集合在“颤抖的手完美”条件下进行选择。训练的框架图如图2所示,具体步骤如算法1所示。

图2 多智能体博弈深度强化学习无人机智能攻击策略生成框架及改进Fig.2 Generation framework and improvement of multi-agent game deep reinforcement learning unmanned aerial vehicle intelligent attack strategy

算法1 MAPPO(改进)算法初始化观察状态s;初始化m个Actori的原网络Ni(s,a,θ),目标网络NTi(s,a,θ'),i=1,2…,m;For episode=0,1,…,n doFor actor=1,2,…,m do 执行策略πθ;存储Actori的状态集合;存储环境其他智能体Actor-i的状态动作集合{S-i,A-i};计算优势函数A︿1,A︿2,…,A︿T;end for求解损失函数loss=mean(square(A)),反向传播更新critic网络;将Actori的状态集合输入Actori网络;依据“颤抖的手完美”思想改进探索;计算裁剪函数clip;更新Actori的目标网络NTi(s,a,θ');更新Actori的原网络Ni(s,a,θ);End for

3 实验分析

本文以Python3.6[29]作为开发语言,多智能体博弈强化学习算法的网络结构基于 TensorFlow2.0[30]。实验硬件为Intel 512G固态硬盘,Nvidia RTX 2080TI显卡,64G内存,软件环境为Ubuntu 18.04。

3.1 红蓝双方初始位置及主要武器性能参数

红蓝双方初始位置及主要武器性能参数如表1所示。其中:红方无人机挂载的反坦克导弹直径为0.18 m,重量为45 kg,发射高度为18~4 572 m,目标速度为0~1 481 km/h,爬升率为134 m/s,最大射程为9.26 km。蓝方地空导弹排装备的地空导弹的直径为0.17 m,重量为90 kg,目标高度为6~7 620 m,目标速度为0~3 704 km/h,爬升率为323 m/s,最大射程为18.52 km。

表1 红蓝双方初始位置及挂载武器参数表Table 1 Initial positions and parameters of mounted weapons of red and blue sides

3.2 超参数设置

本实验中,超参数设置如表2所示。

表2 参数设置Table 2 Parameter setting

3.3 实验结果分析

红蓝双方进行3 000轮对抗训练,其中,红方战机采用MAPPO算法及其改进算法,蓝方战机采用预编规则。

图3 MAPPO和MAPPO改进算法的累积回报曲线Fig.3 Cumulative return curve of MAPPO algorithm and improved MAPPO algorithm

MAPPO算法和MAPPO改进算法的损失函数值曲线如图4所示。损失函数用于计算训练样本的误差,评估算法对数据的建模程度。若实际结果与预测值相差较大,损失函数也会相应变大;反之,损失函数不断减小。本实验的损失函数逐渐减少,趋向于0,说明MAPPO评价网络的预测值与实际值相差不大,且MAPPO改进算法的损失函数更小,表明改进后的算法的预测值与真实值之间的差值更小,可见改进后的算法提升了预测的准确性。

图4 MAPPO和MAPPO改进算法的损失函数曲线Fig.4 Loss function curve of MAPPO and improved MAPPO algorithm

由于本实验目标中最大化的累积回报是红方3架无人机总的回报值,因此只能反映红方总体的作战效果,无法反映红方每架无人机的战斗力生成情况。为了具体分析红方每架无人机的训练效果,单独统计了每架无人机的累计回报值,统计结果如表3所示。

表3 算法改进前各无人机平均累积回报值统计Table 3 Statistics of average cumulative return value of each unmanned aerial vehical before algorithm improvement

从表3可以看出,随着迭代轮数的增加,每架无人机的累积回报均有增加,在迭代了1 000轮以后,累积回报值趋于收敛。由于2 000~3 000轮时算法已经收敛,因此累积回报的变化不大,这与图3得到的结论一致。由表3还可发现,无人机1和无人机2的累积回报值接近且远大于无人机3,这可能和3架无人机的初始位置有关,无人机1和无人机2在训练过程中更快地学会了相互配合,从而获得了更高的回报值。

算法改进后各无人机平均累积回报值如表4所示。从表4可以看出,经过“颤抖的手完美”改进的MAPPO算法在经过训练后,各个无人机获得的平均累积回报值均有所增加,可见“颤抖的手完美”改进不仅增加了整体的效能,而且提升了每一个智能体的打击和寻路能力。其中,无人机1提升了47.8%,无人机2提升了54.2%,无人机3提升了32%。

表4 算法改进后各无人机平均累积回报值统计Table 4 Statistics of average cumulative return of each unmanned aerial vehical after algorithm improvement

从最后的2 000轮无人机反坦克仿真实验中,选择了一组最具代表性的无人机飞行和打击轨迹图,如图5所示。

图5 无人机反坦克仿真测试轨迹样例Fig.5 Unmanned aerial vehical anti tank simulation test track example

其中,3条曲线分别表示3架无人机的飞行轨迹。从无人机的飞行轨迹图可以看出,在经过了1 000轮的迭代训练后,无人机逐渐学会了避开地空导弹的打击范围,直接对坦克进行火力打击。同时,无人机也分别学会了打击外围薄弱节点和从中路纵向攻击或横向攻击的战术。3架无人机协同配合,首先打击距离自身最近的蓝方目标,再打击较远的目标。总体而言,无人机在寻找最优路径、打击目标节点和协同合作这3个方面均表现出了很好的效果。

4 结束语

针对无人机智能攻击策略生成和优化问题,本文阐述了马尔可夫随机博弈的理论框架,提出了基于多智能体博弈强化学习算法在无人机反坦克仿真场景下的解决思路,并构建了一种基于 MAPPO算法的3vs.9无人机智能攻击策略的训练模型,并使用“颤抖的手完美”对训练模型进行了优化。最后,对相关场景进行了模拟试验和分析。仿真试验表明,该训练模型可产生多种无人机智能攻击策略,对无人化战争下的智能化指挥控制具有较强的现实意义。