基于人机协同的无人系统自主性评估方法

王 菖,郭虎生,柏 航,牛轶峰*

(1. 国防科技大学智能科学学院,长沙 410073;2.32382部队,武汉 430000)

1 引 言

随着智能无人系统技术的持续创新,美军陆续提出了分布式作战、马赛克战、忠诚僚机、无人机蜂群等新型作战概念,无人作战样式正向着智能化、协同化、集群化不断发展[1]。例如,马赛克战具备低成本、灵活自主、分布式和抗抵消等特点,推动以“分布式决策为中心”的体系作战样式发展,代表了当今世界作战概念的先进水平[2]。智能无人系统是诸如马赛克战的无人作战基础单元,无人系统的自主程度将直接影响无人作战的整体效能。然而,无人系统的自主程度并非越高越好,而是需要根据作战意图和战场态势进行动态调整,高效的有人/无人系统协同、人机协同是贯彻作战意图和实现态势理解的重要保障。

无人系统的自主性(Autonomy)是指其凭借自身平台的感知、决策、规划、行动、学习等基本能力,独立完成指定任务的综合能力水平。由于任务的复杂性、环境的动态不确定性,以及可能引发的伦理和法律等问题,无人系统仍需在操作人员的监督和干预下自主运行[3]。研究无人系统的自主性评估问题可以避免关于自主性描述上的模糊性,有助于无人系统的工程实现和性能提升,对于政策制定者、研制和设计者以及相关用户都有非常重要的意义[4]。无人系统的自主性评估需要选取合理的评价指标,采用定性或定量方法划分其自主能力水平。文献中对于自主性和自主等级(Levels of Autonomy,LOA)的定义主要是从机器平台的操控视角出发,考虑人机功能分配[5-6]和人机控制权限[7]等问题。然而,随着无人系统自主控制和学习能力的持续提升,有人系统与无人系统的协作模式逐渐从“遥控”向“主从协同”的方向发展[8],因而需要将无人系统抽象成高级的智能体(Agent),从自主协同和自主学习的角度考虑其自主性评估问题。

基于OODA(即Observe 观察、Orient 判断、Decide 决策、Act 行动)循环理论[9],本文主要从感知与认知、决策与规划、行动与控制等三个维度评估无人系统的基础能力,每个维度都采用协同性和学习性评估指标。其中,协同性评估是基于人机协同模型中的OPD[8](即Observability 可观察性、Predictability 可预测性、Directability 可干预性)准则,主要考虑人机之间能否观察彼此内部状态的表示、能否预测彼此的意图和计划,以及能否干预彼此的行动过程;另一方面,学习性评估是基于机器学习方法的特点(训练样本监督程度、学习可持续性、知识可迁移性等),主要考虑无人系统自主学习过程中需要人工参与的程度。在此基础上,构建了基于人机协同的无人系统自主性评估表,并提出了一种自主等级量化评估方法。

2 自主性评估方法

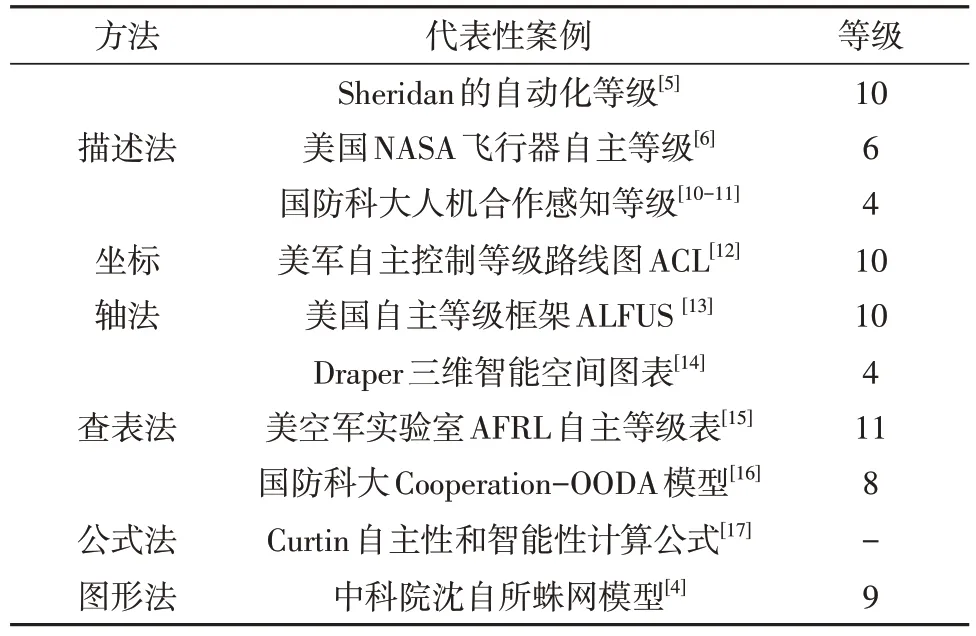

目前,国内外无人系统自主性评估方法主要包括描述法、坐标轴法、查表法、公式法、图形法等,上述方法及其代表性案例如表1所示。

表1 无人系统自主性评估方法Table 1 Autonomy evaluation for unmanned systems

2.1 描述法

当前很多关于自主等级的定义都源自于美国麻省理工学院Sheridan等提出的自动化等级划分理论[5]。该理论描述了操作人员与自动化机器之间的交互方式,包括完全由人操控、需要人同意、人默认同意、机器自动运行等10 个等级。由于自主无人系统也属于一种自动化机器,因此可以借鉴自动化等级理论进行自主等级划分。然而,该理论侧重于描述人机功能分配问题,尚未考虑自主无人系统与任务相关的感知、规划、决策等方面的能力。因此,该理论不宜直接用于评价无人系统的自主水平[8]。

针对高空长航程无人机,美国航空航天局(National Aeronautics and Space Administration,NASA)描述了从低到高的6 个自主等级及其特征[6]:遥控(人在回路中,100%掌控时间)、简单自动控制(基于自动驾驶仪,80%掌控时间)、执行预编程任务(无人机综合管理、预设航路点飞行,50%掌控时间)、半自主(可自主起降,具有基本态势感知能力,具有常规决策能力和权限,链路中断后可继续原任务,20%掌控时间)、完全自主(具有广泛的自身及环境态势感知能力,具有全面决策能力和权限,能够自动进行任务重规划,小于5%掌控时间)、协同操作(多无人机协同飞行)。需要人操作的时间与自主等级为反相关。NASA的分级标准较为简洁,初步提供了高空长航程无人机的自主等级划分依据。

针对人机合作感知型任务,国防科技大学的研究人员提出了更为简洁的4个自主等级描述:H(人控制)、HR(人监督)、RH(人辅助)、R(全自主)。Zhao 等[7]考虑低人机比监督控制条件下(1 人控4 机)的无人机目标侦察问题,自主等级可根据任务复杂度、环境复杂度、人的状态等因素自适应调整。吴雪松[10]假设机器具备一定的自动目标检测与识别能力,但仍在遮挡、运动、混淆等条件下存在不足,通过对比各自主等级下的目标识别正确率,表明RH在多目标检测与识别任务中效果较好。针对无人机毁伤评估任务,王治超[11]将无人机侦察图像变化检测与数值仿真方法相结合,从人机功能分配的视角描述自主等级。上述研究主要侧重于研究机器感知能力受限情况下的无人系统自主等级调整问题,尚未全面考虑决策、规划、控制等方面的任务能力。

2.2 坐标轴法

坐标轴法主要包括双坐标轴法和三坐标轴法。其中,双坐标轴法的典型代表是美国军方提出的10 个自主控制等级(Autonomous Control Level,ACL)路线图[12],三坐标轴法的典型代表是美国国家标准和技术研究所智能系统部提出的无人系统10 个自主等级(Autonomy Levels for Unmanned Systems,ALFUS)框架[13]。ACL 双坐标轴法来源于美军发布的《无人机路线图》,横轴是时间节点,纵轴是自主能力目标,主要用于规划特定无人系统应在特定时间节点达到怎样的自主等级。ACL 倡导发展分布式自主无人机集群。与此不同,ALFUS三坐标轴法是从任务复杂性、环境复杂性、人机交互性等三个方面进行自主性评估,总体自主等级是由这三个方面的评估结果加权得到。与此前的方法相比,ALFUS 三坐标轴法考虑较为全面。但是,每个坐标轴上的因素应如何选择、量化和加权仍存在一定的不确定性。

2.3 查表法

查表法通常是在表格中设置多种自主性评价因素,可以比较全面地描述自主无人系统的自主能力。美国Draper 实验室研究人员[14]提出了4 个自主等级的三维智能空间图表,从运动控制、任务规划、情景感知等3 个方面综合评价无人系统的自主性。针对感知、协调、决策、控制4个维度,美国空军实验室(Air Force Research Laboratory,AFRL)提出了具备11 个等级的自主能力分级表[15],从低到高的等级描述如下:执行预先规划任务、可变任务、实时故障/事件的鲁棒响应、故障/事件自适应平台、实时多平台协调、实时多平台协同、战场战术认识、战场战略认知、战场集群认知、完全自主。同样基于OODA 理论,国防科技大学Wu 等[16]将AFRL 的自主等级精简为8 个,并增加了对协同和交互能力(人机交互、协同观测、协同分析、协同决策以及协同行动)的评估维度,提出了Cooperation-OODA模型。

2.4 公式法

公式法主要是针对特定的无人系统,通过构建经验公式来计算无人系统的自主能力。公式的结构设计和参数设置都对计算结果有较大影响。Curtin 等[17]使用控制量、总信息量、控制时间、总控制时间等因素计算了水下机器人的自主性。

2.5 图形法

考虑到不同任务中无人系统自主等级的差异性,中国科学院沈阳自动化研究所的王越超等[4]提出了一种无人系统自主等级蛛网评价模型。蛛网评价模型从一个原点向外辐射几条轴,每条轴代表一个技术因素,且都有 9 个技术成熟程度等级。针对每个指定的无人系统,每个技术因素对应一个确定的级别,最后把每条轴上的对应点连接起来,形成的蛛网纬线可用于评价该无人系统的自主性。蛛网模型具有较好的普适性和直观性,但缺乏对每个技术因素的详细解释,且难以判别各因素间的耦合和独立性。

2.6 小结与分析

文献中的自主性评估方法源自于人与自动化机器协作中的功能分配问题,然后针对特定任务和特定类型的无人系统进行了个性化设计。随着无人系统的应用模式向无人集群和人机协同方向发展,交互性与协同性成为了必须考虑的评估因素。此外,此前的研究尚未考虑无人系统的自主性评估与无人系统的内部实现方式(体系结构、算法程序等)之间的关系,而是更加关注如何评估自主无人系统完成任务的能力。然而,随着人工智能技术自2015 年以来的飞速发展,机器学习技术对无人系统的感知与认知、决策与规划、行动与控制、交互与协同等基础能力产生了全方位影响,因此也应作为自主性评估的重要考量。

由于自主性评估涉及的要素不断增加,且每种要素的内涵也越来越复杂,因此难以构建通用的无人系统自主性评估方法。与此前的研究不同,本文兼顾无人系统的感知与认知、决策与规划、行动与控制能力评估以及机器学习技术对上述基础能力的影响,从传统人机功能分配视角转变为人机智能协同视角,重点运用表格法和公式法分别进行无人系统的自主性分析与量化评估。

3 自主性评估指标

3.1 协同性

协同性主要考察人机之间从“感知”到“行动”环节的OPD准则,如图1所示。

图1 人机内部模型表示及其协同性[8]Fig.1 Internal models for human-robot teamwork[8]

3.1.1 可观察性

可观察性用来评估人机之间内部状态的共享程度和互理解程度,即“对方看到的是什么”“对方认为看到的是什么”,主要涉及感知与认知方面的问题。一方面,人通过读取机器的传感器数据,使用可视化、机器学习等技术来观察机器的感知与认知信息。例如,可以使用无人机遥控终端观看无人机摄像头拍摄的画面,并标记机器检测、识别与跟踪的物体。此外,机器的感知与认知方式是由人预先定义和设计的,具有较好的可理解性和可操作性。另一方面,可以通过眼动、语音、手势、脑机接口等智能交互方式获取多模态人机交互数据,然后使用人工智能算法提取人的内部状态。例如,可以从眼动数据中判断人的注视点、疲劳和繁忙程度[18]。

3.1.2 可预测性

可预测性用于评估人机之间意图和计划的互理解和互预测程度,即“对方将要做什么”“对方将要怎么做”,主要涉及决策与规划方面的问题。

机器决策与规划的方法多样,因而机器决策与规划结果的表示形式也不尽相同。其中,贝叶斯网络、规则集、表格等形式较为直观,具有较好的可理解性和可预测性,而神经网络的形式难以理解和预测。

规划结果通常可以使用图表化的形式来表达,具有较好的可理解性和可预测性。例如,任务管理软件可以实时监控每架无人机的任务进度,地面控制软件可以显示无人机规划的航线,任务规划软件可以输出带时间窗约束的复杂任务分解和分配结果[19]。

相对而言,人的意图和计划较难被机器理解和预测。虽然人的意图和计划可以通过鼠标、键盘、触摸屏等传统二维交互方式直接输入到机器中,但是未来的人机协同作业需要更加自然的智能人机交互方式。例如,在语音交互中,语音识别技术可以将口头下达的指令转化为文本形式,语义理解技术可以分析文本的含义,例如实现基于语音的无人机自动路径规划[20]。

此外,可以从多智能体系统的角度考虑,采用人机统一的认知模型来表示意图和计划,并通过智能体之间的消息传递机制实现互理解和互预测。例如,在人机混合多智能体协作采集任务中,Belief-desire-intention(BDI)智能体通过共享意图和信念,可以有效提升团队协作效率[21]。

3.1.3 可干预性

可干预性用于评估人机相互控制的程度,即“谁主导控制”,主要涉及行动与控制方面的问题。一般而言,人机协同系统是由人主导控制,例如由人操控的防御性自主武器可用于人类难以做出快速反应的作战场景[22]。

由人主导控制能够降低由于自主无人系统行动失控引发的安全风险。但有些情况下可以允许机器主导控制权,并防止人的不当干预。例如,假设固定翼无人机的自主降落程序可以安全稳定运行,如果人按照自己的观察和判断而施加错误干预,反而可能会导致飞机坠毁。

3.2 学习性

考虑机器学习方法的主要特点,本文将训练样本监督程度(强监督、弱监督、自监督)、学习可持续性(离线学习、持续学习、终身学习)、知识可迁移性(不可迁移、手动迁移、自动迁移)作为无人系统自主学习能力的主要评价指标。

3.2.1 训练样本监督程度

训练样本监督程度是指无人系统在自主学习过程中获取训练样本所需要的人工参与程度,主要涉及样本标签、样本获取方式等问题。监督程度的分级如下:

(1)强监督:所有的训练样本由人选择,且样本都有人工标注的标签,主要使用监督学习方法;

(2)弱监督:训练样本主要由人选择,部分样本具有人工标注的标签,主要使用半监督学习、强化学习方法;

(3)自监督:训练样本由机器自主选择,样本无需人工标注,主要使用主动学习、无监督学习方法。

从自主性的角度来看,训练样本需要人监督的程度越低,意味着无人系统自主学习能力越强。特别指出,当前的强监督、弱监督、自监督学习方法各有特色,并无优劣之分。此外,训练样本量暂不作为自主学习能力评价指标。

3.2.2 学习可持续性

学习可持续性是指自主无人系统在预先训练、任务执行、全寿命周期内的可持续学习程度,主要涉及模型更新方式、样本获取方式等问题。可持续性的分级如下:

(1)离线学习:模型和样本都由人选择,学习是在任务执行前完成,学习完成后不再收集新样本或更新模型;

(2)持续学习:模型和样本可以由人选择或机器自己选择,可以在特定环境和任务中持续收集新样本,已经学习的模型可以持续更新;

(3)终身学习:模型和样本主要由机器自己选择,可以在开放环境中按需持续收集新样本,已经学习的模型可以持续更新。

无人系统学习的可持续性越好,意味着自主学习能力越强。当前的无人系统学习模式主要是由人选择模型和样本,并且以离线学习为主。例如,主流的深度学习方法需要预先训练深度神经网络模型,且模型越复杂越难以持续更新。此外,当前的学习方法主要考虑的是特定的学习环境。终身学习需要考虑复杂、动态、不确定、非合作环境下的自适应模型选择和样本获取问题,是实现机器高自主学习水平的必由之路。

3.2.3 知识可迁移性

知识可迁移性是指无人系统在解决新任务时能够使用已学习知识的程度,主要涉及迁移学习、课程学习、多任务学习等方法。分级如下:

(1)不可迁移:仅考虑单任务学习问题,样本、模型、参数、策略都不可以在新任务中重新使用;

(2)手动迁移:考虑存在多个任务的学习问题,可以由人手动选择迁移有用的样本、模型、参数、策略,并由人评估迁移效果;

(3)自动迁移:考虑存在多个任务的学习问题,由机器自主选择迁移哪些样本、模型、参数、策略,并由机器自主评估迁移效果。

学习的可迁移性越好,意味着自主学习能力越强。当前很多学习方法只考虑单任务学习,未来必须考虑从单任务到多任务、从简单任务到复杂任务的迁移学习和知识重用问题[23]。

4 自主性评估表

基于所提出的自主性评估指标,本文设计了基于人机协同的自主性评估表,如表2所示。

表2 基于人机协同的自主性评估表(基于OPD准则和学习能力)Table 2 Autonomy evaluation table based on human-robot teamwork (OPD Criteria and Learning,OPDL)

4.1 零级L0——人操控

无人系统不具备自主性,感知与认知、决策与规划、行动与控制等各个环节都完全由人操控,不考虑OPD准则,且不具备学习能力。

4.2 初级L1——人委派

OPD 准则满足“人观察机、人预测机、人干预机”,感知与认知、决策与规划、行动与控制能力的学习都是“强监督、离线学习、不可迁移”。下面通过例子进行说明。

4.2.1 L1的OPD准则满足度

在地面站控制单架无人机执行对地侦察任务中,地面站操作人员可以通过空地数据链路,获取无人机光电吊舱拍摄的侦察图像,并通过地面站软件界面观察无人机的航线以及任务时间线,从而预测无人机的航向以及即将执行的任务序列。此外,在无人机遇到突发恶劣天气威胁、地面雷达或导弹威胁等情况时,操作人员可以干预无人机绕飞威胁区域。

4.2.2 L1感知与认知学习能力

在无人机对地面车辆目标的识别任务中[14],可以使用大量人工标注样本,采用深度神经网络模型并进行离线训练,所学的模型不可迁移至其他目标的识别任务中。

4.2.3 L1决策与规划学习能力

在无人机导航与避障任务中[24],可以使用基于Q-学习的DQN、DDQN 等强化学习算法,在给定的仿真环境中进行大量的离线训练,训练样本由训练人员采集,且所学策略不能迁移至其他任务中。

4.2.4 L1行动与控制学习能力

在固定数量的无人机群编队飞行控制策略学习任务中[25],可以使用深度强化学习框架和深度神经网络模型进行离线训练,所学模型不可迁移至其他规模的无人机群飞行控制任务中。

综上所述,L1适用于静态环境中的特定任务,需要消耗大量的人力成本,难以适应高动态环境中的复杂任务。

4.3 中级L2——人监督

OPD 准则满足“互观察、人预测机、人干预机”,感知与认知、决策与规划、行动与控制能力的学习都是“弱监督、离线学习、手动迁移”。与L1 相比,L2 在OPD 准则满足度方面的提升主要体现在支持人机“互观察”,即人与无人系统可相互观察彼此的内部状态;学习能力方面的提升体现在从“强监督”变为“弱监督”,且从“不可迁移”变为“手动迁移”。下面通过例子进行说明。

4.3.1 L2的OPD准则满足度

在有人机/无人机协同对地侦察任务中[11],有人机可以通过机间数据链获取无人机侦察的目标信息、航线、任务时间线,同时无人机也可以通过机间数据链获取有人机侦察的目标信息、航线、任务时间线,从而支撑有人机/无人机协同动态任务分配。此外,在无人机遇到突发恶劣天气威胁、地面雷达/导弹威胁等,有人机飞行员可以干预无人机绕飞威胁区域。有人机可以预测无人机的计划和行为,但无人机不能预测有人机的计划和行为。有人机具有对无人机的飞行控制权限,但无人机不能干预有人机的飞行控制。

4.3.2 L2感知与认知学习能力

在无人机对车辆目标的图像识别任务中[26],可以使用少量的人工标注样本和大量的未标注样本,采用半监督学习、小样本学习等方法进行离线训练,所学的模型和参数可手动迁移至相关的目标识别任务中。

4.3.3 L2决策与规划学习能力

在无人车集群导航与避障任务中[27],可以使用DDPG 强化学习算法,将仿真环境中预先训练好的4辆车的导航避障策略迁移至8辆车的导航避障场景中,从而提升新环境中的策略学习速度。

4.3.4 L2行动与控制学习能力

在规模可变的无人机群编队飞行控制策略学习任务中,可以使用特殊的机制将可变数量的输入映射为固定长度的向量,可以使用深度强化学习框架和深度神经网络模型进行离线训练,所学的模型可迁移至任意规模的无人机群编队飞行控制任务中[28]。

综上所述,L2 适用于低动态环境中的特定任务,需要消耗一定的人工成本,能够应对简单的突发事件,却难以适应高动态环境中的复杂任务。

4.4 高级L3——混合主动

OPD 准则满足“互观察、互预测、人干预机”,感知与认知、决策与规划、行动与控制能力的学习都是“弱监督、持续学习、手动迁移”。与L2相比,L3在OPD 准则满足度方面的提升主要体现在支持人机“互预测”,即人与无人系统可相互观察彼此的意图和计划;学习能力方面的提升体现在从“离线学习”变为“持续学习”。下面通过例子进行说明。

4.4.1 L3的OPD准则满足度

在多智能体协作采集任务中[8],基于BDI 模型的多智能体系统统一表示了人与虚拟机器人的内部模型,智能体之间可以分享彼此的意图、状态、行动计划,有效提升了团队任务的完成效率。

4.4.2 L3感知与认知学习能力

在无人机对车辆目标的图像识别任务中[29],无人机可以基于少量不同视角拍摄的车辆图片,学习车辆不同部件的轮廓特征,并结合概率推理模型,用于持续提升车辆识别的正确率。

4.4.3 L3决策与规划学习能力

在基于交互式深度强化学习的无人车导航任务中,导航策略可以在人的引导下持续更新[30]。在人形机器人学习如何使用工具物品的任务中,可以基于自驱动强化学习方法自主学习探索策略[31],并将所学知识迁移到新物品的使用中[32]。

4.4.4 L3行动与控制学习能力

在大规模无人机集群避碰飞行控制策略学习任务中[33],可以使用课程学习方法将复杂的学习任务分解为一系列从小规模到大规模、从简单到复杂的持续性课程,从而提升学习效率。

L3 能够适应高动态环境中的复杂任务,需要较少的人工成本,是当前技术发展的最高水平。

4.5 超级L4——全自主

OPD 准则满足“互观察、互预测、互干预”,感知与认知、决策与规划、行动与控制能力的学习都是“自监督、终身学习、自动迁移”。与L3相比,L4 在OPD 准则满足度方面的提升主要体现在支持人机“互干预”,即人与无人系统可相互引导甚至控制对方的行动;学习能力方面的提升体现在从“弱监督、手动迁移”变为“自监督、自动迁移”。下面通过例子进行说明。

4.5.1 L4的OPD准则满足度

在有人机/无人机群对地侦察打击任务中,有人机与无人机群间可以共享彼此的内部状态,能够预测彼此的意图和计划。当无人机发现有人机处于危险状态时,可以先提醒有人机,如果无效或情况紧急,则可以临时接管有人机的控制权限,协助其逃离危险区域。

4.5.2 L4感知与认知学习能力

发展型机器人[34]倡导模仿幼儿探索未知世界的方式,通过自主探索和自我确认,持续更新对环境和自身的认知。

4.5.3 L4决策与规划学习能力

在空战决策问题中[35],智能体可以自学习和演化空战规则,能够判断对手策略是否变化,并且可以重用已有知识或按需继续学习新策略。

4.5.4 L4行动与控制学习能力

野外地面无人运输车可以在新的复杂地形环境中按需收集有价值的数据样本,持续提升其在导航、避障、跟随、运输等行为的自主控制水平,并且自适应调整已有策略。

综上所述,L4 能够适应高动态、强对抗、不确定环境,除了必要的交互外,无人系统几乎可以完全自主运行。

5 自主等级量化评估

针对感知与认知、决策与规划、行动与控制不同能力视角下的每个等级,以及协同性和学习性指标,OPDL定性给出了自主等级的描述性评估方法。然而,如何综合评估无人系统的自主等级仍然存在困难。

例如,如果某个无人系统的OPD 准则满足度都是L2级,感知与认知学习能力是L2级,决策与规划学习能力是L3级,行动与控制学习能力是L2级,应当如何评估其自主等级?一种可行的方法是由最低的基础自主等级决定综合自主等级,即L2。但该方法缺乏定量的分析过程,难以精确计算。

本节设计了一种基于加权求和的无人系统自主性评估的定量计算方法为

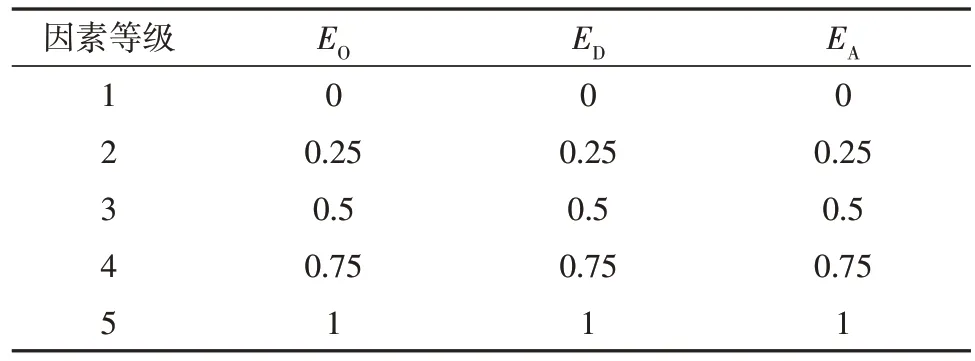

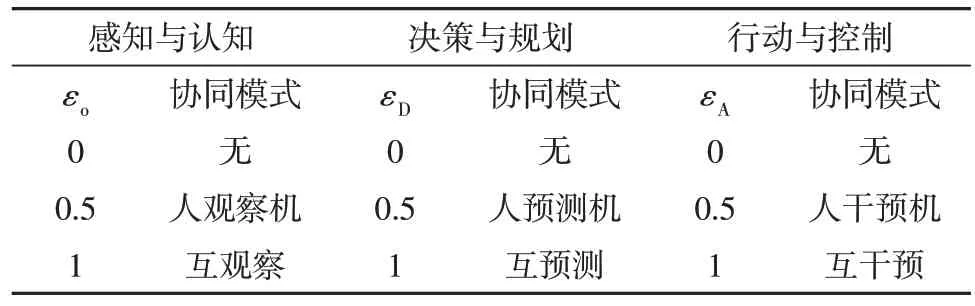

式中,EO、ED、EA分别表示感知与认知、决策与规划、行动与控制三个方面的学习能力指标(参见表3),其取值范围是[0,1]区间中的实数;εo、εD、εA分别表示感知与认知、决策与规划、行动与控制的OPD 准则满足度,取值范围也是[0,1]区间中的实数(参见表4)。

表3 学习能力量化表Table 3 Quantification table of learning ability

表4 OPD准则满足度量化表Table 4 Quantification table of OPD criteria satisfaction

学习性和协同性能力指标EO、ED、EA、εo、εD、εA的离散化参考值是将[0,1]区间按因素等级的数量平均得到。由于本文采用5 个自主等级描述,因此学习能力量化表也选择相应的5 级。OPD 准则主要考虑人机间的交互,因而分为3级。

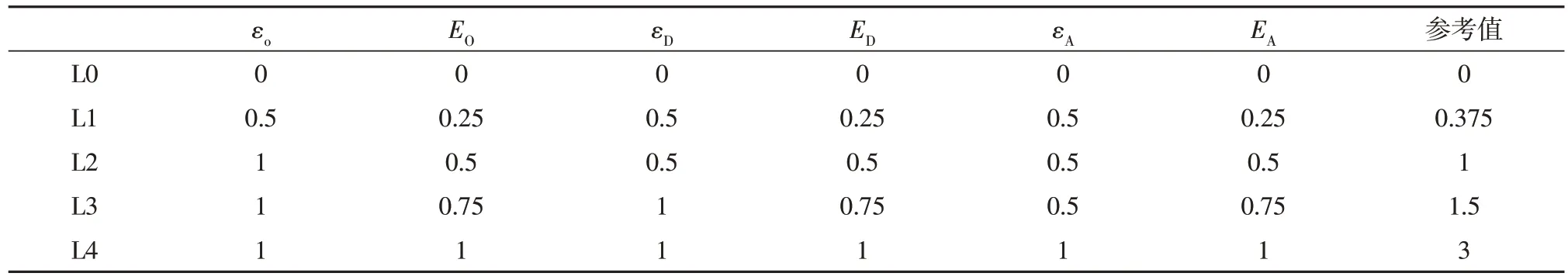

为了合理计算综合自主等级,应当参考HROPDL 自主性评估表的定性分级标准。因此,将表3 和表4 的数值代入表2 中进行计算,得到自主等级分级参考表,如表5所示。

表5 自主等级分级参考表Table 5 Reference table for autonomy level grading

根据式(1)和每项能力指标查表对应的数值,计算得出E后按下列规则评判综合等级:

(1)当E= 0 时,综合自主等级为L0;

(2)当0 <E≤ 0.375时,综合自主等级为L1;

(3)当 0.375<E≤ 1时,综合自主等级为L2;

(4)当 1 <E≤ 1.5 时,综合自主等级为L3;

(5)当 1.5 <E≤ 3 时,综合自主等级为L4。

针对本节开始提出的某自主无人系统的量化评估问题,计算得出E= 0.875,因此属于L2。

特别指出,本文采用均匀长度的区间量化学习性和协同性能力指标,其主要原因在于较为简洁直观。非均匀的区间分割也是可行的,例如可以将更高能力等级对应的数值增大,从而使得表5中更高自主等级的参考值更高,即使得能力等级参考值分布更为均匀。换而言之,不同的区间分割方式将会影响综合量化自主等级的参考值。然而,在给定的区间分割方式下,表5 的能力等级参考值可以作为综合评估的参考阈值。由于自主性评估采用的是式(1)的加权求和方式进行计算,综合自主能力的量化值应当能够落在相应的等级区间中。类似的,能力因素等级数量也会影响综合量化自主等级的参考值,但最终得到的综合自主等级评估数值也仍应能够落在相应的等级区间中。综上所述,本文提出的方法具有一定的普适性,可以根据需要进行相应调整。

与文献中针对具体无人系统的OODA 各环节能力或者人机功能分配方式的自主性评估方法不同(参见表1),本文提出的方法更侧重于无人系统的人机协同能力和自主学习能力,尤其是在人机协同关系和机器学习方式方面的划分更细致。例如,美国NASA 飞行器自主等级[6]、美空军实验室AFRL 自主等级[15]、国防科大Cooperation-OODA 模型[16]等方法虽然提到了“协同操作”“战场认知”“完全自主”等概念,都需要有效的协同和机器学习技术作为支撑,然而上述文献并没有明确描述涉及的协同关系或者机器学习方式。以“忠诚僚机”为代表的现役无人系统仍以遥操作控制方式为主,其OPD 准则满足程度仍以人观察机、人预测机、人干预机为主(不高于L1),且朝着互观察、互预测、互干预(L4)的方向发展,但是其学习能力主要以强监督、离线学习、不可迁移为主(不高于L2),因此其综合自主等级目前难以突破L2。未来的无人系统如果具备持续学习和自动迁移学习能力,则可能达到本文提出的L4。

6 结 论

本文研究了基于人机协同的无人系统的自主性评估问题,提出将感知与认知、决策与规划、行动与控制等三个能力维度的协同性和学习性作为自主性评估的主要因素。其中,协同性主要考虑人机之间的可观察性、可预测性和可判断性;学习性主要考虑无人系统自主学习过程中需要人参与的程度。综合运用描述法、表格法和公式法,设计了人操控、人委派、人监督、混合主动、全自主等五个等级的自主性评估表,并提出了一种自主性量化计算方法。所提出的方法充分考虑了无人系统应用和机器学习技术的发展现状与趋势,有望广泛应用于各类无人系统的自主性评估。