群体信息对面部表情识别的影响*

王伟晗 曹斐臻,2 余林伟 曾 珂 杨鑫超 徐 强

群体信息对面部表情识别的影响*

王伟晗1曹斐臻1,2余林伟1曾 珂3杨鑫超1徐 强1

(1宁波大学心理学系暨研究所, 浙江 宁波 315211) (2华南师范大学心理学院, 广州 510631) (3中山大学心理学系, 广州 510006)

本研究通过3个实验探讨群体信息对面部表情识别的影响。结果发现:(1)周围面孔的情绪状态影响个体对目标面孔情绪的识别, 两者情绪一致时的反应时显著短于不一致时的反应时, 且面部表情识别准确性更高。(2)群体信息会调节周围面孔情绪对目标面孔的影响, 进而影响面部表情识别。具体而言, 群体条件下, 个体对目标面部表情的识别受到周围面孔情绪状态的影响, 相比周围面孔情绪与目标面孔情绪不一致, 两者情绪一致时, 即符合个体基于知觉线索建立的群体成员情绪具有一致性的预期, 面部表情识别的准确性更高、速度更快; 而非群体条件下, 个体则不受周围面孔情绪状态的影响。研究结果表明, 个体能够基于互动人物之间的社会关系识别面孔情绪, 群体存在时, 会建立群体成员情绪具有一致性的预期, 进而影响面部表情识别。

面部表情, 群体信息, 情绪识别, 情绪一致性, 预期

1 前言

情绪产生于个体与他人的互动中, 面部表情的准确识别对社会交互过程影响重大(Keltner & Haidt, 1999; van Kleef, 2009)。以往研究大多基于情绪类别理论(Ekman, 1993), 孤立呈现面部表情, 以探讨个体对面部表情的加工过程(Adolphs, 2002; Susskind et al., 2007)。近年来研究发现, 个体对面部表情的识别不仅依赖面孔构型信息, 场景、身体姿势、语言文字、面孔等情境信息也是面部表情识别的重要线索(Aviezer et al., 2008; Gray et al., 2017; Lindquist & Gendron, 2013; Mumenthaler & Sander, 2012; Wieser & Brosch, 2012)。现实生活中, 个体往往是在社会互动过程中完成对他人面部表情的识别, 群体信息作为社会互动的情境, 是否以及如何影响面部表情识别尚不清晰。因此, 本研究拟探讨群体信息对面部表情识别的影响。

大量研究表明, 个体对面部表情的识别并不是孤立的, 来自面孔外部的情境信息同样在面部表情识别中发挥着重要作用(Cao et al., 2023; Gray et al., 2017; Lindquist & Gendron, 2013; Mumenthaler & Sander, 2012; Wieser & Brosch, 2012), 即面部表情识别的情境效应(context effects), 具体表现为情境与面孔情绪一致时的促进作用及不一致时的阻碍作用(Aviezer et al., 2008; 李婉悦等, 2020; 徐强等, 2014)。现实互动过程中, 面孔往往伴随着群体情境出现。以往有研究探讨了群体面孔的情绪信息对群体中目标面孔情绪加工的影响(Griffiths et al., 2018), 结果发现, 个体在编码目标面孔情绪的同时, 也会对群体情绪进行编码, 进而影响个体对目标面孔情绪强度的记忆, 即偏向群体平均情绪强度。例如, 当个体观察到一个略微生气的人和一群更生气的人处在一起时, 其对目标人物情绪状态的记忆将比实际状况更生气, 且这一效应也存在于面孔吸引力评价中(Carragher et al., 2021; Walker & Vul, 2013; Ying et al., 2019)。上述研究表明, 群体面孔的整体表征能够影响个体对群体中目标面孔的信息编码, 反映了个体对群体面孔的整合加工。然而并未有研究从不同群体属性的角度出发, 探讨群体信息对面部表情识别的具体影响。

群体作为一个动态的社会结构, 由群体成员(个体)组成(Vukšić-Mihaljević & Mandić, 2001), 个体的行为往往是其与社会情境中其他个体共同交互的结果。研究发现, 观察者不仅可以依据刻板印象形成群体信息(Yzerbyt & Demoulin, 2010), 也能基于社会个体的空间接近性、相似性、共同命运等形成知觉整体的线索(Campbell, 1958), 产生群体存在性与边界的认识, 进而感知群体信息(Morewedge et al., 2013; Sweeny et al., 2013; 徐浩等, 2019), 且这种对群体信息的知觉能力在个体早期生命阶段就已存在(Powell & Spelke, 2013), 表明人类具备通过知觉线索提取群体信息的能力。有研究发现, 基于知觉线索形成的群体信息在个体的认知加工中起着重要作用。Dang等人(2018)通过操纵群体成员的空间临近性和相似性提供群体信息, 发现被试认为属于同一群体的成员更温暖且有能力。徐浩等人(2019)也发现, 基于知觉线索形成的群体认识, 促使个体建立了群体成员行为具有一致性的预期。以上证据表明, 基于知觉线索形成的群体信息会影响个体的认知加工过程。基于此, 面部表情识别作为个体认知加工中极其重要的一方面, 本研究预期群体信息会对个体识别面部表情产生影响。

此外, 本研究进一步探讨的问题是, 群体信息以何种方式影响面部表情的识别?以往研究发现, 当个体与群体内成员互动时, 能够根据群体内其他成员的已知属性推测该成员的未知属性, 认为该成员也具有这一属性(徐浩等, 2019)。此外, 当观察者预测群体中的个体行为时, 往往对其作出与群体内其他成员一致的推断(Todd et al., 2012)。那么在面部表情识别中, 群体内其他面孔的情绪状态是否也会影响个体识别目标面孔情绪?即群体存在时, 个体也会根据周围其他成员的情绪状态推测目标面孔的情绪, 反之则不会。有研究为该问题提供了支撑。Mumenthaler和Sander (2012)的研究发现, 当周围面孔的注视方向指向目标面孔时, 表示其对目标面孔的社会评价, 不仅增强了情绪一致性效应, 且当周围面孔情绪与目标面孔情绪存在功能关联时, 识别目标面孔的准确性提升。该研究表明个体会利用两者之间的联系来判断目标面孔的情绪。之后, Mumenthaler等人(2018)通过改变周围人物的头部转向来操纵其与目标人物之间的联系, 发现只有当周围人物转向目标人物且两者情绪一致时, 观察者才会对目标人物的情绪做出更快的判断。Gray等人(2017)也通过头部转向操纵目标人物与周围人物的互动, 得到了类似的结果。研究者认为, 这是因为个体利用周围人物的情绪状态推理目标面孔情绪, 且这种推理只发生在二者存在一定的社会互动关系时。同样, 当个体知觉到周围面孔与目标面孔属于同一群体时, 群体中其他成员的情绪状态可能会影响其对目标面孔情绪的判断。因此, 本研究预期, 群体信息能够调节周围面孔情绪对目标面孔的影响, 进而影响面部表情识别。

综上所述, 本研究假设:群体信息会调节周围面孔情绪状态对目标面孔的影响, 进而影响面部表情识别。具体而言, 群体条件下, 周围面孔的情绪状态会影响个体对目标面孔情绪的判断, 产生情绪识别的情境效应, 即相比两者情绪不一致时, 情绪一致时的表情识别准确性更高、反应速度更快; 而非群体条件下, 周围面孔的情绪状态则不会影响个体对目标面孔情绪的判断。

2 实验1:多项选择任务中群体信息对面部表情识别的影响

2.1 方法

2.1.1 被试

使用G*power 3.1计算研究所需样本量(Faul et al., 2007), 设置参数为:被试内重复测量方差分析, 效应量= 0.25, 统计检验力1 − β = 0.9, ɑ = 0.05, 测量次数 = 6, 计算得到样本量为24人, 实际招募29名大学生被试(女性16名, 平均年龄为20 ± 1.8岁)参加实验。所有被试母语均为汉语, 视力或矫正视力正常, 无色弱色盲, 均为右利手, 无精神病史。实验前, 所有被试均阅读和签署了实验知情同意书, 完成实验后可获得一定的报酬。

2.1.2 实验刺激与设备

面部表情图片选自Nimstim图片系统(Tottenham et al., 2009), 其中快乐、恐惧、中性面部表情图片各15张(8男7女)。图片统一采用 PhotoShop CS6软件进行黑白处理, 匹配图片大小、明暗度和对比度。所有面孔材料去除其头发、耳朵等, 仅保留面孔内特征(如眼鼻口、脸颊等)。31名未参与正式实验的被试对面部表情图片的效价(1 = 非常消极, 9 = 非常积极)和唤醒度(1 = 非常平静, 9 = 非常激动)进行1~9点评分。结果表明, 快乐、恐惧面孔图片的效价差异显著(快乐= 6.71,= 0.88; 恐惧= 3.80,= 1.48;(29) = 8.05,< 0.001), 唤醒度差异不显著(快乐= 6.22,= 1.29; 恐惧= 5.89,= 1.51;(29) =1.77,= 0.09), 符合实验要求。

通过Photoshop制作不同颜色的三角形作为人物身体, 具体为红色(RGB: 255, 0, 0)、绿色(RGB: 0, 255, 0)、蓝色(RGB: 0, 0, 255)。实验程序中, 所有身体与面孔自行拼接。实验刺激呈现在24英寸LED显示器(BenQ XL2430-b)上, 垂直刷新频率为60 Hz,被试与屏幕距离约70 cm。

2.1.3 实验设计

采用2 (面部表情:快乐、恐惧) × 3 (群体线索:群体、非群体、控制)的被试内实验设计。因变量是由滑块评分计算得到的一致性指数(Congruence index)和辨别指数(Discrimination index)。一致性指数和辨别指数的计算参考了Cristinzio等人(2010)以及Mumenthaler和Sander (2012)的研究。具体而言, 一致性指数通过计算“正确”面部表情的评分得出, 以快乐面部表情的某一个试次为例, 仅计算被试在情绪量表的“快乐”维度的评分; 辨别指数通过计算“正确”面部表情的评分减去其他“不正确”面部表情评分的平均值得出, 以快乐面部表情的某一个试次为例, 首先计算被试在情绪量表的“快乐”维度的评分, 再计算其他五个维度(愤怒、惊讶、恐惧、悲伤、厌恶)评分的平均值, 快乐维度的评分减去其他五个维度评分的平均值, 即为该试次中被试的辨别指数。一致性指数和辨别指数能够更好地描述不同实验设置下, 被试判断目标面孔情绪的准确性, 即一致性指数和辨别指数越高, 个体对目标面部表情的识别越准确。

2.1.4 实验程序

实验包括以下6种条件:群体条件+快乐面孔、群体条件+恐惧面孔、非群体条件+快乐面孔、非群体条件+恐惧面孔、控制条件+快乐面孔、控制条件+恐惧面孔, 每种条件45个试次, 总共270个试次随机呈现, 每30个试次休息1次。

采用Psychopy软件呈现实验刺激并记录行为数据。具体刺激的呈现顺序为:首先呈现注视点“+” (1100~1300 ms随机, 视角为1.5°), 之后群体与非群体条件下呈现三个性别随机的人物, 面部表情均为中性(面孔视角为5.1° × 4.1°), 且按照一定实验要求运动(3000 ms), 具体如下:(1)群体条件下, 三个身体颜色一致的人物围绕中心进行有规律圆周运动; (2)非群体条件下, 三个身体颜色不一致的人物朝向屏幕边缘随机扩散。控制条件下, 只呈现注视点“+”。三个人物的初始位置分别位于一个以屏幕中心为重心、边长为4.9°的等边三角形的三个顶点上。运动结束后, 三个人物消失, 呈现注视点“+” (500 ms)。随后, 群体、非群体条件下, 先前呈现的三个人物表现出相同的面部表情(快乐或恐惧), 再次呈现在屏幕中央(500 ms), 面孔间相隔5.3°; 控制条件只呈现中间人物。最后, 被试需在含有6种情绪的量表上评定中间人物的情绪(6种情绪分别为愤怒、快乐、惊讶、恐惧、悲伤、厌恶; 量表的水平维度表示连续的强度范围, 最左边表示“没有”,最右边表示“很多”; 被试单击量尺某处后, 量尺上出现滑块, 被试拖动滑块确定相应情绪强度) (Cristinzio et al., 2010; Mumenthaler & Sander, 2012)。被试按空格键后结束对面部表情的评定, 进入下一试次(图1)。6种情绪量表的顺序在被试内固定, 被试间随机呈现。

图1 实验1流程图

2.1.5 群体有效性检验

实验1通过三个人物的运动轨迹(群体条件下, 三个人物围绕屏幕中心进行有规律的圆周运动; 非群体条件下, 三个人物朝向屏幕边缘随机扩散)以及身体颜色(群体条件下, 三个人物身体颜色均为红色或绿色或蓝色; 非群体条件下, 三个人物身体颜色为红、绿、蓝随机匹配)操纵群体信息。为检验群体操纵的有效性, 参考以往研究(Yin et al., 2022; 徐浩等, 2019), 招募50名(每组各25名)未参加正式实验的被试, 分别观看“群体线索呈现阶段” (女性12名, 平均年龄为23.08 ± 1.85岁)或“非群体线索呈现阶段”的视频(女性13名, 平均年龄为23.96 ± 1.46岁), 并通过7个项目评估视频中三个人物属于同一群体的程度, 即群体实体性(group entitativity; Campbell, 1958)。7个评定项目主要依据群体实体性的定义与特征确定(Campbell, 1958; Crawford et al., 2002), 具体如下:视频中的三个人物:(1)具有共同的目标; (2)具有共同的需求; (3)彼此间相互依赖; (4)彼此间相互影响; (5)按照一定的规则行动; (6)具有密切的联系; (7)相互接纳。被试需对每个项目进行1~7 点评分(1 = 完全不同意, 7 = 完全同意), 分数越高, 表明被试认为三个人物的群体实体性程度越强。

结果发现:被试对7个项目评分的内部一致性系数分别为:α群体线索= 0.80, α非群体线索= 0.85。对两种条件的群体实体性的评分均值进行独立样本检验, 结果发现:群体条件下的群体实体性的评分(= 5.07,= 0.77)显著高于非群体条件(= 2.63,= 1.04),(48) = 9.43,< 0.001, Cohen’s= 0.91。相比非群体条件, 群体条件中, 被试认为三个人物属于同一群体的程度更高, 表明群体线索操纵有效。

2.2 结果

数据的整理通过Python 3.8完成, 剔除超出各实验条件平均数上下2.5个标准差的数据。采用SPSS 26.0软件进行重复测量方差分析, 对不符合球形假设的值采用Greenhouse-Gessisser法校正, 多重比较时采用Bonferroni校正。

2.2.1 一致性指数结果

以一致性指数结果为因变量, 进行2 (面部表情:快乐、恐惧) × 3 (群体线索:群体、非群体、控制)的重复测量方差分析。结果发现(图2):面部表情主效应显著,(1, 28) = 71.98,< 0.001, ηp2= 0.72, 快乐表情(5.12 ± 0.35)的一致性指数得分显著高于恐惧表情(2.30 ± 0.35)。群体线索主效应显著,(2, 56) = 3.54,= 0.036, ηp2= 0.11, 事后多重比较发现, 群体条件下的一致性指数得分(3.85 ± 0.33)显著高于非群体条件(3.58 ± 0.30;= 0.011), 控制条件(3.69 ± 0.31)与群体条件(3.85 ± 0.33;= 0.58)、非群体条件(3.58 ± 0.30;= 0.82)的差异均不显著。面部表情和群体线索的交互作用不显著(> 0.05)。

图2 不同面部表情的一致性指数

注:误差线表示标准误

2.2.2 辨别指数结果

以辨别指数结果为因变量, 进行2 (面部表情:快乐、恐惧) × 3 (群体线索:群体、非群体、控制)的重复测量方差分析。结果发现:面部表情主效应显著,(1, 28) = 120.54,< 0.001, ηp2= 0.81, 快乐表情的辨别指数得分(4.89 ± 0.36)显著高于恐惧表情(0.81 ± 0.32)。面部表情与群体线索的交互作用显著,(2, 56) = 3.39,0.041, ηp2= 0.11, 进一步简单效应分析发现(图3), 当个体识别恐惧目标面孔时,控制条件下的辨别指数得分(0.80 ± 0.30)显著高于非群体条件(0.45 ± 0.30;= 0.031), 群体条件(0.75 ± 0.32)与非群体条件(0.45 ± 0.30)的辨别指数得分边缘显著(= 0.07), 但群体条件和控制条件之间不存在显著差异(= 1.00);当个体识别快乐目标面孔时, 群体(5.00 ± 0.39)、非群体(4.80 ± 0.36)、控制(4.65 ± 0.39)条件之间均不存在显著差异(s> 0.05)。

图3 不同面部表情的辨别指数

注:误差线表示标准误, *< 0.05

2.3 讨论

实验1通过多项选择任务, 发现群体信息会影响面部表情识别。具体而言, 在一致性指数指标上, 群体条件下个体识别目标面孔情绪的一致性指数显著高于非群体条件; 在辨别指数指标上, 群体条件下个体识别恐惧目标面孔的辨别指数高于非群体条件。可能的原因是:首先, 相比积极情绪, 个体对恐惧表情的识别更易受到情绪性情境信息的影响(李婉悦等, 2019)。其次, 由于实验1的面部表情识别阶段, 群体与非群体条件下均呈现三个情绪一致的人物, 以往研究表明, 周围面孔与目标面孔情绪一致时会促进面部表情识别(Mumenthaler & Sander, 2012)。先前通过知觉线索呈现的群体信息, 可能会影响个体对周围人物情绪状态的参考, 进而影响面部表情识别。

但由于实验1的面部表情识别阶段, 群体、非群体、控制条件的人物数量、身体颜色存在一定差异。因此, 实验2在面部表情识别阶段, 一方面, 进一步控制三种条件中物理属性的差异, 即三种条件的面部表情识别阶段均设置为三个身体颜色随机匹配的人物; 另一方面, 操纵周围面孔与目标面孔之间的情绪一致性, 以探讨群体信息与情绪一致性对面部表情识别的影响。

3 实验2:多项选择任务中, 群体信息与情绪一致性对面部表情识别的影响

3.1 方法

3.1.1 被试

使用G*power 3.1计算研究所需样本量(Faul et al., 2007), 设置参数为:被试内重复测量方差分析, 效应量= 0.25, 统计检验力1 − β = 0.9, ɑ = 0.05, 测量次数 = 12, 计算得到样本量为16人, 实际招募26名大学生被试(女性14名, 平均年龄为21.15 ± 1.99岁)参加实验。所有被试母语均为汉语, 视力或矫正视力正常, 无色弱色盲, 均为右利手, 无精神病史。实验前, 所有被试均阅读和签署了实验知情同意书, 完成实验后可获得一定的报酬。

3.1.2 实验刺激与设备

实验材料与设备同实验1。

3.1.3 实验设计

采用2 (面部表情:快乐、恐惧) × 3 (群体线索:群体、非群体、控制) × 2 (目标面孔与周围面孔的情绪一致性:一致、不一致)的被试内实验设计。因变量为一致性指数和辨别指数。

3.1.4 实验程序

实验包括以下12种条件:群体条件+快乐目标面孔+情绪一致、群体条件+快乐目标面孔+情绪不一致、群体条件+恐惧目标面孔+情绪一致、群体条件+恐惧目标面孔+情绪不一致、非群体条件+快乐面孔+情绪一致、非群体条件+快乐面孔+情绪不一致、非群体条件+恐惧面孔+情绪一致、非群体条件+恐惧面孔+情绪不一致、控制条件+快乐面孔+情绪一致、控制条件+快乐面孔+情绪不一致、控制条件+恐惧面孔+情绪一致、控制条件+恐惧面孔+情绪不一致, 每种条件30个试次, 总共360个试次随机呈现, 每60个试次休息1次。实验总时长约1小时。

采用Psychopy软件呈现实验刺激并记录行为数据。具体刺激的呈现顺序为:首先呈现注视点“+” (1100~1300 ms随机, 视角为1.5°), 之后群体与非群体条件下呈现三个面部表情为中性的人物图片(5.1° × 4.1°), 三个人物性别随机, 身体颜色均设置为红色、绿色、蓝色随机匹配。群体条件下, 三个人物围绕中心进行有规律圆周运动(3000 ms); 非群体条件下, 三个人物朝向屏幕边缘随机扩散(3000 ms); 控制条件下, 只呈现注视点“+” (3000 ms)。三个人物的初始位置分别位于一个以屏幕中心为重心、边长为4.9°的等边三角形的三个顶点上。运动结束后, 三个人物消失, 呈现注视点“+” (500 ms)。

随后, 在面部表情识别阶段, 与实验1的不同主要体现在:(1)群体、非群体、控制条件下, 均呈现三个人物图片(人物图片之间相隔5.3°, 500 ms), 且三个人物图片的身体颜色均随机匹配(群体、非群体条件的人物图片与群体信息呈现阶段一致), 从而减少物理线索带来的知觉整体性对实验的干扰; (2)操纵了周围人物与中间人物的情绪一致性, 具体表现为:情绪一致条件下, 三个人物图片的面部表情均为快乐或恐惧; 情绪不一致条件下, 中间人物情绪为快乐时, 周围人物情绪为恐惧; 中间人物情绪为恐惧时, 周围人物情绪为快乐。最后, 被试需在含有6种情绪的量表上评定中间人物的情绪(6种情绪分别为愤怒、快乐、惊讶、恐惧、悲伤、厌恶; 量表的水平维度表示连续的强度范围, 最左边表示“没有”, 最右边表示“很多”; 被试单击量尺某处后, 量尺上出现滑块, 被试拖动滑块确定相应情绪强度) (Cristinzio et al., 2010; Mumenthaler & Sander, 2012)。被试按空格键后结束对面部表情的评定, 进入下一试次(图4)。6种情绪量表的顺序在被试内固定, 被试间随机呈现。

图4 实验2流程图

3.1.5 群体有效性检验

实验2通过三个人物的运动轨迹(群体条件下, 三个人物围绕屏幕中心进行有规律的圆周运动; 非群体条件下, 三个人物朝向屏幕边缘随机扩散)操纵群体信息。招募50名(每组各25名)未参加正式实验的被试, 分别观看“群体线索呈现阶段” (女性11名, 平均年龄为24.12 ± 1.96岁)或“非群体线索呈现阶段”的视频(女性13名, 平均年龄为23.96 ± 1.46岁), 并通过7个项目评估视频中三个人物属于同一群体的程度(同实验1)。

结果发现:被试对7个项目评分的内部一致性系数分别为:α群体线索= 0.83, α非群体线索= 0.85, 对两种条件的群体实体性的评分均值进行独立样本检验, 结果发现:群体条件下的群体实体性的评分(= 4.94,= 1.03)显著高于非群体条件(= 2.63,= 1.04),(48) = 7.86,< 0.001, Cohen’s= 1.04。相比非群体条件, 群体条件中, 被试认为三个人物属于同一群体的程度更高, 表明实验操纵有效。

3.2 结果

数据的整理通过Python 3.8完成, 剔除超出各实验条件平均数上下2.5个标准差的数据。采用SPSS 27.0软件进行重复测量方差分析, 对不符合球形假设的值采用Greenhouse-Gessisser法校正, 多重比较时采用Bonferroni校正。

3.2.1 一致性指数结果

以一致性指数结果为因变量, 进行2 (面部表情:快乐、恐惧) × 3 (群体线索:群体、非群体、控制) × 2 (情绪一致性:一致、不一致)的重复测量方差分析。结果发现:面部表情主效应显著,(1, 25) = 23.57,< 0.001, ηp2= 0.48。群体线索主效应显著,(2, 50) =12.72,< 0.001, η2p= 0.34。情绪一致性主效应显著,(1, 25) = 21.81,< 0.001, ηp2= 0.47。

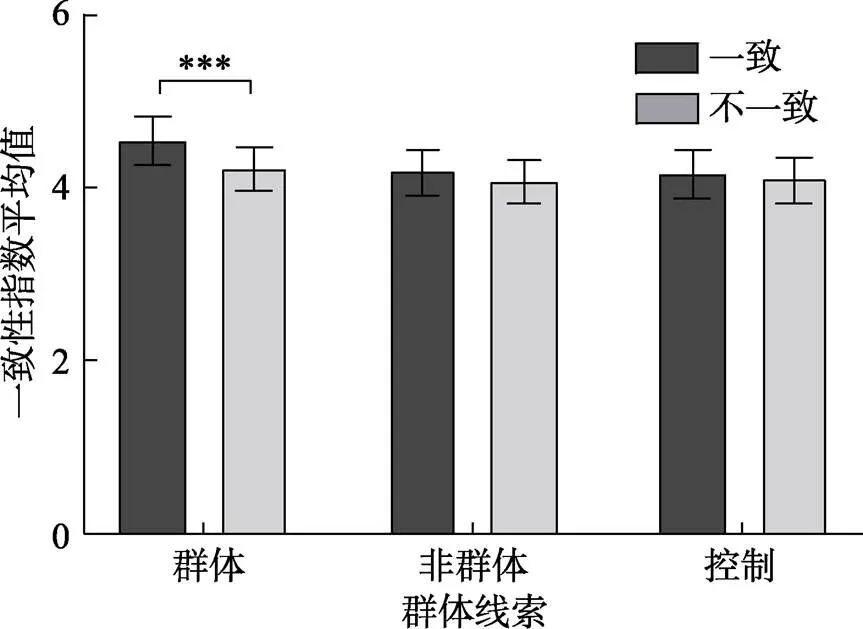

群体线索和情绪一致性的交互作用显著,(2, 50) = 4.23,= 0.020, ηp2= 0.15。进一步简单效应检验发现(图5), 群体条件下, 情绪一致条件的一致性指数得分(4.55 ± 0.28)显著高于情绪不一致条件(4.23 ± 0.25;< 0.001); 非群体条件下, 情绪一致(4.20 ± 0.27)与情绪不一致条件(4.09 ± 0.26)的一致性指数得分无显著差异(> 0.05); 控制条件下, 情绪一致(4.18 ± 0.28)与情绪不一致条件(4.11 ± 0.26)的一致性指数得分无显著差异(> 0.05)。此外, 当目标面孔与周围面孔情绪一致时, 群体条件下的一致性指数(4.55 ± 0.28)显著高于非群体条件(4.20 ± 0.27,= 0.001)和控制条件(4.18 ± 0.28,< 0.001), 非群体条件与控制条件之间不存在显著差异(> 0.05); 当目标面孔与周围面孔情绪不一致时, 群体条件(4.23 ± 0.25)、非群体条件(4.09 ± 0.26)、控制条件(4.11 ± 0.26)下的一致性指数均无显著差异(s > 0.05)。

图5 不同群体线索下, 面部表情识别的一致性指数

注:误差线表示标准误, ***< 0.001

群体线索和面部表情的交互作用显著,(2, 50) = 4.30,= 0.030, ηp2= 0.15。对于恐惧表情, 群体条件下的一致性指数得分(3.73 ± 0.27)显著高于非群体条件(3.27 ± 0.28;< 0.001)和控制条件(3.38 ± 0.26;< 0.001), 非群体条件与控制条件之间不存在显著差异(> 0.05)。对于快乐表情, 群体条件(5.05 ± 0.35)、非群体条件(5.02 ± 0.32)、控制条件(4.91 ± 0.37)下的一致性指数均无显著差异(s > 0.05)。无其他显著交互作用(s > 0.05)。

3.2.2 辨别指数结果

以辨别指数结果为因变量, 进行2 (面部表情:快乐、恐惧) × 3 (群体线索:群体、非群体、控制) × 2 (情绪一致性:一致、不一致)的重复测量方差分析。结果发现:面部表情主效应显著,(1, 25) = 66.48,< 0.001, ηp2= 0.73。群体线索主效应显著,(2, 50) = 13.15,< 0.001, ηp2= 0.35。情绪一致性主效应显著,(1, 25) = 22.30,< 0.001, ηp2= 0.47。

群体线索和情绪一致性的交互作用显著,(2, 50) = 3.79,= 0.029, ηp2= 0.13。进一步简单效应检验发现(图6),群体条件下, 情绪一致条件的辨别指数得分(3.77 ± 0.26)显著高于情绪不一致条件(3.39 ± 0.24;< 0.001); 非群体条件下, 情绪一致(3.32 ± 0.25)与情绪不一致条件(3.21 ± 0.24)的辨别指数得分无显著差异(> 0.05); 控制条件下, 情绪一致(3.34 ± 0.27)与情绪不一致条件(3.23 ± 0.26)的辨别指数得分无显著差异(> 0.05)。此外, 当目标面孔与周围面孔情绪一致时, 群体条件下的辨别指数(3.77 ± 0.26)显著高于非群体条件(3.32 ± 0.25,= 0.001)和控制条件(3.34 ± 0.27,= 0.001), 非群体条件与控制条件之间不存在显著差异(> 0.05); 当目标面孔与周围面孔情绪不一致时, 群体条件(3.39 ± 0.24)、非群体条件(3.21 ± 0.24)、控制条件(3.23 ± 0.26)下的辨别指数均无显著差异(s > 0.05)。

图6 不同群体线索下, 面部表情识别的辨别指数

注:误差线表示标准误, ***< 0.001

群体线索和面部表情的交互作用显著,(2, 50) = 5.75,= 0.011, ηp2= 0.19。对于恐惧表情, 群体条件下的辨别指数得分(2.35 ± 0.24)显著高于非群体条件(1.78 ± 0.25;< 0.001)和控制条件(1.93 ± 0.24;< 0.001), 非群体条件与控制条件之间不存在显著差异(> 0.05)。对于快乐表情, 群体条件(4.80 ± 0.35)、非群体条件(4.75 ± 0.34)、控制条件(4.63 ± 0.38)下的辨别指数均无显著差异(s> 0.05)。无其他显著交互作用(s > 0.05)。

3.3 讨论

实验2在进一步控制不同条件物理属性差异的基础上, 在面部表情识别阶段操纵了周围面孔与目标面孔的情绪一致性, 通过多项选择任务探讨群体信息与情绪一致性对面部表情识别的影响。实验2同样发现, 相比快乐表情, 恐惧表情识别更易受群体信息的影响, 即群体条件下, 个体识别恐惧表情的一致性指数和辨别指数均显著高于非群体条件和控制条件。重要的是, 实验2进一步发现, 周围面孔与目标面孔之间的情绪一致性会影响个体对目标面孔情绪的识别, 产生情绪识别的情境效应, 即一致时的面部表情识别准确性显著高于不一致时。而群体信息则对这种效应产生了调节作用, 具体表现为:在群体条件下, 当周围面孔与目标面孔情绪一致时, 被试识别目标面孔情绪的准确性显著高于情绪不一致时; 在非群体条件下, 则不存在显著差异。

此外, 在面部表情加工中, 不同实验任务诱发的认知过程存在一定的差异, 相比自由标记任务, 迫选任务下被试有更高的准确率和更快的反应速度(Betz et al., 2019)。因此, 实验3采用二择一的迫选任务, 探讨群体信息与情绪一致性对面部表情识别的影响。

4 实验3:迫选任务中, 群体信息与情绪一致性对面部表情识别的影响

4.1 方法

4.1.1 被试

使用G*power 3.1计算研究所需样本量(Faul et al., 2007), 设置参数为:被试内重复测量方差分析, 效应量= 0.25, 统计检验力1 − β = 0.9, ɑ = 0.05, 测量次数 = 12, 计算得到样本量为16人, 实际招募32名大学生被试(女性15名, 平均年龄为21.2 ± 1.6岁)参加实验。所有被试母语均为汉语, 视力或矫正视力正常, 无色弱色盲, 均为右利手, 无精神病史。实验前, 所有被试均阅读和签署了实验知情同意书, 完成实验后可获得一定的报酬。

4.1.2 实验刺激与设备

实验材料与设备同实验1。

4.1.3 实验设计

采用2 (面部表情:快乐、恐惧) × 3 (群体线索:群体、非群体、控制) × 2 (目标面孔与周围面孔的情绪一致性:一致、不一致)的被试内实验设计。因变量为反应时和正确率。

4.1.4 实验程序

实验条件共12种, 与实验2一致, 每种条件45个试次, 总共540个试次随机呈现, 每60个试次休息1次。实验总时长约0.8小时。

实验过程中, 与实验2不同的是, 在面部表情识别阶段, 被试需在人物图片呈现后, 对中间人物的面部表情做出按键反应, 快乐按“Q”键, 恐惧按“P”键, 按键方式在被试之间进行平衡。人物图片在按键后消失, 若被试在1500 ms内未进行按键反应, 记为错误反应, 人物图片消失。随机间隔1200~1500 ms之后进入下一试次(图7, 其余流程均与实验2保持一致)。

4.1.5 群体有效性检验

同实验2。

4.2 结果

数据的整理通过Python 3.8完成, 剔除超出各实验条件平均数上下2.5个标准差的数据。采用SPSS 26.0软件进行重复测量方差分析, 对不符合球形假设的值采用Greenhouse-Gessisser法校正, 多重比较时采用Bonferroni校正。

4.2.1 反应时结果

以反应时结果为因变量, 进行2 (情绪一致性:一致、不一致) × 3 (群体线索:群体、非群体、控制) × 2 (面部表情:快乐、恐惧)的重复测量方差分析。结果发现:面部表情主效应显著,(1, 31) = 19.63,< 0.001, ηp2= 0.39, 快乐表情(= 704.95 ms,= 12.55)的反应时显著短于恐惧表情(= 727.42 ms,= 12.57)。群体线索主效应显著,(2, 62) = 140.24,< 0.001, ηp2= 0.82, 情绪一致性主效应显著,(1, 31) = 25.74,< 0.001, ηp2= 0.45。

重要的是, 群体线索与情绪一致性的交互作用显著,(2, 62) = 8.07,< 0.001, ηp2= 0.21, 进一步简单效应检验发现(图8), 在控制条件和群体条件下, 情绪一致条件的反应时(控制:= 758.78 ms,= 11.71; 群体:= 678.55 ms,= 12.64)显著短于情绪不一致条件(控制:= 782.12 ms,= 13.35,0.001; 群体:= 688.15 ms,= 13.38,0.008)。而在非群体条件下, 情绪一致(= 693.92 ms,= 13.01)与不一致条件(= 695.59 ms,= 13.10)的反应时无显著差异(0.70)。此外, 当目标面孔与周围面孔情绪一致时, 群体条件下的反应时(= 678.55 ms,= 12.64)显著短于非群体条件(= 693.92 ms,= 13.01,= 0.004)和控制条件(= 758.78 ms,= 11.71,< 0.001), 非群体条件下的反应时(= 693.92 ms,= 13.01)显著短于控制条件(= 758.78 ms,= 11.71,< 0.001); 当目标面孔与周围面孔情绪不一致时, 群体条件下的反应时(= 688.15 ms,= 13.38)显著短于控制条件(= 782.12 ms,= 13.35,< 0.001), 非群体条件下的反应时(= 695.59 ms,= 13.10)显著短于控制条件(= 782.12 ms,= 13.35,< 0.001), 群体条件与非群体条件下的反应时无显著差异(= 0.27)。无其他显著交互作用(s> 0.05)。

图7 实验3流程图

图8 不同群体线索下, 面部表情识别的反应时

注:误差线表示标准误, **< 0.01, ***< 0.001

4.2.2 正确率结果

以正确率为因变量, 进行2 (一致性:一致, 不一致) × 3 (群体条件:群体, 非群体, 控制) × 2 (面部表情:快乐表情, 恐惧表情)的重复测量方差分析。群体条件主效应边缘显著,(2, 62) = 3.20,= 0.049, ηp2= 0.18。但进一步分析发现不存在任何显著效应(s> 0.05)。无其他显著主效应或交互作用(s > 0.05)。

4.3 讨论

实验3采用二择一的迫选任务, 进一步探讨群体信息与情绪一致性对面部表情识别的影响。与实验2类似, 实验3同样发现, 群体信息对情绪一致性效应产生了调节作用, 具体表现为:在群体条件下, 当周围面孔与目标面孔情绪一致时, 被试对目标面孔情绪的知觉速度快于情绪不一致时; 在非群体条件下, 上述效应消失。

5 总讨论

本研究考察了群体信息对面部表情识别的影响及具体表现。研究发现, 周围面孔的情绪状态能够影响目标面孔情绪的识别, 产生情绪一致性效应, 即周围面孔与目标面孔情绪一致时的反应速度快于情绪不一致时, 且面部表情识别的准确性更高。重要的是, 群体信息能够调节周围面孔的情绪状态对目标面孔的影响, 进而影响面部表情识别, 具体表现为:(1)群体条件下, 周围面孔的情绪状态会成为个体识别目标面孔情绪的参考。相比周围面孔情绪与目标面孔情绪不一致, 两者情绪一致时, 即符合个体基于知觉线索建立的群体成员情绪具有一致性的预期, 面部表情识别速度更快、准确性更高; (2)非群体条件下, 周围面孔的情绪状态不会影响个体对目标面孔情绪的判断。此外, 本研究还发现了面部表情识别的积极情绪优势效应, 具体表现为:相比恐惧表情, 个体对快乐情绪的识别速度更快, 准确性更高。

本研究发现, 控制条件不存在任何群体运动线索, 周围面孔的情绪状态依然会影响个体对目标面孔情绪的识别, 具体表现为:相比周围面孔的情绪状态与目标面孔情绪不一致时, 当两者情绪一致时, 被试识别目标面孔情绪的反应时更短、准确性更高。这一结果体现了面部表情识别的情境效应(Gray et al., 2017; Lindquist & Gendron, 2013; Mumenthaler & Sander, 2012; Wieser & Brosch, 2012; 徐强等, 2014), 表明个体对面孔情绪的知觉并不仅仅由面孔构型特征驱动, 也会受到其所处情境的影响。

重要的是, 本研究发现, 群体信息会影响面部表情识别, 且这一影响是通过调节周围面孔情绪对目标面孔的影响实现的。当个体知觉到目标面孔与周围面孔属于同一群体时, 周围面孔的情绪状态会成为个体识别目标面孔情绪的参考, 即相比周围面孔与目标面孔情绪不一致, 当两者情绪一致时, 个体识别目标面孔情绪的速度更快、准确性更高; 而当个体知觉到两者不属于同一群体时, 则不存在上述效应。这一结果得到以往相关研究的支持, Mumenthaler和Sander (2012)发现, 当周围面孔的注视方向指向目标面孔时, 即社会评价条件下, 周围面孔的情绪状态影响了被试对目标面孔的情绪识别。在该实验中, 周围面孔对目标面孔的注视提供了互动信息, 即周围面孔的情绪状态表达了其对目标面孔的社会评价。与该研究相似, Gray等人(2017)的研究也发现, 互动关系影响观察者对目标面孔的情绪识别。个体在互动关系中情绪的表达, 反映了其对互动对象的认知、态度等(Pietroni et al., 2008; van Kleef, 2009)。因此, 当周围人物与目标人物存在社会互动时, 观察者会将周围人物的情绪状态作为推断目标面孔情绪的重要参考(Gray et al., 2017; Mumenthaler & Sander, 2012; Mumenthaler et al., 2018), 而群体成员之间又存在彼此互动和依赖。因此, 本研究中, 当观察者通过群体线索知觉到目标人物和周围人物属于同一群体后, 会依据周围面孔的情绪状态对目标面孔的情绪进行判断; 而当观察者知觉到目标面孔与周围面孔不属于同一群体时, 则不会根据周围面孔的情绪状态对目标面孔情绪进行推断。

此外, 上述结果也表明, 群体条件下, 个体基于知觉线索形成的群体信息, 会建立群体成员情绪具有一致性的预期。当周围面孔与目标面孔情绪一致, 即符合个体预期时, 面部表情识别速度更快、准确性更高。Cao等人(2023)发现, 基于场景的预期能够影响个体对面部表情的早期知觉加工, 当先前呈现的场景与面孔情绪一致时, 面孔诱发的N170波幅显著大于不一致条件。这一结果表明:自下而上的面孔情绪与基于场景产生的自上而下的期望相一致时, 个体会对面孔投入更多的认知资源, 即期望强化效应(expectation sharpening effect, Kok et al., 2012; Lee & Mumford, 2003)。而当面孔情绪与先前预期不一致时, 个体则会对其产生相对抑制。此外, 研究表明, 当个体通过知觉线索意识到群体存在时, 会建立群体成员行为具有一致性的预期(徐浩等, 2019)。本研究的实验2、实验3中, 通过虚拟人物的运动轨迹操纵群体信息, 具体而言:群体条件下, 三个虚拟人物围绕中心进行有规律圆周运动; 非群体条件下, 三个虚拟人物朝向屏幕边缘随机扩散。不同实验条件下运动方式的不同构建了不同的群体线索, 使得个体对之后即将出现的目标面部表情产生不同的预期。那么, 在面部表情识别中, 当观察者通过知觉线索意识到三个虚拟人物属于同一群体后, 会建立其情绪具有一致性的预期, 当三个虚拟人物的面部表情一致时, 即与个体的预期相符, 面部表情识别的准确性显著高于不一致时, 且速度更快。

本研究还发现, 相比恐惧表情, 个体识别快乐表情的速度更快、准确性更高, 这可能是与恐惧表情相比, 快乐表情具有晚期知觉加工优势所致(Becker et al., 2011; Calvo & Nummenmaa, 2008; Švegar & Kardum, 2013; 许茜如等, 2019)。研究发现, 面部表情加工和解码需要个体对效价和特定情绪信息进行双重加工(Aguado et al., 2013; Aguado et al., 2019; Dieguez-Risco et al., 2015), 对于效价信息的加工往往发生在较早的加工阶段(Moors & de Houwer, 2001)。实验1和实验2中, 被试需在含有6种情绪的量表上评定中间人物的情绪(6种情绪分别为愤怒、快乐、惊讶、恐惧、悲伤、厌恶)。对于快乐情绪而言, 效价信息的加工就足以判断面部表情的情绪; 对于恐惧情绪而言, 被试不仅需要对效价信息进行加工(是积极还是消极), 还需要进一步对其情绪类别信息进行加工(是愤怒、恐惧还是厌恶等), 因此, 被试对快乐面孔表现出知觉加工优势。实验3中, 被试仅需对面孔的情绪效价进行判断。相比快乐表情, 恐惧表情本身就具有一定的模糊性(Mumenthaler & Sander, 2012), 当面孔构型信息难以准确传达其情绪状态时, 个体更倾向于依据情境信息判断面孔情绪(Leleu et al., 2015; 李婉悦等, 2020)。这一现象在实验1和实验2中也有所体现, 即相比快乐表情, 恐惧表情识别更易受情境信息的影响。因此, 在实验3中, 被试在判断恐惧表情时, 周围人物的情绪状态更具参考意义。对于快乐目标面孔而言, 个体通过快乐目标面孔本身就足以判断其情绪效价。而对于恐惧目标面孔而言, 其面孔自身信息的模糊性与不确定性, 促使个体更倾向于参考周围人物的情绪状态, 以确认自身的情绪判断的准确性。因此, 个体判断恐惧表情时, 表现出较长的反应时。

尽管如此, 本研究也存在一定的局限。首先, 本研究发现群体条件下, 个体对目标面部表情的识别受到周围面孔情绪状态的影响。但由于在实验2和实验3的操纵中, 并未设置单独呈现目标面孔的基线条件, 因此无法明晰是周围面孔与目标面孔情绪一致时的促进作用, 还是情绪不一致时的阻碍作用。未来研究应增设基线条件, 进一步探讨群体存在时, 其他成员的情绪状态对目标面部表情识别的具体影响。第二, 本研究中, 群体信息的呈现以及人物的外形与真实情况还存在一定的差异, 影响了本研究的生态效度。未来研究应采用更为生态的方式呈现群体信息。第三, 本研究通过知觉线索操纵群体信息, 但知觉线索本身的低级物理属性带来的影响难以完全排除。未来可以在现有实验的基础上, 增设物理属性相同的对照实验, 并干扰被试形成群体或非群体信息, 以进一步检验群体信息对面部表情识别的影响。

6 结论

本研究得到以下结论:(1)群体信息作为社会互动的重要情境, 会对面部表情识别产生重要影响, 即群体存在时, 周围面孔的情绪状态会成为个体识别目标面孔情绪的参考; 而非群体条件下, 周围面孔的情绪状态不会影响个体对目标面孔情绪的识别。(2)个体知觉到群体存在时, 会建立群体成员情绪具有一致性的预期, 当群体情绪与预期相一致时, 会促进其对目标面孔的情绪识别。(3)不同类别的面部表情加工存在差异, 相比恐惧面孔, 个体对快乐面孔的识别速度更快、准确性更高, 即出现快乐面孔的识别优势效应。

Adolphs, R. (2002). Neural systems for recognizing emotion.,(2), 169−177. https:// doi.org/10.1016/S0959-4388(02)00301-X

Aguado, L., Dieguez-Risco, T., Méndez-Bértolo, C., Pozo, M. A., & Hinojosa, J. A. (2013). Priming effects on the N400 in the affective priming paradigm with facial expressions of emotion.,(2), 284−296. https://doi.org/10.3758/s13415-012-0137-3

Aguado, L., Dieguez-Risco, T., Villalba-García, C., & Hinojosa,J. A. (2019). Double-checking emotions: Valence and emotion category in contextual integration of facial expressions of emotion.,, 107723. https://doi. org/10.1016/j.biopsycho.2019.107723

Aviezer, H., Hassin, R. R., Bentin, S., & Trope, Y. (2008). Putting facial expressions back in context. In N. Ambady & J. Skowronski (Eds.),(pp. 255−288). New York, NY: Guilford Press.

Becker, D. V., Anderson, U. S., Mortensen, C. R., Neufeld, S. L., & Neel, R. (2011). The face in the crowd effect unconfounded: Happy faces, not angry faces, are more efficiently detected in single-and multiple-target visual searchtasks.,(4), 637−659. https://doi.org/10.1037/a0024060

Betz, N., Hoemann, K., & Barrett, L. F. (2019). Words are a context for mental inference.,(8), 1463−1477. https://doi.org/10.1037/emo0000510

Calvo, M. G., & Nummenmaa, L. (2008). Detection of emotionalfaces: Salient physical features guide effective visual search.,(3), 471− 494. https://doi.org/10.1037/a0012771

Campbell, D. T. (1958). Common fate, similarity, and other indices of the status of aggregates of persons as social entities.,(1), 14−25.

Cao, F., Zeng, K., Zheng, J., Yu, L., Liu, S., Zhang, L., & Xu, Q. (2023). Neural response and representation: Facial expressions in scenes.,(3), e14184. https://doi.org/10.1111/psyp.14184

Carragher, D. J., Thomas, N. A., & Nicholls, M. E. R. (2021). The dissociable influence of social context on judgements of facial attractiveness and trustworthiness.,(4), 902−933. https://doi.org/10.1111/ bjop.12501

Crawford, M. T., Sherman, S. J., & Hamilton, D. L. (2002). Perceived entitativity, stereotype formation, and the interchangeability of group members.,(5), 1076−1094. https://doi.org/ 10.1037//0022-3514.83.5.1076

Cristinzio, C., N’Diaye, K., Seeck, M., Vuilleumier, P., & Sander, D. (2010). Integration of gaze direction and facial expression in patients with unilateral amygdala damage.,(1), 248−261. https://doi.org/10.1093/brain/ awp255

Dang, J., Liu, L., Ren, D., & Su, Q. (2018). Polarization and positivity effects: Divergent roles of group entitativity in warmth and competence judgments.,, 74−84. https://doi.org/10.1016/j.jesp. 2017.09.003

Dieguez-Risco, T., Aguado, L., Albert, J., & Hinojosa, J. A. (2015). Judging emotional congruency: Explicit attention to situational context modulates processing of facial expressions of emotion.,, 27−38. https://doi. org/10.1016/j.biopsycho.2015.09.012

Ekman, P. (1993). Facial expression and emotion.,(4), 384−392. https://doi.org/10.1037/0003- 066X.48.4.384.

Faul, F., Erdfelder, E., Lang, A.-G., & Buchner, A. (2007). G* Power 3: A flexible statistical power analysis program for the social, behavioral, and biomedical sciences.(2), 175−191. https://doi.org/10.3758/ bf03193146

Gray, K. L. H., Barber, L., Murphy, J., & Cook, R. (2017). Social interaction contexts bias the perceived expressions of interactants.,(4), 567−571. https://doi.org/10. 1037/emo0000257

Griffiths, S., Rhodes, G., Jeffery, L., Palermo, R., & Neumann, M. F. (2018). The average facial expression of a crowd influences impressions of individual expressions.,(2), 311−319. https://doi.org/10.1037/ xhp0000446

Keltner, D., & Haidt, J. (1999). Social functions of emotions at four levels of analysis.,(5), 505− 521. https://doi.org/10.1080/026999399379168

Kok, P., Jehee, J. F., & de Lange, F. P. (2012). Less is more: Expectation sharpens representations in the primary visual cortex.,(2), 265−270. https://doi.org/10.1016/j. neuron.2012.04.034

Lee, T. S., & Mumford, D. (2003). Hierarchical Bayesian inference in the visual cortex.,(7), 1434−1448. https://doi.org/10. 1364/JOSAA.20.001434

Leleu, A., Demily, C., Franck, N., Durand, K., Schaal, B., & Baudouin, J.-Y. (2015). The odor context facilitates the perception of low-intensity facial expressions of emotion.,(9), e0138656. https://doi.org/10.1371/journal. pone.0138656

Li, W., Han, S., Liu, S., Yang, Y., Zhang, L., & Xu, Q. (2020). Scene effects on facial expression detection: The moderating effects of trait anxiety.(8), 869−878. https://doi.org/10.3724/SP.J.1041.2019.00869

[李婉悦, 韩尚锋, 刘燊, 杨亚平, 张林, 徐强. (2019). 场景对面孔情绪探测的影响:特质性焦虑的调节作用.(8), 869−878. https://doi.org/10.3724/SP.J.1041.2019. 00869]

Li, W., Tan, Q., Liu, S., Han, S., Zhang, L., & Xu, Q. (2020). The influence of language context on facial expression processing.,(2), 140−150.

[李婉悦, 谭群, 刘燊, 韩尚锋, 张林, 徐强. (2020). 语境信息对面部表情加工的影响.,(2), 140−150.]

Lindquist, K. A., & Gendron, M. (2013). What’s in a word? Language constructs emotion perception.,(1), 66−71. https://doi.org/10.1177/1754073912451351

Moors, A., & de Houwer, J. (2001). Automatic appraisal of motivational valence: Motivational affective priming and Simon effects.,(6), 749−766. https:// doi.org/10.1080/02699930143000293

Morewedge, C. K., Chandler, J. J., Smith, R., Schwarz, N., & Schooler, J. (2013). Lost in the crowd: Entitative group membership reduces mind attribution.,(4), 1195−1205. https://doi.org/10.1016/j.concog.2013.08.002

Mumenthaler, C., & Sander, D. (2012). Social appraisal influences recognition of emotions.,(6), 1118−1135. https://doi.org/ 10.1037/a0026885

Mumenthaler, C., Sander, D., & Manstead, A. S. (2018). Emotion recognition in simulated social interactions.,(2), 308−312. https://doi.org/10.1109/TAFFC.2018.2799593

Pietroni, D., van Kleef, G. A., de Dreu, C. K. W., & Pagliaro, S.(2008). Emotions as strategic information: Effects of other’s emotional expressions on fixed-pie perception, demands, and integrative behavior in negotiation.,(6), 1444−1454. https://doi.org/10. 1016/j.jesp.2008.06.007

Powell, L. J., & Spelke, E. S. (2013). Preverbal infants expect members of social groups to act alike.,(41), E3965-E3972. https://doi.org/10.1073/pnas.1304326110

Susskind, J. M., Littlewort, G., Bartlett, M. S., Movellan, J., & Anderson, A. K. (2007). Human and computer recognition of facial expressions of emotion.,(1), 152−162. https://doi.org/10.1016/j.neuropsychologia.2006. 05.001

Švegar, D., Kardum, I., & Polič, M. (2013). Happy face superiority effect in change detection paradigm.,(2), 249−269.

Sweeny, T. D., Haroz, S., & Whitney, D. (2013). Perceiving group behavior: Sensitive ensemble coding mechanisms for biological motion of human crowds.,(2), 329. https://doi.org/10.1037/a0028712

Todd, A. R., Galinsky, A. D., & Bodenhausen, G. V. (2012). Perspective taking undermines stereotype maintenance processes: Evidence from social memory, behavior explanation, and information solicitation.,(1), 94−108.

Tottenham, N., Tanaka, J., Leon, A., McCarry, T., Nurse, M., Hare, T., Marcus, D., Westerlund, A., Casey, B., & Nelson, C. (2009). The NimStim set of facial expressions: Judgments from untrained research participants.,(3), 242−249. https://doi.org/10.1016/j.psychres.2008.05. 006

van Kleef, G. A. (2009). How emotions regulate social life: The emotions as social information (EASI) model.,(3), 184−188. https:// doi.org/10.1111/j.1467-8721.2009.01633.x

Vukšić-Mihaljević, Ž., & Mandić, N. (2001). Psychodynamics and regression of social groups.,(1), 213−226.

Walker, D., & Vul, E. (2013). The cheerleader effect: Hierarchical encoding of individuals in groups.,(9), 853−853. https://doi.org/10.1167/13.9.853

Wieser, M. J., & Brosch, T. (2012). Faces in context: A review and systematization of contextual influences on affective face processing.,. https://doi. org/10.3389/fpsyg.2012.00471

Xu, H., Duan, J. P., Chen, M., & Yin, J. (2019). The mechanisms of action prediction based on social group information.(3), 239−252. https://doi.org/CNKI:SUN:YXNX.0.2019-03-005

[徐浩, 段继鹏, 陈满, 尹军. (2019). 基于群体信息的行为预测机制.(3), 239−252. https://doi.org/ CNKI:SUN:YXNX.0.2019-03-005]

Xu, Q., Yang, Y. P., Zhang, E. T., & Zhang, F. (2014). The influence of context on facial expression processing: Retrospect and prospect.(3), 252−262. https://doi.org/10.3969/j.issn.1006-6020.2014.03. 008

[徐强, 杨亚平, 张恩涛, 张锋. (2014). 背景因素影响面部表情加工的研究: 现状与展望.(3), 252− 262. https://doi.org/10.3969/j.issn.1006-6020.2014.03.008]

Xu, Q. R., He, W. Q., Ye, C. X., & Luo, W. B. (2019). Attentional bias processing mechanism of emotional faces: Anger and happiness superiority effects.(1), 90−98. https://doi.org/10.13294/j.aps.2018.0098

[许茜如, 何蔚祺, 叶超雄, 罗文波. (2019). 情绪面孔注意偏向的加工机制: 愤怒和快乐优势效应.(1), 90−98. https://doi.org/10.13294/j.aps.2018.0098]

Yin, J., Duan, J., Huangliang, J., Hu, Y., & Zhang, F. (2022). Members of highly entitative groups are implicitly expected to behave consistently based on their deep-level goals instead of their shallow-level movements.,(1), 13− 28. https://doi.org/10.1037/xlm0001009

Ying, H., Burns, E., Lin, X., & Xu, H. (2019). Ensemble statistics shape face adaptation and the cheerleader effect.,(3), 421− 436. https://doi.org/10.1037/xge0000564

Yzerbyt, V., & Demoulin, S. (2010). Intergroup relations. In S. T. Fiske, D. T. Gilbert, & G. Lindzey (Eds.),(5th ed., pp. 1024−1083). Hoboken, NJ: Wiley.

Influence of group information on facial expression recognition

WANG Weihan1, CAO Feizhen1,2, YU Linwei1, ZENG Ke3, YANG Xinchao1, XU Qiang1

(1Department and Institute of Psychology, Ningbo University, Ningbo 315211, China)(2School of Psychology, South China Normal University, Guangzhou 510631, China)(3Department of Psychology, Sun Yat-sen University, Guangzhou 510006, China)

Emotions surface during interaction between individuals. Thus, an accurate recognition of facial expressions is essential in the realm of social interactions. In recent years, numerous studies have revealed that individuals not only depend on facial configuration information for identifying facial expressions but also place considerable emphasis on contextual information extracted from external cues beyond the face. People’s behavior frequently unfolds within intricate social group dynamics, wherein individuals often perceive and interpret the facial expressions of their fellow group members during interaction. However, the impact of group information on facial expression recognition, being an essential social contextual factor, remains somewhat unclear. Hence, three experiments were conducted to investigate the influence exerted by group information on the recognition of facial expressions.

The stimuli used in the study were happy, fearful, and neutral face images selected from the NimStim set, including 15 pictures (seven females) of each of the aforementioned emotions. Group information was manipulated following the presentation of a fixation cross through perceptual cues. Subsequently, during the facial expression recognition phase, participants were instructed to recognize the facial expressions exhibited by target individuals. In the first experiment, participants were instructed to rate the intensity of target facial expressions on a six- emotion scale, and the surrounding facial expressions were always congruent with the target facial expressions. A total of 29 college students (16 females, mean age 20.00 ± 1.80 years) were recruited to participate in this experiment. In Experiments 2 and 3, we manipulated the emotional congruency between the surrounding faces and the target faces during the facial expression recognition phase. Additionally, we controlled for variations in physical characteristics across different experimental conditions. The task requirement of Experiment 2 was the same as that of Experiment 1. However, in Experiment 3, participants were instructed to judge the target facial expressions by pressing corresponding keys on the keyboard as quickly and accurately as possible. A total of 26 college students (14 females, mean age 21.15 ± 1.99 years) participated in Experiment 2, and 32 college students (15 females, mean age 21.20 ± 1.60 years) participated in Experiment 3.

Results revealed the following: (1) Compared with emotion-incongruent conditions, emotional congruency between target faces and surrounding faces resulted in shorter RTs and higher accuracy. (2) Group information regulated the influence of surrounding facial expressions on target facial expression recognition. Specifically, under group conditions, participants tended to recognize target facial expressions according to the emotional state of the surrounding faces. When the target facial expressions in line with the expectations established by the participants that group members have congruent emotional state, the recognition of target facial expressions was faster and more accurate than incongruent conditions. However, under nongroup conditions, participants recognized target facial expressions without reference to the emotional states of the surrounding faces. (3) Participants exhibited a faster and more accurate recognition of happy faces, indicating the recognition advantage effect for happy facial expressions.

Results revealed that group information influenced facial expression recognition, individuals recognized facial expressions based on the social relationship between the interactions, and understanding social interaction plays an important role in the process of emotion perception.

emotion congruency effect, emotion recognition, expectation, facial expression, group information

2023-05-25

* 国家教育部人文社会科学研究项目/青年基金项目(18YJC190027)。

王伟晗和曹斐臻同为第一作者。

徐强, E-mail: xuqiang1117@163.com

B842