决策树算法在学生成绩分析中的应用研究

韩丽娜,韩改宁

(咸阳师范学院 图形图像处理研究所,陕西 咸阳 712000)

决策树算法在学生成绩分析中的应用研究

韩丽娜,韩改宁

(咸阳师范学院 图形图像处理研究所,陕西 咸阳 712000)

基于挖掘分析影响学生学习效果主因素为目的,采用了能够对数据进行挖掘分析并直观展示结果的决策树技术方法,通过某班学生某门课程的学习信息数据进行挖掘分析的试验,采用ID3和C4.5算法生成决策树,并使用后剪枝技术精简决策树,最终找出决定本门课程学习效果的主要因素-考勤。从而为分析学生学习情况,给予个性化提示与指导提供有效的建议。

决策树;信息熵;信息增益;信息增益率

决策树算法最早源于人工智能的机器学习技术,用以实现数据内在规律的探究和新数据对象的分类预测[1-2]。由于其出色的数据分析能力和直观易懂的结果展示等特点,决策树成为一种重要的数据挖掘技术。随着信息化技术的不断发展,高校遇到的新问题越来越多,虽然积累了大量的学生信息,但学生的管理工作越来越复杂[2]。决策树技术对学生的学习信息进行挖掘分析,找到影响学习效果的因素以及这些因素反映的相关问题,那么就能及时反馈教学效果,预测学生的发展趋势,进而对学生的行为进行个性化指导,这样不仅有利于教师改进教学方式,而且对学生的管理工作也提供了有用信息。所以研究决策树技术在高校中的应用具有重要的现实意义。

1 决策树算法及基本概念

1.1 ID3算法

决策树算法的目的是通过向数据学习,获得输入变量和输出变量不同取值下的数据分类和预测规律,并用于对新数据对象的分类预测[3-4]。届时,决策树能够依据新数据输入变量的取值,推断其输出变量的分类取值。它是一种有指导的学习,要求数据既包含输入变量也包含输出变量。

决策树最有名的算法是Quinlan在1986年提出的ID3算法[5],该算法通过计算每个属性的信息增益,选取具有最高增益的属性作为给定数据集合的测试属性并创建根节点,以该属性为标记,对该属性的每个取值创建一个分支,并据此划分样本[6-8]。以此类推不断向下,直到选择某个叶子节点,从而构造决策树。

1.2 信息熵及信息增益

信息熵:ID3算法认为,对于样例集合S而言,拥有P个正例和N个反例(若为多个分类结果,可照此类推),它的信息熵是信息量的数学期望,公式为:

样例集 S中具有某属性 A且有 v个取值(A {V1,V2,…Vv}),并将S分为对应的v个子集S1,S2,…Sv,而且对于任意一个Si子集均含有Pi个正例和Ni个反例,规定Si的信息熵为:

条件熵:以属性A为根进行分类的信息熵(也叫条件熵)为:

信息增益:属性A的信息增益[8-10]定义为:

1.3 C4.5算法

由于ID3算法是以信息增益值的大小作为标准,它存在一定问题:类别值多的输入变量比类别值少的输入变量肯定有更多的机会成为当前最佳分组变量。为了解决这个问题,完善形成了C4.5算法。它的核心概念还是信息熵,主要以信息增益率为标准确定最佳分组变量。

信息增益率:属性A的信息增益率定义为:

可见,如果输入变量A有较多的分类值,则它的信息熵会很大,而信息增益率会因此降低,进而消除了类别数目所带来的影响。

2 决策树技术的应用

本次数据信息以某学院某专业38名同学《程序设计基础》期末上机考试成绩为基础,结合学生的平时成绩(考勤,回答问题,作业完成)以及学生的调查数据信息(课程的兴趣,每周上机时长,试卷难易程度,学生自评)等对学生信息进行数据挖掘分析,生成决策树。

2.1 数据收集、处理

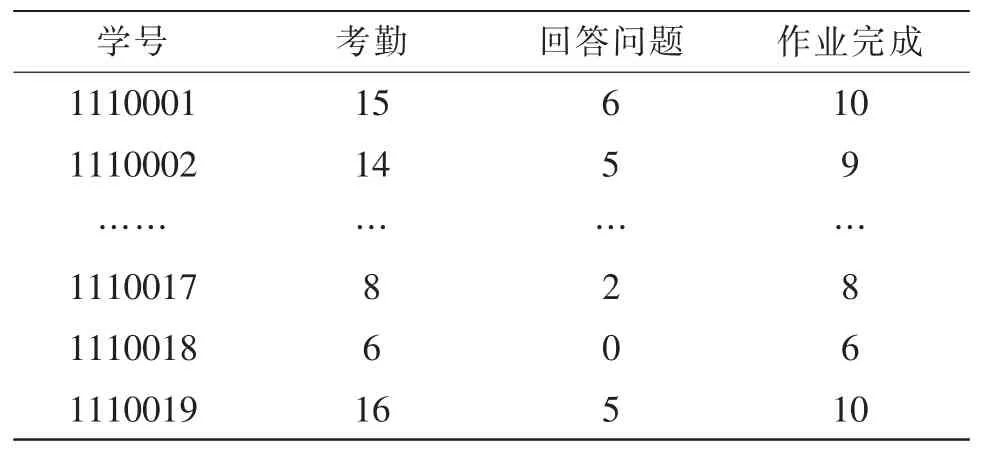

数据源主要包括调查数据信息、学生学习信息以及考试成绩信息[11-13]。调查数据信息如表1所示,主要包括学生的学号,性别,课程兴趣,每周上机时长,试卷难易程度,学生自评等。学生学习信息如表2所示,包括考勤,回答问题,作业完成等。其中每周上机时长(h)分为>2、1-2、<1;课程兴趣分为感兴趣、一般、不感兴趣;试卷难易分为高、中、低。上课考勤、回答问题、作业完成为学生实际完成次数(满勤16次,提问16次,作业布置10次)。考试成绩信息如表3所示。

表1 学生调查统计表

表2 学生学习情况统计表

表3 学生成绩表

由于学生缺考,调查者未填写等等原因,收集到的数据存在不完整性,剔除不合要求的数据[14-15],剩下35条学生数据,将其中的23条数据作为训练样本数据,其余12条数据作为测试样本数据。

为了便于建立决策树模型,根据实际情况,采用3个数据表中的学号,课程兴趣,每周上机时长,试卷难易,考勤,成绩合并为一个成绩分析表如表 4所示,以此作为建立决策树模型的依据。经过数据预处理后,量化表示数据表中的描述性文字(其中考勤>13次,优秀,考勤8-13之间,一般,考勤<8次,差;成绩<60分,不及格,成绩60-85,良好,成绩>85,优秀)。

2.2 构造决策树

据表4可知,训练样本的结果分为优秀(C1),良好(C2),不及格(C3)三类。

表4 学生成绩分析表

1)计算信息熵

对于23个训练样本,其中成绩C1类有14个样本,成绩C2类有5个样本,成绩C3类有4个样本。根据公式(1)得到信息熵为:

2)计算条件熵

考查样本属性A“每周上机时长”,共有优秀,差,一般3个取值,据此将23个训练样本也分为3类 (S1,S2,S3),属性A取值优秀有4个样本(S1类),取值一般的有15个样本(S2类),取值差的有4个样本(S3类)。S1类中成绩为C1类的样本有3个,成绩为C2类的样本有1个,成绩为C3类的样本有0个,根据公式(1)可得到S1类、S2类、S3类的信息熵分别为:

根据公式(2),可得到以属性A为分类的条件熵

3)计算信息增益和信息增益率

根据公式(3),公式(4)可得到属性A的信息增益和信息增益率为:

同理,可求出其他属性(课程兴趣B,考勤C,试卷难易D)的信息增益和信息增益率。由于试卷难易结果都为中,对构建决策树没有影响。

4)建立决策树

ID3算法选择信息增益最大的属性C(或C4.5算法选择信息增益率最大的属性C)作为树根节点,按照属性C的3个取值,对23个样本进行分支得到3个子集,如图1所示,然后对每一个分支按照以上方法递归计算,最后得到决策树如图2所示。

图1 属性A为根建立分支

5)修剪决策树[8,15]

由于完整的决策树对样本特征的描述 “过于精确”,所以并不是一棵最佳树。随着建树层次的增加,确定分支准则的样本数量不断减少,个性化特征非常明显,缺乏一般性,出现“过渡拟合”的想象,解决这个问题的方法就是决策树修剪。决策树剪枝有两种基本策略,一种是预修剪,另一种是后修剪[2]。文章采用后修剪方式绘制出来的决策树如图3所示。通过后剪枝技术,只保留对学习成绩影响最大的属性值,减去对学习成绩影响小的属性。

2.3 模型评估

基于23个训练样本,采用C4.5方法构建完成某班学生学习成绩的决策树模型,是否对其它样本集有效呢?将12个测试样本数据按照此模型进行分析,11个学生数据符合模型的结果,准确率达到了91%。采用其他专业同门课程的学生信息数据进行测试,准确率也达到了85%以上,因此该模型是有效的,能够对学生的学习,教师和教育教学部门的工作起到指导作用。

图2 学生成绩分析决策树

图3 修正后的决策树

3 结 论

文中在论述了决策树算法的基础上,采用决策树技术对学生成绩问题进行了分析研究。选取影响学生学习成绩的主要因素作为属性,利用ID3算法和C4.5算法构造决策树,并通过后剪枝技术得到最终的决策树,结果表明,学生上课听讲和课程兴趣是影响学生成绩的主要因素。通过测试样本数据对模型进行评估,准确率达到85%以上。不足之处该模型中样本数据较少,考虑影响学生成绩的因素不够全面,而且基于训练样本的后剪枝技术还需要进一步改进。

[1]李爱国,厍向阳.数据挖掘原理、算法及应用[M].西安:西安电子科技大学出社,2012.

[2]薛薇,陈欢歌.SPSS Modeler数据挖掘方法及应用[M].北京:电子工业出版社,2014.

[3]施俊琦,王星(译).决策与判断[M].北京:人民邮电出版社,2004.

[4]王永梅,胡雪钢.决策树中ID算法的研究[J].安徽大学学报(自然科学版),2011,35(3):71-75.

[5]樊敏.基于决策树算法的成绩优秀率分析与研究[J].计算机时代,2015(12):70-71.

[6]刘静.基于决策树技术的CET-4成绩数据挖掘研究[J].赤峰学院学报(自然科学版),2015,31(12): 18-19.

[7]陈治国.数据挖掘技术在教学决策支持中的应用研究[D].长沙:国防科技大学,2006.

[8]蒋盛益,李霞,郑琪..数据挖掘原理与实践[M].北京:电子工业出版社,20113.

[9]覃桂敏基于数据仓库的决策支持技术的研究[D].西安:西安电子科技大学,2004.

[10]杨静.决策树算法的研究与应用[J].计算机技术与发展,2010,20(2):115-118.

[11]崔仁桀.数据挖掘在学生专业成绩预测上的应用[J].软件,2016,37(1):24-27.

[12]陈凯,曹晓光,杨冀红,等.基于C4.5决策树算法的全国积雪模型生成[J].电子设计工程,2014,22(17): 44-47.

[13]周宝曜,刘伟,范承工.大数据战略·技术·实践[M].北京:电子工业出版社,2013.

[14]冷泳林.ID3算法在学生评教数据分析中的应用研究[J].电子设计工程,2013,21(2):4-6,9.

[15]杨淑莹.模式识别与智能计算-MATLAB技术实现[M].北京:电子工业出版,2009.

[16]徐岩,陈昕.基于贝叶斯决策树的电网报警信息去噪方法研究 [J].陕西电力,2014(6):38-41.

[17]高静,杨楠,贺元康.基于Matlab/Simulink的直流输电系统异常引起的发电机组失步保护动作仿真分析[J].陕西电力,2014(2):70-73.

[18]宋晓林,王正杰,寇喆.基于LabVIEW和Matlab综合平台的高精度多功能虚拟数字电能表的研究[J].陕西电力,2015(8):39-44,49.

Application of the decision tree algorithm in the analysis of student achievement

HAN Li-na,HAN Gai-ning

(Institute of Graphics and Image Processing,Xian Yang Normal College,Xianyang 712000,China)

Based on the analysis of the main factors that influence the students'learning effect,the method of decision tree is adopted to analyze the data and display the results directly.Through the study of a certain class of students learning data mining analysis of the test,it uses the ID3 and C4.5 algorithm to generate a decision tree and streamline it with post-pruning technology.Finally the main factors influenced the effectiveness of this course,checking work attendance was found out.Then an effective suggestions on individualized presentation and guidance was provided after analysis of students learning.

decision tree;information entropy;information gain;information gain rate

TN91

:A

:1674-6236(2017)02-0018-04

2016-04-27稿件编号:201604261

陕西省教育厅资助项目(14JK1802);咸阳师范学院引进人才项目(13XSYK053);陕西省教育科学“十二五”规划2014年度项目(SGH140802)

韩丽娜(1976—),女,陕西富平人,博士,副教授。研究方向:数据挖掘,图像处理。