融合多跳关系路径信息的关系推理方法

董永峰,刘 超,王利琴*,李英双

(1.河北工业大学人工智能与数据科学学院,天津 300401;2.河北省大数据计算重点实验室(河北工业大学),天津 300401;3.河北省数据驱动工业智能工程研究中心(河北工业大学),天津 300401)

0 引言

知识图谱(Knowledge Graph,KG)[1],例如YAGO、NELL和国内的百度知心等为智能问答系统、推荐系统的构建提供了十分宝贵的资源。这些知识图谱以三元组的形式包含了数以百万计的有关现实世界中实体与关系的事实,例如(马云,创立,阿里巴巴)以及(蔡崇信,创立,阿里巴巴);但同时也存在着大量缺失关系的三元组,例如(马云,?,蔡崇信)。

为了更加有效地应用知识图谱并提高智能问答系统、推荐系统的功能性和完善性,进行实体间关系推理尤为重要。同时在进行关系推理时,需要挖掘并利用实体间多跳关系路径中的隐含信息,这样才能保证在推理之后得到的关系是符合现实事实且更加准确的。

关系推理首先需要将知识图谱中现有的实体和关系嵌入到低维空间,但是目前大多数的嵌入方法只考虑了实体之间的直接关系,即直接相连两个实体的关系,忽略了存在于实体之间的多跳关系路径对实体间关系推理的影响。例如一组多跳关系路径(李华,在职,清华大学,位于,北京)可以为三元组(李华,?,北京)提供了有效的推理证据,从而得到完善的三元组(李华,居住于,北京)。为了解决这个问题,Lao等[2]提出的路径排序算法(Path Ranking Algorithm,PRA)表明了由两个实体之间的关系类型组成的关系路径可以有效地应用于知识图谱的关系推理和补全任务上。PRA通过枚举给定候选关系的所有实体对之间的路径,利用随机游走方式构建特征矩阵,然后在特征矩阵上训练一个二分类方法(如逻辑回归或决策树)来推断所缺失的关系。近些年,Neelakantan 等[3]将循环神经网络(Recurrent Neural Network,RNN)应用在了基于路径推理的方法上,通过PRA 获取每个实体关系路径,然后将推理路径嵌入到低维空间并利用RNN 建模进行知识推理和补全。这些基于路径推理方法的思想简单来说就是实体之间关系的语义可以由连接实体的多个路径的语义来表示。因此,可以通过对连接实体的路径进行学习来推理两个实体之间缺失的关系。仅使用PRA 进行推理只适用于一些规模较小的数据集,并且缺乏语义相关性。增加RNN 建模之后,虽然解决了缺乏语义相关性的问题,但是其扩展性较低,组合路径的效率低且无法处理长期依赖问题。另外由于现有关系推理相关算法没有十分注重嵌入方式对推理结果的影响,因此推理精度仍有很大提升空间。

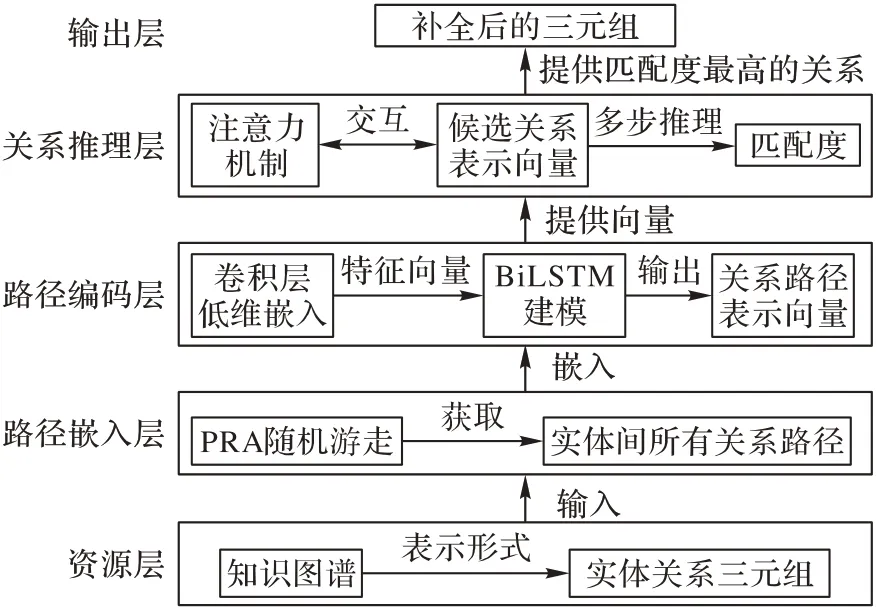

针对实体间关系推理的结果平均精度较低的问题,本文提出了一种新的融合多跳关系路径信息的关系推理方法,将卷积神经网络(Convolutional Neural Network,CNN)[4]、双向长短时记忆(Bidirectional Long Short-Term Memory,BiLSTM)[5]模块以及注意力机制(Attention mechanism,Att)结合起来应用于知识图谱的知识推理和补全任务上。

1 相关工作

随着知识图谱的研究和应用,出现了许多与知识推理相关的方法,这些方法主要分为基于KG 嵌入的推理方法和基于路径的推理方法两大类:基于KG 嵌入的推理方法通过对KG应用低维嵌入的方法预测缺失的链接,其主要是将实体和关系表示为低维向量,并通过对向量进行处理来预测实体间的关系;基于路径的推理方法主要是通过提取两实体间多条路径之间的局部特征,然后利用这些特征来预测实体间的关系。

目前,基于KG 嵌入的推理已经出现了多种依赖翻译的方 法。Nickel 等[6]提出的三阶张量分解算法RESCAL 和Bordes 等[7]提出的翻译嵌入模型(Translating Embedding,TransE)是一种采用在低维空间中实体嵌入来对关系进行解释的方法,分别通过最小化重建损失和基于边距的等级损失来学习潜在的表示。RESCAL 是基于张量分解的交替最小二乘关系学习算法,该算法可以扩展到大型的资源描述框架(Resource Description Framework,RDF)数据集,并且在链接预测、实体分类任务中取得了良好的效果。

吴运兵等[8]提出使用张量神经网络(Neural Tensor Network,NTN)模型进行知识图谱推理,与一般的神经网络相比,提供了一种更强大的关系信息建模方法。NTN 使用具有双线性张量层的标准线性神经网络层,该层直接将跨多个维度的两个实体向量相关联。Yang等[9]通过结合NTN和TransE提出了双线性对角线模型DistMult,其中关系表示为对角矩阵。另外,Trouillon 等[10]提出了一种名为ComplEx 的方法,ComplEx 在实值向量之间使用标准点积,与NTN 模型相比,嵌入实体和关系的性能更好。Dettmers 等[11]将多层卷积网络模型应用到三元组中形成了卷积嵌入模型(Convolutional Embedding,ConvE)来提高ComplEx 的性能,表明CNN 模型可以有效用于知识推理。

上述的研究主要集中在关系和实体的嵌入上,在对实体之间的语义关系建模时并不能有效地识别句子意思,没有根据实体之间的各个关系路径来对实体间的关系进行推理。基于路径推理的传统模型主要包括PRA 及其变体。在PRA 的早期研究中,路径被视为原子特征,于是就需要单个分类器去训练包含数百万条不同路径的特征矩阵。不仅如此,随着知识图谱中实体间关系数量的增加,分类器的压力也会增大。为了解决这个问题,Zhao 等[12]提出Path-RNN 模型,该模型将每条路径分解为关系序列,并将其加入到RNN 中,从而构造路径的向量表示,然后通过路径向量表示的点积计算路径和候选关系的相关性。由于一个实体对之间有多条关系路径,因此Path-RNN 使用max 运算选择可预测性得分最高的路径。为了改善Path-RNN 的性能,Das 等[13]提出了集中路径组合运算,其中包括Mean、Top-K和LogSumExp,但是这些运算都有一定的缺点,例如每条路径上都有其独特的局部特征,然而对于这些不同的局部特征,这些运算使用了相同的RNN 对其进行建模,导致推理结果准确率偏低。另外,Lin 等[14]提出一种基于三元组的推理方法对路径进行了优化,该方法采用实体对之间的路径,更加注重学习使用路径更好地表示实体和关系。

近年来,人们探索了各种扩展方式:Gardner 等[15]将文本语料库作为补充证据加入到了推理中;之后Gardner等[16]又引入了可以生成更多的预测路径的方案;另外,Wang 等[17]考虑了某些关系之间的关联性。这些扩展方法在考虑到了每条路径独特性的同时,也减小了其稀疏性;杨瑞达等[18]通过使用强化学习(Reinforcement Learning,RL)算法中的MINERVA 模型来找到路径,从而完成推理;Jiang 等[19]在推理过程中引入了注意力机制,使模型能够专注于不同的路径并组合这些路径;但是使用点积运算来吸引注意力,使得其扩展性不强,并且在链接预测过程中使用的是单步推理,推理结果也较低。Zhou 等[20]提出了结合BiLSTM 和注意力机制对文本中的关系进行分类的Att-BLSTM模型。

针对目前基于神经网络的推理方法对长序列进行排序时会发生梯度消失,且忽略了多跳关系路径中隐含信息具有长时依赖性的问题,本文提出了结合注意力机制、卷积神经网络以及双向长短时记忆网络的推理模型Att-ConvBiLSTM。

本文模型Att-ConvBiLSTM 与Att-BLSTM 相似,不同之处在于Att-BLSTM 注重于单词级别的注意,而Att-ConvBiLSTM注重于句子级别的注意。也就是说,Att-BLSTM 注意力机制模块在BiLSTM的单个输出上执行,以专注于来自单词级别上BiLSTM 隐藏单元的单词嵌入。而在Att-ConvBiLSTM 中,在BiLSTM 中将前向LSTM 的最后一个隐藏状态和后向LSTM 的第一个隐藏状态连接起来,然后在句子级别上对多个句子执行注意力机制模块,以实现对句子嵌入的集中聚合。

2 融合多跳关系路径信息的关系推理模型

在知识图谱G上给定一组实体E以及实体上的一组二元关系R,例如三元组(es,r,et)是E和R上的有序集合,es、et是头实体和尾实体,r是它们之间的关系。关系推理的目的是完善不完整三元组中缺失的关系信息,例如,给定一个查询三元组(es,?,et),通过对所有候选关系R进行评估,可以预测es与et之间具有关系r的概率,将具有较高合理分数关系r与缺失关系的两个实体组合成完善的三元组,从而对知识图谱进行补全。

基于RNN 推理路径的方法在对长序列进行排序时会遇到梯度消失的问题。为了解决此问题,使用适合对具有长期依赖性的路径序列建模的BiLSTM进行处理。此外,典型的基于路径的推理方法将实体之间的路径视为不同的特征,导致分类器必须训练大量不同的路径。本文所提方法Att-ConvBiLSTM 无需构造大型的特征矩阵,而是使用CNN 和BiLSTM 将路径嵌入到低维空间中并进行特征提取,然后针对不同路径特征进行路径序列信息编码。Att-ConvBiLSTM 模型的整体结构如图1所示。

图1 Att-ConvBiLSTM模型整体结构Fig.1 Overall structure of Att-ConvBiLSTM model

2.1 路径嵌入

首先使用嵌入矩阵来将每个输入实体和关系转换为向量,令e∈Rd和r∈Rd分别表示图中实体e和关系r的d维嵌入向量。在模型中,通过实体的类型来表示实体:一方面可以减少模型参数并防止计算瓶颈;另一方面还可以防止在测试过程中碰到无法识别类型的实体。然后使用PRA 获取与关系r最相关的每个训练实例(es,r,et)的关系路径。给定知识图谱中的三元组(es,r,et),PRA 首先在一组限定路径长度的三元组上进行随机游走,从头实体开始,一直到达尾实体,同时记录将头实体与其尾实体连接起来的所有关系。由此就获取到了多条关系路径,并且每一条关系路径p包含一系列关系{r1,r2,…,rl},加上中间实体,得到一次随机游走的路径π={es,r1,e1,…,rl,et},进一步将所有关系路径p扩展为完整路径Π。这样就获得了由关系r连接的两个实体(es,et)之间的一组路径P(es,et)={π1,π2,…,πn} ∈Π,并将其嵌入到连续向量空间中。

2.2 路径序列编码

通过对整个知识图谱进行随机遍历后可以提取到从头实体es到尾实体et的路径,一旦获得两个实体之间的路径,就进行路径编码来获取头实体和尾实体之间的路径的嵌入。两个实体之间长度为l的路径定义为π={es,r1,e1,…,rj,ej,…,rl,et},其中ej和rj分别表示路径中的第j个实体和第j项关系,es和et分别是在位置0 和l处嵌入的实体。然后将所有的路径序列长度都填充到l,并且l定义为路径集中最大路径长度。在路径序列上使用多重一维卷积运算,让路径序列经过多个具有相同大小窗口的滤波器,从而生成特征。令Wk∈R3×d是窗口内核大小为3的一维滤波器,将滤波器Wk应用于每条路径上。从头实体开始,将滤波器从左向右一次移动一个位置,直到到达了最后一个位置,从而生成特征图c,cj,k表示将第k个滤波器应用于路径序列的第j个窗口之后生成的特征,如式(1)所示:

其中:b是偏置,k是滤波器的数量,f是ReLU 非线性激活函数。将从k个滤波器中获得的特征进行横向拼接,生成特征向量cj=[cj,1,cj,2,…,cj,k],处理完所有路径后会获得特征向量集{c1,c2,…,cl}。

将卷积层输出的特征向量输入到BiLSTM 中,表示BiLSTM 模块中的一个时间步输入。在每个时间步中,将路径序列中每个项的k维嵌入输入到LSTM,LSTM 会记住先前计算的结果并将其结果在当前计算中使用。BiLSTM 由前向LSTM 和后向LSTM 两个部分组成,前向LSTM 从左到右读取路径序列中的项,后向LSTM 从右到左读取路径序列中的项,分别用¯→hj和←¯hj表示前向LSTM 和后向LSTM 的输出。为了匹配路径和候选关系的嵌入,将LSTM 单元中隐藏状态数设置成了d/2并取整。在使用BiLSTM处理路径序列中的所有项后会获得两个单独的隐藏状态序列,例如给定一个输入序列{c1,c2,…,cl},前向LSTM输出的隐藏状态序列为∈Rd/2,后向LSTM 输出的隐藏状态序列为,计算式如式(2)所示:

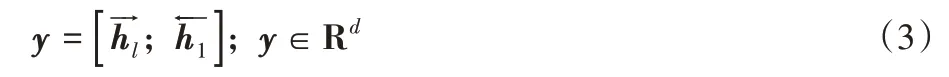

然后将BiLSTM 中前向LSTM 的最后1个隐藏状态和后向LSTM 的第1 个隐藏状态连接起来,生成长度为l的路径π的最终表示形式y,如式(3)所示。最终,n条路径生成了嵌入向量Y={y1,y2,…,yn},其中Y∈Rd×n,可以有效捕获路径的顺序特征。

2.3 注意力机制

目前已有的基于路径的推理方法基本都使用最大池化或均值运算来组合多个路径,最大池化忽略了每条路径可以提供不同的关系推理证据,而均值运算则没有考虑到并不是实体间所有路径都能代表它们之间的关系。为了衡量每条路径对路径组合的作用,本文采用加性注意力机制计算所有路径的匹配分数,实现与候选关系更为相关的路径应具有较高的权重,与候选关系相关度较低的路径具有较低的权重。与点积相比,加性注意力机制可以有效地考虑较小的值,在计算得分方面表现出更好的性能。

首先,通过PRA 对候选关系r进行嵌入,并将其转换为向量表示形式u(u=A(r));接下来,将嵌入的关系和路径编码进行匹配,计算出每条路径yi的匹配分数来表示关系r和路径πi之间的语义相似性;最后,使用加权和运算对路径向量进行组合,从而生成状态向量o,计算过程如式(4)所示:

其中:Wa∈Rd×2d是特定路径所占的权重,Wb∈Rd是权重参数;yi是第i条路径的路径表示形式;αi是匹配得分,表示在响应关系r时模型对路径πi的关注程度。加权和运算操作将来自多个路径的基本信息组合在一起,并且在丢弃不相关路径的同时保留想要关注的路径的值。

2.4 多步推理

当路径表示的搜索空间很大时,组合所有的路径并不能提供足够的证据来推断实体之间的关系,因此,为了缩小搜索范围,在模型上进行了扩展,对路径分布执行多步推理。多步推理是指对从BiLSTM 中得到的路径向量多次使用注意力机制,将每次使用注意力机制得出的结果继续使用注意力机制去提高推理结果的精确值。每一步推理都会生成一个新的关系嵌入向量u来表示推理证据。在每一步中,关系嵌入向量的计算方式如式(5)所示:

其中:Wo∈Rd×d表示权重参数,通过此计算方式可以在各层之间添加线性映射从而来更新uz。初始状态u1由嵌入的关系A(r)来定义。输出嵌入向量uz+1的更新由前一个向量uz和状态向量oz的加权和来计算。最后,生成uz并将其通过权重矩阵Wp和非线性激活函数sigmoid 计算最终预测得分,计算方式如式(6)所示。超参数Z由实验结果确定。

2.5 损失函数

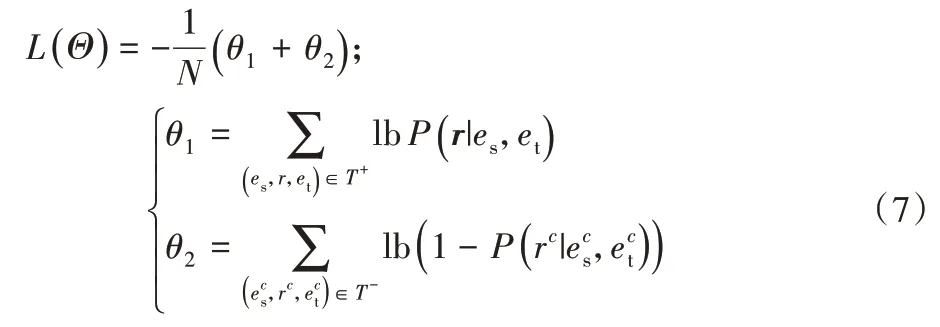

模型通过最小化交叉熵损失进行学习,使用自适应矩估计(Adam)优化,目标函数的简化形式定义如式(7)所示:

其中:N是训练集中三元组的数量;T+和T-分别代表正例和负例三元组;Θ代表模型中所有可学习的参数。在模型训练将误差降为最低的同时,给正例三元组赋予较高的值,给负例三元组赋予较低的值。调整模型的参数并将权重的标准L2范数用作约束函数,最后从所有的候选项中检索出前k个预测。

3 实验及结果分析

3.1 数据集及评价标准

为了评估本文所提方法,使用了四个知识图谱数据集,分别是两个大型数据集NELL995 和FB15k-237,以及两个小型数据集Kinship和Countries,数据集的统计信息如表1所示。

表1 不同数据集信息统计Tab.1 Information statistics of different datasets

采用平均精确率均值(Mean Average Precision,MAP)、平均倒数排名(Mean Reciprocal Rank,MRR)、F1 值以及Hit@k评估本文方法。MAP 是对相关正确实体进行排名的准确率的平均值,计算如式(8)所示,AP是在每个正例三元组的排名位置的精确率的平均值。MRR 指的是在第i个查询中查询到的第一个正例三元组的排名位置,计算如式(9)所示。F1 值是综合精确率(precision)和召回率(recall)的评估指标,其计算方式如式(10)所示。Hit@k是指推理出的关系在排名前k位所占的比例。

其中:q是推理出来的正确的实体间的关系数,Qr是所有实体间的关系数,rankq是该正确推理的排名位置

3.2 实验设置

为了生成负例三元组,将数据集中三元组的头实体或尾实体替换为随机实体。利用负例三元组生成路径之后,会将开头或者末尾包含目标三元组的路径删掉,防止出现过度拟合的问题。例如假设存在一条从实体x到y并且经过关系temp、temp-1以及artists的路径,即temp(x,person)&temp-1(person,x)&artists(x*,y)⇒artists(x,y)。当生成这样的一条路径时,x*和x可以是同一个人,因此x*=x。在这种情况下,测试三元组artists(x,y)是已经存在于知识图谱中的。另外可以观察到,连接正实体对temp(x,person)的一些关系路径出现在了负实体对temp-1(person,x)中,但是这类路径对预测没有作用,因此将其排除在外。在推理中,长路径被认为没有短路径可靠和有效。因此在本实验的PRA设置中,将关系路径限制为最多有3个关系,这样可以有效保证在将实体类型合并到关系路径中后,推理路径在未填充的情况下最多包含7个单词。除此之外,在实验中,选择通过随机游走方式到达目标实体的概率得分大于0.1的关系路径。为了使本文方法被有效评估,没有明确路径的实体对,不论是否正确都将其从训练集中去掉。

在实验中,随机初始化所有模型参数,用Adam 优化器进行优化,调整minibatch的大小从而保证每一轮训练中minibatch数量为64。当训练集在最近的10 轮训练内精确率提高不超过10-2时,停止训练。使用网格搜索参数方法对模型中的超参数进行选择。学习率γ设置为5个可选择的值,分别是0.001,0.001 5,0.002,0.002 5,0.003;向量的维数k设置从{50,100}中选择。BiLSTM 中的隐藏单元数分别设置为64 和128,滤波器数量选择{30,40,50,60}中的值,正则化权重λ值选择{0,0.005,0.01,0.1,0.5,1}中的值。一共设置了100轮来进行训练。

3.3 实验及结果分析

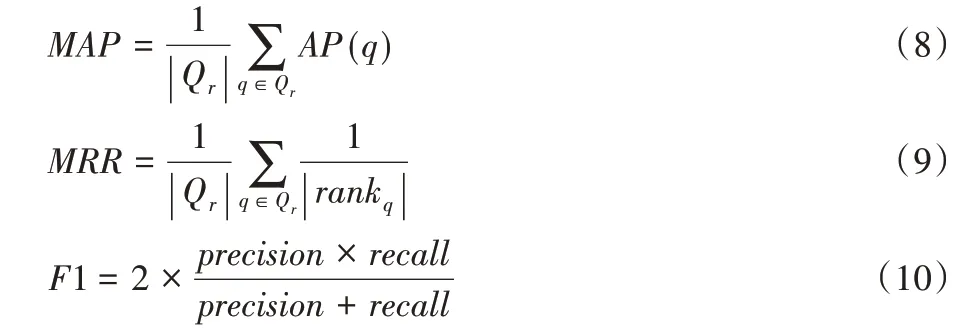

本文模型Att-ConvBiLSTM 和路径排序算法PRA[2]、双线性对角线模型DistMult[9]、卷积嵌入模型ConvE[11]、基于路径的神经网络模型Path-RNN[12]以及强化学习模型MINERVA[18]在NELL995 和FB15k-237 数据集上的推理结果MRR、MAP 以及Hits@3 的值如表2 所示。对于这种大型数据集,由于在数据集中缺少负样本,表中对比方法和本文方法Att-ConvBiLSTM 的Hits@10 得分是相同的,因此只列出了在Hits@1 和Hits@3 的命中得分。可以看到MINERVA 模型和Att-ConvBiLSTM 模型在NELL995 数据集上都表现出了很好的结果,但是Att-ConvBiLSTM 中各评价指标均比MINERVA提高了约0.2 个百分点。Att-ConvBiLSTM 可以更精确地预测到大型数据集上实体间缺失的关系。对比表中的其他方法,Att-ConvBiLSTM 在所有评估指标上都取得了很好的结果。ConvE 模型的MRR 和Hits@k得分与Att-ConvBiLSTM 相近,但是Att-ConvBiLSTM 在具有大量不同关系的FB15k-237 数据集上的结果优势还是很明显的。相反,ConvE 在具有较少关系的数据集上得出的结果略好一些,表明Att-ConvBiLSTM 更适合于大型知识图谱的推理。

表2 不同推理方法在NELL995和FB15k-237数据集上的实验结果对比Tab.2 Experimental results comparison of different reasoning methods on NELL995 and FB15k-237 datasets

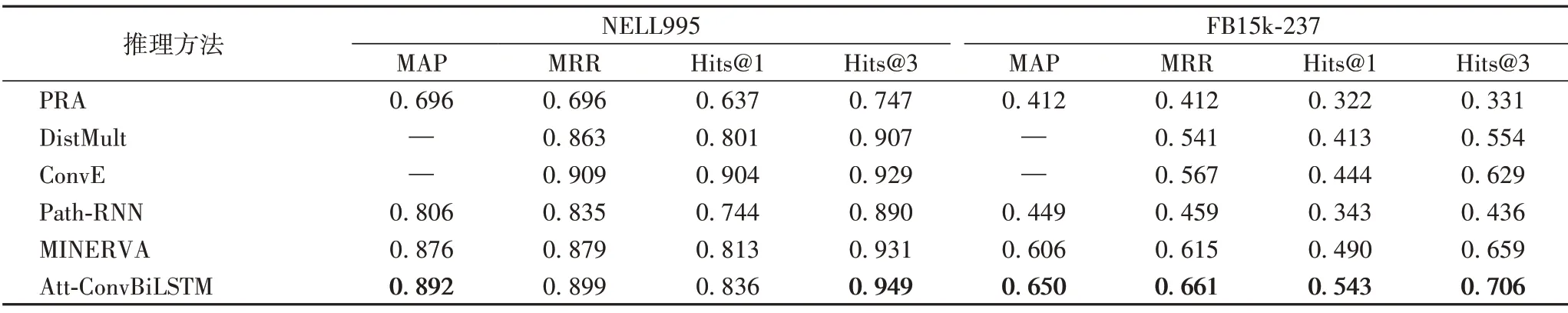

为考察不同路径长度对实验结果的影响,在NELL995 数据集上引入了不同的路径长度进行了实验:当路径长度低于3 时,由于路径中可用于推理的证据不够多,导致实验结果并不够好;当路径长度大于3 时,路径中无用单词偏多,同样会影响结果;当路径长度等于3 时,可以发现实验各项指标都处于最佳值,如表3所示。

表3 对NELL995数据集不同路径长度下的实验结果Tab.3 Experimental results of different lengths of paths on NELL995 dataset

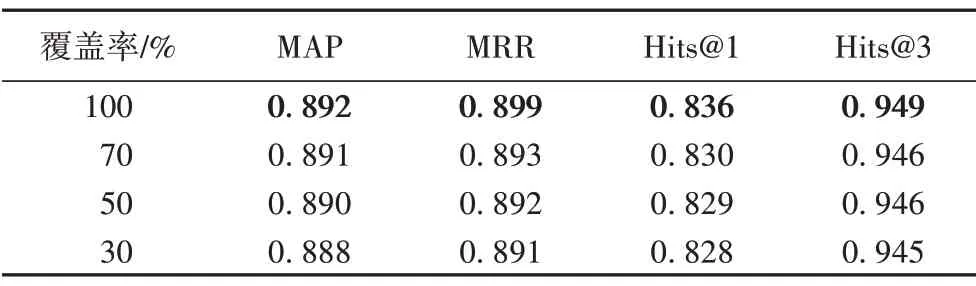

当路径较长时,PRA 会生成大量路径,可能导致内存溢出。为了避免此问题,必须将PRA 中的路径阈值调整到较高的值,这样就可以将权重占比很低的一些路径过滤掉,从而减少路径数量;但是这样又会导致模型整体性能不高,存在测试集中的一些实体无法被路径连接。实验中还发现在NELL995数据集上,较短的路径可以比较长的路径提供更可靠的推理依据。此外,在上述的实验中,使用了实体类型嵌入来表示实体,但是在某些情况下,类型信息可能无法访问或者仅部分可用。如果类型信息不可用,那么使用该实体的嵌入,而不按其类型来表示实体。因此在NELL995 数据集上,对于实体类型的覆盖率做了实验,在路长为3 时不同覆盖率的实验结果如表4所示。可以注意到当路径长度设置为3时,如果实体类型的覆盖率降低,性能则会有所下降。出现这种问题可能是由于测试集中的一些实体在训练集中并不存在。

表4 对NELL995数据集不同覆盖率下的实验结果Tab.4 Experimental results of different coverage rates on NELL995 dataset

为了考察Att-ConvBiLSTM 的泛化能力,在小型数据集Kinship 和Countries 上进行了实验,其实验结果如表5 所示。由表5 可知,Att-ConvBiLSTM 在Kinship 数据集上取得了优异的结果,因为相较于其他数据集,Kinship 数据集具有更多可预测的路径。但是对于Countries 数据集,Att-ConvBiLSTM 模型的推理结果相比其他方法略有不足。通过分析Countries数据集可知,该数据集中可用于训练的三元组数量较少,无法有效地进行训练,因此本文方法不适用于规模很小的知识图谱。对于具有更多多跳关系路径的知识图谱,Att-ConvBiLSTM 具有相比其他方法更好的性能体现。

表5 不同推理方法在Kinship和Countries数据集上的实验结果对比Tab.5 Comparison of experimental results of different reasoning methods on Kinship and Countries datasets

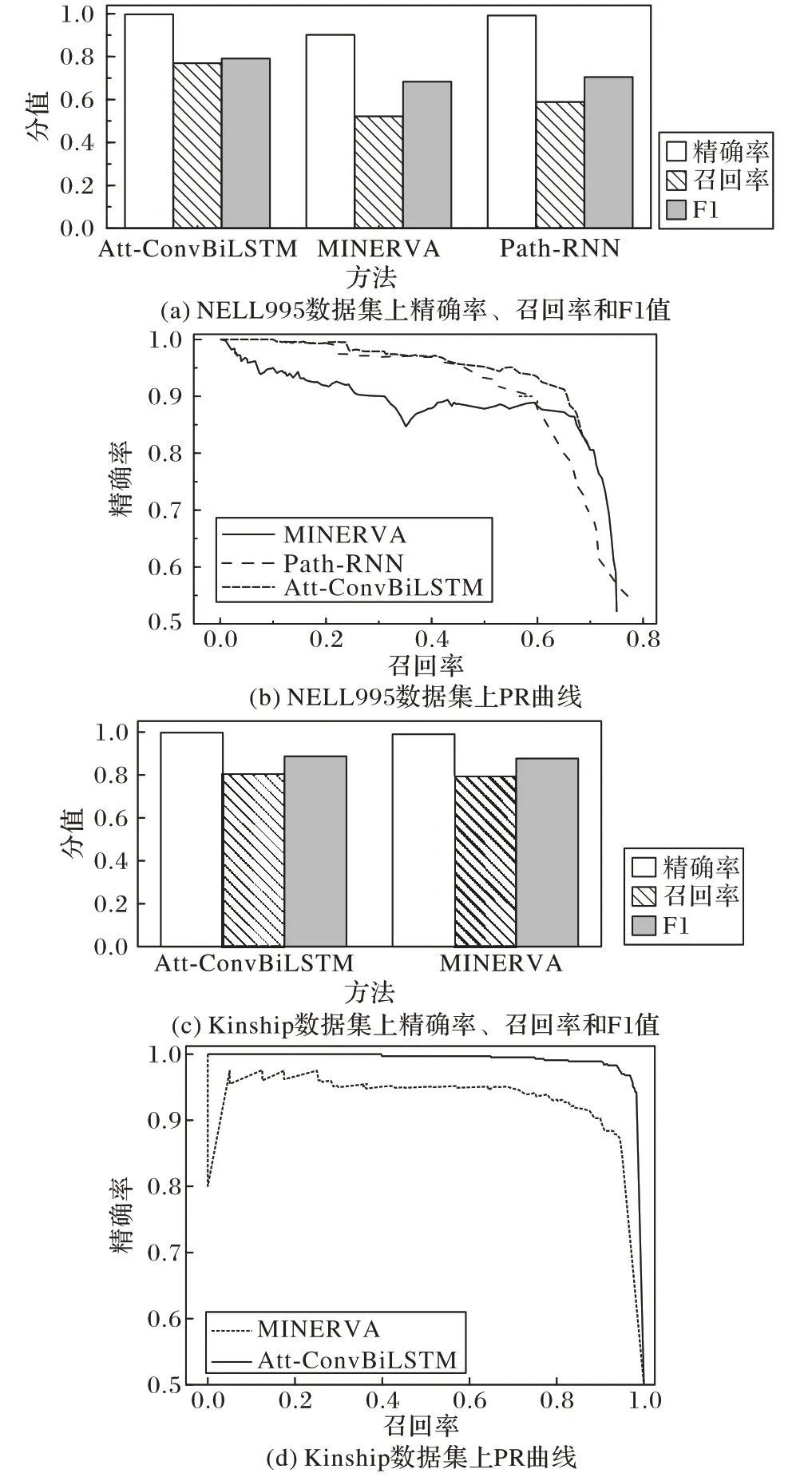

Att-ConvBiLSTM 和其他模型在大型数据集NELL995 和小型数据集Kinship 中精确率、召回率以及F1 值如图2 所示。由图2可知,Att-ConvBiLSTM 模型F1分数最高,并且召回率比MINERVA 高出了约10%。这意味着Att-ConvBiLSTM 在推理中可以更大概率找到正确的候选集。

图2 Att-ConvBiLSTM与其他模型在NELL995和Kinship数据集上的实验结果对比Fig.2 Comparison of experimental results of Att-ConvBiLSTM and other models on NELL995 and Kinship datasets

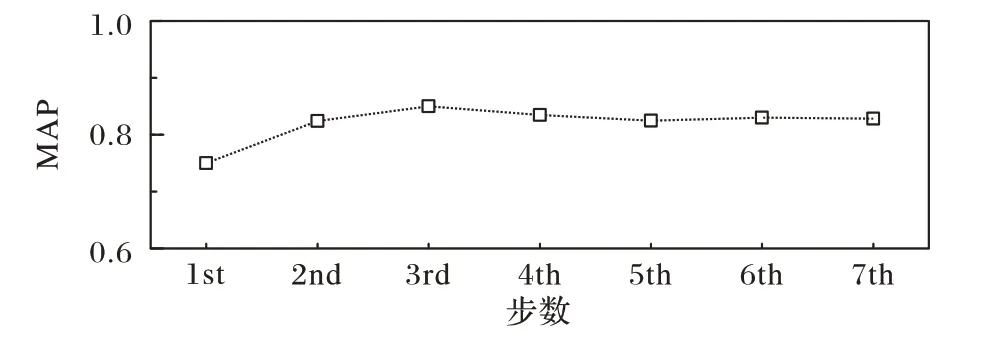

为考察推理步数对模型性能的影响,采用1~7 步推理。在NELL995 数据集上,参数采用上述实验的最佳参数,MAP得分如图3 所示。可以观察到,MAP 得分一开始随着推理步骤数量的增加而逐渐增加,在第3 步之后达到最高值,然后又有所降低。分析可知,一开始该模型中会有一些无用的路径参与推理,从而导致MAP 得分比较低。但随着模型到了第3步推理时,无用的路径越来越少,从而得到了很高的预测分数。随后由于出现过拟合,MAP得分从第4步开始逐渐减小。

图3 NELL995数据集上采用不同推理步数的MAPFig.3 MAPs with different reasoning steps on NELL995 dataset

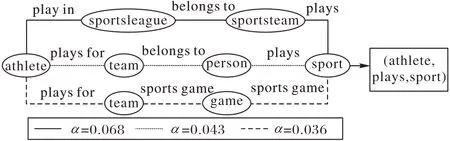

图4 给出了实体间具有不同注意力权重α的关系路径的推理路径,通过不同的路径可以推理出的直接关系。在原来的NELL995 数据集中,athlete 与sport 并没有直接的关系,但是通过推理可以得到两者之间的直接关系是plays。推理完成后,通过将推理出的关系与相应两实体进行结合形成新的三元组(athlete,plays,sport)增加到原知识图谱中,完成该知识图谱的补全。

图4 不同注意力权重的路径以及对应推理结果Fig.4 Paths of different attention weights and corresponding reasoning results

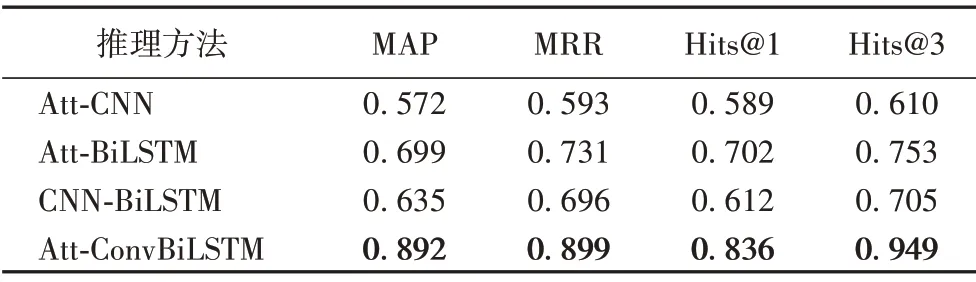

对于本文提出的模型Att-ConvBiLSTM 中的3 个核心组件,为了评价各组件对推理结果的影响程度,在NELL995 数据集中做了以下3 组实验来进行判断(参数设置均为最优值),得出不同组件组合下的实验结果如表6 所示。根据实验结果可知,BiLSTM 对语义的长时依赖处理最大程度影响着推理结果。由于注意力机制需要捕获候选关系与实体间的关系路径中的语义相关性,因此也较大程度影响着推理结果。对于CNN 卷积层,虽然其对结果的影响程度较低,但多跳关系路径中的局部特征提取是非常重要的一个环节,因此不可缺少。

表6 不同组件组合在NELL995数据集上的实验结果Tab.6 Experimental results of different component combinations on NELL995 dataset

4 结语

为了考虑到多跳关系路径信息对知识图谱中的关系推理结果的影响,结合CNN、BiLSTM 和注意力机制,本文提出了一种融合多跳关系路径信息的关系推理方法。该方法在减少了计算开销的情况下,在各数据集中的实验结果均优于其他方法。表明本文方法对知识图谱中实体间的关系推理具有较高的准确性,在知识图谱领域,本文方法可作为研究实体间关系推理的参考。下一步研究将会尝试将更多种实体类型融合到嵌入中,实体类型的多样化对推理结果的影响程度也将是进一步研究的重点。