基于强化学习的一对多雷达干扰资源分配策略研究

尚 熙,杨革文,戴少怀,蒋伊琳

(1.哈尔滨工程大学信息与通信工程学院,黑龙江哈尔滨 150001;2.上海机电工程研究所,上海 201109)

0 引言

目前,自适应雷达对抗技术已经成为现代电子对抗研究的重点问题。在飞机进行突防的过程中,所面对的“地/海面雷达信号环境”大多是复杂、多变的;并且,随着多功能雷达的发展,当前雷达的工作模式可以发生较大的变化,单一干扰策略的压制效果并不理想。当干扰方对雷达方进行干扰时,通常是处于信息非对称的情形,这样,就需要干扰方的干扰设备具有一对多的干扰能力。现有的能够动态分配干扰资源策略且与环境进行互动变化的算法主要是强化学习,如:黄星源等对信息对称情况下的多对多干扰资源分配问题进行了研究,但未涉及一对多干扰资源分配问题;周彬等使用Q-learning 算法对无人机路径规划问题进行了研究,但不适用于多状态及动作场景;刘松涛等在对自适应干扰机的研究中,没有引入干扰辐射能量低、突防距离远的干扰资源分配理念;现有的DQN(deep Q network)算法可应用于多状态及动作场景,已经被用于解决路径规划问题,但是对于雷达干扰资源的分配问题研究较少。

本文主要以突防距离比和干扰辐射能量比作为整个干扰对抗过程的评价标准,以要求突防距离最大和使用干扰辐射能量最少之间的反比关系互相牵制,采用引入动态调整奖励值的DQN 和Dueling-DQN 算法,分别记作DQN(R)和Dueling-DQN(R),利用其合理地分配自适应干扰机的干扰资源,使得实施一对多干扰时的整体效益最大化,即:在研究复杂电磁环境下实施一对多干扰的压制效果基础上,对能量损耗和突防距离的最大化效益进行研究,并比较两种强化学习算法的优劣。

1 复杂电子对抗环境模型建立及资源分配评价标准

1.1 自适应干扰机

与传统干扰机相比,自适应干扰机能够随着所接收到的参数信息实时地更改自身的干扰策略,合理、高效地对雷达实现压制干扰,根据干扰方的需求,可以满足干扰辐射总能量小、突防距离大的要求。传统干扰机往往采用单一的干扰样式和功率对雷达进行压制,只考虑压制成功与否,这种固定的、单一的策略很容易因多功能雷达工作参数的改变而达不到理想的压制效果,因此,自适应干扰机更加符合当前对抗技术的需求。自适应干扰机可以被理解为一个智能体,其接收的数据和采用的策略则可以被认为是与环境的交互,通过模拟人类大脑学习过程,对不同的事物做出不同的策略和自己的评价,最终使智能体可以面对任何环境做出合理的动作和评价。自适应干扰机的结构框图如图1 所示,本文中干扰策略库主要的干扰样式有噪声调幅、噪声调频、灵巧噪声和密集假目标压制。

图1 自适应干扰机的结构框图Fig.1 Block diagram of the adaptive jammer

1.2 电子对抗场景

建立一对多的复杂电子对抗环境时,本文中进行对抗的雷达模型有搜索、跟踪、制导3 种工作状态(具体状态转换关系见2.1 节),飞机突防开始状态默认雷达处于搜索状态,飞机突防失败状态默认雷达进入制导状态。因海杂波对雷达的探测性能影响较大,在整个突防的过程中引入海杂波的影响,可参考文献[11]和文献[12]。考虑到随着自适应干扰机离雷达越来越近,需要考虑干扰信号从旁瓣进入的影响,可参考文献[13]。

雷达在杂波与干扰环境下的最大探测距离,如式(1)所示。

式中:为玻尔兹曼常数;为标准室温,通常取290K;为接收机内部噪声带宽;为噪声系数;为接收到的海杂波功率;()为接收机输出端测量的信噪比,即个脉冲信噪比;为干扰机天线增益;()为在偏离雷达角度时的接收增益;为干扰机到雷达的径向距离;为极化因子;为发射信号波长;为目标散射截面积;为脉冲压缩比;为雷达接收机损耗;为干扰功率;为雷达发射功率;为雷达天线增益;为雷达接收天线增益。此处认为雷达接收信号方向为雷达天线的主瓣方向,故而有==。

建立如图2 所示的一对多情形下的电子对抗场景,其中,两雷达之间相距为,3部雷达都建立在高为的小岛顶部。飞机携带一部自适应干扰机从远方突防而来,自适应干扰机携带的干扰样式有噪声调幅干扰、噪声调频干扰、灵巧噪声干扰及密集假目标干扰。突防开始时,飞机与雷达2 相距为,飞机飞行速度为,飞行高度为,飞行航迹指向雷达2。以上述建立的电子对抗环境为背景,研究一部自适应干扰机在一对多情况下的干扰资源分配策略。

图2 整体电子对抗场景示意图Fig.2 Schematic diagram of the overall electronic countermeasure scenario

1.3 干扰资源分配评价标准

对于飞机携带自适应干扰机对雷达进行突防的过程,需要考虑的是利用现有资源使干扰辐射能量最小、突防距离最大,合理、动态完成干扰资源的分配。若整个需要突防的距离为,飞机速度为,则可以将整个过程分为=/步,每次重新分配干扰资源的时间步长为1 s,在该时间步长内采用相同的干扰样式进行多次干扰。记~分别为整个过程中各种压制的干扰辐射总能量,如表1 所示。其中,约束条件有:=+++,~分别为每种干扰样式各自干扰的总时长;~分别为某一干扰样式且不同功率下的干扰时长;~分别为不同时刻采取不同干扰样式时选择的干扰功率大小。

表1 整个过程中各种压制的干扰辐射能量计算方法Tab.1 The calculation method of various suppressed interference radiation energy in the whole process

基于此,提出整体干扰辐射能量占比=/,其中:=+++,称为实际干扰总能量,即突防过程中,干扰机总共辐射的干扰能量大小;=max()·(/),称为整体干扰总能量,即突防过程中总是施放干扰功率最大的干扰样式产生的总干扰辐射能量大小。根据定义,0 <<1,越大表明整个过程中干扰需要的总能量就越大,反之,需要的干扰总能量就越小。作为一对多干扰策略的目标值,越小越好。

不能只从一个方面对整个雷达的压制干扰效果进行评价,因此,引入最大突防距离比=/,其中:表示战斗机携带干扰吊舱突防的最大距离;表示整个突防的距离。作为干扰效果的目标值,越大越好,与对的要求相反。可以利用指标和对干扰资源分配的结果进行整体评价。

2 基于强化学习的干扰资源分配

2.1 马尔可夫建模

在对雷达阵地的突防过程中,多功能雷达有多种工作模式。对于干扰方来说,多功能雷达主要有搜索模式、跟踪模式和制导模式。搜索模式是初始状态,制导模式是终止状态,进入制导模式后结束本次迭代。多功能雷达的工作状态变化可以用图3 描述,记S(为雷达编号)为雷达状态值,用来描述雷达所处工作模式,搜索、跟踪、制导模式的S值分别取0、1、2。本文假设3部雷达不进行组网,各自对目标进行独立探测。对于每部雷达,状态转换依据为:

图3 雷达的工作模式转换及相应Sri值变化示意图Fig.3 Schematic diagram of radar working mode conversion and corresponding Sri changes

1)搜索状态下,如果4次探测中雷达有3次探测到目标,雷达状态进入跟踪状态,否则,保持搜索状态。

2)跟踪状态下,如果3 次探测中雷达有2 次探测到目标,雷达状态从跟踪状态进入制导状态;若3次探测均未探测到目标,雷达状态返回搜索状态;否则,保持在跟踪状态。

根据马尔可夫模型建立状态函数S

式中:表示飞机离雷达2 的径向距离;=[,,]为1×3 的矩阵,包含3 部雷达当前时刻各自的工作模式S,S对应的值越大,则代表威胁等级越高,反之,则越小;CON(·)为连接函数。

干扰动作主要从功率和干扰样式进行划分,自适应干扰机能够有效干扰的功率范围为~,若把有效干扰功率合理地划分成个,那么,对于4 种压制干扰样式,自适应干扰机可以采取的干扰动作就有4种,每一种干扰动作对应不同功率下的某一种压制干扰方式。根据马尔可夫模型建立动作函数,可表达为

式中:表示对第部雷达进行干扰,本文的取值为1到3;a表示该时刻采取4中动作的一种。因此,A表示对第部雷达所采取4中某一种干扰动作,为1×2的矩阵。

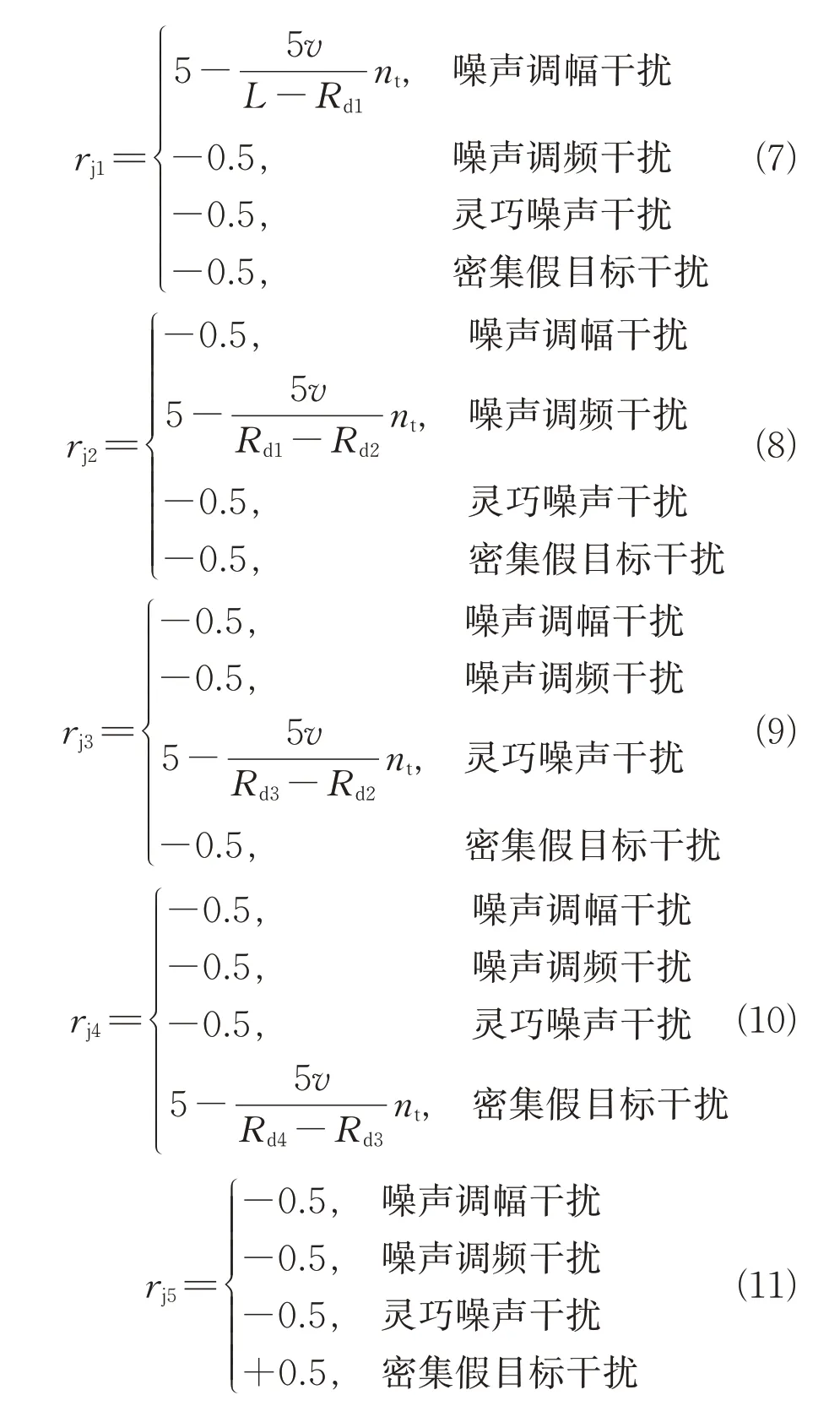

当奖励设置不合理时,会使得干扰策略分配难以快速收敛,导致智能体学习的速度大大降低,而合理的奖励值设置会使智能体可以快速地在与环境的交互中学习和收敛。因此,本文从3个方面设置奖励:每步干扰成功奖励、干扰功率奖励、干扰样式能量最小化奖励。

每步干扰成功奖励设置为

干扰功率奖励设置为

式中:~取值范围为[-0.5,+0.5],~为正值,分别为-0.5、-0.4、-0.3、-0.2、-0.1,~为负值,分别为0.1、0.2、0.3、0.4、0.5。

干扰样式能量最小化奖励设置为

式中:=(-)/,表示飞机飞行到步;~表示各个干扰样式最大功率下对雷达旁瓣干扰时雷达最大探测距离(当虚警概率为10、发现概率为0.5 时)。参考第三章仿真参数,带入公式(1)可求得各种干扰下的雷达最大探测距离~,~分别为321 km、139 km、77 km、16 km。

综上,我们可得每步的总奖励值为=++。

2.2 基于DQN与Dueling-DQN算法的干扰资源分配策略

DQN 算法是Q-Learning 算法的改进,摒弃了QLearning 算法中的Q 表,利用深度神经网络(deep neural network,DNN)代替了Q 表,可以适用于多状态-多动作的强化学习模型。DQN 网络主要由当前网络、目标网络、环境、经验回放池、DQN误差函数构成,如图4所示。

图4 本模型中DQN网络结构图Fig.4 DQN network structure diagram in this model

如图4所示,其中、、、分别代表状态、动作、奖励及网络参数,采用随机梯度下降法(stochastic gradient descent,SGD)更新网络参数。DQN 内部包含两个网络,分别是当前网络和目标网络,这两个网络的结构一模一样,均为DNN 网络,把上文的状态S和动作A作为DNN 网络的输入得到该状态和该动作下的值函数。控制目标网络的参数在一定的步数间隔内保持不变,把当前网络的参数直接复制给目标网络,而不是每帧都更新,目的是去除目标值和当前值的相关性,解决训练不稳定的问题,提高收敛成功率。其网络中的相关参数有:(经验回放集合尺寸)、(奖励折扣因子)、(学习率)、(-贪婪因子,以的概率选择最优动作,(1-)的概率选择随机动作)、(重置网络权重步数)、(每次训练批量)。

结合建立模型的DQN 算法的具体实施步骤如图5 所示,主要流程为:先对网络进行初始化;然后侦查获得雷达当前时刻状态,使用贪婪策略以的概率选择最优动作,以(1-)的概率选择随机动作,与设定对抗环境进行交互获得下一时刻状态,并对该动作进行打分操作,将上文中的状态和动作作为DNN 网络的输入,进行值函数的计算,将当前状态下采取动作的优劣度以值函数的方式进行表述;当达到训练总步数后,将状态和动作信息存储下来,用于自适应干扰机的在线干扰资源学习和分配。

图5 结合建立模型的DQN算法流程图Fig.5 DQN algorithm flow chart combined with the establishment of the model

Dueling-DQN 算法与DQN 算法的不同点在于:DQN 神经网络输出的是每种动作的值,而Dueling-DQN每个动作的值是由式(12)确定的,其余部分两者完全相同。

式中:V(;)表示这个状态下的值;(,;)表示每个动作在这个状态上的优势。因为有时在某种状态下,无论做什么动作,对下一个状态的影响均很小。通过这种方法就能大幅提升学习效果,加速收敛。

Dueling-DQN(R)算法与DQN(R)算法分别是在Dueling-DQN 算法与DQN 算法的基础上,将动态调整的奖励值引入其中。

3 仿真验证

3.1 干扰对抗场景及DQN网络相关参数设置

雷达阵地与干扰机位置关系设置如图6 所示,飞机携带自适应干扰吊舱对准雷达2 进行飞行,速度为300 m/s,3 部雷达分别位于高度为1 000 m 的小岛上,雷达阵地间隔为5 000 m,目标散射截面积为6 m,雷达平均功率为77 kW,雷达天线增益为42 dB,脉冲宽度为6.4 us,接收机带宽为40 MHz,载频为8 GHz,雷达接收机损耗为6 dB,脉冲重复频率为5 000 Hz;干扰机有效功率100~1 000 W,干扰机天线增益为15 dB,干扰机带宽为400 MHz,为0.5 dB。海杂波环境中当海面风速为10~20 Kt(Kt 用来描述海况信息的风速单位),即风速为19~38 km/h,X 波段不同来源的海杂波σ的数据合成为-36 dB。3 部雷达为同一体制雷达,工作参数相近,均有3种工作模式。

图6 雷达阵地与干扰机位置关系Fig.6 The relationship between the radar position and the jammer

经验回放池大小为2 000,奖励折扣因子为0.9,学习率为0.001,-greedy 为0.9,重置网络权重步数为1 200,每批次训练量为320。

DQN(R)算法和Dueling-DQN(R)算法训练结果对比如图7~8所示。

由图7可知:大约680次训练后Dueling-DQN(R)算法分配下的最大突防距离已经基本稳定,而DQN(R)算法则要经过约1 000次训练才能达到Dueling-DQN(R)算法的效果。由图8可知:引入干扰功率奖励值和干扰样式能量最小化奖励值后,1 200次的训练后,每次突防的整体辐射能量占比在20%~50%之间,且Dueling-DQN(R)算法下的整体辐射能量占比基本上比DQN(R)算法的整体辐射能量小,即:就干扰辐射能量的损耗情况而言,Dueling-DQN(R)算法分配的干扰策略要优于DQN(R)算法分配的干扰策略。

图7 两种算法下最大突防距离Fig.7 Maximum penetration distance of the two algorithms

图8 两种算法辐射能量占比Fig.8 The proportion of radiated energy of the two algorithms

DQN(R)算法与Dueling-DQN(R)算法训练至1 200次时干扰动作分配如图9~10所示。

图9 DQN(R)算法训练1 200次时的动作分配Fig.9 Action distribution when DQN(R)algorithm training reaches 1200 times

图10 Dueling-DQN(R)算法训练1 200次时的动作分配Fig.10 Action distribution when Dueling-DQN(R)algorithm training reaches 1200 times

由图9~10 中可以看出,Dueling-DQN(R)算法的干扰动作分配比较稳定,而DQN(R)算法的分配结果较为多变,结合两种算法的原理可知,这是因为Dueling-DQN(R)算法去掉某一状态下的不敏感动作,使得其收敛能力较DQN(R)有明显提升。并且,图9~10 中,动作数值越大表示其干扰功率越高,大部分动作的选取所需的干扰功率未达到峰值,而较为独立的峰值大都为雷达状态改变的结果。

图11 为3 种算法的损失函数对比,Dueling-DQN(R)算法大致在1 800 次网络迭代后收敛,DQN(R)算法大致在4 000 次网络迭代后收敛,而寻常DQN 算法大致在9 000 次网络迭代后收敛。从其变化规律来看,3 种算法的收敛速度和稳定性从优到劣为:Dueling-DQN(R)算法、DQN(R)算法、DQN 算法,这是因为引入了随环境动态调整的奖励值的结果,提升了前两种算法收敛的速度和稳定性。而Dueling-DQN(R)算法、DQN(R)算法的收敛速度也从一定程度上佐证了图7中曲线变化梯度。

图11 3种算法的收敛曲线Fig.11 Convergence curves of the three algorithms

图12是网络迭代14 000次中Dueling-DQN(R)算法下不同时刻自适应干扰机所选择干扰的目标雷达,可见在整个突防的过程,Dueling-DQN(R)算法实现了随突防距离变化更改其一对多干扰策略的能力。

图12 自适应干扰机选择干扰的雷达Fig.12 The adaptive jammer selects the radar to jam

4 结束语

为了研究一对多情形下的干扰资源的分配方法,本文提出了一种奖励值随突防距离动态调整的DQN干扰资源分配方法,以干扰、杂波下的雷达最大探测距离作为奖励值的调整标准,可以加快DQN算法和Dueling-DQN算法的收敛速度和稳定性,使得干扰资源的分配更快地收敛。本文算法较为理想地完成了对不组网雷达阵地的一对多的干扰资源分配,对干扰辐射总能量小、突防距离大的认知电子对抗以及非对称下多机协同干扰的干扰资源分配具有一定的参考价值。