结合卷积注意模块与卷积自编码器的细节注入遥感图像融合

李明,刘帆,李婧芝

(太原理工大学 大数据学院,山西 晋中 030600)

0 引言

遥感图像融合的目的是将多源图像综合成高质量图像,以提高图像信息的利用率、提升原始图像的空间分辨率和光谱分辨率,利于监测[1]。其中,全色图像具有较高的空间分辨率,多光谱图像具有丰富的光谱信息,利用其互补信息生成具有高空间分辨率的多光谱波段图像[2],提高图像的可视效果。

目前遥感图像融合的方法主要分为四种类型[2]:1)分量替换(Component Substitution,CS),如强度-色调-饱和度(Intensity Hue Saturation,IHS)变换[3],主成分分析(Principal Component Analysis,PCA)[4]和Gram-Schmidt(GS)[1]等;2)多分辨率分析(Multiresolution Analysis,MRA),如非下采样Contourlet 变换(Non-Subsample Contourlet Transform,NSCT)[5]和非下采样剪切波变换(Non-Subsample Shearlet Transform,NSST)[2]等;3)变分优化(Variational Optimization,VO),如基于贝叶斯[6]和稀疏表示[7]等;4)机器学习(Machine Learning,ML)[2],如基于卷积神经网络(Convolutional Neural Network,CNN)[8]、对抗神经网络(Generative Adversarial Networks,GAN)[9]和条件随机场(Conditional Random Field,CRF)[10]等。然而大部分算法需要设计复杂的融合规则,且仍然存在不同程度的细节缺失和光谱失真情况。近年来,基于VO/ML 算法与CS/MRA 算法的混合模型算法被提出,并取得显著的效果。混合模型算法将光谱信息与空间细节信息分开处理,在光谱信息保留上有了很大的提升,如基于稀疏表示的细节注入(Detail injection based Sparse Representation,SR-D)[11]与基于卷积神经网络的遥感图像融合(Detail injection based Convolutional Neural Network,Di-PNN)[12]。但是仅依靠浅层网络获取的融合图像仍存在图形特征提取不完全,导致图像信息保留不全面、信息缺失和冗余信息等问题[2],使得融合图像的空间信息和光谱信息没有得到有效的表达,在细节信息和光谱信息上有很大的提升空间。

为了解决上述问题,本文提出结合卷积注意模块、高斯滤波器和卷积自编码器作为新的混合模型的融合算法。一方面卷积自编码器可以从低分辨率高频图像中获取对应的高分辨率高频图像;另一方面高斯滤波器与卷积注意模块可以提高网络的学习能力,获取更准确的图像高频信息。其中,高斯滤波器可以从已知图像中,通过滤波获取图像的高低频信息[13],并通过二次滤波获取图像的降阶图像。在模型训练过程中引入卷积注意模块提高图像关键信息的重要性和网络的学习能力,使得模型预测的图像更加接近缺失的细节信息,减少融合阶段的光谱失真,获取更加准确的高分辨率多光谱图像。

1 卷积自编码器

通过训练卷积自编码器获取低分辨率高频图像与高分辨率高频图像的非线性映射关系。卷积自编码器具有局部连接特性,并通过卷积操作实现权重共享和二维空间信息保留[14]。卷积自编码器的结构包括两个主要部分:编码和解码。

1.1 编码

编码获取输入图像的压缩版本,由卷积层和最大池化层组成编码部分网络。编码部分通过卷积操作捕捉图像中的结构信息;最大池化删除非重叠子区域中的所有非最大值,在隐藏表示上引入稀疏性,使特征检测器变得更广泛适用。卷积自编码器随机初始化w个卷积核,表示为K=[K1,K2,…,Kw],通过卷积核K卷积操作,提取到w个卷积核下的图像的特征信息Tw。计算公式为

式中,δ表示编码层的激活函数,F为被处理的图像数据,Tw为经过卷积核操作后获取图像的特征信息,bw表示w个卷积核偏置项。编码部分由多个卷积层和最大池化层的叠加组成,上一层提取的特征信息被作为下一层的输入信息,通过多层运算获取图像的压缩版本。同时在编码部分引入卷积注意模块,处理编码部分中间步骤中的信息,实现对图像的自适应特征细化。

1.2 解码

解码将编码部分的图像压缩版本进行图像重建。由反卷积层和上采样层组成解码部分。重建图像是通过反卷积Tw和图像上采样实现。计算公式为

式中,用来描述解码层重建的输入图像,δ为解码层的激活函数,KTw为编码计算得到的卷积核的转置。利用KTw对Tw进行反卷积操作,将反卷积后的结果相加得到新的重构特征图Tw。解码层通过多个反卷积层和上采样层的叠加实现对输入图像的重建。

1.3 损失函数

卷积自编码器通过编码与解码的叠加实现了对图像信息的压缩和重建。与标准网络一样,训练过程中通过反向传播算法对神经网络中的权重进行微调。用低分辨率高频图像作为输入图像,高分辨率高频图像Ft作为标签图像。用均方误差作为卷积自编码器的损失函数,计算在n个样本数量下,卷积自编码器计算重建图像与标签图像Ft之间的均方误差。计算公式为

2 卷积注意模块

注意力通过卷积注意模块实现,卷积注意模块(Convolutional Attention Module,CAM)是一种简单而有效的前馈卷积神经网络注意模块。给定一个中间特征信息,模块沿着通道和空间两个维度顺序推断注意映射,然后将注意映射与输入特征相加以进行自适应特征细化[15]。将卷积注意模块与卷积自编码器编码部分结合,编码部分最大池化后的信息作为卷积注意模块的输入,对信息进一步细化自适应特征和加强注意力。图1为卷积注意模块流程。

图1 卷积注意模块流程Fig.1 Convolutional attention module flowchart

2.1 通道注意力模块

通道注意力模块利用特征的通道关系生成通道注意图。通道注意力模块首先采用平均池化聚合空间信息,最大池化提取图像的纹理信息,生成两个不同的上下文信息,然后将获取的两个信息输入一个共享网络中生成通道注意力图M[16]。共享网络由多层感知机(Multilayer Perceptron,MLP)和隐藏层组成。并通过δ 函数对共享网络的输出信息进行合并生成通道注意力图M,表达为

式中,对待处理的图像信息F使用平均池化(AvgPool)和最大池化(MaxPool)操作聚合特征地图中的空间信息,生成平均池化特征和最大池化特征。然后将两个特征经过MLP 和一个隐藏层,求和合并输出特征向量,如图2所示。

图2 通道注意力模块流程Fig.2 Channel attention module flowchart

获取图像的通道注意力图M后,将M与通道注意力模块的输入特征做乘法,获取经过通道注意力处理的特征图,并输入至空间注意力模块进一步细化。

2.2 空间注意力模块

空间注意力模块是在通道注意力模块基础上的进一步操作。沿通道轴应用池化操作可以有效地突出特征图中信息区域[15]。为了有效计算空间注意,沿通道轴进行平均池化和最大池化操作,然后通过一个标准卷积层将它们连接并卷积,生成空间注意力图,表示为

式中,对通道注意力图M依次进行平均池化(AvgPool)和最大池化(MaxPool)操作,并通过一个n×n大小的标准卷积将它们连接,如图3所示。

图3 空间注意力流程Fig.3 Spatial attention flowchart

获取图像的空间注意力图S后,先利用S与空间注意力模块输入特征图做乘积获取经过空间注意力模块处理后的特征图,再与卷积注意模块的输入信息F相加即可获取输入图像自适应特征细化后的图像。通过卷积注意模块的自适应特征细化,卷积自编码器在编码部分得以保留更多的关键信息,减少图像细节信息的丢失和光谱信息失真。

3 算法流程描述

基于理论分析结合卷积自编码器、卷积注意模块和高斯滤波器[17]作为新的遥感图像融合算法。算法的核心是通过训练卷积自编码器获取低分辨率高频图像与高分辨率高频图像的非线性映射关系;利用获取的非线性映射关系,将低分辨率多光谱图像的高频图像作为输入,获取其对应的高分辨率多光谱图像的高频信息,即多光谱图像缺失的细节信息。流程见图4。

图4 算法流程Fig.4 Method flowchart

3.1 数据预处理

1)将全色图像P通过计算进行滤波处理,获取高分辨率P的低频信息PL,并通过图像差值操作PH=P-PL获取高分辨率P的高频图像PH。将PL图像进行二次滤波操作,获取PL图像的高频图像PLH,即为高分辨率高频图像PH对应的低分辨率高频图像PLH。

2)将多光谱图像M处理至与P相同像素大小的图像,将图像中的每个波段k通过计算获取图像的低频图像。进一步通过图像差值操作获取图像不同波段的高频图像。

3.2 模型训练

模型训练是通过卷积自编码器的训练获取低分辨率高频图像和高分辨率高频图像的映射关系。在此阶段,低分辨率高频图像PLH作为卷积自编码器的输入图像,高分辨率高频图像PH作为卷积自编码器的标签图像。

1)编码部分:编码部分用于获取低分辨率高频图像PLH的压缩版本。在编码部分最大池化后引入卷积注意模块,实现对编码部分中间过程图像的自适应特征细化,从而加强卷积自编码器对关键信息的关注。

2)解码部分:解码部分用于将低分辨率高频图像PLH的压缩版本进行图像重建。通过上采样操作恢复图像的大小,反卷积操作实现对图像信息的恢复。并计算重建图像与标签图像PH的均方误差,更新网络的参数权值。

为卷积自编码器设定一定的迭代次数,模型优化器Adadelta[18]对模型参数进行更新,获取低分辨率高频图像PLH与高分辨率高频图像PH之间的映射关系。

3.3 图像融合

2)图像融合:图像的融合遵循CS 算法一般融合框架[1],计算公式为

4 实验结果和分析

4.1 实验平台及参数设置

实验采用QuickBird 和SPOT 卫星数据集作为试验训练数据和验证数据。为了扩充样本数据集,采用滑窗方式,裁剪步长设置为5,裁剪图像块尺寸为8×8。在训练中模型训练批量大小为256,训练迭代次数为1 600,优化器Adadelta 进行网络模型参数优化和学习率自适应。

操作系 统为Win10;CPU 为Intel Core i5,主频2.2 GHz;内存500 GB。软件平台:MATLAB2016a、Pycharm。训练环境:Keras 2.1.6;Tensorflow 1.8;Python 版本为3.6.7。

4.2 滤波器选择分析

用滤波器对模型训练数据进行预处理,克服模型训练中高低频信息冗余导致信息缺失的问题[12]。同时利用滤波器生成高分辨率高频图像对应的低分辨率高频图像。为了验证滤波器对算法的适应性,选择基于QuickBird 卫星获取的遥感图像进行实验,在网络模型迭代次数为150 次的情况下获取本文算法的融合结果。

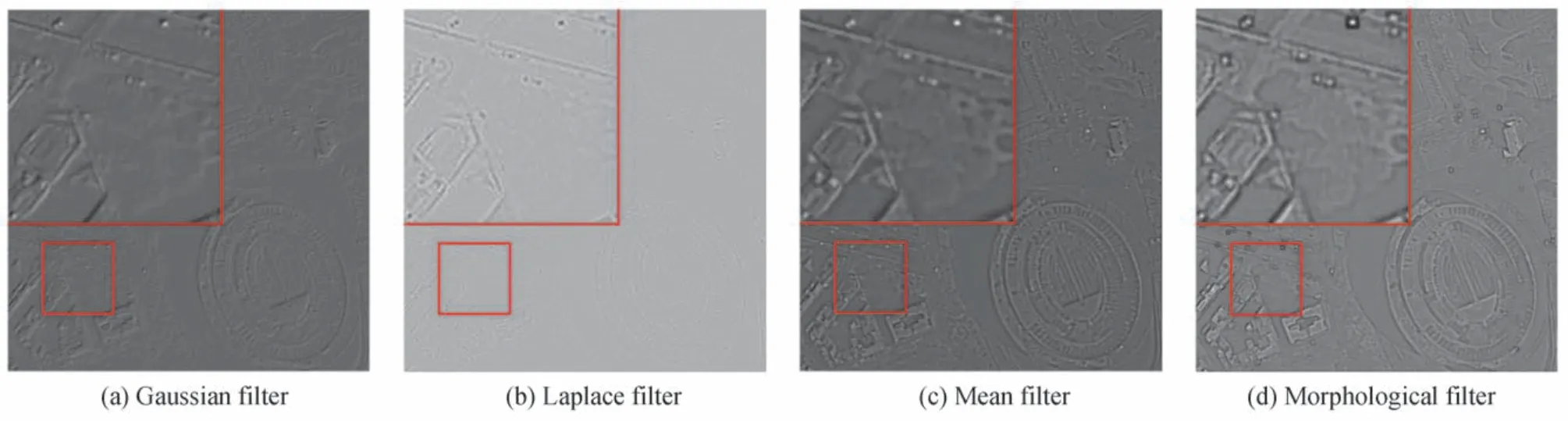

图5为QuickBird 数据集进行一次滤波后的高分辨率高频图像,含有大量图像细节信息,作为模型训练的标签图像。从图5中可以明显发现高斯滤波器、形态学滤波器和均值滤波器有较好的细节提取能力。从图5(c)可知均值滤波器处理图像的同时对图像进行模糊化处理,图像中建筑边缘信息丢失明显;形态学滤波器相对于均值滤波器保留了更多的图像细节信息,但是从图5(d)放大区域可以发现,最上部中汽车边缘部分有明显的像素扭曲。从图5(a)中发现高斯滤波器处理后图像避免了细节丢失和噪声引入。从图5(b)可以看出拉普拉斯滤波器提取细节能力比较弱。图6为进行二次滤波后的图像,用来模拟低分辨率高频图像。由图4可知训练完成的卷积自编码器可获取缺失的细节信息EH,即滤波后的图像为低分辨率高频图像,通过模型获取对应的高分辨率高频图像。因此P进行二次滤波后的图像PLH与相关性越强,图像能获取更完整的细节图像。将不同滤波器获取的PLH图像与进行相关系数(Correlation Coefficient,CC)[19]计算。相关系数用来判断两幅图像之间的相关性,公式为

图5 网络模型的标签图像Fig.5 Labeled images of the network model

图6 网络模型的输入图像Fig.6 Input images of the network model

式中,I表示原图像,R为待对比图像,与表示图像均值。相关系数的值和两个图像的相关性成正比,其值越接近1,说明两幅图像相关性越强。表1记录了不同滤波器下的PLH图像与的相关系数,其中高斯滤波的相似性最强。选择高斯滤波器对模型训练的图像进行预处理。为了进一步说明本文高斯滤波器有较好的适应性,进行基于高斯滤波器的图像融合实验。

表1 PLH 与 的相关系数Table 1 CC for PLH and

表1 PLH 与 的相关系数Table 1 CC for PLH and

Values CC Laplace 0.051 2 Mean 0.104 2 Morphological 0.178 1 Gaussian 0.333 8

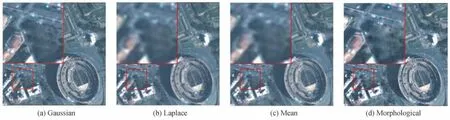

针对不同的滤波器,在模型迭代次数一定的情况下进行了遥感图像融合。图7为高斯滤波器、拉普拉斯滤波器、均值滤波器、形态学滤波器得到的融合结果。从主观上判断,可以发现图7(a)、(d)有明显的细节注入效果,图7(b)、(c)细节信息缺失明显。同时,图7(a)与(d)相比,光谱信息保留更完全,图7(d)在放大区域可以明显发现物体边缘发生了较为明显的光谱扭曲。在表2中,采用6 个参数对融合图像进行客观评价,分别为平均梯度(Average Gradient,AG)[17]、相对全局融合误差(Erreur Relative Global Adimensionnelle Synthese,ERGAS)[20]、光谱角(Spectral Angle Mapper,SAM)[21]、CC、均方根误差(Relative Average Spectral Error,RASE)[22]和通用图像质量评价指标(Universal Image Quality Index,UIQI)[23],可以发现高斯滤波器相比其他滤波器有更好的表现。

图7 不同滤波器下的融合图像Fig.7 Fusion images with different filters

表2 不同滤波器下的融合图像指标Table 2 Fusion image metrics with different filters

4.3 迭代次数分析

在4.1 节的滤波器选择中,模型迭代次数是一定的。卷积自编码器迭代次数不同,影响着模型学习图像细节结果。选取客观指标CC、ERGAS、UIQI 和RASE 作为本阶段实验的观测数值。如图8所示,ERGAS、RASE 和CC 表示图像中的光谱保持度,ERGAS 和RASE 值越小表明图像的光谱信息保留越完全,CC 值越接近1 表明图像相似度越高,图像保留信息越多;UIQI 表示图像中保留的空间细节,值越接近1 表明图像的空间细节信息保留更多,融合结果更好。图8中黑色曲线为融合图像的真实指标数值,绿色曲线为拟合曲线,拟合曲线更好地描述了指标的变化趋势,为迭代次数的选择提供了重要参考。在图8(a)中,CC 指标总体在0.944 到0.956 之间浮动,由拟合曲线可以发现,指标在1 500 次迭代之前迅速上升,在1 500 次到1 750次时趋于稳定,在1 750 次到2 000 次有了下降趋势,说明迭代1 600 次左右,图像的CC 指标普遍最佳。在图8(b)中,RASE 指标在6.4 到7.2 之间浮动,1 500 次迭代之前,随着迭代次数的增加RASE 指标逐渐下降,表明图像逐渐保留更多的光谱信息,迭代1 500 次到1 600 次时趋于平稳,在1 600 次之后RASE 指标有上升趋势,可以看出,在迭代次数为1 550 次左右时,RASE 的值普遍更佳。在图8(c)中,ERGAS 指标的变化范围在3.15 与3.55 之间浮动,1 500 次迭代之前,ERGAS 指标平稳下降,图像的融合质量逐步上升,并且在1 600次左右达到了拟合曲线的最低值,从1 750 次之后指标值有了上升趋势,可以发现迭代次数在1 600 左右图像的ERGAS 指标值普遍较好。图8(d)中,UIQI 值的浮动范围在0.95 到0.97 之间,可以发现,迭代次数在1 600 次之前,UIQI 指标值在平稳上升,并且在1 600 次与1 900 次之间拟合曲线趋势平稳,没有明显变化,在1 900 次之后,拟合曲线出现了下降趋势,表明迭代1 700 次左右时UIQI 值普遍较好。结合图8,以每幅图的拟合曲线作为重要参考,可以看出合适的迭代次数在1 600 次左右,此时图像的各项指标普遍较好,获取的融合图像较佳。

图8 不同迭代次数对应的图像指标值Fig.8 Image index values with different number of iterations

4.4 实验结果分析

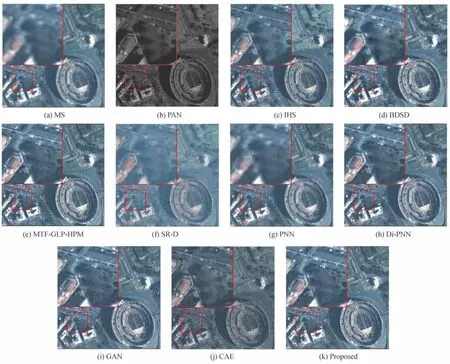

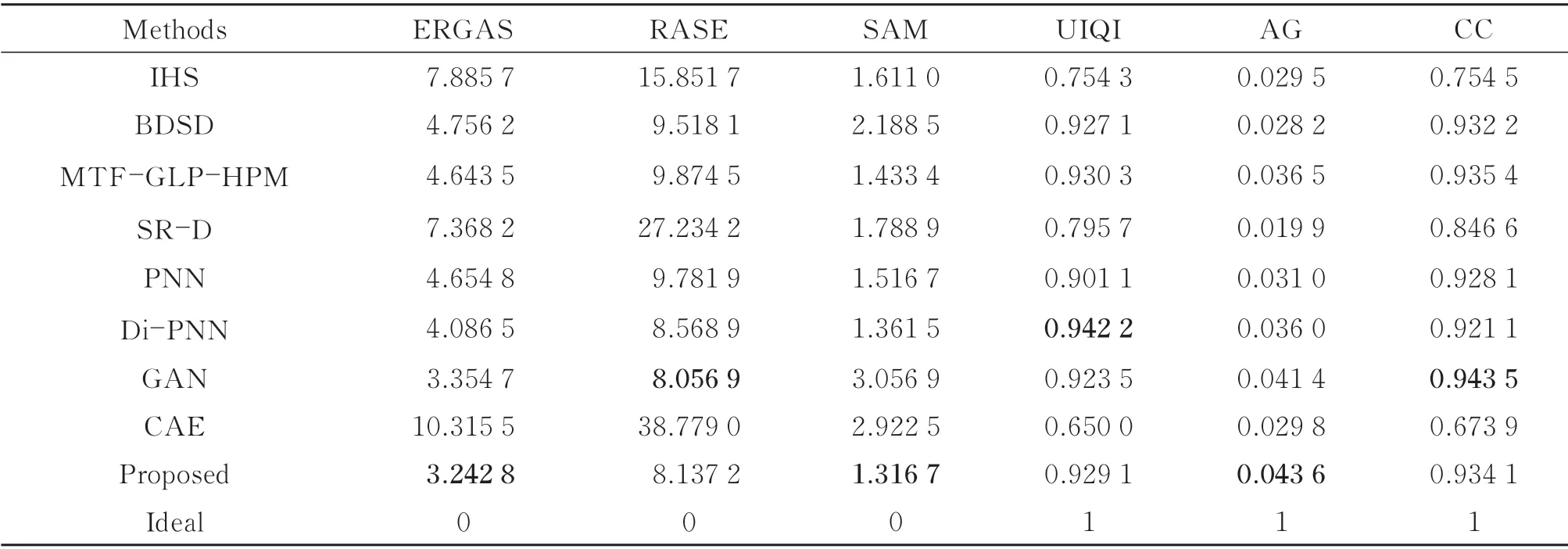

为了证明算法的有效性,将本算法与其他8 种融合算法进行比对实验。这8 种融合算法分别为IHS 算法[1],BDSD 算法[19],MTF-GLP-HPM[24]算法,基于卷积神经网络的融合算法(PNN)[25],基于卷积神经网络的细节注入算法(Di-PNN)[12],基于稀疏表示的细节注入算法(SR-D)[11],基于对抗生成网络的融合算法(GAN)和基于卷积自编码器网络的融合算法(CAE)[26]。

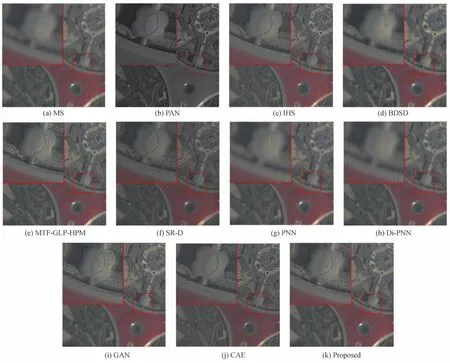

图9为QuickBird 卫星获取的意大利Roma 原图像融合结果和局部放大图。图9(a)为多光谱图像,分辨率为2.44 m。图9(b)为全色图像,分辨率为0.61 m。多光谱图像与全色图像大小均为512×512 像素。图9(c)~(k)为不同算法下的融合结果。图9(c)为利用IHS 变换获取的融合图像,在IHS 变换中采用全色图像替换多光谱图像的强度分量以增强多光谱图像中的细节信息。可以发现,IHS 变换在增强细节信息的同时,也导致了图像光谱信息的失真。从图9(c)局部放大图中可以发现树的颜色发生了失真,由绿色变成了淡绿色。图9(d)是BDSD 算法的融合结果,相比IHS 算法,BDSD 算法对融合进行了适应性选择,保留了更多的光谱信息,但是在图9(d)放大区域中仍然存在斑点光谱失真的现象。图9(e)是MTF_GLP_HPM 算法的融合结果,该算法保留了好的光谱信息与空间细节信息。可以发现,MTF_GLP_HPM 算法获取的融合图像在建筑边缘存在伪影,在图像的阴影部分也出现了细节扭曲的情况。图9(f)是SR-D 算法的融合结果,可以观察到图像的黑暗部分存在明显的噪声。因此,SR-D 算法在提升细节信息和光谱信息的同时,也为融合结果也引入了噪声。PNN 算法首次将深度学习引入遥感图像融合领域,图9(g)为PNN 算法的融合结果。与多光谱图像相比,该算法在保留光谱信息的同时,加入了全色图像的细节信息。由于PNN 融合算法采用三层卷积操作,在光谱信息和细节信息上仍有缺失,从图9(g)可以发现,PNN 融合算法的结果图像细节信息保留不完全,并存在伪影,融合效果仍有大的进步空间。为了更好地提高PNN 的融合效果,Di-PNN 算法被提出,Di-PNN 在细节信息保留上相比PNN 算法有很大的提高。图9(h)为Di-PNN 算法的融合结果,与图9(g)相比,在细节信息上有了更大的提高,保留了更多的空间细节信息与丰富的光谱信息。图9(i)为GAN算法的融合结果,主观上较图9(c)~(h)有了大的进步,但是在光谱信息保留上相比多光谱图像仍有缺失。在图9(i)局部放大图中,可以发现树木的颜色较淡,图像的阴影部分也存在一些白色噪声。图9(j)是CAE算法的融合结果,与PNN 不同的是CAE 采用编码解码网络,比PNN 有更强的空间细节提取能力和光谱保持能力。但是图9(j)图像整体偏暗,融合结果的光谱信息缺失,因此在光谱信息保持上,CAE 网络仍可以改善。受限于深度学习网络的端对端学习,PNN、GAN 和CAE 存在不同程度的光谱失真情况。本文提出算法的结果为图9(k),与全色图像和多光谱图像相比,草木、建筑和海洋的边缘细节比较清晰,光谱信息和空间细节信息得到了较好的保持,主观视觉较好。

图9 Roma 原图像及不同算法的融合结果Fig.9 Roma source images and fusion result by different methods

表3给出了QuickBird 卫星遥感图像的客观评价指标。可以看出IHS 各项指标处于劣势,BDSD 算法加入MS 的适应性选择后,分量替换算法的指标得到了明显提升。MTF-GLP-HPM 算法与PNN 算法各项指标相似,说明两者融合结果客观接近。SR-D 融合算法的RASE、UIQI 和AG 指标较低说明图像的细节信息丢失严重,同时光谱信息也存在丢失。与PNN 相比,Di-PNN 在指标RASE 和UIQI 上有所改善,说明细节注入方式保留更多的空间细节信息,SAM、ERGAS 和CC 指标说明Di-PNN 融合方式对光谱有较好的保存能力。GAN 算法与本文算法各项指标相似,融合能力相近。但是SAM 和ERGAS 指标表明本文算法有较好的光谱保存能力。同时CAE 算法融合的图像在RASE 指标和ERGAS 指标上偏高,说明图像的光谱与细节存在缺失,本文算法弥补了这些缺点并获得了较好的指标。综上,本文提出的融合算法较优于参考算法。

表3 Roma 原图像融合结果性能比较Table 3 Performance comparison of fusion results of Roma source images

图10为SPOT 卫星在United Arab Emirates 区域获取的原图像和融合图像的局部放大图。图10(a)为多光谱图像,其分辨率为6 m。图10(b)为对应的全色图像,分辨率为1.5 m。多光谱图像与全色图像大小均为512×512 像素。通过观察图10可以发现SPOT 卫星的融合图像拥有与QuickBird 卫星融合图像相似的结果。图10(c)局部放大区域中,房屋的红色房顶颜色变浅,并且草坪颜色也发生了光谱失真。图10(d)中BDSD 算法有明显的细节信息丢失,建筑边缘部分模糊。图10(e)在图像的边缘部分同样也有细节丢失的情况。在图10(e)中右上角部分建筑出现了细节信息错位的情况,不容易区分房屋界限。图10(f)放大区域中可以明显发现SR-D 算法存在空间细节丢失,边缘信息不完全的情况。PNN 受限于浅层网络的学习能力,在图10(g)中均存在空间信息保留不完全,区域信息模糊,光谱信息丢失的情况。Di-PNN 对PNN 算法有了更好的优化,图10(h)在空间细节保留能力上有明显的提高,但是仍然存在细节缺失问题,融合效果还有待进一步提升。图10(i)有较好的视觉融合结果,在空间细节信息与光谱信息的保持上比上述算法有明显进步。在图10(j)中可以发现基于卷积自编码器网络的融合结果空间细节能力保持不完全,光谱信息失真,在房屋边缘部分由黄色变成了墨绿色,光谱信息扭曲。本文算法得到的图像在空间细节保留和光谱信息保存上有较好的改善。

图10 United Arab Emirates 原图像及不同算法的融合结果Fig.10 United Arab Emirates source images and fusion result by different methods

表4给出了SPOT 卫星遥感图像的客观评价指标。其中IHS 融合算法UIQI 指标较好,表明其保留细节信息的能力,而其他指标均处于劣势,表明IHS 算法在光谱信息上的缺失。BDSD 算法指标的提升表明其在各项能力上优于IHS 融合算法。MTF-GLP-HPM 算法与PNN 算法各项指标的差距很小,说明两个算法在SOPT 卫星上表现能力相似,但在主观视觉上MTF-GLP-HPM 算法有更优的表现能力。SR-D 融合算法SAM 指标偏高,光谱信息存在丢失。PNN 算法在指标上没有突出的表现,Di-PNN 算法指标的提升表明细节注入对PNN 算法改良的有效性。GAN 算法与本文算法虽然在主观视觉上有强的相似性,但是本文算法有较好的指标,保留了更多的光谱信息与细节信息。同时本文算法相比CAE 融合算法也有较好的表现能力。

表4 United Arab Emirates 原图像融合结果性能比较Table 4 Performance comparison of fusion results of United Arab Emirates source images

5 结论

本文采用结合卷积自编码器、卷积注意模块和高斯滤波器的算法,将原始图像进行滤波处理,获取低分辨率高频图像与高分辨率高频图像,接着将低分辨率高频图像重建到高分辨率高频图像作为卷积自编码器的学习目标,并通过卷积注意模块对特征信息自适应细化,提高卷积注意模块对关键信息的保留,最终训练完成的卷积自编码器能够预测更完整的图像缺失细节信息。通过采用细节注入的方式,克服了深度学习中端对端学习方式对光谱信息的损失。实验表明,本文提出的遥感图像融合算法取得较好的视觉效果和客观指标,获取的融合图像保持了好的光谱信息和空间细节信息。