基于改进YOLOv3的多尺度目标检测算法

张丽莹,庞春江,王新颖*,李国亮

(1.华北电力大学(保定)计算机系,河北保定 071003;2.国网山东省电力公司枣庄供电公司,山东枣庄 277800)

0 引言

目标检测在计算机视觉领域的发展中发挥着不可或缺的作用,主要目标是确定所研究的对象在图像中所处的位置,并且表明所涉及对象的类别。作为模式识别中最主要的算法,它的出现为自动识别物体开辟了一种创新方式,在许多领域和特定的应用场景中都发展出较为成熟的解决方案。

近年来,随着计算机硬件技术的显著提升和深度学习理论在图像领域的不断深入,基于深度学习的目标检测算法的发展越来越成熟,因在特征表达能力和时间效率等方面都取得了突破性的进展,具有更好的鲁棒性和检测精度,在大多应用场景下已成为图像识别的首选方法。目前常见的基于深度学习的目标检测算法一般分为两类:主要是以R-CNN(Region-Convolutional Neural Network)为代表的基于候选区域提取的两阶段算法[1-3]和以YOLO(You Only Look Once)[4-7]、SSD(Single Shot multibox Detector)[8-10]、CenterNet[11]等为代表的基于回归的一阶段算法。其中,Redmon 等[6]创建了YOLOv3 算法,该算法使用了一种分类效果更好的网络结构Darknet-53,利用更强大的网络提取目标特征并生成边界回归,利用残差模块进一步深化了网络结构,保证了模型检测的准确性和时效性。

虽然基于深度学习的目标检测算法在各领域得到广泛应用,但对于多尺度目标检测特别是小目标检测仍是一项具有挑战性的任务。随着网络层数的不断加深,虽然在特征表达方面有所增强,但是浅层信息却未能得到充分利用,对目标进行精确定位的能力不足。同时小目标的有效像素很少,只携带一些不完整的特征,经过多次下采样和池化操作后,相当多的特征信息会丢失[12]。YOLOv3 作为一种代表性的单阶段目标检测算法,当目标检测背景复杂,多尺度且姿态多样时,YOLOv3 易造成小目标的漏检和误检,检测能力有待提升。

从目前的研究来看,处理多尺度目标检测问题可以分为以下几种方法:

1)采用经典的方法将网络提取的特征信息进行融合。文献[6]通过特征金字塔网络(Feature Pyramid Network,FPN)实现多尺度目标的特征融合,来提升特征网络对多尺度目标的检测能力;文献[13]将注意力机制融入到改进的Inception 结构中,使网络更加收敛,实现多尺度融合,从而提高检测的精度;文献[14]通过嵌入注意力和特征交织模块使特征图自主学习每个通道的权重,增强关键特征。

2)利用反卷积对深度特征图进行扩展。文献[15]在主干网络中引入混合空洞卷积(Hybrid Dilated Convolution,HDC)增大浅层特征图的感受野,并与深层网络特征融合以改进网络结构,提升模型对小目标的检测能力;文献[16]引入扩张卷积和自我注意模块(Self-Attention Module,SAM),提升网络对上下文信息的利用率。

3)对损失函数的优化。Focal loss[17]中利用平衡因子,来平衡正负样本的损失,降低大量负样本在训练过程中所占比重,使模型在训练时可以集中在难分及错分的样本上;文献[18]通过将预测框长宽比拟合成目标框的长宽比的LOSSCIoU提升目标的定位能力。

这些算法在一定程度上解决了目标尺度变化的问题,提高了对小目标的检测精度,但是没能考虑到检测时存在尺度变化差异的问题,并且整体算法的计算量大、鲁棒性差,不能满足对小目标精确的检测要求。

针对上述问题,本文在分析YOLOv3 算法优缺点的基础上,提出了一种基于改进YOLOv3 的多尺度目标检测算法。首先,在特征提取网络中,引入密集连接模块,实现低高层特征的复用集成,减少模型参数数量,并采用残差模块进一步深化网络结构,添加注意力机制,利用高效的通道注意力模块实现不降维的跨通道交互;在特征融合网络中,考虑到多次下采样后小目标的大部分信息都会丢失,设计双向的FPN,融合丰富的上下文信息,以弥补小目标的缺失特征。为了实现准确的边界框回归,将YOLOv3 算法中的位置损失函数替换为GIoU(Generalized Intersection over Union),训练过程中具有更快、更准确的回归,使检测算法对小目标更友好。

1 YOLOv3算法

1.1 网络结构

与YOLO 模型相比,YOLOv3 算法的主要改进是网络结构的调整,采用新的主干网络Darknet-53 进行特征提取,它是由一个DBL(Darkbetconv2d-BN-Leaky)模块和五个残差模块组成,如图1 所示。残差叠加的每个主体赋予不同的系数,分别为1、2、8、8、4。残差叠加完成后,将特征映射输出到下一个残差模块,继续进行特征提取操作。残差网络的加入,一方面保证了网络结构在更复杂的情况下仍然收敛,网络越深入,特征表达越好,有效改善了分类检测的效果,特别是对于小目标的检测;另一方面,残差网络中的1×1 卷积在一定程度上减少了参数量和计算量,这与ResNet(deep Residual Network)结构相似[19]。同时,引入了特征金字塔网络(FPN)的多层次预测结构[6],输出三种大小不同的特征图,分别为13×13、26×26、53×53,实现多尺度检测。网格单元越精细,被检测的物体就越精准。YOLOv3 整体网络结构如图2 所示。

图1 DBL和残差模块的结构Fig.1 Structure of DBL and residual modules

图2 YOLOv3的整体结构Fig.2 Overall structure of YOLOv3

1.2 损失函数

损失函数用于判断预测值与真实值的差值,它是代表模型性能的重要参数之一。在模型的训练中,不断调整网络中的参数,将损失函数优化到最小,损失值越小,模型的鲁棒性越好。YOLOv3 算法的损失函数是在YOLOv2 的基础上所作出的改进,其中最关键的变动是分类损失的替换,使用了二分交叉熵,计算公式如下:

其中:第一项目标定位损失函数(中心坐标预测误差、边界框预测误差)使用均方差进行对目标框的回归;在第二项置信度损失函数中,分为有目标和无目标两种情况,在没有包含目标的损失中引入权重系数;第三项分类损失函数中,同样使用交叉熵损失,降低计算的复杂度。LOSS函数如下所示:

2 改进的YOLOv3算法

传统YOLOv3 算法通过输出三幅大小不同特征图像来融合深层特征和浅层特征,提高了目标检测能力,具有较高的检测精度。但是对于多尺度尤其是小目标的检测,YOLOv3 算法虽能检测到大部分目标,但是检测效果并不理想,存在误检和漏检的问题。由于携带的有效像素少,特征不明显,YOLOv3 算法不能很好地提取图像的特征信息。所以本文在特征提取网络、多尺度特征融合、减少网络层数等方面进行改进,提高目标检测的精度。

2.1 基础网络改进

在YOLOv3 算法中,Darknet-53 利用残差网络的思想,采用大量1×1 的卷积减少了每个卷积的通道,残差模块的设计,降低了梯度爆炸的风险,增强网络对特征信息的学习,在保持速度的同时,减少了计算量,有效地提高了检测的准确性。但是随着网络结构的加深,模型中的浅层特征信息并未得到充分利用,缺乏多尺度特征提取,导致了大量小目标位置信息的丢失。此外,冗余的网络结构和过多的参数会导致模型的复杂训练,增加对数据需求,降低检测速度。

密集连接网络(Dense Convolutional Network,DenseNet)[20]是在保留特征信息的前提下将所有层直接连接在一起,即每一层的输入是之前所有层的输出,使整个网络层与层之间的信息流最大化。DenseNet 的核心思想是通过通道级联的方式,将浅层的特征映射转移到后续连接紧密的模块中,减轻梯度消失问题,进一步增强了特征复用,更加有效地利用特征;并且网络很窄,减少了参数量,有助于抑制过拟合的问题,以更少的参数和计算成本获得比ResNet 更好的性能。YOLOv3 算法的特征提取网络由5 个残差模块组成。本文将前两个残差模块替换为两个密集连接模块,以增加层与层之间的信息流动。通过从两个密集模块中提取特征,考虑到图像的浅层语义特征和深层语义特征,将浅层特征传递到深层网络中,实现特征的复用和融合;并通过残差模块进一步深化网络结构,减少模型参数的数量,保证模型检测的准确性和时效性。

密集连接网络由密集模块和过渡层组成,由图3 所示。密集模块中层与层之间的特征关系可以表示为:

图3 密集连接网络Fig.3 DenseNet

其中:[x0,x1,…,xl-1]表示将0 到l-1 层的输出特征图进行通道的合并。此外,过渡层级联多个密集模块,由一个卷积单元和2×2 的平均池化组成,在不同卷积层生成的特征映射之间找到一个有效的组合,降低计算的复杂度。

为了实现通道间的特征加权,确保更多有用的信息被发送到后续层进行进一步的特征提取,挤压和激励网络[21]在2017 年由Hu 等提出。通过学习全局特征,对通道间的卷积特征进行精确建模,重加权特征映射,从而提高了网络的表达能力。SE Block(Squeeze-and-Excitation Block)的引入提升模型对通道的敏感性,聚焦于特征通道之间的关系,根据不同的权重增加对有用特征的关注程度。同时这种方式抑制了对当前任务没有用处的特征,使得在不增加网络深度的前提下提高神经网络实现任务的准确性。SE Block 主要包括两个操作,分别是Squeeze 和Excitation。Squeeze 通过全局平均池化的方式进行特征压缩,得到全局描述特征;随后,对全局特征进行Excitation,学习各个通道之间的关系,通过参数的设置,来为不同特征通道之间生成权重;最后Scale 操作利用Excitation 所获得的结果乘到原始特征上,如图4 所示。

图4 SE Block的基本结构Fig.4 Basic structure of SE Block

因此,本文对Darknet-53 的网络结构进行了改进,改进的主干网络如表1 所示。将叠加残差模块的数量改为5、5、2、2、2,降低模型的运算量。在传输模块中增加了1×1 卷积核。通过改进网络结构,提高目标检测分类速度。同时,利用深度可分离卷积代替普通卷积,显著降低卷积层的计算成本,获得更多的语义信息,提高网络的检测效果。

表1 改进的主干网络Tab.1 Improved backbone network

2.2 改进的FPN

YOLOv3 算法采用FPN 结构,利用多尺度特征映射来进行预测。特征金字塔集成了深浅层特征映射的优点,将低分辨率、语义较强的特征和高分辨率、语义较弱但空间信息丰富的特征进行融合,使用不同分辨率的特征图检测不同大小的目标。然而该结构只包含了单向的特征融合过程,虽增强了语义信息,但对定位信息没有传递,丢失了大量细节信息,难以满足精确的目标定位任务。因此本文改进的FPN 增加了自上而下的特征融合信息流,将浅层的强定位特征传递下去,融合不同层次的特征使提取的特征更加丰富,对提高检测性能,特别是小目标的检测性能非常重要。改进后的特征融合网络如图5 所示。

从图5 可以看出,本文引入了第二个Dense Block 提取的浅层特征信息,并在原YOLOv3 中存在的自下而上的特征融合策略上增加了自上而下的特征融合路径。整体改进的FPN 流程如下:首先,最底层的残差模块(13,13,1 024)提取的特征图首先经过5 次卷积并保留原特征Feature Map1,再进行2 倍上采样和1×1 的卷积扩充通道,和上一个残差模块(26,26,512)进行Concat;经过3 次卷积并保留原特征Feature Map2,随后进行2 倍上采样和1×1 的卷积扩充通道,与上一个残差模块进行Concat;经过3 次卷积并保留原特征Feature Map3,随后进行2 倍上采样和1×1 的卷积扩充通道,与上一个密集模块进行Concat;进行3 次卷积后保留原特征Feature Map4;3 次卷积后进行下采样并与Feature Map3 进行concat,进行3 次卷积保留原特征图Feature Map5;经过一次下采样后与Feature Map2 进行Concat 后进行3 次卷积保留原特征Feature Map6;经过下采样与Feature Map1 进行Concat,进行3 次卷积保留原特征Feature Map7;最后将Feature Map4、Feature Map5、Feature Map6、Feature Map7 送入YOLO Head 得到四个不同尺度的特征预测层。

图5 改进的FPNFig.5 Improvd FPN

2.3 多尺度检测

YOLOv3 算法采用多尺度检测,最终输出三种特征尺度,分别是13×13、26×26、52×52。但当面对尺度较大的目标时,由于小目标的目标区域较小,携带的有效信息在经过多次卷积和下采样后造成信息丢失,最终检测准确率降低。针对此问题,本文在多尺度检测基础上进行改进,通过增加低维的尺度检测来增强对浅层特征的学习能力,由原来的3 尺度检测变为4 尺度检测,添加一个104×104 层,在保留深层语义信息的基础上获得浅层特征信息。低维尺度预测层的加入虽增加了模型的复杂度,在训练时影响了检测速度,但是最终实验结果表明,算法检测的准确率得到了一定程度的提升。

2.4 损失函数的改进

在YOLOv3 算法中,使用均方误差(Mean-Square Error,MSE)作为目标框定位损失函数,但MSE 损失函数易受到目标尺度的影响。交并比(Intersection over Union,IoU)作为目标检测中性能指标常用的函数,在位置回归中,通过比较真实框和预测框框之间的并集和交集之比,达到反映预测框检测效果的目的,且具有尺度不变性的特性,公式如下所示:

但是IoU 也存在一定的局限性。比如,当真实框和预测框没有重叠时,根据IoU 的计算结果定义为0,无法通过IoU来预测两框之间的距离;而且由于损失为0,网络也无法进行梯度回归训练。如图6 所示,三种情况下IoU 是相等的,但是每种重叠的形式是不同的,反映了IoU 不能准确地反映两框之间的覆盖情况的局限性。

图6 IoU相等的三种情况Fig.6 Three scenarios with the same IoU

为了解决此问题,本文采用GIoU 代替IoU 来计算损失函数。GIoU 的计算方式如下所示:

其中:C表示包含A和B的最小矩形面积。根据计算公式,GIoU 与IoU 取值范围不同,IoU 是[0,1],而GIoU 的取值范围是(-1,1]。当两框完全重叠时,最大值为1;当两者之间的距离为无穷大且无交集时,最小值为-1,GIoU 仍然可以计算梯度,在一定程度上GIoU 克服了IoU 作为损失函数的缺点。同时,由于GIoU 不仅关注重叠区域,也关注非重叠区域,因此能更好地反映预测框与真实框的重叠。综上所述,在损失函数中使用GIoU 时,可以达到比IoU 更好的效果,解决了IoU 不能反映重叠方式,无法优化IoU 为0 时预测框的问题,提高算法的检测精度。

3 实验与结果分析

3.1 数据集

Pascal VOC 2007 和Pascal VOC 2012是由Pascal VOC(2005—2012)大赛提供的数据集。比赛的目标主要是图像目标识别,它提供的数据集包含20 种不同的对象。

实验采用Pascal VOC 2007 和Pascal VOC 2012 数据集来进行训练和测试模型的性能。数据集包含20 000 多张图片。为了提高模型的泛化能力,满足对多尺度目标的检测要求,所选数据集的图像中包含尺寸大小不一的目标,其变化程度是不一样的。同时增加COCO(Common Objects in Context)2014 数据集,其包含80 种类别目标。相较于Pascal VOC 数据集来说,COCO 数据集的评估标准更加严格。IoU 从0.5 到0.95 这一区间每变化0.05 就测试一次平均准确率(Average Precision,AP)[22],最后求出10 次测量结果的平均值作为最终的AP。模型使用预先训练过的Darknet-53 的参数为模型特征提取网络的初始化参数。在训练开始时,先冻结一部分进行训练,加快速度,也可以防止在训练初期权值被破坏,初始学习率为0.001,训练140 个epoch,每次传入网络的图片数量为8,解冻后学习率变为0.000 1,传入网络的图片数量变为4,在训练前对图片进行适当的旋转和饱和度变化,以增强训练样本的稳定性,防止过拟合。

3.2 实验配置和评价指标

本文实验所使用的配置环境如表2 所示。

表2 实验配置环境Tab.2 Experimental configuration environment

本文采用平均准确率(AP)[22]、平均准确率均值(mean Average Precision,mAP)、帧率等目标检测常用指标评价模型性能的对比提升。

1)计算某一类别的AP需要绘制出这一类别的PR 曲线以进一步说明其性能,以召回率(Recall)为横轴,准确率(Precision)为纵轴,曲线下的面积即为AP值。准确率和召回率两者的值呈负相关,在局部区域上下波动。公式如下:

在目标检测中,一个模型通常会检测出多种物体,那么多个类别的AP的平均值就是mAP。公式如下:

2)评价目标检测网络检测速度的常用指标是速率,即每秒内可以处理的图片数。

3.3 实验结果

3.3.1 模型训练

评价一个模型的质量不仅需要检测的准确率,而且需要损失函数的收敛速度。当模型的精确度高、收敛速度快时,模型才能对多尺度的目标检测保持鲁棒性和稳定性。本文分别对YOLOv3 算法和基于YOLOv3 改进的目标检测算法进行训练和测试。在整个训练过程中,采用分批随机梯度下降法对函数进行优化。从图7 所示的损失函数可以看出:这两种算法在20 个epoch 之前的损失值都很大,损失值开始呈现下降收敛的状态;随着训练迭代次数的叠加,损失值不断减小,网络不断拟合。与YOLOv3 算法相比,基于改进YOLOv3的目标检测算法在训练过程中更加稳定,损失值的波动范围更小,收敛效果更好。

图7 损失函数Fig.7 Loss function

3.3.2 本文算法与YOLOv3算法实验对比

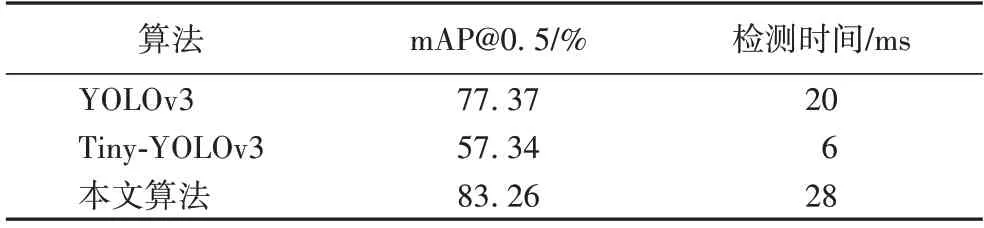

YOLOv3 算法、Tiny-YOLOv3 算法与基于改进YOLOv3 的算法对不同目标检测准确率的对比如表3 所示;不同算法在通用数据集Pascal VOC 数据集上的性能比较以及检测一张图片所用的时间如表4 所示。

表3 不同算法对不同目标检测准确率对比 单位:%Tab.3 Comparison of different algorithms for different objects on detection precision unit:%

表4 三种算法在Pascal VOC数据集上的性能比较Tab.4 Performance comparison of three methods on Pascal VOC datasets

实验结果表明,与YOLOv3 算法、Tiny-YOLOv3 算法相比,基于改进YOLOv3 的目标检测算法的mAP 值分别提高了5.89 个百分点和25.92 个百分点。在目标检测速率分析方面,Tiny-YOLOv3 算法明显高于其他网络,但是其检测精度较低,而本文算法虽检测速率有所下降,但是保证了较高的检测精度。

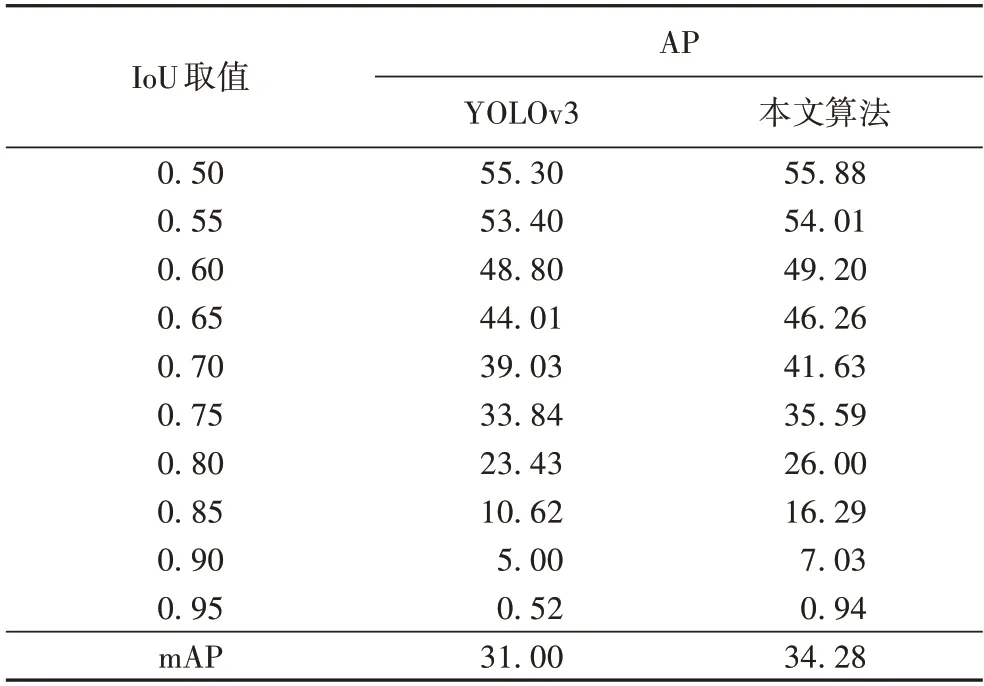

考虑到在COCO 数据集中,需要在IoU 为[0.50:0.95]上10 个取值上计算mAP,最后取平均得到最终结果,因此,COCO 的多IoU 评估方法能够更好地说明算法的检测性能,本文算法在COCO 数据集上的检测结果如表5 所示。实验结果表明,基于改进YOLOv3 的目标检测算法高出原YOLOv3算法3.28 个百分点,检测性能有所提升。

表5 本文算法COCO数据集上的mAP@[0.50:0.95]测试结果 单位:%Tab.5 Detection results of mAP@[0.50:0.95]on COCO dataset unit:%

为了进一步验证实验对不同尺度目标检测的有效性,在Pascal VOC 数据集上对目标尺度进行划分,小尺度目标(尺度大小为(0,110]),中尺度目标(尺度大小为(110,230]),大尺度目标(尺度大小为(230,400]),本文算法对不同尺度目标的检测结果如表6 所示,P-R 曲线如图8 所示。

图8 两种模型对于不同尺度目标的PR曲线Fig.8 PR curves of two models for objects with different scales

从表6 可以看出,本文算法对多尺度目标进行检测的mAP 值分别是75.66%、87.70%、88.19%,和YOLOv3 算法相比,分别提高了6.38 个百分点、5.23 个百分点、3.44 个百分点。实验结果表明,基于改进YOLOv3 的目标检测算法对多尺度的目标有着更好的检测效果。

表6 不同尺度目标的检测结果 单位:%Tab.6 Detection results of objects with different scales unit:%

3.3.3 本文算法与其他算法对比

为了进一步验证本文算法的有效性,将本文算法和其他算法,包括一些典型的算法如两阶段的算法和其他文献[23-24]中的算法进行对比,来测试在同一测试集上改进的YOLOv3 检测性能的提升能力。其中:文献[23]算法中包含了特征提取网络、双向金字塔和损失函数的改进;文献[24]算法中进行的改进包括空洞卷积、引进了Focal Loss 改进损失函数;同时,在其他模型如SSD 模型上,通过增加双向特征金字塔、注意力机制等部分改进来实现对比实验,算法性能结果如表7 所示。

表7 不同算法检测结果对比Tab.7 Comparison of detection results of different algorithms

从表7 的算法检测结果可以看出,所有目标检测算法在使用相同的数据样本及参数进行实验的背景下,本文算法的mAP 值相较于其他算法有所提升,相较于文献[23]算法和文献[24]算法分别提升了5.07%和2.15%。实验结果表明,基于改进后YOLOv3 的目标检测算法有更好的性能。

3.3.4 消融实验结果对比

在验证模型性能的过程中,为了更好地定性定量地研究模型所作出的改进,经常采用“消融实验”来进行对比实验,以便于更好地理解网络中不同模块对于网络检测性能的影响,因此本文设置了四组实验分别进行实验。A 表示将前两个残差模块替换成密集模块,B 表示在残差模块中引入了SE Block,C 表示深度可分离卷积代替普通卷积,D 表示改进的双向的特征融合网络,E 表示优化损失函数。实验结果如表8 所示,其中“√”表示包含所进行改进的模块。

从表8 可以看出:在第2 组实验中,把前两个残差模块更换为密集模块之后,检测精度有所下降,但小尺度检测结果有所提升。第3 组实验增加了SE Block,和第2 组的对比发现,不同尺度目标的检测精度都有所提升,表明增加通道间信息特征的作用是有效的,提高了卷积过程中特征提取的效率。第4 组实验增加了深度可分离卷积,检测精度相差不大,但是运行速度有所提升,相较于原网络更加轻量高效。第5 组增加了自上而下的特征融合路径,虽然增加了一定的参数量导致运行速度略微下降,但是提升了对小目标的检测精度,提升了浅层特征的分类能力和深层特征的定位能力。第6 组增加了损失函数的改进,在几乎不增加参数量的情况下,整体的检测精度有所提升,在一定程度上改善了小目标的漏检,有效避免了当预测区域发生偏离无法进行回归的情况。综上所述,基于改进YOLOv3 的目标检测算法在性能上相比原YOLOv3 算法有了明显的提升,更加适合多尺度目标的检测场景。

表8 消融实验结果对比Tab.8 Comparison of ablation experimental results

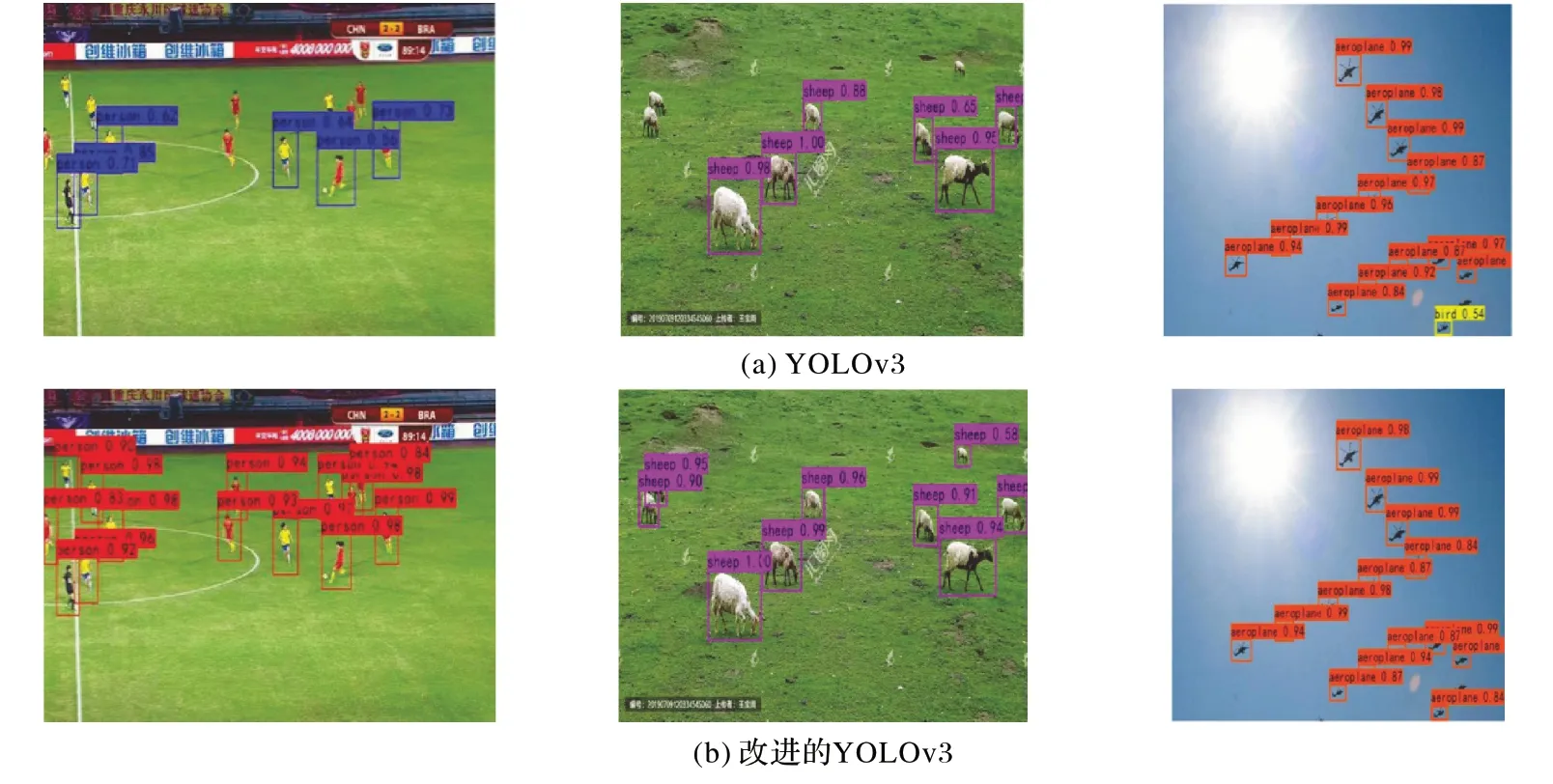

3.4 多尺度目标检测测试

从图9 可看出:原算法基本上存在一些小目标的漏检以及检测精度不高问题;而通过改进模型,改进算法成功检测出了多尺度目标,检测精度也有所提升。

图9 YOLOv3与改进的YOLOv3的多尺度目标检测结果Fig.9 Multi-scale object detection results of YOLOv3 and improved YOLOv3

3.5 小目标检测测试

从图10 可以看出:YOLOv3 算法对图像中的小目标检测结果不理想,容易漏检和误检;改进的YOLOv3 对密集的小目标检测效果更好,能有效解决特征获取困难的问题,降低漏检率和误检率。

图10 YOLOv3与改进的YOLOv3的小目标检测结果Fig.10 Small object detection results of YOLOv3 and improved YOLOv3

4 结语

在多尺度的目标检测任务,针对存在漏检,错检以及重复检测的问题,本文在YOLOv3 算法的基础上进行改进,从网络的特征提取和特征融合能力方面入手,增加密集连接模块,充分利用各层特征,实现各层特征集成,同时增加了一层多尺度预测,提高了网络提取图像深度特征的能力,注意力模块的引入,使有效特征的权值变大,抑制无用特征,对图像进行增强;在特征融合方面,双向金字塔充分利用了多尺度特征,将浅层特征信息和深层特征信息充分融合,降低了目标定位中目标丢失的概率;最后是对损失函数的优化,有效地减少了小目标的漏检情况。定性和定量实验结果表明,基于改进YOLOv3 的目标检测算法具有更好的检测效果,在Pascal VOC 的测试中显示,算法整体mAP 达到83.26%。与传统的YOLOv3 算法相比,本文算法提高了5.89 个百分点,表明检测性能的提高,更好地解决了面对多尺度的目标检测的问题。

在未来的工作中,将对模型进行压缩,其中包括通道剪枝和参数量化等操作,目的是减少参数,提高检测速度,在保证参数数量尽可能少,检测速度尽可能快的前提下进一步提高模型的精度,从而在性能较低的嵌入式设备中获得更好的结果。