回环结构与PAM结合的双目图像超分辨率网络

李 雪,张红英,吴亚东,廉炜雯

1.西南科技大学 信息工程学院,四川 绵阳 621010

2.西南科技大学 特殊环境机器人技术四川省重点实验室,四川 绵阳 621010

3.四川轻化工大学 计算机科学与工程学院,四川 宜宾 644000

视觉信息是人类获取万物信息的主要来源,通过软件的方法提高原始图像分辨率的过程称为图像超分辨率(super resolution,SR)重建,图像超分辨率技术满足了人们观感所需,在计算机视觉领域蓬勃发展。双目图像超分辨率旨在由同一场景下不同视角的两张低分辨率(low resolution,LR)图像重建出高分辨率(high resolution,HR)图像,随着双摄系统在大众生活中的出现,双目图像超分辨率在计算机视觉领域日益广泛应用。由于输入为左右视角的两张LR 图像,使得输入图像之间存在视觉、特征、景深和分辨率等差异,解决这些差异性问题,并充分利用双目图像间有效细节信息优势可以提高超分辨率性能,所以丰富的上下文特征提取与表示研究成为了双目图像超分辨率重建的研究重点。

图像超分辨率的研究从最开始基于插值的方法到现在基于学习的方法经历了飞跃性成就,从人工处理到人工智能、从浅层网络到深层网络、再从深层网络到轻量级网络,图像超分辨率技术为人类科技发展做出了卓越贡献。传统插值方法[1-3]得到的SR 图像过于平滑,丢失了高频细节信息的同时重建出虚假的人工痕迹。基于重构的方法[4-6]研究图像退化模型,图像退化的过程本就是SR 成像的病态逆问题,采样因子的随意性也使得重建的SR图像不能满足人眼视觉需求。基于学习的方法[7-8]是图像超分辨率领域的巨大飞跃,近年来,深度学习的方法成为图像处理研究的代表性方法。SRCNN(super resolution convolutional neural network)的问世也给图像超分辨率研究者奠定了基础;Dong 等[9-10]在SRCNN 的基础上改进得到了FSRCNN(accelerating the super-resolution convolutional neural network),FSRCNN 中的扩张块与收缩块提升了模型的性能与速度。Shi等[11]在ESPCN(efficient sub-pixel convolutional neural network)中提出的亚像素卷积层广泛用于超分辨率网络的重建部分。Tai 等[12]提出的DRRN(deep recursive residual network)结合了Resnet[13(]deep residual network)的多重路径局部残差学习、VDSR[14(]accurate image super-resolution using very deep convolutional networks)的全局残差学习和DRCN[15(]deeply recursive convolutional network for image super-resolution)的多权重递归学习,增加网络深度的同时减少训练参数,达到了理想的SR 性能。SRGAN[16(]super-resolution using generative adversarial network)采用无监督学习方法为LR图像生成更多具有真实感的细节。单幅图像超分辨率在图像超分辨率领域取得了重要成果,但输入为单帧图像也导致重建过程中特征张量缺乏更多的细节信息。

为解决单幅图像超分辨率输入图像细节缺乏的问题,双目图像超分辨率应运而生。双目图像超分辨率在网络输入上比单幅图像超分辨率拥有更多的细节,由于输入是同一场景左右目的图像信息,所以相比视频超分辨率的多输入也能够避免运动模糊和压缩影响等问题。双目图像超分辨率进入深度学习时代是由Jeon等[17]提出的StereoSR(enhancing the spatial resolution of stereo images using a parallax prior)开始的,StereoSR 参照立体匹配的思想,也只是图像像素级别上的位移对齐,并没有充分利用好左右图的信息。Wang等[18-19]提出的PASSRnet(learning parallax attention for stereo image super-resolution)采用视差注意力机制,利用对极几何极线约束提取左右图的特征,并取得优异的成果,次年,他们改进了PASSRnet得到了一个通用的模块SAM(stereo attention module for stereo image superresolution),将其放入单图超分辨率的网络中,有利于提高单图SR 性能。PASSRnet 和SAM 使用3 个卷积核为3×3的具有不同膨胀率的卷积来提取特征,能够很好提取到不同的大特征,当特征映射小于或等于采样率时,3×3卷积核不能很好地捕获上下文的信息,只有滤波器中心用于特征提取工作。

针对双目图像重建网络中特征提取不完整问题,本文提出一种基于深度学习的回环结构与PAM相结合的双目图像超分辨率网络。该网络在特征提取上提出一种MJR-ASPP+(mixed jumping residuals-atrous spatial pyramid pooling+)构成的回环结构,能很好地提取图像中的高低频细节特征,混合跳跃式残差连接相结合的首尾呼应结构可获取最小损耗的同时得到较高精度,从不同的深度操作捕获网络多尺度信息;在特征提取与视差注意力模块中采用扩张残差(expanded residuals,ERes)网络作为过渡块,用来学习双目立体匹配特征的网络能力,以此来缓解其在共享网络ERes与MJR-ASPP+块中的竞争;在双目立体视觉的四个公开数据集中,都取得了优异的SR性能,特别是在Middlebury测试集中,×2放大倍数的PSNR 达到34.67 dB,×4 放大倍数的PSNR 达到28.75 dB。

1 本文网络结构

回环结构与PAM结合的双目图像超分辨率网络由双目立体视觉LR图像对作为输入,并重建出左图(或右图)SR图像。整体网络框架如图1所示,所提网络由特征提取、视差注意力机制和超分辨率重建三部分构成。首先利用权值共享的卷积操作初步提取LR 的浅层特征,通过交替级联的MJR-ASPP+与扩张残差Res1 块进一步提取图像的深层特征;接着将提取的特征张量输入PAM 计算视差图并融合所有特征张量信息;最后利用四个残差块对融合后的特征张量进行卷积操作,经反卷积处理后得到高维张量并通过卷积映射到RGB 空间,得到最终的SR图像。整体网络框架参数设置如表1所示,表中介绍了网络中各模块参数的设置及特征张量输入与输出的通道变换。下面将对网络设计中的各模块及损失函数进行详细说明。

表1 整体网络参数设置说明Table 1 Description of overall network parameter setting

图1 整体网络框架Fig.1 Overall network framework

1.1 特征提取

利用权值共享的卷积网络提取输入LR图像的浅层特征,获取图像中大致概貌和轮廓,得到图像的近似信息。第一层卷积层与第二层残差块的卷积核都为3×3,用每个卷积核去遍历输入双目图像时,卷积核的大小是固定不变的,每个卷积核都会去扫描整张输入的LR 图像,输入图像中所有特征都共享了相同的权值。在卷积神经网络中,利用权值共享卷积网络不仅可以减少神经网络中需要训练的参数个数,使深度学习网络运算简洁高效,也能使网络在大规模的数据集上灵活运算。

在浅层特征的基础上进一步提取输入图像的深层特征,得到图像的边缘、轮廓和细节信息。如图1 整体网络框架所示,本文通过交替级联的回环结构MJR-ASPP+与扩张残差Res1 块进一步提取图像的深层特征,输入特征首先进入回环结构MJR-ASPP+中以生成多尺度特征,接着,这些多尺度特征经过扩张残差块Res1进行特征融合,最后,将回环结构与扩张残差块相结合操作重复两次以生成最终左右图的特征张量。下面对回环结构进行详细介绍。

1.1.1 回环结构MJR-ASPP+

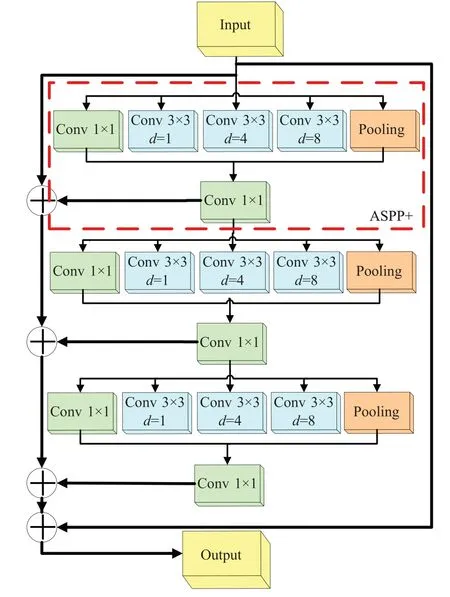

丰富上下文的图像特征提取与表示对超分辨率任务有着重大意义,本文在特征提取部分提出一种混合跳跃式残差空洞空间金字塔池化(mixed jump residualsatrous spatial pyramid pooling+,MJR-ASPP+)的回环结构用于多尺度特征表达,MJR-ASPP+是将ASPP+采用回环结构的方式连接而成,如图2 所示,将三组ASPP+块使用长短跳跃连接的方式,每一块的输出与输入相连,首尾紧扣,形成回环式结构。回环结构能有效捕获图像多尺度特征,相比传统多尺度特征提取网络,回环结构具有以下三个优点:第一,回环结构采用不同卷积核和不同膨胀率的卷积层提取图片中不同层次细节特征的同时,采用全局平均池化层可以有效保留图像背景信息,在整个网络结构上做正则化防止过拟合,赋予每个通道实际的类别意义;第二,回环结构中ASPP+采用残差连接的方式,加深网络深度,使得网络每一条通路都有一个感受野,形成不同感受野和不同膨胀率的卷积集合,从而获取更多细节纹理信息;第三,在残差连接网络中,采用长跳跃连接,将不同层次的特征拼接在一起,达到增加特征多样性、加快训练的目的。下面将具体介绍每一模块的作用。

图2 MJR-ASPP+模块Fig.2 MJR-ASPP+ module

(1)改进空间空洞金字塔池化模ASPP+

图像超分辨率任务的核心是重建出高频细节信息的同时保留低频细节信息,DeepLabV3 工作中Chen等[20]对ASPP(atrous spatial pyramid pooling)进行了改进,改进的ASPP 很好地处理特征映射过大或过小的情况,而在所有的超分辨网络中,第一步是提取LR图像特征,本文将改进的ASPP 思路运用在双目图像超分辨率特征提取与表示这一步骤中,可以使网络获得多尺度的特征表达。本文所提的MJR-ASPP+模块中,ASPP+模块包含一个核为1×1的卷积层、三个核为3×3的卷积层(膨胀率分别为1、4、8)和一个池化层。其中1×1卷积负责提取大范围的图像信息,也能避免因3×3卷积层的膨胀率过大而忽略掉的边界信息;3 个3×3 的卷积层拥有不同的膨胀因子,能够扩大感受野提取到多尺度的图像特征;对特征张量进行自适应平均池化后再通过双线性插值上采样,是从图像级特征出发,获取图像的全局特征。将三者信息进行融合,即可提取到图像的大小局部特征及背景全局特征,也为网络下一层传递了输入图像的高低频多尺度特征,符合超分辨率重建的初衷,所以将改进的ASPP 运用于双目图像超分辨率特征提取部分,在文中消融实验部分也证明了此方法的有效性。

(2)混合跳跃式残差连接MJR

在深度学习网络中,跳跃式连接的方式能很好地解决梯度消失等问题,本文所提的MJR-ASPP+模块,采用长短跳跃相结合的混合跳跃式连接方式来获取图像的多尺度特征。具体为:将三个ASPP+块以混合残差的方式分别级联起来,称为短跳跃式残差ASPP+(short jump residual-ASPP+,SJR-ASPP+),根据梯度链式法则,梯度是从最后一层往前逐层传递回来的,这种残差方式的短跳跃连接相当于是一个深层网络,提取了图像的深层特征;将输入与SJR-ASPP+块的输出结果经长跳跃式(long jump residual,LJR)连接,得到最后的特征张量图。这种混合跳跃式的连接方式从不同深度对图像特征进行处理,根据图像的尺度自相似性,长短跳跃连接能够获取多尺度的图像特征,在本文实验中也证明了混合跳跃式连接使超分辨率网络具有更好的SR性能。

(3)扩张残差模块ERes

回环结构MJR-ASPP+提取的特征张量来自不同感受野和膨胀卷积的集合,为融合多尺度特征,本文将传统的残差块替换为扩张残差ERes块,与普通残差相比,ERes 具有更好的特征提取和综合迭代功能。如图3 所示,ERes 将第一层卷积的输出变为原来通道的2 倍,在最后输出时将通道数恢复为原来的通道数,特征维度的变换有利于图像去噪和多尺度特征的融合,ERes 与回环结构交替级联使网络更加充分地提取与融合图像从浅层到深层的特征信息。

图3 扩张残差模块Fig.3 Extended residual module

1.1.2 FReLU激活函数

本文在特征提取模块提出了一种高效且复杂的回环式网络用于提取图像特征,由于网络结构的复杂性,导致常规卷积无法学习类似的精度,面对网络模型的复杂度,本文用FReLU 替换LReLU。FReLU[21]是专门用于视觉任务的激活函数,增加空间条件来扩展ReLU和PReLU,增强激活空间的敏感度,显著提高图像视觉效果。FReLU 表达式如公式(1)所示,式中T(x)表示高效率的空间上下文提取结构,使用了空间表示信息。FReLU 能自适应地获取ASPP+块中提取到的特征信息,膨胀卷积层和FReLU 激活函数层的结合提高了卷积神经网络(convolutional neural network,CNN)中捕获空间相关性的效率,本文在消融实验中也对FReLU激活函数在网络中的使用进行了验证。

1.2 视差注意力模块PAM

视差注意力模块(parallax-attention module,PAM)是Wang 等在PASSRnet 中提出的一种沿极线具有全局感受野的视差提取模块,巧妙运用对极几何中的极线约束,有效地集成了双目立体视觉LR图像对的有用信息,即双目图像对之间无遮挡的有效区域信息。PAM如图4所示,本文将MJR-ASPP+提取的左右特征张量输入扩张残差过渡块Res2 中,过渡块用来学习双目立体匹配特征的网络能力,以此来缓解其在共享网络中扩张残差块与MJR-ASPP+块的竞争。

图4 视差注意力模块Fig.4 Parallax-attention module

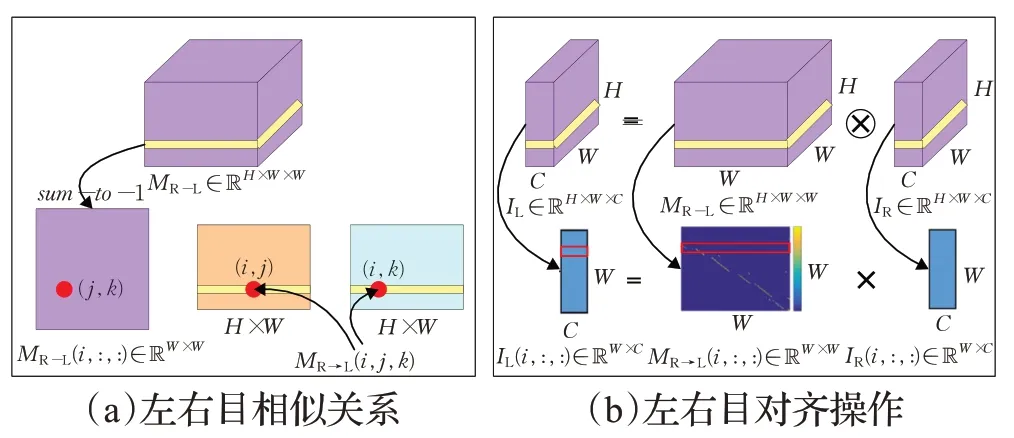

图4 中的视差图ML-R和MR→L描述左右目的相似关系。图5给出了视差图计算的示意图,其中图5(a)为左右目相似关系,(b)为左右目对齐操作。在图5(a)中,MR→L是一个H×W×C三维特征,MR→L(i,j,k)表示沿着i的维度取出切片MR→L(i,:,:)∈ℝW×W,将切片MR→L(i,:,:)∈ℝW×W经softmax函数处理后,水平方向和变为1,切片(j,k)这一点表示右图(i.k)这一点对左图(i,j)的贡献,在真实三维世界中,期望(j,k)的值为1。视差注意力图中的值描述了左右图像素级别的对应关系,利用此对应关系做左右目的对齐操作,称为几何已知的矩阵乘(geometry-aware matrix multiplication)。如图5(b)所示,得到右到左的视差注意力图MR →L后,做右图到左图的对齐操作,从左图IL∈ℝH×W×C中沿H维度取 出 切 片IL(i,:,:)∈ℝW×C,同 理 视 差 图 的 切 片 为MR→L(i,:,:)∈ℝW×W,右图的切片为IR(i,:,:)∈ℝW×C,由图(a)中(j,k)的含义可知,当(j,k)为1时,左图(i,j)点的值对应等于右图的(i.k)点,从亚像素的层面讲,当(j,k)为0.5 时,是将左右图两个像元按50%的贡献值混合在一起。由于采用矩阵乘的方式得到视差图,所以不用单独计算出每点的视差值,左右视差图就能很好地得到左右目的对应关系。

图5 视差图计算Fig.5 Disparity map calculation

1.2.1 一致性

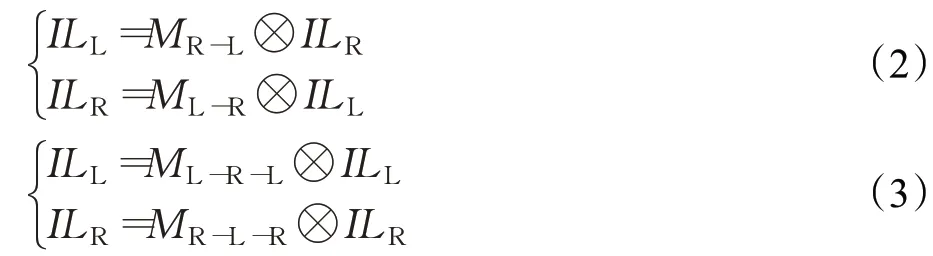

由对极几何极线约束,左图中的一点a,在右图中一定在点a所在的那一行里。左右目图像进行对齐操作时,假设ILL与IRR是从低分辨率图像对中提取出的深层特征,PAM 生成视差注意力图MR-L和ML-R,理想情况下,左右图的对应关系可得出如公式(2)所示的左右一致性原理,右到左视差图MR-L乘以右图ILR可以得到左图ILL,同理得到右图ILR。进而得到循环一致性如公式(3)所示,其中,ML→R→L表示左图到右图再到左图的视差图,⊗表示批次化矩阵乘。

其中:

1.2.2 有效掩码

视差注意力图不仅描述左右图的相对信息,还能描述左右图之间的遮挡信息。在遮挡范围内,赋予像素极小的权重值,如公式(5)所示,当ML→R(i,j,k)或MR→L(i,j,k)的值小于0.1时,认为像素在对应图中是被遮挡的,本文采用形态学的操作来处理遮挡区域。

1.3 超分辨率重建

如图1 整体框架图中③超分辨率重建模块所示,本文采用四个残差块的目的是对融合后的左右图特征张量进行多卷积操作,得到高维特征张量,有利于反卷积处理;此外,残差块除了能减弱梯度消失外,还是一种自适应深度操作,多个残差块级联起到直接信息的传递作用。本文在消融实验部分证明了选用四个残差块能更好提升网络的整体性能。残差块中采用FReLU作为激活函数,反卷积采用Shi 等[11]的sub-pixel 上采样对高维特征进行操作,避免上采样时出现人工痕迹等不真实的信息。最后利用卷积将特征图映射到RGB 空间,得到最后的超分辨率左图或右图。

1.4 损失函数

为了训练回环结构与PAM结合的双目图像超分辨率网络,本文充分利用双目图像对之间的一致性原理,采用公式(6)所示的损失函数,该损失函数由超分辨损失LSR、照度损失Lphotometric、平滑损失Lsmooth和循环一致性损失Lcycle构成。

LSR为超分辨率中的均方误差(mean squared error,MSE)表示,其表达式如公式(7)所示,它衡量原始的HR图像IHR与重建出的SR图像ISR间的差异性,其中‖ · ‖2是2范数。

对图中的非遮挡区域引入照度损失Lphotometric,如公式(8)所示,其中p表示具有有效掩码遮挡值的像素,‖ · ‖1是1 范数。视差图MR-L与ML-R反映左右图与之间的对应关系,采用视差图计算照度损失可以使其更好地表示左右目图像之间的左右一致性。公式中可看出,视差注意力图与右图(左图)批次化矩阵乘后方可得到左(右)图。

为了在无纹理或弱纹理区域生成准确一致的视差注意力图,本文在视差图上采用公式(9)所示的平滑损失Lsmooth。该等式的两项因式分别代表视差注意力图中的垂直一致性与水平一致性。

为了使用循环损失体现视差注意力图的循环一致性,本文采用公式(10)所示的循环一致性损失Lcycle,由该式可知左图(右图)经过两次注意力图的映射后,将得到左(右)图本身。其中MR-L-R是单位矩阵。

2 实验结果与分析

本章将详细介绍具体实验操作与实验结果,首先介绍实验的数据集与实验的预处理细节,接着通过消融实验测试本文提出网络的有效性,最后将实验结果与典型的超分辨率算法比较,进一步验证本文方法的SR性能。

2.1 数据集

为验证实验过程的一致性与准确性,本文采用与PASSRnet网络同样的数据集。在训练集上使用该团队收集的Flickr1024数据集中的800张训练集和双目立体视觉公开数据集Middlebury 中的60 张训练图片。将860张HR图片进行2倍和4倍下采样,得到本文网络最终的训练数据集,并将LR 图像对和相应的HR 图像对送入网络进行有监督训练。考虑到测试集的选取要遵循景物的多样性、视差变化的灵活性、景深的可对比性等必要条件,按照PASSRnet的实验数据准备,本文也相应选取了Middlebury 测试集中的5 幅图像、KITTI2012测试集中的20 幅图像、KITTI2015 测试集中的20 幅图像和Flickr1024 测试集中的112 幅图像作为测试集,同样对测试集进行2倍或4倍下采样。

2.2 实施细节

本文实验在Nvidia GTX 2060 GPU 上进行,在Pytorch网络框架上实现,使用Adam方法对网络模型进行优化,其中,Bach size设置为40,初始学习率为0.002,每30 个Epochs 后降低一半,训练在90 个Epochs 后结束,因为更大的Epochs对SR性能影响不大。

在训练阶段,首先对双目HR 图像进行双三次插值下采样,生成对应的LR 图像对;然后对生成的LR 图像进行预处理,将其裁剪为30×90 个步长为20 的图像块,它们在HR图像中对应的图像块也被裁剪出来,水平块的大小慢慢增加到90 以避免训练集中图片的大小差异;最后为了增加训练集的样本数量,对裁剪出来的图像块进行平移和旋转。本文采用峰值信噪比(peak signal-to-noise ratio,PSNR)和结构相似性(structural similarity,SSIM)指标来评价测试图片的SR性能。

2.3 消融实验

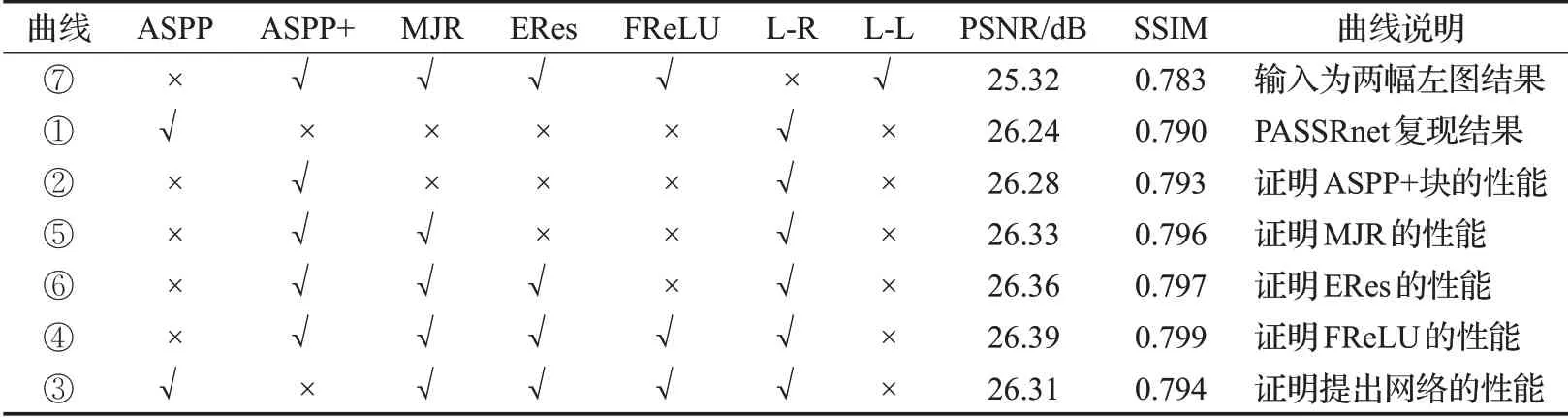

本节对消融实验进行介绍,以证明本文网络的设计与选择,消融实验在KITTI2012和Middlebury测试集上实现,采样因子为4倍,图6训练曲线显示了80个Epochs的训练结果,具体实验环节与实验结果如表2、图6和图7所示。

表2 消融实验各环节与测试结果Table 2 Ablation study and test results

图6 消融实验训练结果Fig.6 Ablation study and test results

图7 网络重建部分的残差块个数Fig.7 Number of residual blocks in network reconstruction

表2为消融实验各环节与KITTI2012测试集的实验结果,图6 是消融实验训练时的Loss 值与PSNR 值。图6中曲线①是文献PASSRnet的复现结果,曲线②是使用ASPP+后的结果,从结果可以看出在原本的ASPP块中增加了1×1卷积层和池化层后,PSNR提升了0.04 dB,因为本文改进的ASPP+模块能够获取更完整的感受野,达到了丰富的多尺度特征提取与表达的效果。在ASPP+的基础上,继续调试本文网络,首先对残差ASPP+添加长跳跃残差连接,使整个ASPP+模块通过混合跳跃残差连接的方式传递不同深度的信息,如曲线⑤所示,对比曲线②的实验结果,采用混合跳跃式残差连接的ASPP+块在最后的网络重建结果优于曲线②。接着扩张残差使用在本文网络的特征提取和视差注意力机制上,曲线⑥中PSNR 值比曲线②提高了0.08,是因为扩张残差可以起到很好处理网络中图像噪声和平缓网络模块间权值共享的作用。最后,在本文提出的多尺度特征表示网络上进行超参数的改进,替换ReLU 函数为FReLU,得到本文最终的SR 重建方法,曲线⑦无论在训练中还是测试中都达到了最优的效果。为了证实本文网络的有效性,去除PASSRnet 网络的ASPP 块,其他网络连接方式都与本文一致,相比曲线③和曲线②可以看出,采用混合跳跃式残差连接方式和FReLU 函数对网络也有一定帮助。此外,本文还对输入为两张一样的图像进行实验,结果可以看出曲线⑦得到的结果并不理想。

图7 是本文在网络重建部分使用残差块个数在Middlebury 测试集上的PSNR 结果,由图中曲线可以看出残差块的个数越多,图像的PSNR 值越高,特别是在曲线前半部分,每增加一个残差块,PSNR 值就提升0.1 dB左右,但当残差块的个数增加到四个之后,PSNR结果提升只有0.014 dB 左右,根据网络模型大小和SR性能提升综合考虑,在网络重建部分采用四个残差块最为适宜,实验结果也表明在超分辨率重建部分选取四个残差块能提升网络的整体性能。

综上,消融实验验证了本文多尺度特征表示的双目图像超分辨率重建网络设计与选择的意义,消融实验中也看出了MJR-ASPP+块、混合跳跃式残差、扩张残差、FReLU函数和重建使用四个残差块能更好提升网络的SR性能。

2.4 本文网络参数规模分析

本文网络参数模型分别从参数数量Params、理论计算量FLOPs(floating point operations)、PSNR 和SSIM四方面来分析,测试结果在Middlebury 数据集中实现,具体分析结果如表3 所示。首先是对本文网络自身的参数规模进行分析,去除本文网络中的MJR-ASPP+块和PAM 块对于本网络来说虽然参数量和计算量降低了,但总体SR性能也跟着降低;然后对比双目图像超分辨率重建的两个典型方法,本文网络参数量比StereoSR降低了0.38×106,计算量降低了0.329 GFLOPs,PSNR增加了2.01 dB,SSIM提高了0.011,取得了优异网络性能,但对于PASSRnet 结果,虽然模型的参数量与计算量相对高一点,但最终也达到了更好的SR 性能。针对模型参数规模分析,本文的下一步工作也将沿着轻量级网络发展,在降低模型计算量的同时取得良好的SR性能。

表3 网络参数规模分析结果Table 3 Results of network parameter scale analysis

2.5 对比实验

对比实验选取Flickr1024、Middlebury、KITTI2012和KITTI2015四个双目立体图像公开数据集,与代表性单幅和双目图像超分辨率重建方法作对比,代表方法有SRCNN、VDSR、DRRN、StereoSR、PASSRnet,实验结果如表4所示。表4实验对比结果是对四个公开数据集图片结果进行平均值比较,从表中可以看出MJR-ASPP+在×2 或×4 的采样因子中都取得了最好的结果,在Middlebury 数据集中,×2 的PSNR 相比PASSRnet 提高了0.62 dB,×4 的PSNR 提高了0.17 dB;在KITTI2015 数据集中,×2 的SSIM 相比PASSRnet 提高了0.011,而×4 的SSIM提高了0.015。

表4 数据集实验对比结果Table 4 Experimental comparison of data sets

图8 和图9 的实验结果分别为放大4 倍和2 倍的重建结果,选取Flickr1024 测试集中0031、0089、0107 和Middlebury中的motorcycle图像,本文MJR-ASPP+网络重建出的图像在评估和视觉效果上都取得了较好的性能,其中,×4放大倍数的两幅图像的PSNR对比PASSRnet 分别提高了0.15 dB 和0.22 dB,×2 放大倍数的两幅图片PSNR分别提高了0.33 dB和0.75 dB。从视觉效果上看,图片0089 解决了PASSRnet 重建后出现的噪声,整体细节轮廓清晰了许多,如左上角白色弧线边缘恢复的更连续,台阶分割线也更加分明,右下三角阶梯上的高光和阴影部分也更加接近原始图像;图片0107 恢复的细节信息更平滑,如左侧蒲公英树干上的纹理细节要比几种典型方法清晰,蒲公英上的绒毛部分PASSRnet和本文方法都恢复出了根根分明的效果,但本文方法恢复的绒毛边缘信息更丰富;图片0031 中字母和两边线条的轮廓信息相对PASSRnet 要更明显,且恢复出的色彩信息更接近原始图像;本文方法在图片motorcycle中完整地恢复出了车的凹槽部分,其中在车轮与地面的分界部分,本文方法避免了PASSRnet中产生的噪声颗粒,在车轮上的细节纹理部分,本文方法比原有的典型算法恢复出了更多的细节信息,特别是左下角磨损部分,也能很好地凸显车轮的凹凸信息。

图8 实验对比结果(×4)Fig.8 Experimental comparison results(×4)

图9 实验对比结果(×2)Fig.9 Experimental comparison results(×2)

本文网络采用回环结构MJR-ASPP+提取图像多尺度特征,使图像在重建后能完整恢复出物体边缘轮廓信息,同时也能恢复出图像中大部分细节纹理信息,在计算机视觉领域中,图像中的轮廓边缘信息用于区分物体间的差异,反映物体的位置信息,而图像中的细节纹理信息则反映物体的主要信息,这两种信息为图像分割、目标检测、机器视觉和模式识别等任务奠定基础。

3 结束语

双目图像超分辨率在计算机视觉领域有着重要的应用前景,在超分辨率重建技术中,输入为同一场景的两张图像相比单帧图像拥有更多的细节信息,且相对多输入的视频图像超分辨率可以避免运动模糊和噪声影响等优势。如何充分利用好双目图像左右图的细节信息成为双目图像超分辨率重建的重难点,针对双目图像丰富上下文的特征提取与表示问题,本文提出一种多尺度特征表示的双目图像超分辨率重建方法,采用MJRASPP+模块和扩张残差对图像进行特征提取,在整个网络框架中使用FReLU 激活函数,并在比较四个公开数据集的实验结果中,均达到了最优的效果,从而也进一步证实了本文多尺度特征表示网络框架的优异性能。

本文提出的多尺度特征表示网络虽然在轮廓信息重建上取得了很好的效果,但在细节纹理增强上还需深入研究。在接下来的工作中,将继续沿着双目图像间信息提取和视差注意力机制方面内容,解决双目图像细节纹理恢复不明显和视差变化影响大等问题;并进一步轻量化网络,使网络提高超分辨性能的同时,减轻内存消耗。