整体与局部相互感知的图网络时序动作检测

黄金钾, 詹永照, 赵逸飞

(江苏大学 计算机科学与通信工程学院, 江苏 镇江 212013)

随着近年来智能手机摄像设备的普及和通信传输速率的飞跃,视频已成为人与外界信息交互的重要媒介,在抖音、小红书、bilibili等各类视频平台上人们随时随地用视频记录和分享生活日常,各类视频数据呈井喷式增长,因此对视频数据的分析成为热点研究问题.其中针对视频中人类行为理解的动作识别[1]和时序动作检测[2]算法需求巨大,在安防、技能评估、视频摘要、自动驾驶、人类行为分析[3]等多个领域有着广泛应用前景.动作识别依赖于对剪辑的视频进行模型训练,人工对未剪辑的长视频进行修剪费时费力,已很难满足实际应用的需要,近年来针对未剪辑长视频时序动作检测的研究越来越受到重视[2,4-6].

时序动作检测不仅要对动作进行分类,还要定位出每个动作实例的开始和结束时间.目前时序动作检测方法多套用目标检测领域方法的两阶段框架[4]模式:先通过提案生成网络产生一系列时序动作提案,再对每个动作提案单独地执行分类和时序边界回归.然而,这种单独地处理每个动作提案、仅依靠单一提案的信息进行动作实例识别的方式忽视了视频中提案之间十分丰富的时空关系信息,因此在获取上下文和定位多种不同时间尺度的动作方面存在困难,不利于精细化地在视频中定位和识别动作.文献[7]表明,借助视频段之间相关的关系信息能显著提高机器对日常生活中人类行为的认知.在视频中,提案间存在联系,蕴含着关于某一类特定动作的相关信息[8],如果充分利用好这些视频域中提案之间十分丰富的时空关系信息,就能够为动作实例的识别提供更多线索,带来检测性能的增益.

如今也有一些方法参照语言翻译[9]和目标检测[10]的工作对提案之间的关系加以利用,采用自注意力机制[9]捕获提案之间成对的相似性,建模提案之间的交互关系.此种方式通过自注意力将提案信息与自动学习得到的融合权重聚合,汇集到每个提案.由于需要对视频中可能包含的数千个提案对进行查询,计算代价十分昂贵.相反,图卷积网络(graph convolutional network, GCN)[11]仅从相邻节点聚合信息影响每个节点,显著减少了计算复杂度.图卷积网络很适合用于挖掘视频段之间的关系,在许多任务的关系推理中表现出良好的效果.同时,提案的整体和局部关系信息存在内在的语义联系,当前整体与局部相互感知的时空关系信息的综合应用在动作检测与定位中还未见涉及.

基于以上考量,提出整体与局部相互感知的图网络时序动作检测方法,更好地发挥图卷积网络的优势,以综合利用提案整体与局部的时空关系信息.针对目前存在的上下文信息采样范围仅限于局部区域造成的难以获取完整上下文信息问题,单独地识别每个提案带来的检测性能不足问题,该方法通过关系注意力[8]增强提案特征,综合利用各动作提案的特征相似性和时序重叠度构建提案整体关系图推理子网络,学习获得提案更丰富的整体时空特征表示;针对如何在多尺度上定位动作,同时获取长距离上下文信息以增强相应局部特征问题,该方法利用提案发生的时间偏序关系,构建多个级别多个三体相似图和三体互补图的提案局部关系图推理子网络,学习获得不同时间尺度下提案的局部关系信息;最后,构成提案整体与局部关系相互感知的丰富特征表达,用于动作检测与定位.

1 相关工作

1.1 时序动作检测

时序动作检测方法包括动作候选提案生成和动作分类决策2个步骤.目前时序动作检测方法大多是对目标检测方法思路迁移,即先检测帧中对象,后进行动作分类和时序综合[12].拓展目标检测形式改进的方法优点是具有一定的动作解释性,但动作的时序性特征未能准确获取,不利于整个视频中多个动作的关系表达.这类方法主要利用视频的单个提案进行时序动作检测,因此对长视频中时序跨度较大动作序列检测定位的准确性不足.

1.2 图卷积网络

自从T. N. KIPF等[11]提出了图卷积网络以来,越来越多的工作结合图卷积网络有效解决了视频理解领域的问题.图卷积网络能够捕捉样本之间丰富的关联信息,它通过从相邻的节点聚集信息从而影响图中每一个节点,能够有效挖掘提案之间的语义关系.基于图卷积网络结构,YAN S. J.等[13]提出了一种时空图卷积ST-GCN从骨架数据中学习空间和时间模板.YANG J. W.等[14]使用注意力图卷积网络,有效捕获对象和关系之间的上下文信息.ZENG R. H.等[15]提出采用图卷积网络挖掘动作提案之间的时序关系.周航等[16]提出时空融合图卷积网络,构建空间相似图和时间连续图进行自适应加权融合,形成时空融合图卷积网络,有效地学习了生成视频特征.文中改进文献[15]中的GCN网络结构,通过挖掘提案整体与局部关系的丰富特征表达,有效提高动作检测与定位的准确性.

2 方 法

2.1 总体框架

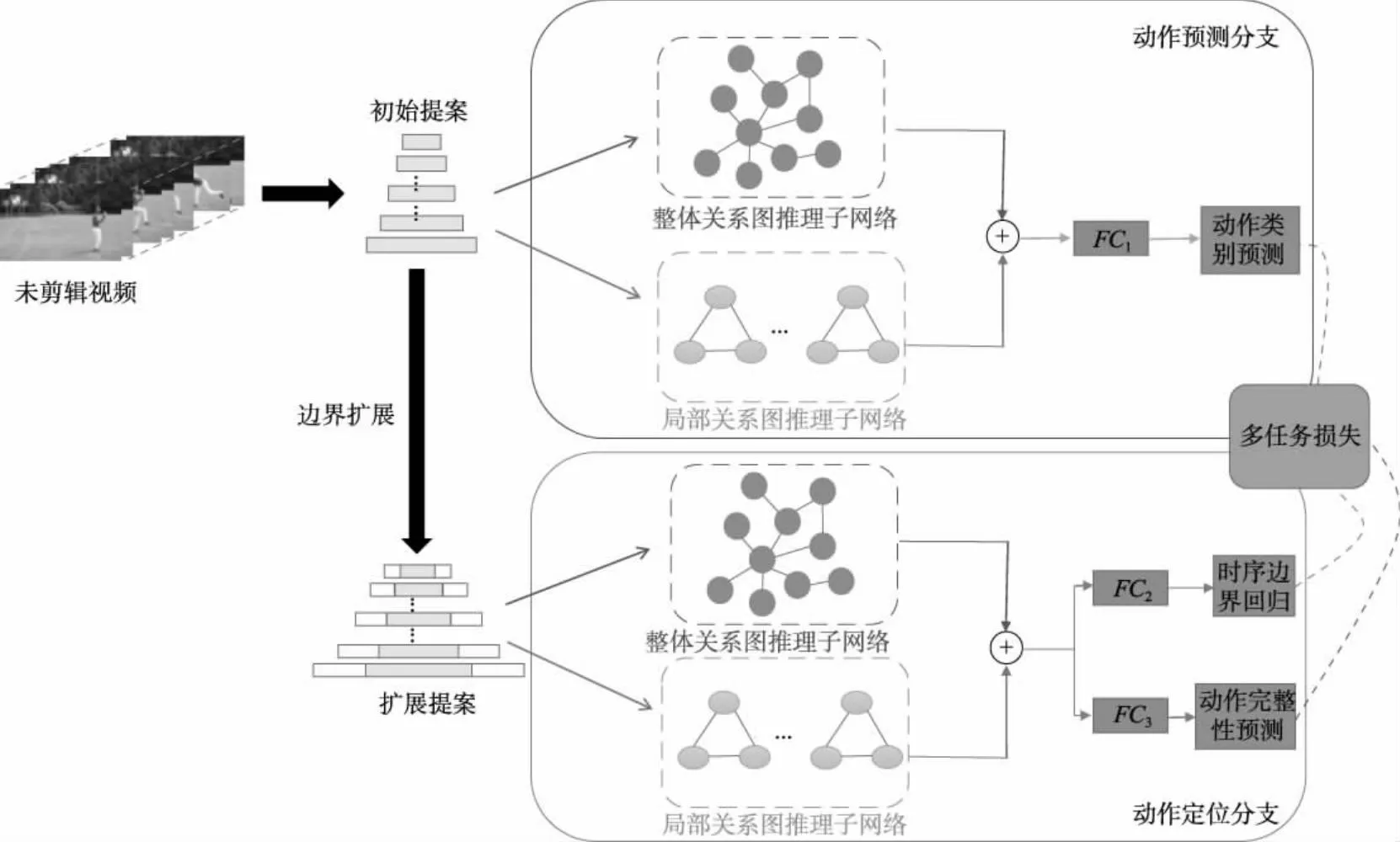

目前动作提案检测与定位缺乏整体与局部相互感知时空关系的综合利用,限制了动作检测与定位的性能提高.因此提出整体与局部相互感知的图网络时序动作检测方法,该方法包含整体与局部时空关系推理的动作检测与定位两路分支,一路用于动作检测分类,另一路用于动作检测定位.该方法预先通过BSN[17]提案生成方法获得动作提案,在动作检测分类分支中,通过关系注意力[8]得到关系增强的提案特征,综合利用各提案的特征相似性和时序重叠度构建提案关系图,形成提案整体关系图推理动作检测子网络,学习获得提案更丰富的整体时空特征表示;同时利用提案发生的时间偏序关系,依据提案顺序和间隔尺度,构建多个级别多个三体相似图和三体互补图,形成提案局部关系图推理动作检测子网络,学习获得不同时间尺度下提案的局部关系信息;最后,融合两个子网络输出的提案整体和局部时空关系信息,构成提案整体与局部关系相互感知的丰富特征表达,以期提高动作分类检测的准确性.在动作检测定位分支中,从各动作提案的首尾扩展动作时序边界,形成动作提案的扩展特征,同样通过构建提案整体与局部关系图推理两个定位子网络,学习用于动作定位的整体与局部关系相互感知的更丰富特征表示,以促进更准确的动作定位.总体框架如图1所示.

图1 整体与局部相互感知的图网络框架

2.2 特征提取与动作初始提案生成

采用I3D[18]提取视频各片段特征,利用BSN[17]从未剪辑长视频生成动作初始提案P={pn|pn=(zn,(tn,s,tn,e)),n=1,2,…,N},式中:tn,s和tn,e分别为动作提案的开始和结束时间;zn∈Rd为经I3D[18]网络从tn,s到tn,e之间的视频帧中提取得到的特征;N为提案的个数.利用动作初始提案进行整体与局部时空关系推理的动作检测与定位.

2.3 整体与局部时空关系推理的动作检测

为了获得更丰富的动作时空关系特征表达,在动作检测分支中,将初始特征zn作为输入,建立动作整体时空关系图推理子网络和局部时空关系图推理子网络,以实现更准确的动作检测.

2.3.1整体关系图推理子网络

考虑到目前上下文信息采样范围仅限于局部区域造成难以获取完整上下文信息的问题,将关系注意力加权引入图卷积网络中,学习时序相邻提案特征的相似性获取完整的上下文信息,以增强特征的表达能力,构建整体时空关系图推理子网络,学习提案间的整体时空关系,其具体结构如图2所示.

图2 整体关系图推理子网络结构

2.3.1.1关系注意力加权

深挖提案之间的整体时空关系,自适应地从时序相邻的提案中寻找与之关联的信息,对提高动作分类检测性能十分重要.采用类似文献[8]的关系注意力加权方法,将多个提案的关系注意力加权来获得各提案特征信息,以增强提案特征之间的时空关系.第n个提案的输出特征可以由嵌入子空间中所有输入提案特征的关系注意力加权得到.关系注意力加权后的提案特征表达为

(1)

式中:ψ(·)为成对特征的关系注意力权重;φ(·)为输入特征转化到嵌入子空间的特征;函数φ(·)设计为φ(zm)=WVzm,其中WV作为线性嵌入矩阵,由1×1卷积实现.

成对的关系注意力权重由两个特征之间的相似度确定,可使用softmax形成量纲一化的权重值:

(2)

式中:S(zn,zm)为特征之间的相似度,计算式为

(3)

式中:WQ和WJ为2个提案的网络参数矩阵.

2.3.1.2整体关系图构建

(4)

(5)

图GG所有边权重组合成的邻接矩阵表示为

(6)

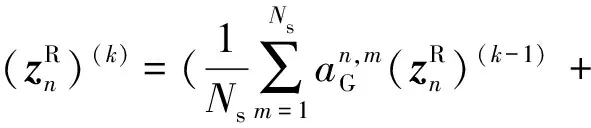

完成整体关系图GG的构建之后,特征被送入K1层的图卷积网络以抽取整体时空关系信息,经过第k层(1≤k≤K1)整体关系图推理的特征表示为

(ZR)(k)=AG(ZR)(k-1)W(k),

(7)

式中:AG为邻接矩阵;W(k)∈Rdk×dk为训练得到的参数矩阵;(ZR)(k)∈RN×dk为第k层所有节点的特征.采用类似文献[15]的SAGE采样方法,逐层对每个节点的邻域进行采样,设Ns为采样节点数目,汇集邻域聚合而来的带有关系信息的特征:

(8)

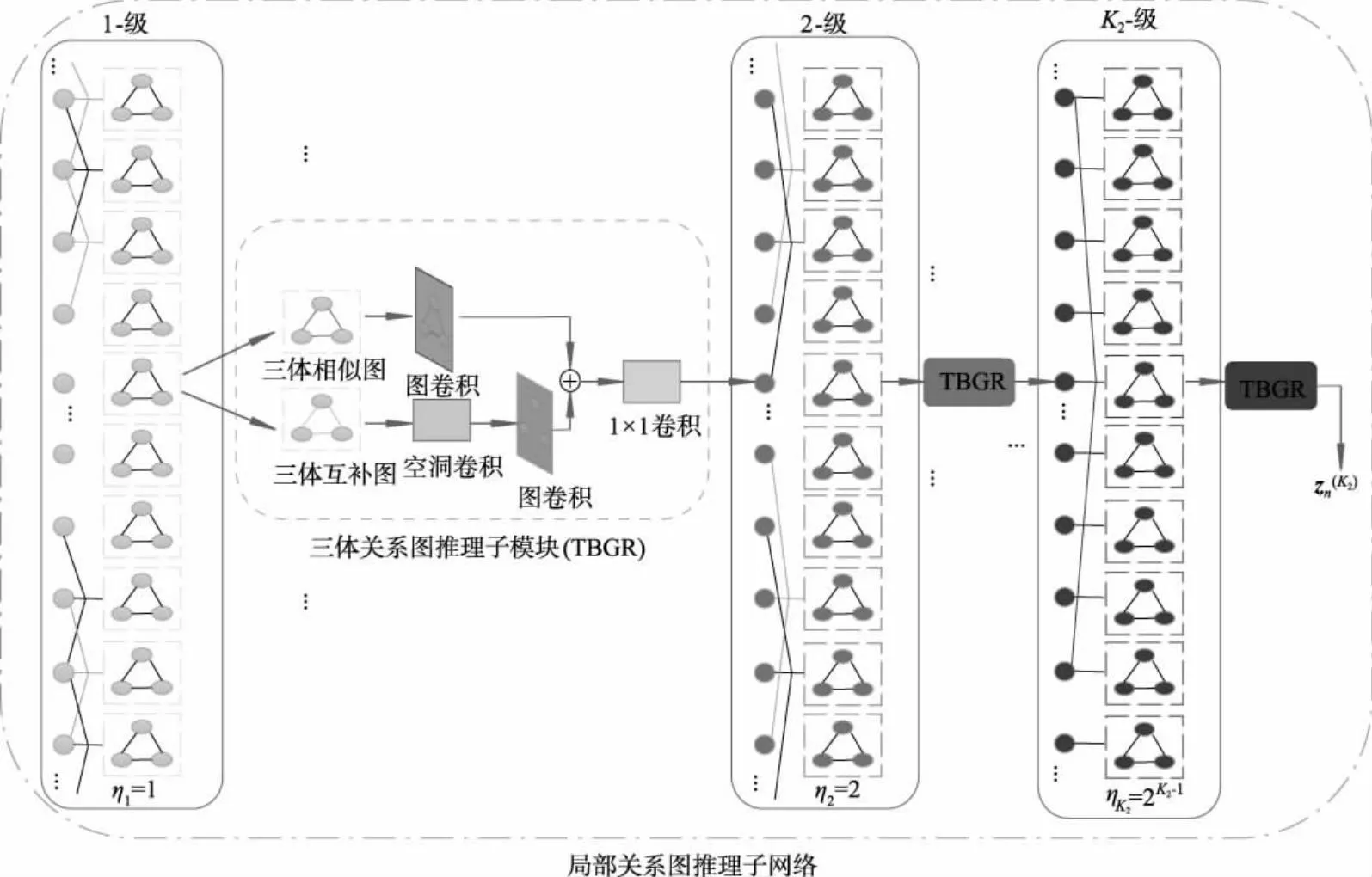

2.3.2局部关系图推理子网络

考虑到时序动作检测中存在的多尺度问题,视频时序的变化范围大,一个动作的持续时间可能在几秒到几分钟之间,导致时间段的范围与anchor的跨度不能很好对齐,提出一个局部关系图推理子网络,构建多级迭代的图网络结构,并使用空洞卷积扩大感受野,以获得多时间尺度的局部时空关系信息.文中利用提案发生的时间偏序关系,依据提案顺序和间隔尺度,构建多个级别多个三体相似图和三体互补图.

提案之间的关系表示为图上的边,对每一级的提案节点,关联其间隔尺度邻域节点.随着网络级数的深入,使之对应的空洞系数随指数增长,时间尺度也发生相应变化,从而学习不同时间尺度下提案的局部时空关系,其具体结构如图3所示.

图3 局部关系图推理子网络结构

(9)

(10)

(11)

(12)

式中:W(k)∈R1×d×d表示卷积核大小为1的一维卷积层的权重矩阵.

2.3.3动作检测

将整体时空关系特征与局部时空关系特征相融合,有效捕获视频中的短距离和长距离时空关系,得到整体与局部相互感知的关系感知特征为

(13)

(14)

2.4 整体与局部时空关系推理的动作定位

(15)

(16)

(17)

2.5 训练与损失函数

文中以端到端的方式结合多种损失函数训练整体与局部关系图推理子网络,两个子网络共享训练参数,通过联合优化动作分类检测、动作完整性回归、时序边界回归,联合训练多任务损失为

(18)

3 试验结果分析

3.1 数据集和性能指标

Thumos14[19]数据集的训练集、验证集、测试集分别包含13 320个已剪辑视频、1 010和1 574个未剪辑视频,涵盖20个动作类别,该数据集的难点在于单个视频包含时间跨度不一的动作实例.文中采用验证集中200个带有时序标注的视频进行训练,采用测试集中213个带有时序标注的视频进行评估.

ActivityNet1.3[20]是一个大型数据集,包含19 994个未剪辑视频,涵盖200个动作类别,按2 ∶1 ∶1的比例分为训练集、验证集和测试集,视频的总持续时间为648 h.文中采用训练集中9 338个带有时序标注的视频进行训练,在验证集中4 578个带有时序标注的视频上进行评估.

在性能指标方面,文中使用平均精度均值mAP作为评估指标,认为提案与真实标注的时序交并比大于tIOU阈值且检测类别与真实类别相同时的检测值正确.在Thumos14上,tIOU阈值从{0.1,0.2,0.3,0.4,0.5}中选择;在ActivityNet1.3上,tIoU阈值从{0.50,0.75,0.95}中选择;以0.05为步长,计算了0.50到0.95之间对应tIoU阈值的mAP.

3.2 试验细节

由于视频动作的时间尺度差异性较大,对视频进行分段处理,划分成无重复区域的连续64帧视频段.利用在Kinetics上预训练好的I3D[18]网络提取段级特征,对片段内得到的所有特征块进行最大池化处理,得到多个1 024维的特征.特征经过BSN[17]网络生成1 024维的初始提案特征,并进一步扩展得到3 072维的扩展提案特征.整个模型根据作用和输入特征的不同分为动作检测分支和动作定位分支,每个分支包含结构相同的整体关系图推理子网络和局部关系图推理子网络.在整体关系图推理子网络中,动作检测分支关系注意力模块中3个1×1卷积的维度分别采用64、64、1 024维,动作定位分支采用64、64、3 072维.图卷积网络采用2层GCN,K1=2层,动作检测分支每层维度分别采用512、1 024维,动作定位分支采用512、3 072维.在局部关系图推理子网络中,采用K2级网络结构,层级参数K2值由下节对比试验选定,每级包括1个一维空洞卷积、2个图卷积和1个1×1卷积.训练阶段,进行Ns为4的邻域采样,采用SGD优化算法,RGB流初始学习率设置为0.001,光流设置为0.01,学习率每15个epoch衰减为原来的10%,dropout值设置为0.8.在输入训练样本时每次迭代的批量数为32批,共70个epoch,损失函数参数设置λ1=λ2=0.5,λ3=0.2.测试阶段,采用动作分类得分和完整性得分计算mAP,采用非极大值抑制(NMS)去除冗余检测结果,RGB和光流的检测结果通过2 ∶3的比例融合.试验参数设置与PGCN[15]保持一致,保证了试验的公平性.

3.3 层级参数K2的选择试验

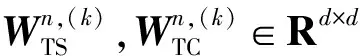

局部关系图推理子网络采用了多级迭代的图网络结构进行关系推理,为了实现对层级参数K2取值的最优选择,按照表1在Thumos14数据集上对不同K2值进行了选择试验.

表1 K2的参数选择试验结果 %

由表1可见,当网络层数取7层时达到了最好的检测精度效果,网络层数从1层开始逐渐增加到7层时,检测精度呈提升趋势,当网络层数超过7层,检测精度呈下降趋势.当网络层数过少时,网络的感受野不足,不利于模型特征学习,当网络层数过多时,模型过于复杂,而对学习的效果提升不明显.结合参数选择试验,文中层级参数K2取值7层,构建7级的局部关系图推理子网络结构.

3.4 试验结果对比分析

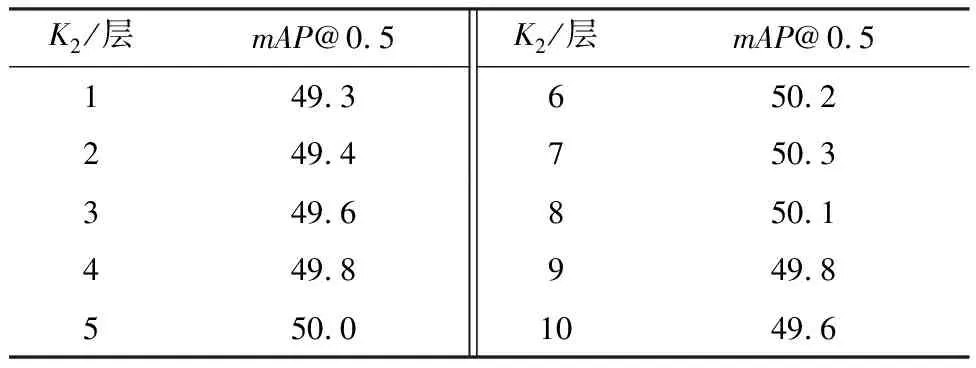

表2为在Thumos14数据集上文中方法与先进方法在tIoU阈值取值为0.1到0.5的mAP结果.

表2 Thumos14数据集上mAP的试验结果

由表2可见,文中方法在各阈值上mAP都达到最高,表明文中方法达到了SOTA的性能水平.特别是在tIoU=0.5条件下,文中方法的动作检测mAP达到了50.3%,比S-CNN[2]、CDC[6]、SSAD[5]、TURN[21]、R-C3D[22]、SS-TAD[23]、CBR[24]、BSN[17]、G-TAD[25]、TAL-Net[4]、PGCN[15]分别增加31.3%、27.0%、25.7%、24.7%、21.4%、21.1%、19.3%、13.4%、10.1%、7.5%、1.2%,以上结果表明文中方法可以更准确地检测未剪辑视频中的时序边界.

表3显示了在ActivityNet1.3数据集上文中方法与先进方法在不同tIoU阈值的mAP结果.

由表3可见,对于在0.50到0.95之间tIoU阈值求得的mAP而言,文中方法在这种高阈值条件下的平均检测性能达到了SOTA的性能水平,其动作检测mAP达到了28.11%,比R-C3D[22]、B.SINGH等[26]、TAL-Net[4]、CDC[6]、SSN[28]、PGCN[15]分别增加15.41%、13.49%、7.89%、4.31%、4.13%、1.12%.结合Thumos14数据集上的试验结果,可以看出虽然在有大量数据可以学习时的检测结果与G-TAD[25]存在差距,文中方法对于较少样本数据集上的检测结果要显著高于G-TAD[25],表明文中方法更适合较少样本训练的动作检测与定位.

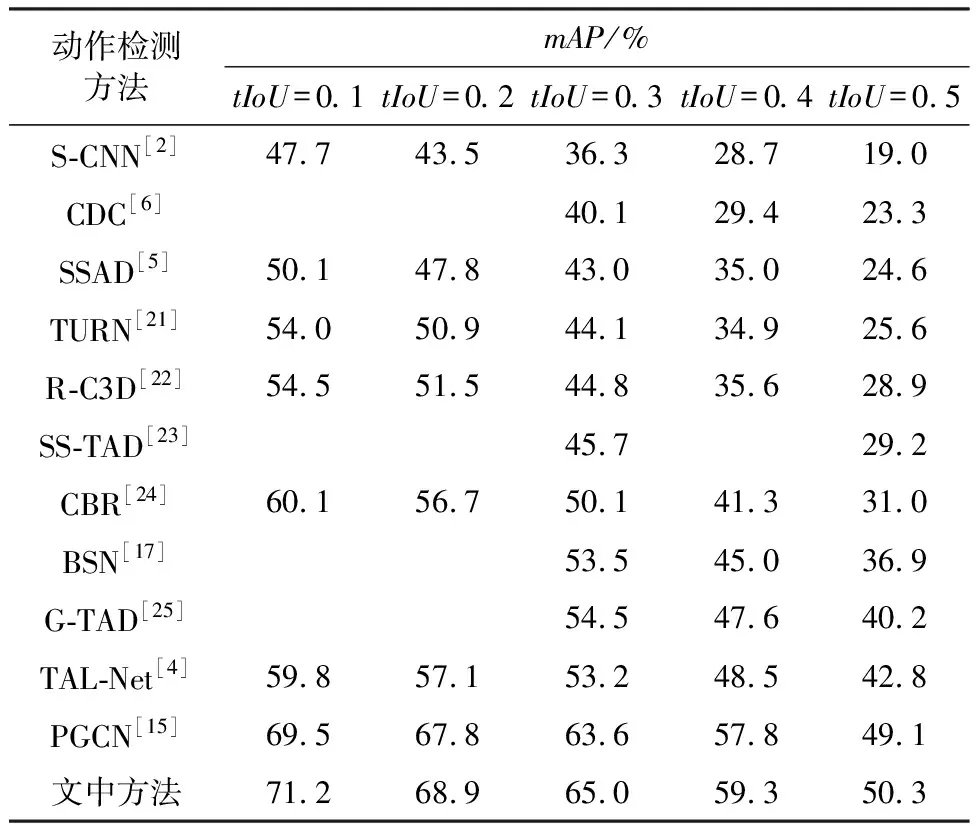

3.5 消融研究

为了探究文中方法中各模块对性能提升的实际影响,在Thumos14数据集上进行了消融试验,表4给出了消融试验结果,分别进行了对基准网络(PGCN)、在基准网络基础上构建整体关系图推理子网络、在基准网络基础上构建局部关系图推理子网络以及同时构建整体+局部关系图推理子网络形成文中的整体与局部相互感知的图网络等方法的试验对比.

表4 Thumos14数据集下消融试验结果 %

试验结果表明,构建整体关系图推理子网络,学习获得了提案更丰富的整体时空特征表示,使基准网络动作检测性能得到了0.4%的提升.构建局部关系图推理子网络,学习获得了不同时间尺度下提案的局部关系信息,较为显著地使基准网络动作检测性能得到了1.0%的提升.结合整体与局部关系图推理子网络和局部关系图推理子网络的优势构建文中模型的网络框架,综合学习整体与局部相互感知的时空关系信息,有效地使基准网络动作检测性能得到了1.2%的提升.因此,应同时结合整体与局部时空关系图推理的综合利用.

4 结 论

1) 文中提出了一种整体与局部相互感知的图网络时序动作检测方法,与先进的方法相比,文中方法在Thumos14数据集tIoU=0.5标准阈值下的动作检测平均精度均值达到了50.3%,在ActivityNet1.3数据集tIoU=0.50-0.95动作检测平均精度均值达到了28.11%,表明文中方法能有效提高动作检测的性能.

2) 文中方法虽然在Thumos14数据集上的动作检测结果优于G-TAD,但在ActivityNet1.3数据集上的检测结果与其存在一定差距.原因如下:一方面是相较G-TAD,文中方法更适合少样本数据集训练;另一方面文中预先通过BSN网络基于概率序列的方式生成提案,生成的提案只包含少量的局部信息,对长距离全局上下文信息未深入考虑,因而在处理复杂的活动和杂乱的背景时,对模糊边界的精确定位存在困难.

3) 后续工作是对全局上下文信息在提案生成方法中的综合利用进行研究,改进提案生成网络以有效利用视频中丰富的全局上下文信息,以期生成高质量的时序动作提案,进一步提高时序动作检测在大样本数据集上的综合性能.