车辆智能障碍物检测方法及其农业应用研究进展

何 勇,蒋 浩,方 慧,王 宇,刘羽飞

(浙江大学生物系统工程与食品科学学院,杭州 310058)

0 引 言

传统的农业作业过程一般是由人或人操纵农机完成,劳动重复且单调,易产生疲劳,长时间会导致作业精度下降以及危险性上升,智能化农业车辆的使用则可以减轻人员的劳动强度,提升作业的精度及安全性。智能化农业车辆(包括农业机器人)是一个高度信息化、自动化、智能化,可自主实施变量作业的智能化平台,随着精准农业理论的发展,其自动导航技术已越来越受到国内外的关注[1-2]。农机自动导航技术的研究内容主要包括环境中障碍物的检测、路径规划、车辆模型的建立与控制方法,其中障碍物检测是重要的一个环节,当环境复杂时是进行其他任务的前提[3]。

真实的农田环境是复杂的非结构化环境,在智能农业车辆或机器人行进路线上不可避免的存在大量障碍物,包括高土堆或坑、树桩或较大的树杈、灌木丛、电线杆、人工放置的农具以及人、家畜和其他行驶的农机等,如果不通过传感器实时感知并及时避开,会造成严重的安全问题。目前世界上用于障碍物检测的传感器主要为超声波传感器、激光雷达和视觉传感器,但大多数的研究集中在室内或者已知结构的简单室外环境,对于田间的研究相对较少。随着多传感器融合技术的运用,复杂环境障碍物检测的可靠性提高且成本降低,使得其成为了新的研究热点。

本文将首先对单一种类传感器检测技术在农田环境中的障碍物检测研究进行逐一研究,分析每一类的优点以及存在的问题;然后将几种典型的传感器技术融合方式(视觉技术与超声波技术,视觉技术与激光雷达技术以及Kinect传感器)的应用情况进行概述;最后对未来这方面可能展开的研究进行展望,包括新型装置和新算法引入及原有传统方法的改进2个方面。

1 超声波技术障碍物检测

超声波是一种频率高于人耳听觉上限的声波,其方向性好、穿透能力强、易于获得集中的声能,在农业[4]、化工[5]、医学[6]、军事[7]等领域得到了广泛的应用。超声波距离检测的基本原理是通过传感器发出超声波,遇物体反射后,传感器计算超声波的飞行时间(time of fly ,TOF)从而确定物体的大致位置。

1.1 室内环境下障碍物检测

当超声波技术用于障碍物检测时,单一的传感器能探测的范围太小且方向性差无法满足需求[8],一般会使用多个传感器同时发出和接收信号。由于超声波传感器无需接触、操作简单、探测速度快(一个测量周期仅需几十毫秒),并且在一定条件下可以检测到处于黑暗、灰尘、烟雾、电磁干扰、有毒等恶劣环境中的被测障碍物[9],该技术已经在室内环境自动导航中得到了广泛的应用。Veelaert等[10]尝试将三个超声波传感器安装在自动轮椅上以检测轮椅前面的障碍物,但是他们没有考虑多物体反射的互相干扰以及传感器的方向性,因此只能应用在单一障碍物或者障碍物间距离较大的简单条件下;Ohya等[11]利用超声波技术辅助视觉,通过由 4个超声波传感器组成的声纳环检测移动的障碍物;Ureña等[12]设计了基于 4个超声波传感器的室内障碍物检测系统,能够检测出墙壁、墙角等障碍物;曾迎生等[13]设计了一种超声传感器线阵,可在室内环境下确定障碍物的距离和方位;美国Activmedia公司生产的Pioneer2DXE型移动机器人在机器人的前方和两侧安装了 8个超声传感器用于检测[14]。

上述这些研究都是在室内环境进行,障碍物种类单一且位置大致已知,仅需检测出障碍物的距离与大致边界,而在非结构化的室外环境中,不仅障碍物种类更多样化,且位置未知,还存在重叠或者间距较小的情况。

1.2 室外环境及农田环境障碍物检测

随着技术的发展和设备的更新,国内外学者开始研究超声波技术在室外环境中的应用并获得了一定的成果,但仍存在亟需解决的问题。Guo等[15]通过 2个超声波传感器检测并计算室外静止和移动障碍物的相对位置,但由于强风会造成超声波反射信号的丢失,该系统无法在有强风的环境中对障碍物进行有效检测。高云[16]采用声速温度补偿及针对湿度、气压等其他影响因素的误差修正因子补偿来提高测距精度的方法,设计了超声波测距系统,该系统在100~4 000 mm范围内,对障碍物的距离检测误差在10%以内。石彪等[17]对超声波的传播、反射过程中引起的农业机器人测距不确定性进行了研究,并提出了基于概率和D-S理论的2种方法,对获取的信息进行分析和融合,从而确定障碍物的位置。Dvorak等[18]针对不同表面对超声波反射波特性影响的问题,试验研究了超声波传感器用于不同农田障碍物或结构环境中障碍物的检测能力,试验的对象包括人、动物、篱笆桩、不同植物冠层、水壶、定向刨花板等。贾闯等[19]研制了用于山地果园单轨运输机的超声波避障系统,以规则物块(高60 cm、宽20 cm、长30 cm)和不规则小石块(最大横截面积直径小于等于18 cm,高小于等于8 cm)作为轨道上的障碍物,以侧枝较多的盆栽柑橘树(直径70 cm,高110 cm)作为轨道旁的非障碍物,结果显示将超声波传感器安装在车头正前方中垂线上距轨道垂直高度 10 cm处时能达到最佳安全停车距离,且都不会将非障碍物误判为障碍物而导致停车;该试验对农田环境具有一定参考性,单轨条件可类比作物行间的行车路径,柑橘树侧枝可类比作物的侧枝,因此可考虑将该系统用于农机行进道路上的障碍物检测。

综上所述,目前将超声波技术用于室外环境(包括更为复杂的农田环境)中的障碍物检测仍存在的问题有:超声波检测障碍物空间位置的准确性较差,误差在10~50 cm[20];环境噪音或者多个传感器之间的相互干扰会造成检测系统的频繁误判;空气温度在一定的程度上会对超声波传播速度产生影响;障碍物的表面类型会影响超声波检测的效果[21]。因此,该技术目前只适用于障碍物相对单一的场景。可以预见,在复杂的农田环境中进行障碍物检测,如果出现障碍物和作物混杂在一起的情况或者是存在超声波检测效果不好的障碍物(如牛、羊等[21]),单独使用超声波技术是无法完成的,将其与其他传感器检测技术相结合使用是未来研究的趋势。

2 激光雷达技术障碍物检测

激光雷达(light detection and ranging, LIDAR),是激光与现代光电探测技术结合的探测方式,集激光、全球定位系统(global positioning system, GPS)和惯性导航系统(inertial navigation system, INS)三种技术于一体,通过发射器向目标发射激光束,将接收到的反射信号与发射信号比较,处理后得到目标的相关信息,如目标距离、方向、速度、形状参数等,基本原理与超声波测距类似,但该技术依据光速计算距离,而光的传播速度基本不受环境温度的影响。激光雷达具有分辨率高、抗有源干扰能力强、光束窄的优点,已经被广泛应用于军事[22]、大气监测[23]、无人机遥感[24]、道路检测[25]、自动避障等方面。根据扫描机构的不同,激光雷达可分为二维扫描和三维扫描2种。

2.1 二维激光雷达

与三维激光雷达相比,二维激光雷达通常只使用一组激光传感器和一个旋转装置在一条线上进行扫描[26],结构简单、检测速度快、价格相对较低。

2.1.1 室内研究

Kwon等[27]利用二维激光对实际环境中不规则形状的障碍物进行检测,通过得到数据的空间近邻性对障碍物区域进行划分;该方法虽能检测到不规则的墙壁或微小障碍物,但不能提取出有效的线段特征且只适用于准静态环境(障碍物位置非一直保持移动)。Kyriakopoulos等[28]基于二维激光雷达的扫描测量设计了一种方法,对机器人的移动进行评估同时对移动障碍物进行检测并估计速度;该方法试验场所为办公室内且障碍物较为单一,仅为遥控的玩具汽车。于金霞等[29]使用二维激光雷达对办公室环境中的障碍物,使用无监督聚类学习对障碍物的特征进行提取并将模糊逻辑引入增量式数据关联来进行障碍动静态属性的判别;该方法对运动物体具有一定的识别能力且能消除长期运动中轨迹推测造成的误差。

2.1.2 室外研究

上述都是二维激光雷达用于室内障碍物检测,近几年也有学者对二维激光检测技术的室外应用展开了研究。Takahashi等[30]针对人行道上障碍物的情况设计了基于LIDAR的紧急避障模块,模块包括倾斜安装的二维激光雷达和嵌入式微控制器,并运用二维自回归模型对障碍物的位置进行了定位;试验结果证明可以对静止的路障、运动的人和自行车进行较好的检测且能将低矮的障碍物与斜坡进行快速区分。Peng等[31]则基于二维激光雷达设计了障碍物检测的算法,将得到的激光点云去噪后进行滤波、分割和聚类,最终输出障碍物的形状和位置;该算法的数学模型简单实时性强,且能用于室外环境下的已知障碍物(灌木丛、墙壁、木箱)的检测,但只能是用于静止障碍物且要求路面平整。

从上述的文献可以看出,二维激光雷达适用的前提是周围环境的路面情况比较平坦,不会出现大幅度的颠簸情况,然而,而在复杂的野外(包括农田)环境中地形高低不平,会引起车体行驶时的剧烈颠簸;且二维激光测距雷达只能是单线扫描,对于扫描线外的障碍物无法进行检测。朴燕等[32]将虚拟二维激光雷达用到了障碍物检测上,并结合 3D场景点云特征进行扫描障碍物模拟;虚拟激光雷达是一类以计算机模型模拟激光传播、测距、成像原理形成激光图像的技术,国外已经开始对这方面进行研究[33-35],但目前技术还不是很成熟且应用在障碍物检测上的研究很少。

2.2 三维激光雷达

三维激光雷达通过多线(即多组传感器同时扫描,常见的有4线、8线、16线、32线)混合固态或固态旋转来实现三维空间的环境测绘,在室外环境中的应用比二维激光雷达更多。Brenneke等[36]提供了一种三维激光障碍物识别算法,将三维点云分成两类,第一类点垂直成一条线,如树干、墙、坑和某些人造路标;第二类点与地面无直接关联,如树枝、屋顶,对整副图像两类点进行颜色标识即可完成对障碍物的识别。Jiménez等[37]提供了一种改进的障碍物识别算法,解决了一般方法只依赖障碍物距离对障碍物进行识别的局限性,并通过提取障碍物的特征轴,计算动态变量如速度;该算法在室外进行试验测试时,结果具有较高的鲁棒性和精确性。Asvadi等[38]利用三维激光扫描获得的点云数据和惯性导航系统获得的定位数据设计了一种方法进行城市环境中的静态和动态障碍物检测(马路上常见的运动障碍物包括行驶的车辆、行人,静止障碍物包括路边停靠的车辆、电线杆和树木),首先利用分段平面拟合算法和RANSAC方法对地形进行评估,然后对三维像素点网格模型进行判别分析和自运动分析检测静态和动态的障碍物;试验结果证明该方法可行。

应用三维激光雷达检测障碍物获得的信息更直观,且视角更大,受车辆颠簸的影响更小,但由于系统的造价昂贵,目前还没有学者或研究将其直接运用在农田障碍物检测中。

2.3 激光雷达技术的农业应用

针对三维激光和二维激光雷达各自的缺点,有学者提出了将二维雷达进行改装进行三维扫描的解决方法。国内外学者采取了改装或组合二维激光雷达以获得三维采样功能的方法,如德国的自主智能系统研究所的Surmann等[39]、美国的卡耐基梅隆大学的Tuley等[40]和浙江大学的孙宇[41]都将二维激光雷达增加一维扫描装置(通常为云台)以实现三维测量;而日本东京大学的Zhao等[42]和浙江大学的项志宇[43]则通过安装 2个二维激光雷达在不同的位置获得不同的扫描位置和扫描深度信息,然后加以融合获得环境的三维信息。

虽然目前仍然很少有研究将激光雷达技术单独用在农机农田障碍物检测中,但其已经在农业中的其他方面得到了应用。薛金林等[44]利用基于激光雷达研究农业机器人在有行株距的果树行和无行株距的果树行(尤其是单侧存在行缺失的情况)中的导航性能;张莹莹[45]用激光雷达检测果树的位置,并通过结果生成导航线和导航控制量指导农业移动机器人行走;Hämmerle等[46-48]使用激光雷达技术分别进行了粮食作物表面建模、粮食产量建模和农田土地利用检测。

3 机器视觉技术障碍物检测

机器视觉就是指用视觉传感器代替人眼来做测量和判断[49],已经被广泛的应用于自动导航中的障碍物检测中。目前常用的视觉传感器主要有单目相机、双目相机和多目相机。单目相机结构简单,在已知障碍物类型的特定环境中可以用来进行障碍物检测[50-52],但是在非特定环境中只能得到二维信息[53],目前较多应用在喷药播种施肥、地头识别、田间路径检测[54-57];多目相机需要用到 3个及以上的相机,构造复杂,价格相对昂贵,对计算机处理器的运算速度要求很高[58],较少运用于智能农机的自动导航系统中。相比较而言,双目相机更有利于研究和使用[59],尤其是在障碍物检测方面,得到了国内外学者的重视。

双目视觉技术的基本原理是利用两台位置固定(一般平行)的相机,在两个不同的视角下得到两幅图像,通过几何原理计算视差(两幅图像中同一像素点的位置偏差),从而确定三维空间点的深度信息。早在1995年,Matthies[60]等就首先证明了立体视觉技术实际用于无人驾驶地面车辆(UGV)的可行性,其中就改进了算法通过高度阈值实现了对障碍物的检测;近几年来,算法得到了不断的改进,尤其是在立体匹配方面,Yoon等[61-68]学者提出了多种算法,研究的障碍物对象也从静止状态变为移动状态[69-71]。

但是很多研究都只适用于室内环境和室外简单障碍物条件,或者仅仅存在于理论阶段,而在实际农田中,智能农机作业环境复杂、障碍物种类较多,如何利用双目视觉进行快速准确的农田障碍物识别成为国内外学者研究的一个热点。

3.1 田间障碍物识别分割算法

3.1.1 传统算法

基于双目视觉技术检测障碍物的关键在于利用图像分割算法识别复杂背景中的多种典型障碍物。Reid[72]在专利中提出了一套基于双目视觉的田间障碍物检测系统,可以对高于田间作物冠层的障碍物进行检测,并通过立体匹配获得障碍物的范围和距离。Wei等[73]假定人为唯一潜在的田间障碍物,通过设定阈值对获得的视差图进行处理,可以检测出农机附近的人型障碍物及其运动状态。张磊等[74]提出通过分析扫描线上的亮度分布情况将障碍物区域从背景中分割出来,并进行快速的立体特征匹配,得到障碍物的空间信息,结果表明每对图像的处理时间小于100 ms且检测出人型障碍物的正确率达到95%。丁幼春等[75]针对联合收割机的视觉测障,提出了将单目彩色图像分割与立体视觉特征匹配相结合的新方法,利用H、S分量对单目图像阈值分割获得潜在障碍物的区域,采用尺度空间不变(SIFT)算法和近似最近邻分类(ANN)算法进行立体特征匹配,进一步确定障碍物距离收割机的距离,该算法在200 ms内可以完成障碍物的检测。Yin等[76]对3D相机(PMD CamCube 2.0,原理即通过两个镜头得到深度图像,且相机内自带立体匹配的程序)获得的深度图像进行去噪处理,去除噪声后的像素点通过坐 标转换并设定高度阈值进行过滤,再通过四联通法(4-connectivity)进行障碍物的边界提取,最终获得障碍物的位置和大小信息。

上述的传统阈值分割方法虽然得到获得较好的检测效果且单幅图像的处理时间较短,但都存在一定的局限性,如 Wei[73]和 Yin[76]的检测对象都仅仅为田间的人,Reid[72]、张磊[74]和丁幼春[75]的试验对障碍物与周围环境的高度差或颜色差有严格的要求。

3.1.2 传统算法的改进及新算法的提出

总的来说,传统算法存在的问题有:检测的障碍物种类单一;无法检测未知障碍物;对于作物遮挡的障碍物检测效果不佳;部分算法的实时性较差。针对这些问题,也有学者提供了新的思路。

杨福增等[77]提出了一种针对不同障碍物的检测方法:对获得的左右图像用Bouguet算法进行双目校正,然后采用 SAD(绝对差值和)算法对校正后的双目图像进行立体匹配,获得障碍物的深度信息;田间试验设置的障碍物包括人、砖块、铁锹和陷坑,识别的准确率达到96%以上,且完成一次检测的时间小于 100 ms。但是,该试验虽然分析了多种障碍物情况,但这些障碍物的类型和大致位置是已知的,且需要满足检测距离小于 2 m的条件,难以在田间实用。

苟琴等[78]基于视差图提出了一种障碍物的检测方法:采用改进的立体匹配算法(基于SAD算法)对获得的图像进行立体匹配获得视差图,然后通过视差阈值和区域联通分割出潜在的障碍物区域,最后由面积阈值和高度阈值进一步过滤,检测出障碍物并定位,田间结果显示在 5 m视野内,障碍物距离和尺寸的相对偏差在4.37%和3.81%内,总耗时不超过310 ms,满足多数情况下的作业要求;该算法较好的解决了未知障碍物的问题,但是算法中的视差阈值、高度阈值和面积阈值都是根据经验或试验得出,对于不同的试验场景不具有普遍性,且算法单幅图像的处理时间较长,实时性仍较差。

韩永华等[79]提出了基于频率信息与立体匹配相结合的方法,利用作物和非作物频率信息的区别,检测发生遮挡的障碍物,最后采用立体匹配技术确定障碍物的具体位置;试验图像在深秋的青菜地、春天的麦田、收获期麦田、生长期水稻田中进行,发现田头、农业机械、土堆、石块、电线杆、人等障碍物都可以检测出且检出率为100%,单帧图像的平均处理时间为79 ms。Ball等[80]设计的障碍物检测和自动导航系统中使用双目视觉相机和 novelty-based障碍物检测方法,先将典型的种植场图像模型输入给系统,当相机采集到的图像中出现模型之外的区域时就标记为潜在的障碍物,并用 LIBELAS(Library for Efficient Large-Scale Stereo Matching)匹配方法对其进行立体匹配生成三维点云,经过过滤后找出障碍物,并最终输出二维的局部障碍物图和障碍物位置的掩膜,试验结果显示可以避开多种典型的静止农田障碍物,如:油桶、农机、树杈和人。Fleischmann等[81]则将通过像素差的绝对值(Sum of Absolute Differences,SAD)立体匹配后得到的三维点云分割成相互独立的平面单元,通过分析点的密度和分布以及拟合平面的法线确定障碍物所在的单元,最终通过邻域分析实现障碍物的聚类与识别,试验证明该方法可准确识别多种环境中的障碍物包括收割田中的电线杆,且能够实时进行。姬长英等[82]也利用了双目视觉中立体匹配得到的点云图为对象进行了障碍物检测,通过对不同区域点云密度的计算获得点云密度随距离的衰减曲线,经二次设置有效空间后锁定障碍物位置,并将障碍物点云分别投影于俯视栅格图和正视图中,获得距离和尺寸信息;结果显示该方法的最大测距为28 m(平均误差2.43%),最大尺寸检测范围为10 m。

3.2 双目视觉技术的优点和缺点

相比于其他方法,利用机器视觉(双目视觉)进行农田障碍物的检测,具有以下的优点:机器视觉使用的相机不对外发射信号,所以不会对周围环境造成影响[83];可以检测更宽广视角下的障碍物而无需进行扫描[73];机器视觉能在瞬时得到一个面上的信息,并进一步得到一个区域范围的信息;相比于其他传感器,用于障碍物检测的相机价格更低,且图像内包含的信息更多。但是该方法也存在以下的问题需要解决:受环境光的影响较大,在没有良好光照的条件下障碍物不易被检测[84];虽然已有很多算法提出,但如何从复杂环境中快速准确检测出与环境类似的障碍物仍是一个重大问题;环境中的灰尘、雨、雪会对障碍物的检测产生很大的影响[85];由于立体匹配的准确性随着检测距离增加而降低,所以该方法的检测距离受到限制,部分系统无法满足实际的农田作业。

针对这些问题,也有学者进行了相应的研究:Broggi等[86-87]使用多基线相机(multibaseline cameras)取代双目视觉中的普通相机,可以有效地提升立体匹配的距离从而提高障碍物的检测距离,但是该方法会降低检测的精度并提高系统的成本;Gée等[88]采用RGB颜色空间,利用2G-R-B作为颜色特征因子,在一定程度上降低了光照对图像分析造成的干扰;An等[89]采用与光照无关的方法消除图像阴影,提高了导航系统在光照变化条件下参数提取的稳健性,但是该算法计算复杂、耗时长,难以满足实时性要求。

尽管现在对于上述问题还没有很好的解决方案,但是机器视觉技术已经证明了在环境可控的条件下是一种有效的障碍物检测方法,随着研究的深入,该技术会在农田障碍物检测中得到更多的应用。

4 多传感器融合障碍物检测

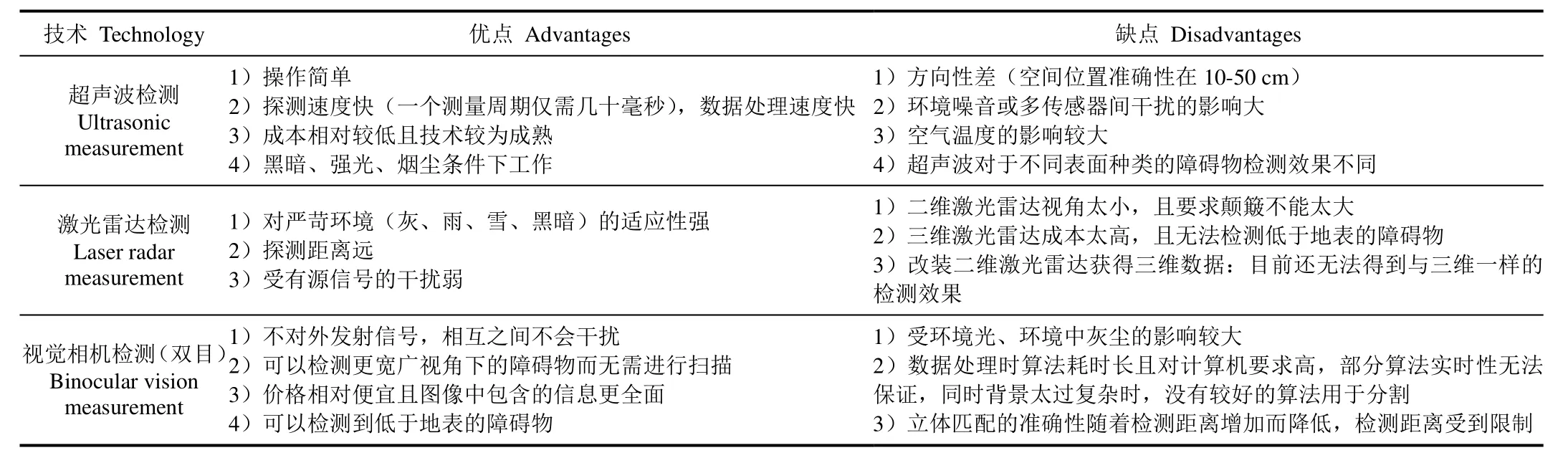

农田环境是非结构化环境,相比于如室内这种结构化环境,更为复杂和未知,障碍物种类更多且环境因素更不可控,因此需要障碍物检测系统具有更高的精确性、更远的检测距离、更好的实时性和更强的环境适应性。而单一的传感器检测技术虽各有优点,但同时也存在局限性,如表 1所示。显然,只靠单一传感器搭建的系统无法满足农机的农田作业要求,随着多传感器融合技术的出现和应用[90],将 2种或多种单传感器检测技术结合运用到系统中已经成为室外环境障碍物检测的趋势。

表1 单一传感器检测技术的优缺点Table 1 Advantages and disadvantages of single sensor measurement technology, including ultrasonic measurement, laser radar measurement and binocular vision measurement

4.1 视觉技术与雷达(激光雷达)技术相结合

Labayrade等[91]结合立体视觉和激光扫描的优点设计了道路环境下多障碍物的检测系统,该系统的鲁棒性、准确性和实时性比单一传感器的系统都好;Perrollaz等[92]针对立体视觉中检测精度随检测距离增加而降低的情况,利用激光扫描仪与立体相机结合的方法进行道路上的障碍物检测,提高了系统的检测距离;Bertozzi等[93]用视觉相机结合雷达的方法检测障碍物,解决了单独使用雷达时提供的用于障碍物边界检测的数据点不足和对于较小障碍物检测效果不佳的问题;王葵等[94]利用激光测距雷达和机器视觉对障碍物进行联合检测,既可以获得深度信息,又可以获取形状信息,提高了障碍物检测的可靠性;汪佩等[95]提出了一种基于单线激光雷达和单目视觉的负障碍检测算法,解决了单线激光雷达在覆盖能力不足的问题,对不同尺寸的室外环境中负障碍物的识别准确率达96%。

综上所述,这两种技术的结合使用一方面能通过激光雷达弥补视觉相机检测距离短的问题,另一方面能通过相机弥补二维激光雷达检测视角小的缺点,能有效地提高系统的鲁棒性和准确性,同时避免了使用三维激光雷达的高成本问题。

4.2 视觉技术与超声波技术相结合

Ohya等[96]将单目相机与超声波传感器相结合用于室内移动机器人的避障;戈新良等[97]将单目彩色相机与超声波传感器相结合,利用相机获得二维图,利用超声波传感器获得深度信息从而得到三维图,该方法相当于用一个价格低的超声波传感器替代双目视觉中的另一个相机;Kim 等[98]利用视觉系统检测两米以外的障碍物,用超声波传感器对两米内的障碍物进行边缘检测;王檀彬等[99]用D-S证据理论将视觉和多个超声波传感器信息进行融合的方法进行障碍物判断,解决了单独使用视觉传感器存在光干扰和单独使用超声波传感器方向性不确定的问题;Lu[100]通过相机获得的图像判断障碍物区域的大小,并使用超声波传感器获得障碍物的距离信息,实现了机器人前方障碍物的快速准确识别。

综上所述,利用单目相机获得的图像确定障碍物的大小和大致范围,并通过低成本超声波探头确定障碍物的距离,这种融合方法一方面进一步降低了系统的成本,另一方面解决了单独使用超声波技术时方向性差以及单独使用双目相机时立体匹配过程耗时长的问题,提升了系统的实时性。

4.3 其他形式的技术结合

Mobus等[101]将红外检测技术与雷达结合进行障碍物检测,并通过与单独使用 2种传感器进行试验比较,结果表明,将雷达数据与红外数据融合,大大提高了检测范围、可靠性和准确性;Yamamoto等[102-103]都将普通相机和红外相机获得的图像信息结合用于障碍物识别,结果显示识别效果比单独使用可见光图像和红外图像的效果都好,且能够很好的克服环境光的影响;Wang[104]为提高移动机器人障碍物检测的实时准确性,利用自适应加权融合算法将红外传感器和超声波传感器获得的环境信息融合,结果显示相比于单一传感器更接近真实值、波动更小;Qu等[105]将超声波传感器阵列与红外距离检测技术组合,在机器人前方建立了一个 180°的滚动窗口用于未知环境中障碍物的检测;Close[106]针对部分被遮掩的障碍物检测提出了将激光雷达与普通雷达相结合进行检测的方法,并利用两者在无线电频谱中不同的部分工作弥补了彼此的缺点;Budzan等[107]将深度图像信息和3D激光扫描数据融合进行障碍物的检测,结果显示该方法能提高不同场景下障碍物检测的有效性;Giannì等[108]研究的障碍物检测系统集成了超声波传感器、雷达和激光雷达三种传感器,该系统能对墙、透明窗户、电线杆、金属网、人和植被等典型户外障碍物的距离进行准确估计。

以上所述传感器融合用于障碍物检测的环境大多都是道路环境,虽然相比于室内环境更为复杂,但相比于农田环境还是过于简单(如道路上的障碍物种类一般为人和行驶车辆,而农田的障碍物种类更多且部分隐藏在非障碍物中),因此这些方法只能作为参考而不能直接用于农田中的障碍物检测,否则无法获得满意的检测效果。

4.4 多传感器融合技术的农业应用

近几年来随着技术的不断发展,多传感器融合技术在智能化农业车辆(包括农业机器人)上的研究逐渐开始有了进展。Liu等[109]设计了基于多传感器融合算法的避障系统用于农业机器人,该系统中GPS进行定位,超声波传感器、红外热成像传感器、二维激光扫描仪测得到的障碍物信息进行融合后通过聚类模糊找到障碍物的大致区域。Ding等[110]研究的避障算法可用于较接近于农田环境的森林环境中,具体做法是用二维激光扫描仪和红外热像仪采集林区障碍物信息,从中分别提取障碍物的特征(包括温度、颜色、长宽比、多边形特点),利用融合后的数据训练支持向量机进行障碍物的识别;试验设置的障碍物包括人、树木、石头,平均识别准确率为91%,可以考虑将其用于障碍物较少的农田环境中使用。Yang等[111]在专利中设计了用于山地区域的农业机器人避障系统,包括视觉传感器模块、超声波传感器模块、红外传感器模块和数据融合模块。Benet等[112]将激光雷达获得的三维数据融入到普通相机获得的彩色图像中,在葡萄园环境中进行试验,结果显示识别农机前方不同离地高度的杂草或实体障碍物(如树杈)有较好的效果,且受光照条件的影响较小。但目前这些研究大多仍处于起步阶段或室内模拟试验阶段,距离产品化及实际田间使用还有大量问题亟待解决,如产品的成本、环境变化时系统的稳定性等。

4.5 基于Kinect的障碍物检测

近几年来出现的基于Kinect的障碍物检测技术也是一种多传感器融合技术的运用。Kinect传感器因其同时含有彩色图像视觉传感器和深度视觉传感器且价格较低[113],已被应用到障碍物的三维重建中。

目前大多数研究都在简单室内环境进行[114-116],但已有学者开始将试验地点转移到温室或简单的室外环境中。Nissimov等[117]设计了使用Kinect传感器检测温室作物行间(本文为辣椒)障碍物的方法,通过计算深度数据各个点的斜率,将斜率大于阈值的点标记为可疑障碍物,然后根据颜色特征和纹理特征对这些可疑点进行分类和筛选,最终确定障碍物的位置。Zhu等[118]提出了将Kinect传感器获得的深度图像与红外图像先用均值漂移方法进行背景分割,然后融合进行障碍物检测的方法;在室内环境和室外环境中进行试验的结果显示,该算法可以检测视野中小的障碍物并且检测的准确率不受环境光的影响。Hernández-Aceituno等[119]将 Kinect传感器用于室外环境的障碍物检测,通过一系列的滤波技术将传感器获得的深度图像转换为潜在障碍物区域图,结果显示Kinect的检测结果比立体视觉技术更准确。

Kinect传感器的优势在于:设备方便装卸且价格较低;同时获得深度信息、红外和彩色图像信息,避免因传感器不同而带来的不同步问题;受环境光的影响较小。但是由于红外摄像头和彩色相机的可视范围有限(一般在0.5 m~4 m[113],Zhu等[118]在文章中提到的有效距离为0.5 m~8 m,但较远处的检测准确度有所下降),导致了在复杂农田环境中使用Kinect传感器时虽能检测到障碍物,但无法及时避开,因此目前没有研究将其用于农田环境中,但是如果能有研究将其的检测距离提升或是再与其他价格相对较低的传感器融合弥补其检测距离短的缺点,Kinect在农业中的应用将更为广泛。

5 结论与展望

5.1 总 结

综上所述,单个传感器检测技术所使用的不同的传感器都具有各自的优点和缺点:超声波传感器操作简单、探测速度快、成本低且技术较为成熟,但缺点在于空间检测的准确性较低、受噪音的影响大以及检测效果受物体表面类型影响大;雷达(包括激光雷达)对严苛环境(灰、雨、雪、黑暗)的适应性强、探测距离远、受有源信号的干扰弱,但是视角相对较小,若考虑视角大的三维雷达或者多个二维雷达组合则会使成本太高;立体视觉(包括双目视觉)相机虽然获得的视角更广且不用对外发射信号,但受环境因素影响严重,在数据处理上相对复杂,若要提高处理的速度需在检测范围或精度标准上相应降低。而多传感器融合的障碍物检测虽然能弥补一种传感器单独使用的缺点,但现在的研究尚处于起步阶段,对于农田环境的研究仍需进一步深入,至于搭建真正用于农田障碍物检测的系统尚需更多的时间。

5.2 未来研究展望

未来的研究可从新型装置及新算法引入及原有传统方法的提升这2个方面考虑。

1)新装置及新算法的探索

随着技术的发展和设备的更新,一些新出现的方法和设备可以逐步运用在农田障碍物检测中,具体有:

(1)目前不断有新型的基于视觉、激光等原理的装置出现,比如新型的双目立体相机、激光雷达等,在保证了性能的同时,成本却没有提高。如与 Kinect类似的zed双目立体相机据称可在室外20 m有较好深度精度,这为基于深度与立体视觉农机避障提供了可能性;北醒公司的激光雷达TF01作为一款低成本的激光雷达,克服了激光雷达的高成本引起的在农业上运用的局限性;类似这样新型仪器装置,克服了原有同类传感器的一些弱点,但其在农田中的稳定性与可靠性需进一步探索。

(2)避障的数据处理过程一般涉及图像中障碍物分割、边缘提取、识别等过程,可以不断尝试新算法、新方法用于这些障碍物识别过程。如深度学习已经应用在道路环境中的行人检测上且得到了较好的检测效果;在线学习的激光点云聚类算法被证明可正确分割大多数空间分布各异且相互连接的障碍物;密度补偿算法可以有效解决远距离障碍物随距离增加点云密度下降的问题。而农田中背景复杂多样、场景光强弱不一、障碍物姿态多样化且与作物相互遮挡,运用这些新算法进行农田中障碍物的检测、识别和定位的效果值得进一步研究。

(3)农田避障过程中一些看似无法解决的问题,需要用新思路新的角度去考虑。如视觉技术的缺点在于田间环境中作物对障碍物的遮挡导致无法通过图像分割对障碍物边缘进行提取,而农用无人机可以在农田上空采集图像,避免了水平视角下作物的遮挡问题;可否考虑使用农用无人机携带视觉检测系统与农机协同作业,通过无人机获取的障碍物信息制定农机的避障策略。

2)已有传统方法的改进

新方法的运用尚需要一定的时间,因此未来几年发展的重点应在已有的算法和设备的改进上。

(1)立体视觉技术所使用的相机在多传感器融合系统中一般作为主要传感器使用,但其存在的问题在于处理得到的数据需要较长的时间(部分障碍物边缘提取效果较好的算法需要用几百毫秒乃至几秒的时间处理单幅图像),影响了系统的实时性,从室内简单环境的数据处理到室外复杂环境,算法需要进一步改进从而达到减少处理时间的目的;需要设计出一种算法,既能使系统快速的分析出障碍物的位置从而对避障策略做出决策,又不会对障碍物空间位置的精度估算造成太大的影响,那么将其应用于立体视觉检测技术中可实现障碍物的快速准确判断。

(2)农田是一种复杂的环境,其中障碍物种类众多且未知,而不同的传感器检测技术对不同类型的障碍物有不同的检测效果,如对于超声波检测来说,对于表面硬、反射强的障碍物的检测效果较好而对于表面柔软、吸收性强的检测效果相对较差;想要依靠一种传感器检测出所有类型的障碍物在现阶段是极难实现的,可考虑首先对农田中存在的障碍物进行建模,然后在进行检测之前先对障碍物的种类进行识别(可考虑使用高光谱图像技术),根据其不同的类型选择不同的传感器技术进行检测,这样可以一定程度上提高检测的效率与精度。

[参 考 文 献]

[1] 田光兆. 智能化农业车辆导航系统关键技术研究[D]. 南京:南京农业大学,2013.Tian Guangzhao. Research on the Key Techniques of Intelligent Agricultural Vehicles Navigation System[D].Nanjing: Nanjing Agricultural University, 2013. (in Chinese with English abstract)

[2] 张智刚,罗锡文. 农业机械导航中的航向角度估计算法[J]. 农业工程学报,2008,24(5):110-114.Zhang Zhigang, Luo Xiwen. Adaptive weighted fusion algorithm for orientation evaluation of agricultural machinery[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2008,24 (5): 110-114. (in Chinese with English abstract)

[3] Bellingham J G, Rajan K. Robotics in remote and hostile environments[J]. Science, 2007, 318(5853): 1098-1102.

[4] 邓红,仇农学,孙俊,等. 超声波辅助提取文冠果籽油的工艺条件优化[J]. 农业工程学报,2007,23(11):249-254.Deng Hong, Qiu Nongxue, Sun Jun, et al. Optimization of ultrasonic-assisted extraction technology of oil from Xanthoceras sorborifolia burge seeds[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2007, 23(11): 249-254. (in Chinese with English abstract)

[5] Suslick K S, Price G J. Applications of ultrasound to materials chemistry[J]. Mrs Bulletin, 1995, 20(4): 29-34.

[6] 周永昌,郭万学. 超声医学第3版[M]. 北京:科学技术文献出版社,1998.

[7] 钱星博. 超声波技术在军事上的应用[J]. 世界发明,1997(3):21-21.

[8] 陈疆. 基于超声波传感器的障碍物判别系统研究[D]. 杨凌:西北农林科技大学,2005.Chen Jiang. Research of Based on Ultrasonic Sensors Differentiating Obstacle System[D]. Yangling: Northwest A&F University, 2005. (in Chinese with English abstract)

[9] Ohya A, Ohno T, Yuta S. Obstacle detectability of ultrasonic ranging system and sonar map understanding[J]. Robotics &Autonomous Systems, 1996, 18(1/2): 251-257.

[10] Veelaert P, Bogaerts W. Ultrasonic potential field sensor for obstacle avoidance[J]. IEEE Transactions on Robotics &Automation, 1999, 15(4): 774-779.

[11] Ohya A, Kosaka A, Kak A. Vision-based navigation of mobile robot with obstacle avoidance by single camera vision and ultrasonic sensing[J]. IEEE Transactions on Robotics & Automation, 1998, 14(6): 704-711.

[12] Ureña J, Mazo M, García J J, et al. Classification of reflectors with an ultrasonic sensor for mobile robot applications[J]. Robotics & Autonomous Systems, 1999,29(4): 269-279.

[13] 曾迎生,刘爱琴. 用于自主车绕障的超声传感器线阵[J].高技术通讯,1995(4):9-12.

[14] 吴涛. 移动机器人避障与路径规划研究[D]. 武汉:华中科技大学,2004.Wu Tao. Research on Obstacle Avoidance and Path Planning for Mobile Robots[D]. Wuhan: Huazhong University of Science and Technology, 2004. (in Chinese with English abstract)

[15] Guo L, Zhang Q, Han S. Agricultural machinery safety alert system using ultrasonic sensors[J]. Journal of Agricultural Safety & Health, 2002, 8(4): 385-396.

[16] 高云. 农业机器人的超声波测距系统设计[J]. 农机化研究,2009,31(4):76-79.Gao Yun. The design of ultrasonic ranging system in agriculture robot[J]. Journal of Agricultural Mechanization Research, 2009, 31(4): 76-79. (in Chinese with English abstract)

[17] 石彪,倪文志,刘利枚. 农业机器人中超声波测距的不确定性研究[J]. 农机化研究,2010,32(12):19-22.Shi Biao, Ni Wenzhi, Liu Limei. Study on uncertain information of ultrasonic distance measurement in agricultural robotics[J]. Journal of Agricultural Mechanization Research,2010, 32(12): 19-22. (in Chinese with English abstract)

[18] Dvorak J S, Stone M L, Self K P. Object detection for agricultural and construction environments using an ultrasonic sensor[J]. Journal of Agricultural Safety & Health,2016, 22(2): 107-119.

[19] 贾闯,李加念,洪添胜,等. 山地果园单轨运输机超声波避障系统的设计与试验[J]. 农业工程学报,2015,31(增刊 2):69-74.Jia Chuang, Li Jianian, Hong Tiansheng, et al. Design and test of ultrasonic obstacle avoidance system for mountain orchard monorail conveyor[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2015, 31(Supp.2): 69-74. (in Chinese with English abstract)

[20] Borenstein J, Koren Y. Real-time obstacle avoidance for fast mobile robots[J]. IEEE Transactions on Systems Man &Cybernetics, 1989, 19(5): 1179-1187.

[21] O’Sullivan J A. Evaluation of a polaroid ultrasonic proximity transducer[J]. Journal of Agricultural Engineering Research, 1986, 34(1): 63-73.

[22] 倪树新. 军用激光雷达的发展趋势[J]. 红外与激光工程,2003,32(2):111-114.Ni Shuxin. Trend of laser radar for military[J]. Infrared and Laser Engineering, 2003, 32(2): 111-114. (in Chinese with English abstract)

[23] 周军,岳古明,金传佳,等. 探测对流层气溶胶的双波长米氏散射激光雷达[J]. 光学学报,2000,20(10):1412-1417.Zhou Jun, Yue Guming, Jin Chuanjia, et al.Two-Wavelength Mie Lidar for monitoring of tropospheric aerosol[J]. Acta Optica Sinica, 2000, 20(10): 1412-1417.(in Chinese with English abstract)

[24] 庞勇,赵峰,李增元,等. 机载激光雷达平均树高提取研究[J]. 遥感学报,2008,12(1):152-158.Pang Yong, Zhao Feng, Li Zengyuan, et al. Inversion using airborne Lidar technology[J]. Journal of Remote sensing,2008, 12(1): 152-158. (in Chinese with English abstract)

[25] 杨象军. 基于四线激光雷达的道路检测与跟踪[D]. 杭州:浙江大学,2013.Yang Xiangjun. Detection and Tracking of Road Boundary Based on a Four-laver Laser Radar[D]. Hangzhou: Zhejiang University, 2013. (in Chinese with English abstract)

[26] 王荣本,赵一兵,李琳辉,等. 智能车辆的障碍物检测研究方法综述[J]. 公路交通科技,2007,24(11):109-113.Wang Rongben, Zhao Yibin, Li Linhui, et al. Approach review of obstacle detection for intelligent vehicle[J].Journal of Highway and Transportation Research and Development, 2007, 24(11): 109-113. (in Chinese with English abstract)

[27] Kwon Y D, Jin S L. A stochastic map building method for mobile robot using 2-D laser range finder[J]. Autonomous Robots, 1999, 7(2): 187-200.

[28] Kyriakopoulos K J, Skounakis N. Moving obstacle detection for a skid-steered vehicle endowed with a single 2-D laser scanner[C]//IEEE International Conference on Robotics and Automation, 2003. Proceedings. ICRA. IEEE,2003: 7-12.

[29] 于金霞,蔡自兴,段琢华. 基于激光雷达特征提取和增量式数据关联的障碍分类判决[J]. 高技术通讯,2007,17(7):703-708.Yu Jinxia, Cai Zixing, Duan Zhuohua. Obstacle classification decision based on feature extraction and incremental data association of laser scanners[J]. Chinese High Technology Letters, 2007, 17(7): 703-708. (in Chinese with English abstract)

[30] Takahashi M, Kobayashi K, Watanabe K, et al.Development of prediction based emergency obstacle avoidance module by using LIDAR for mobile robot[C]//International Symposium on Soft Computing and Intelligent Systems. IEEE, 2015: 561-564.

[31] Peng Y, Qu D, Zhong Y, et al. The obstacle detection and obstacle avoidance algorithm based on 2-D lidar[C]//IEEE International Conference on Information and Automation.IEEE, 2015: 1648-1653.

[32] 朴燕,沈俊,张华,等. 虚拟二维激光雷达成像积分算法[J]. 计算机测量与控制,2016,24(4):152-154.Piao Yan, Shen Jun, Zhang Hua, et al. An integral algorithm of imaging virtual 2D Lidar[J]. Computer Measurement &Control, 2016, 24(4): 152-154. (in Chinese with English abstract)

[33] Telgarsky R J, Cates M C, Thompson C, et al. High-fidelity ladar simulation[C]//International Society for Optics and Photonics, 2004: 194-208.

[34] Smith D D, Nichols T L, Gatt P, et al. Supercomputer-based advanced ladar imaging simulator (ALIS)[J]. Proceedings of SPIE-The International Society for Optical Engineering,2004, 5240:142-152.

[35] Bosché F. Automated recognition of 3D CAD model objects in laser scans and calculation of as-built dimensions for dimensional compliance control in construction[J]. Advanced Engineering Informatics, 2010, 24(1): 107-118.

[36] Brenneke C, Wagner B. A scan based navigation system for autonomous operation of mobile robots in man-made environments[C]//International Conference of systems engineering, 2003.

[37] Jiménez F, Naranjo J E. Improving the obstacle detection and identification algorithms of a laserscanner-based collision avoidance system[J]. Transportation Research Part C Emerging Technologies, 2011, 19(4): 658-672.

[38] Asvadi A, Premebida C, Peixoto P, et al. 3D Lidar-based static and moving obstacle detection in driving environments[J]. Robotics & Autonomous Systems, 2016, 83(C): 299-311.

[39] Surmann H, Kai L, Nuchter A, et al. A 3D laser range finder for autonomous mobile robots[J]. Proceedings of Isr, 2001,2(6): 1218-1223.

[40] Tuley J, Vandapel N, Hebert M. Analysis and removal of artifacts in 3-D LADAR data[C]//IEEE International Conference on Robotics and Automation. IEEE, 2004:2203-2210.

[41] 孙宇. 基于激光雷达的机器人三维地形构建和草丛中障碍物检测[D]. 杭州:浙江大学,2007.Sun Yu. Terrain Construction and Obstacle Detection in Grass of Robots Based on Lidar[D]. Hangzhou: Zhejiang University, 2007. (in Chinese with English abstract)

[42] Zhao H, Shibasaki R. Reconstructing textured CAD model of urban environment using vehicle-borne laser range scanners and line cameras[C]//International Conference on Computer Vision Systems. Springer, Berlin, Heidelberg,2001: 284-297.

[43] 项志宇. 针对越野自主导航的障碍物检测系统[J]. 东南大学学报(自然科学版),2005(增刊2):71-74.

[44] 薛金林,张顺顺. 基于激光雷达的农业机器人导航控制研究[J]. 农业机械学报,2014,45(9):55-60.Xue Jinlin, Zhang Shunshun. Navigation of an agriculture robot based on laser radar[J]. Transactions of The Chinese Society for Agricultural Machinery, 2014, 45(9): 55-60.(in Chinese with English abstract)

[45] 张莹莹. 基于激光雷达的农业移动机器人果树干检测和导航研究[D]. 南京:南京农业大学,2015.Sun Yingying. Research on Agriculture Mobile Robot Tree Trunk Detection and Navigation in Orchard Based on Laser Radar[D]. Nanjing: Nanjing Agricultural University, 2015.(in Chinese with English abstract)

[46] Hämmerle M, Höfle B. Effects of reduced terrestrial LiDAR point density on high-resolution grain crop surface models in precision agriculture[J]. Sensors, 2014, 14(12): 24212-24230.

[47] Keightley K E, Bawden G W. 3D volumetric modeling of grapevine biomass using Tripod LiDAR[J]. Computers &Electronics in Agriculture, 2010, 74(2): 305-312.

[48] Mesascarrascosa F J, Castillejogonzález I L, Ms D L O, et al. Combining LiDAR intensity with aerial camera data to discriminate agricultural land uses[J]. Computers &Electronics in Agriculture, 2012, 84(11): 36-46.

[49] 申川,蒋焕煜,包应时. 机器视觉技术和GPS在农业车辆自动导航中的应用[J]. 农机化研究,2006(7):185-188.

[50] Angelova A, Matthies L, Helmick D, et al. Learning and prediction of slip from visual information: Research Articles[J]. Journal of Field Robotics, 2007, 24(3): 205-231.

[51] Filitchkin P, Byl K. Feature-based terrain classification for LittleDog[C]//Ieee/rsj International Conference on Intelligent Robots and Systems. IEEE, 2012:1387-1392.

[52] Khan Y N, Komma P, Zell A. High resolution visual terrain classification for outdoor robots[C]//IEEE International Conference on Computer Vision Workshops. IEEE, 2012:1014-1021.

[53] 祝琨. 基于双目视觉信息的运动物体实时跟踪与测距[D].北京:北京交通大学,2008.Zhu Kun. Tracking and Measuring a Moving Object with a Binocular Camera System[D].Beijing: Beijing Jiaotong University, 2008. (in Chinese with English abstract)

[54] Han S, Zhang Q, Ni B, et al. A guidance directrix approach to vision-based vehicle guidance systems[J]. Computers &Electronics in Agriculture, 2004, 43(3): 179-195.

[55] Wei S, Gang L. A robust approach to obtain a guidance directrix for a vision-based agricultural vehicle guidance system[C]//International Conference on Computers and Computing Technologies in Agriculture. 2007: 1067-1072.

[56] Chen B, Tojo S, Watanabe K. Machine vision-based guidance system for automatic rice transplanters[J]. Applied Engineering in Agriculture, 2003, 19(1): 91-97.

[57] 王荣本,纪寿文,初秀民,等. 基于机器视觉的玉米施肥智能机器系统设计概述[J]. 农业工程学报,2001,17(2):151-153.Wang Rongben, Ji Shouwen, Chu Xiumin, et al. General design for corn fertilizing intelligent machine vehicle system based on machine vision[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2001, 17(2): 151-153. (in Chinese with English abstract)

[58] 程嘉煜. 基于机器视觉的农业机器人运动障碍检测及避障策略研究[D]. 南京:南京农业大学,2011.Cheng Jiayu. Research on Moving Obstacle Detection and Avoidance Strategy for Agricultural Robot Based on Machine Vision[D]. Nanjing: Nanjing Agricultural University, 2011. (in Chinese with English abstract)

[59] 宋丽梅. 双目立体机器视觉检测系统及其应用[J]. 西南科技大学学报:自然科学版,2006,21(1):30-34.

[60] Matthies L, Kelly A, Litwin T, et al. Obstacle detection for unmanned ground vehicles: A progress report[C]//Intelligent Vehicles '95 Symposium. Proceedings of the.IEEE, 1995: 66-71.

[61] Yoon K J, Kweon I S. Adaptive support-weight approach for correspondence search[J]. IEEE Trans Pattern Anal Mach Intell, 2006, 28(4): 650-656.

[62] Geiger A, Roser M, Urtasun R. Efficient large-scale stereo matching[C]//Asian Conference on Computer Vision.Springer-Verlag, 2010: 25-38.

[63] Kim C I, Park S Y. Fast stereo matching of feature links[C]//International Conference on 3d Imaging,Modeling, Processing, Visualization and Transmission.IEEE, 2011: 268-274.

[64] Samadi M, Othman M F. A new fast and robust stereo matching algorithm for robotic systems[C]//The International Conference on Computing and Information technology.2013: 281-290.

[65] 张令涛,曲道奎,徐方. 一种基于图割的改进立体匹配算法[J]. 机器人,2010,32(1):104-108.Zhang Lingtao, Qu Daokui, Xu Fang. An improved stereo matching algorithm based on graph cuts[J]. Robot, 2010,32(1): 104-108. (in Chinese with English abstract)

[66] 霍智勇,朱秀昌, 刘天亮. 基于线性生长的区域立体匹配算法研究[J]. 仪器仪表学报,2011,32(4):819-824.Huo Zhiyong, Zhu Xiuchang, Liu Tianliang. Region based stereo matching algorithm using line growing method[J].Chinese Journal of Scientific Instrument, 2011, 32(4):819-824. (in Chinese with English abstract)

[67] 王尧,余祖俊,朱力强,等. 基于脉冲耦合神经网络和Markov随机场的立体匹配研究[J]. 仪器仪表学报,2013,34(7):1539-1545.Wang Yao, Yu Zujun, Zhu Liqiang, et al. Study on stereo matching based on pulse-coupled neutral network and Markov random field[J]. Chinese Journal of Scientific Instrument, 2013, 34(7): 1539-1545. (in Chinese with English abstract)

[68] Kaneko N, Yoshida T, Sumi K. Fast obstacle detection for monocular autonomous mobile robots[J]. SICE Journal of Control, Measurement, and System Integration, 2017, 10(5):370-377.

[69] 周俊,程嘉煜. 基于机器视觉的农业机器人运动障碍目标检测[J]. 农业机械学报,2011,42(8):154-158.Zhou Jun, Cheng Jiayu. Moving obstacle detection based on machine vision for agricultural mobile robot[J]. Transactions of The Chinese Society for Agricultural Machinery, 2011,42(8): 154-158. (in Chinese with English abstract)

[70] Estilo J D, Ramos M. Obstacle detection and localization in an automated vehicle using binocular stereopsis and motion field[C]//IEEE International Conference on Control System,Computing and Engineering. IEEE, 2017: 446-451.

[71] Yamaguchi K, Kato T, Ninomiya Y. Moving obstacle detection using monocular vision[C]//Intelligent Vehicles Symposium. IEEE, 2006: 288-293.

[72] Reid J F. Obstacle detection using stereo vision:US7248968[P]. 2007-07-24.

[73] Wei J, Han S, Reid J F, et al. Obstacle detection using stereo vision to enhance safety of autonomous machines[J].Transactions of the Asabe, 2005, 48(6): 2389-2397.

[74] 张磊,王书茂,陈兵旗,等. 基于双目视觉的农田障碍物检测[J]. 中国农业大学学报,2007,12(4):70-74.Zhang Lei, Wang Shumao, Chen Bingqi, et al. Detection of obstacles in farmland based on binocular vision[J]. Journal of China Agricultural University, 2007, 12 (4): 70-74. (in Chinese with English abstract)

[75] 丁幼春,王书茂,陈红. 农用车辆作业环境障碍物检测方法[J]. 农业机械学报,2009,40(增刊1):23-27.Ding Youchun, Wang Shumao, Chen Hong. Obstacle detection in the working area of agricultural vehicle based on machine vision[J]. Transactions of The Chinese Society for Agricultural Machinery, 2009, 40(Supp.1): 23-27. (in Chinese with English abstract)

[76] Yin X, Noguchi N, Ishi K. Development of an obstacle avoidance system for a field robot using a 3D camera[J].Engineering in Agriculture Environment & Food, 2013, 6(2):41-47.

[77] 杨福增,刘珊,陈丽萍,等. 基于立体视觉技术的多种农田障碍物检测方法[J]. 农业机械学报,2012,43(5):168-172.Yang Fuzeng, Liu Shan, Chen Liping, et al. Detection method of various obstacles in farmland based on stereovision technology[J]. Transactions of The Chinese Society for Agricultural Machinery, 2012, 43(5): 168-172.(in Chinese with English abstract)

[78] 苟琴,耿楠,张志毅. 基于视差图的未知环境下农田障碍物检测方法[J]. 计算机工程与设计,2013,34(2):707-710.Gou Qin, Geng Nan, Zhang Zhiyi. Obstacle detection for farmland in unknown environment based on disparity image[J]. Computer Engineering and Design, 2013, 34(2):707-710. (in Chinese with English abstract)

[79] 韩永华,汪亚明,康锋,等. 基于小波多分辨率分解的农田障碍物检测[J]. 农业机械学报,2013,44(6):215-221.Han Yonghua, Wang Yaming, Kang Feng, et al. Detection of obstacles in farmland based on wavelet multi-resolution transform[J]. Transactions of The Chinese Society of Agricultural Machinery, 2013, 44(6): 215-221. (in Chinese with English abstract)

[80] Ball D, Upcroft B, Wyeth G, et al. Vision-based obstacle detection and navigation for an agricultural robot[J]. Journal of Field Robotics, 2016, 33(8): 1107-1130.

[81] Fleischmann P, Berns K. A stereo vision based obstacle detection system for agricultural applications[J]. Springer International Publishing, 2016:217-231.

[82] 姬长英,沈子尧,顾宝兴,等. 基于点云图的农业导航中障碍物检测方法[J]. 农业工程学报,2015,31(7):173-179.Ji Changying, Shen Ziyao, Guo Baoxin, et al. Obstacle detection based on point clouds in application of agricultural navigation[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2015,31(7): 173-179. (in Chinese with English abstract)

[83] Reina G, Milella A. Towards autonomous agriculture:automatic ground detection using trinocular stereovision[J].Sensors, 2012, 12(9): 12405-12423.

[84] Vázquezarellano M, Griepentrog H W, Reiser D, et al. 3-D imaging systems for agricultural applications-a review[J].Sensors, 2016, 16(5): 618-641.

[85] Corke P, Winstanley G, Roberts J, et al. Robotics for the mining industry: opportunities and current research[C]//Proc.Int. Conf. Field and Service Robotics. 1999: 208-219.

[86] Broggi A, Cappalunga A, Caraffi C, et al. TerraMax vision at the urban challenge 2007[J]. IEEE Transactions on Intelligent Transportation Systems, 2010, 11(1): 194-205.

[87] Milella A, Reina G. 3D reconstruction and classification of natural environments by an autonomous vehicle using multi-baseline stereo[J]. Intelligent Service Robotics, 2014,7(2): 79-92.

[88] Gée C, Bossu J, Jones G, et al. Crop/weed discrimination in perspective agronomic images[J]. Computers & Electronics in Agriculture, 2008, 60(1): 49-59.

[89] An Q, Li Z C, Ji C Y, et al. Agricultural robot vision navigation algorithm based on illumination invariant image.[J]. Transactions of the Chinese Society of Agricultural Engineering, 2009, 25(11): 208-212.

[90] Yenilmez L, Temeltas H. Real time multi-sensor fusion and navigation for mobile robots[C]//Electro Technical Conference, 1998. Melecon 98. Mediterranean. IEEE, 1998:221-225.

[91] Labayrade R, Royere C, Gruyer D, et al. Cooperative fusion for multi-obstacles detection with use of stereovision and laser scanner[J]. Autonomous Robots, 2005, 19(2): 117-140.

[92] Perrollaz M, Labayrade R, Royere C, et al. Long range obstacle detection using laser scanner and stereovision[C]//Intelligent Vehicles Symposium. IEEE, 2006: 182-187.

[93] Bertozzi M, Bombini L, Cerri P, et al. Obstacle detection and classification fusing radar and vision[C]//Intelligent Vehicles Symposium. IEEE, 2008: 608-613.

[94] 王葵,徐照胜,颜普,等. 基于激光测距雷达和机器视觉的障碍物检测[J]. 仪表技术,2012(8):29-32.Wang Kui, Xu Zhaosheng, Yan Pu, et al. Obstacle detection based on laser ranging radar and machine vision[J].Instrumentation Technology, 2012(8): 29-32. (in Chinese with English abstract)

[95] 汪佩,郭剑辉,李伦波,等. 基于单线激光雷达与视觉融合的负障碍检测算法[J]. 计算机工程,2017,43(7):303-308.Wang Pei, Guo Jianhui, Li Lunbo, et al. Negative obstacle detection algorithm based on single line laser radar and vision fusion[J]. Computer Engineering, 2017, 43(7): 303-308. (in Chinese with English abstract)

[96] Ohya A, Kosaka A, Kak A. Vision-based navigation of mobile robot with obstacle avoidance by single camera vision and ultrasonic sensing[J]. IEEE Transactions on Robotics & Automation, 1998, 14(6): 704-711.

[97] 戈新良,杨杰. 基于多传感器融合的机器人障碍物检测和识别[J]. 计算机仿真,2005,22(3):168-170.Ge Xinliang, Yang Jie. Obstacle detection and recognition of robotic based on multi-sensor fusion[J]. Computer Simulation, 2005, 22(3): 168-170. (in Chinese with English abstract)

[98] Kim P G, Chang G P, Yun H J, et al. Obstacle avoidance of a mobile robot using vision system and ultrasonic sensor[C]//International Conference on Intelligent Computing.Springer Berlin Heidelberg, 2007: 545-553.

[99] 王檀彬,陈无畏,焦俊,等. 多传感器融合的智能车辆导航研究[J]. 中国机械工程,2009(11):1381-1385.Wang Tanbin, Chen Wuwei, Jiao Jun, et al. Study on navigation of intelligent vehicles based on multi-sensor fusion[J]. China Mechanical Engineering, 2009(11): 1381-1385. (in Chinese with English abstract)

[100] Lu L. Fast obstacle detection based on multi-sensor information fusion[C]//International Symposium on Optoelectronic Technology and Application, 2014:93011K-93011K-7.

[101] Mobus R, Kolbe U. Multi-target multi-object tracking,sensor fusion of radar and infrared[C]//Intelligent Vehicles Symposium. IEEE, 2004: 732-737.

[102] Yamamoto K. Image processing and fusion to detect navigation obstacles[J]. Proceedings of SPIE - The International Society for Optical Engineering, 1998, 3374:337-346.

[103] Apatean A, Rogozan A, Bensrhair A. Information fusion for obstacle recognition in visible and infrared images[C]//International Symposium on Signals, Circuits and Systems. IEEE, 2009: 1-4.

[104] Wang Y. Application of multi-sensor information fusion technology to moving robot obstacle detection[J].Informatization Research, 2009, 35(1): 55-57.

[105] Qu D, Hu Y, Zhang Y. The investigation of the obstacle avoidance for mobile robot based on the multi sensor information fusion technology[J]. International Journal of Materials Mechanics & Manufacturing, 2013, 1(4): 366-370.

[106] Close R. Fusion of lidar and radar for detection of partially obscured objects[C]//SPIE Defense + Security. 2015: 6-14.

[107] Budzan S, Kasprzyk J. Fusion of 3D laser scanner and depth images for obstacle recognition in mobile applications[J].Optics & Lasers in Engineering, 2016, 77(7): 230-240.

[108] Giannì C, Balsi M, Esposito S, et al. Obstacle detection system involving fusion of multiple sensor technologies[J].The International Archives of Photogrammetry, Remote Sensing and Spatial Information Sciences, 2017, 42: 127-134.

[109] Liu P, Bi S, Zang G, et al. Obstacle avoidance system for agricultural robots based on multi-sensor information fusion[C]//International Conference on Computer Science and Network Technology. IEEE, 2012: 1181-1185.

[110] Ding X, Yan L, Liu J, et al. Obstacles detection algorithm in forest based on multi-sensor data fusion[J]. Journal of Multimedia, 2013, 8(6): 108-117.

[111] Yang Fuzeng, Wang Tao, Wang Yuanjie, et al.Mountainous region agricultural robot obstacle-avoiding system based on multi-sensor information fusion: CN 203012510 U[P]. 2013-06-19.

[112] Benet B, Rousseau V, Lenain R. Fusion between a color camera and a TOF camera to improve traversability of agricultural vehicles[C]// The 6th International Workshop Applications of Computer Image Analysis and Spectroscopy in Agriculture. 2016: 8-16.

[113] 江锽. 基于 Kinect的温室喷雾机器人视觉导航定位系统的研究[D]. 北京:北京林业大学,2015.Jiang Huang. Research of Greenhouse Spray Robot’s Visual Navigation and Positioning System Based on Kinect[D].Beijing: Beijing Forestry University, 2015. (in Chinese with English abstract)

[114] Rakprayoon P, Ruchanurucks M, Coundoul A. Kinect-based obstacle detection for manipulator[C]. Ieee/sice International Symposium on System Integration. IEEE, 2011: 68-73.

[115] 朱涛,芦利斌,金国栋. 基于 Kinect深度技术的障碍物在线快速检测算法[J]. 电子设计工程,2014(12):176-179.Zhu Tao, Lu Libin, Jin Guodong. Obstacle detection algorithm online based on Kinect depth technique[J].Electronic Design Engineering, 2014(12): 176-179. (in Chinese with English abstract)

[116] György Csaba, Zoltán Vámossy. Fuzzy based obstacle avoidance for mobile robots with Kinect sensor[C]//IEEE International Symposium on Logistics and Industrial Informatics. IEEE, 2012: 135-144.

[117] Nissimov S, Goldberger J, Alchanatis V. Obstacle detection in a greenhouse environment using the Kinect sensor[J].Computers & Electronics in Agriculture, 2015, 113(C):104-115.

[118] Zhu Y, Yi B, Guo T. A simple outdoor environment obstacle detection method based on information fusion of depth and infrared[J]. Journal of Robotics, 2016(9): 1-10.

[119] Hernández-Aceituno J, Arnay R, Toledo J, et al. Using kinect on an autonomous vehicle for outdoors obstacle detection[J]. IEEE Sensors Journal, 2016, 16(10): 3603-3610.