基于距离加权重叠度估计与椭圆拟合优化的精确目标跟踪算法

王 宁,宋慧慧,张开华

(1.江苏省大数据分析技术重点实验室(南京信息工程大学),南京 210044;2.江苏省大气环境与装备技术协同创新中心(南京信息工程大学),南京 210044)

0 引言

目标跟踪是计算机视觉领域中一项关键的基础性任务,其难点在于无法事先预知目标信息,仅在跟踪时定义目标,并要求推理出后续视频中目标的位置及其尺度信息,这是一种典型的训练样本少、待推理样本多的小样本学习任务(Few-Shot-Learning)。目标跟踪技术广泛应用于人机交互、自动驾驶、智能安防、交通监控、警务侦查和国防安全等重要场景。尽管此类技术的相关研究[1]已取得显著进展,但跟踪算法在处理非刚性形变、快速运动、目标干扰等复杂情况时仍存在严重不足,因此,视频目标跟踪问题依然具有极高的研究价值。

本文主要讨论短时的单目标跟踪问题。解决单目标跟踪问题的算法主要有三类:基于检测的算法、基于孪生网络的算法以及基于相关滤波的跟踪算法。随着目标检测领域的快速发展,涌现出了一系列优秀的检测相关跟踪算法[2-3],此类跟踪算法利用检测器检测视频中的感兴趣目标,并对视频图像之间的时序关系进行建模,来获得感兴趣目标的运动轨迹。此类算法在一定程度上解决了目标遮挡、目标消失重现问题;但由于检测速度受限,基于检测的跟踪算法难以满足实际应用场景的需求。近几年受全卷积孪生网络(Fully-Convolutional Siamese Network,Siam-FC)[4]跟踪算法的启发,研究人员提出了一系列的基于孪生网络的跟踪算法[5-6],其原理是利用卷积神经网络将目标和搜索区域的图像映射到高维的特征空间中,并在特征空间中计算目标向量与搜索区域向量之间的特征相似程度,从而寻找到相似程度最大向量的空间位置,从而实现跟踪定位。此类算法采用第一帧图像作为模板进行匹配,避免了在线训练更新模型,从而显著提高了算法运行速度,推动了跟踪算法领域的进一步发展。然而孪生网络的算法也存在明显不足:首先,因其采用“以图搜图”的机制,仅利用第一帧的目标区域作为模板进行匹配,难以处理相似物体较多的场景;其次,由于缺乏完备的在线更新机制,孪生网络算法应对目标外观剧烈变化场景的泛化能力不足;最后,孪生网络跟踪算法模型在离线训练时需要海量的数据,并预设较多人工设计的超参数,对计算资源需求较大,在处理未知物体的跟踪场景中表现不佳,遇到了发展瓶颈。

基于相关滤波的跟踪算法明显区别于前述两种类型。此类算法同时利用图像目标和背景区域训练一个分类器(相关滤波器),用以对新视频帧的目标和背景区域进行分类,从而实现定位。伴随着卷积神经网络的快速发展,此类算法从传统手工特征提取逐渐向深度神经网络特征提取过渡,出现了一系列相关滤波与深度特征结合的跟踪算法[7-11],此类跟踪算法需定时重新优化分类器的参数,以保证其强判别能力。但相较于基于孪生网络的最新算法,相关滤波类的算法在估计目标尺度的准确度方面依然存在巨大的差距。准确地估计目标物体的尺度对于衡量算法的性能至关重要,因此本文从改进相关滤波类算法的尺度估计方面进行深入研究。

针对相关滤波类跟踪算法中的跟踪漂移和尺度估计精度低的问题,本文提出了一种基于距离加权的重叠度估计和椭圆拟合优化的精确目标跟踪算法(Accurate object tracking algorithm based on Distance Weighting Overlap Prediction and Ellipse Fitting Optimization,DWOP-EFO),此算法考虑了跟踪过程中的空间位置信息以提高算法稳定性;同时,引入目标分割思想优化目标的轮廓,以得到最佳旋转矩形框,提升精度,进而提升算法整体性能。将本文算法应用在基线算法上,并在两个通用标准数据集上进行了对比实验,实验结果验证了本文算法的有效性。

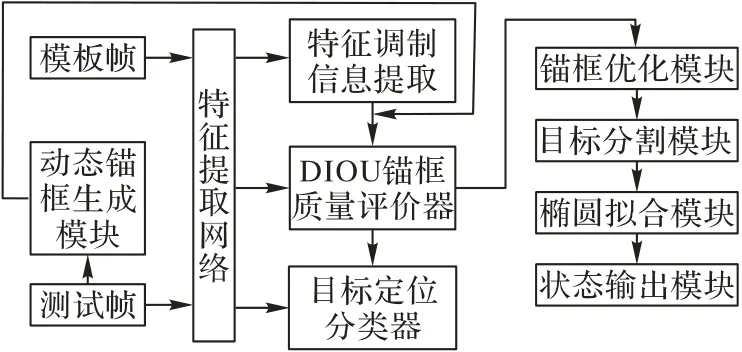

1 本文算法

本文跟踪算法主要包括两个部分:距离加权的重叠度估计和椭圆拟合优化输出。如图1 所示:前者包含动态锚框生成模块、特征提取网络、特征调制信息提取器、目标定位分类器、距离加权的锚框质量评价器(Distance weighted Intersection Over Union Predictor,DIOU)和锚框优化模块;后者包括目标分割模块、椭圆拟合模块和状态输出模块。该算法主要思想是从跟踪任务的角度看待动态锚框的空间位置信息对跟踪性能的影响,从而提出将锚框的中心与目标中心之间的距离因素作为评价锚框的质量分数的因素之一。与此同时,随着视频内容分析应用的快速发展,复杂场景对跟踪器的跟踪精度提出了新要求,为了进一步提升跟踪器的性能,本文提出一种将目标跟踪与目标分割相结合的算法,并采用椭圆拟合的方式对分割结果进行优化,以进一步提升算法的精度。本文算法的简要步骤是:定位、优化最佳的动态矩形框、分割目标区域、椭圆拟合输出旋转矩形框、根据置信度的状态输出最佳结果。

图1 本文算法框架Fig.1 Framework of proposed algorithm

1.1 基于相关滤波的跟踪算法

基于相关滤波的跟踪任务可分解为两个子任务:第一是目标定位任务,第二是尺度估计任务。采用深度特征网络的相关滤波算法展现出了较强判别能力,在跟踪器稳定性上实现了大幅提升。此类算法利用参考帧图像及其标签在线训练一个具有前、背景判别能力的相关滤波器,进而对目标执行定位操作,训练滤波器时的目标函数表达如式(1):

其中:xj表示提取模板图像所得训练样本特征;ω表示相关滤波器参数;f(xj;ω)表示变量执行互相关操作;yj是样本的标签信息,是由标注信息矩形框转化得到的高斯伪标签;γj是第j个样本权重表示样本对相关滤波器的影响程度;λk是权重参数ωk的正则化系数。通过最小化目标函数L(ω)的值,来优化相关滤波器ω的参数,经过一定次数的迭代即可训练优化得到高判别性的相关滤波器参数,从而可实现对后续图像中的目标的定位。

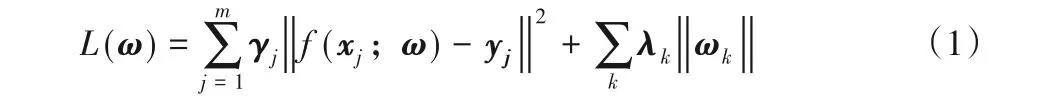

为了准确地估计出目标的最佳矩形框,ATOM[9]借鉴了基于获取定位置信度的准确目标检测算法IOU-Net[13]的思想,在目标定位点(锚点)附近随机生成n个动态锚框,通过预测动态锚框的质量分数的方式优化出质量分数最大的目标预测框,使跟踪器性能得到了大幅提升。但这种评价锚框的质量分数的算法仅考虑了重叠度这一因素,无法处理以下情况,如图2 所示:实线框为目标真实标签,虚线框是在定位点附近随机生成一个动态锚框。当图2 中的动态锚框(图中虚线框)尺寸相同即重叠度值相同,如式(2)所表达,但空间位置不同,如图2(a)、(b)、(c)中情况。

其中:IOU为实线框与虚线框交集面积与并集面积之比值。目前现有的锚框质量评价网络认为图中的三个虚线框的质量是相同的,此时无法选出最优的结果。但实际上在视频跟踪过程中,越靠近目标中心的锚框的质量应该越高,原因在于跟踪器在线更新过程中会将预测结果作为新的样本信息进行训练,偏离目标中心位置的锚框信息容易使得分类器累积过多误差,导致跟踪定位漂移到其他目标上。设动态锚框的实际质量为Q,那么图2 中动态锚框的客观质量应为:Qa<Qb<Qc。由此可见,仅采用区域重叠度指标来评价动态锚框质量的方式,存在指标单一,不适应于跟踪任务的问题。

图2 IOU相同但空间位置不同对比Fig.2 Comparison of same IOU with different spatial location

1.2 距离加权的重叠度估计网络

通常目标尺度估计算法有:尺度金字塔搜索[12]、区域推荐网络[13]和区域重叠度估计法[14]。此三种尺度估计方式在目标检测领域得到了成熟应用,并且尺度金字塔搜索和区域推荐网络技术也广泛应用在跟踪领域中,目标尺度估计的性能得到了提升。基于重叠度最大化的准确跟踪(Accurate Tracking by Overlap Maximization,ATOM)算法[9]首次将重叠度估计[14]的思想应用于跟踪领域,并显著提升了目标尺度估计的性能指标。

区域重叠度估计算法是通过预测动态锚框的质量分数来筛选出目标最佳矩形框。其中动态锚框是在定位点周围随机生成的多个不同尺度的矩形框。其质量分数采用预测框与标注框之间的区域重叠度交并比(Intersection Over Union,IOU)表示。通过对各动态锚框的质量分数进行排序即可优化得到目标的最佳尺度。这种预测动态锚框质量分数的算法,相较于尺度金字塔搜索[11]和区域推荐网络[12],具有尺度搜索空间小、尺度比例变化灵活、计算量少、搜索速度快的优点。

但上述锚框质量分数的计算算法仅仅考虑了矩形框集合之间的关系,并未考虑视频跟踪任务的定位需求,忽略了锚框与真实目标空间上的相对位置对跟踪性能的重要影响。在跟踪任务中,早期的定位误差会随视频流而放大,导致跟踪过程中发生模型漂移、跟踪失败等问题。

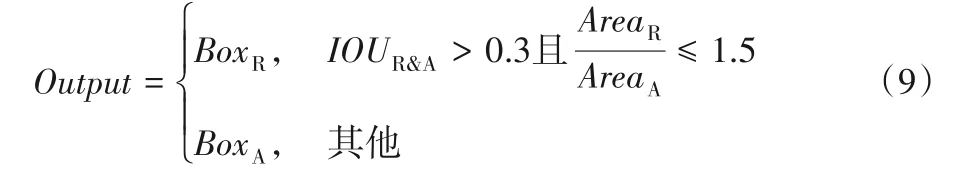

为了解决现有锚框质量评价方式单一、不适合跟踪任务的问题,本文改进原有锚框质量评价网络,设计了一个考虑区域中心距离的新的锚框质量评价网络。如图3所示,矩形S表示目标区域,矩形框R表示动态锚框,图3(a)表示仅采用重叠度分数值作为计算指标,其值为两个集合的交集与这两个集合并集的商,计算方式如式(3):

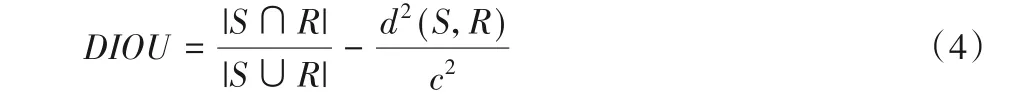

为了将空间距离因素考虑到目标的质量评价中来,受目标检测算法[15]启发,在目标跟踪算法中引入空间距离d,其中d表示目标区域S与矩形框区域R的区域中心点之间欧氏距离,从而形成新的锚框的质量评价器:距离加权的锚框质量评价器(DIOU),如图3(b)、(c)所示为IOU 和DIOU 分数计算算法示意图,其中DIOU计算如式(4)所示:

其中:c2表示两框并集的最小闭包框的对角线欧氏距离的平方,用来归一化不同尺度的矩形框;d2(S,R)表示计算区域S和区域R中心点之间的欧氏距离d的平方。可以发现DIOU是在IOU 的基础上增加了距离因素的惩罚项,用来衡量动态锚框的空间位置对其质量分数的影响。经过离线训练的DIOU 预测网络能够从跟踪算法的角度对动态锚框的质量进行客观准确评价,最终优化出重叠度高同时又处于目标中心附近的结果。

图3 IOU和DIOU分数计算算法示意图Fig.3 Schematic diagram of computing algorithm for IOU and DIOU scores

1.3 集成轻量目标分割网络的跟踪框架

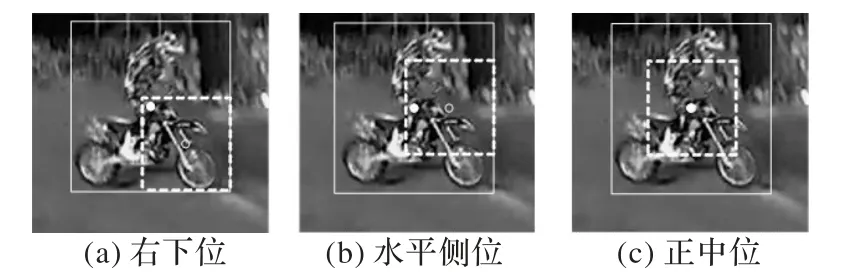

随着人工智能技术快速发展,高性能计算设备快速迭代,为性能更好的跟踪器提供了硬件基础。视觉目标跟踪领域的竞赛(Video Object Tracking,VOT)[16]每年都会提出非常具有挑战性的评测数据,来评判算法的跟踪性能。其数据集人工标注的效果如图4(a)所示,从早期标注的边长垂直坐标轴的正矩形框演变为如今最新标注的旋转矩形框。数据集标注形式越精细,对跟踪算法的性能要求就越高,给跟踪器的设计带来了巨大挑战。能否输出高精度的旋转矩形框成为提升算法性能的关键。受孪生网络系列算法[17]启发,本文提出在相关滤波跟踪网络框架中增加轻量化的离线训练的目标分割网络分支[18]来实现对跟踪目标邻域前、背景的分割,借助分割算法获取目标的精确轮廓,实现精度进一步提升。

图4 本文算法在不同阶段的跟踪结果。Fig.4 Tracking results of proposed algorithm in different stages

网络结构如图1 所示,目标分割网络对跟踪器可以表示如式(5):

其中:Icroped表示所裁剪的跟踪目标及其附近范围的图像;Fθ()表示提取图像特征的骨架网络;Mask()是分割网络模型,用来对目标前、背景进行分割;Output表示网络输出的分割结果,如图4(b)所示中的汽车,分割蒙板(mask)将汽车覆盖住,呈现浅色。目标分割网络分支将目标从背景区域内分割出来为后续进一步获取目标轮廓、优化目标尺度、输出目标的旋转矩形框提供了可能。

1.4 椭圆优化估计目标尺度的最佳尺度

分割蒙版(mask)经过形态学处理可以直接得到目标轮廓以及轮廓的最小闭包框,如一种快速在线目标跟踪与分割的统一算法SiamMask[17]。但由于受到分割噪声的干扰,直接求最小闭包框的方式容易导致目标矩形框尺度变化过快、抖动剧烈、无法正确反映目标的真实外观姿态,对跟踪器的性能产生不利影响。而基于旋转矩形框的快速跟踪算法SiamMask-E[19]中提出的旋转矩形框估计的算法需要复杂的矩阵变换优化操作,会严重影响算法的运行速度,不利于跟踪器实时快速跟踪。为实现快速输出稳定目标尺度,本文采用基于最小二乘法的椭圆拟合算法[20],对目标轮廓进行优化。具体步骤如下:

1)对分割得到的蒙版执行形态学操作,即可找到其连通域面积最大的轮廓,该轮廓上的点组成集合D。

2)利用集合D优化出一个最佳的椭圆E,使得集合D中的所有的点到椭圆曲线上的距离之和最短,算法原理如下:

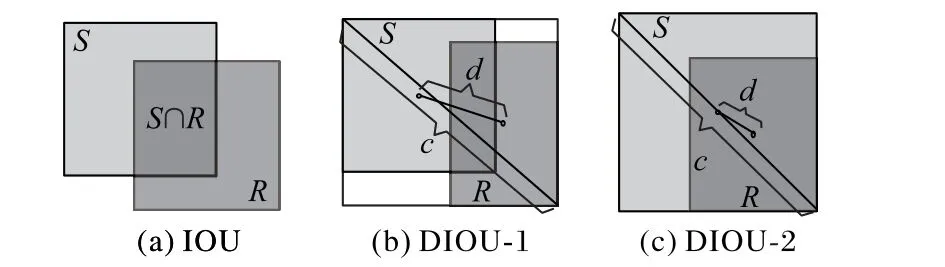

已知椭圆方程(式(6)):

其中:集合D中的点Pi=(xi,yi)到二次曲线F(A,X)=0 的欧氏距离为F(Ai,Xi)。拟合椭圆问题简化为动态优化出所有观测点到椭圆曲线上的距离之和的最小椭圆解,依据最小二乘原理,可利用图像处理工具包OpenCV 中的函数快速优化出最佳椭圆,如图4(c)所示。优化结果将输出椭圆的中心点坐标、长短轴值及其旋转角度,进而可以得到该椭圆状态所对应的旋转矩形框的顶点坐标。

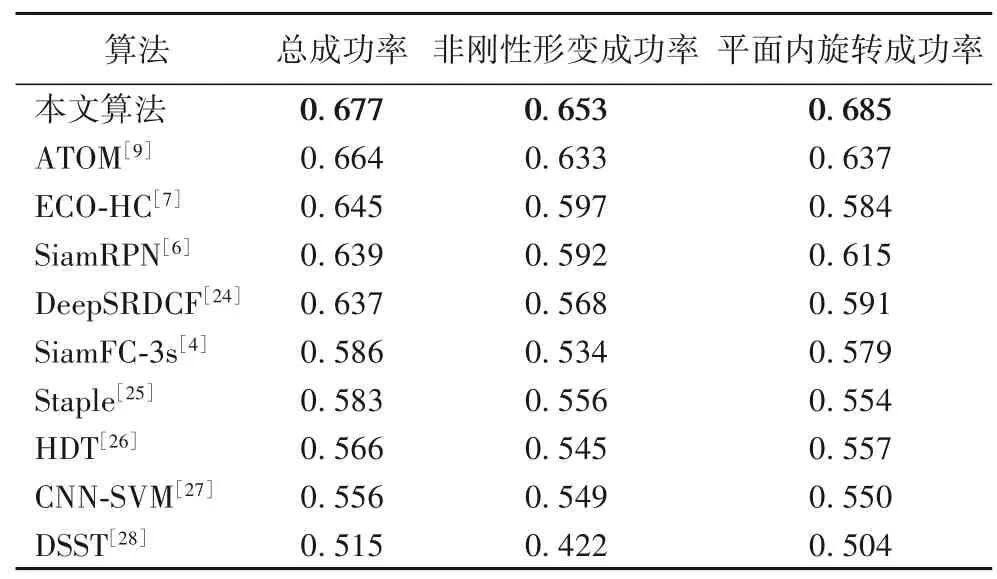

1.5 置信度门控输出与目标尺度更新策略

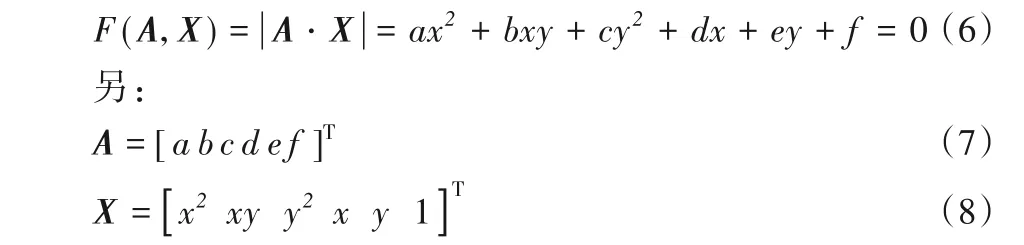

由于跟踪视频中常存在运动模糊、剧烈的光照变化等极端情况,这对目标分割网络分支的输出极为不利,容易导致椭圆优化输出的蒙版存在一定噪声,为此本文专门设计了尺度置信度门控输出模块。定义尺度置信度分数为旋转矩形框与DIOU-Net 网络输出的垂直矩形框之间的重叠度,并根据计算得到的尺度置信度分数来决定是否采信椭圆估计输出的旋转矩形框结果。当尺度置信度分数IOUR&A>0.3,并且旋转矩形框的像素面积与垂直矩形框的面积之比时,输出旋转矩形框结果,用BoxR表示;否则输出正矩形框,用BoxA表示。

根据式(9)中控制结果Output的数值,从而达到门控输出跟踪状态的目的。

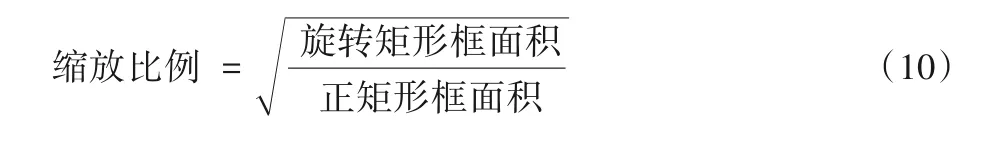

基于相关滤波的算法通常每隔一定周期会利用定位效果较好的样本对相关滤波器进行更新参数。本文算法得到的旋转矩形框结果如图5 所示,在生成高斯标签时需要将旋转矩形框转换为边长平行于坐标轴的正矩形框,为了尽可能地减少背景区域对滤波器训练的干扰,本文算法采用保守的标签生成策略:对目标的外接正矩形框进行尺度上的缩放。缩放比例为旋转矩形框与外接正矩形框面积之比的平方根。缩放比例计算方式如式(10):

图5 矩形框之间的转换Fig.5 Transformation between bounding boxes

2 实验设置及结果分析

实验在Ubuntu16.04、Inter Core i7-8700CPU @3.20 GHz、64 GB 内存、2*RTX2080Ti显卡平台上进行训练和测试。将本文算法应用在18 层的残差特征提取骨架网(Deep Residual Learning for Image Recognition,ResNet18)[20]上得到算法命名为OURS-18,应用到50 层的残差特征提取骨架网络ResNet50[21]上得到的算法命名为OURS-50,两者均借助深度跟踪算法框架Pytracking[9,11]进行代码实现。为了公平比较,在训练“考虑空间距离的动态锚框质量评价网络DIOU-Net”时,实验参数与ATOM 算法保持一致,在跟踪框架中集成目标分割网络DeepMask[18]以实现在线跟踪过程中的对目标快速分割。算法采用Python 语言、PyTorch 框架以及OpenCV 等工具包实现,并采用流行的PySot-toolkit[5-6]工具对跟踪结果进行评估。

为了评估本文算法的有效性,在两个广泛使用的具有挑战性标准评测数据集VOT2018(the sixth Visual Object Tracking challenge results)[16]和 OTB100(Object Tracking Benchmark)[22]上进行实验,并与基于孪生网络和相关滤波的代表性算法进行了比较。

2.1 VOT2018评测数据集上的对比

VOT2018 评测数据集是视觉目标跟踪比赛的标准数据集,包含60 个人工精细标注的极具挑战性的视频序列。相较于其他的评估数据集,具有相似目标多、目标非刚性形变大、目标物体尺度小、运动失真多等特点。其特有的跟踪失败再重启的机制,能够提高数据的利用率,全方位评估算法的性能。VOT 竞赛官方规定的跟踪器性能评价指标为鲁棒性(Robustness)和精度(Accuracy)。鲁棒性反映了跟踪器跟踪目标的稳定程度,其指标值与评测过程中跟踪器丢失目标次数正相关。丢失次数越少,该指标值越低,反映算法鲁棒性越好,稳定程度越高。精度反映了跟踪算法估计物体尺度的精确程度,其分值为预测矩形框与标签矩形框之间的平均区域重叠度,分值越高,反映算法性能越好。VOT竞赛官方将两个指标融合为平均期望重叠率(Expected Average Overlap,EAO)指标来综合评价跟踪器的性能。由此可知,跟踪器性能比较时,鲁棒性值越低,精度值越高,EAO值越高,跟踪器性能越好。

图6显示了本文算法在VOT2018数据集的短时单目标跟踪赛道上的平均期望重叠率排名。从图6 中排名可以发现,在同一特征提取网络前提下,本文OURS-50 算法以EAO 值为0.459 排名第一,超过第二名基于可学习的判别模型跟踪器DiMP-50(learning Discriminative Model Prediction for Tracking)[11]的结果1.9个百分点;OURS-18以EAO指标0.423排名第三,超过第四名ATOM[9]的结果2.2 个百分点。同时OURS-50 和OURS-18 分别超过VOT2018 的冠军SiamRPN(High performance visual tracking with Siamese Region Proposal Network)[6]的结果7.6 和4.0 个百分点,证明了本文算法的竞争力。

图6 VOT2018数据集上的平均期望重叠分数排名Fig.6 Excepted average overlap score ranking on VOT2018 dataset

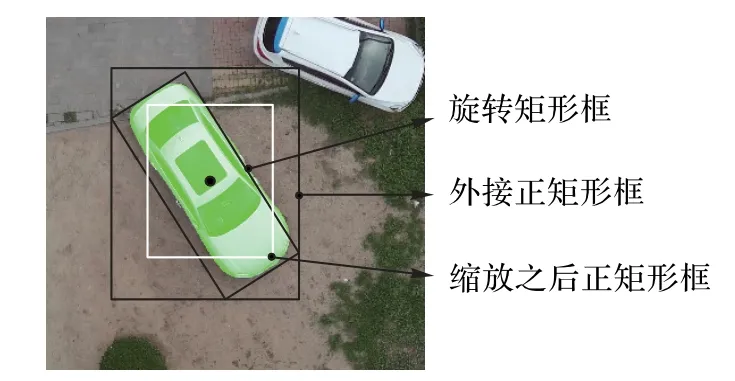

如表1 所示,给出了本文算法与几个性能领先的跟踪器各指标的对比,其中包括孪生网络系列算法SiamMask[5]、SiamPRN++(Evolution of Siamese visual tracking with very deep networks)[23]、SiamMask-E[19]以及相关滤波算ATOM[9]和DiMP[11]实验结果表明,本文算法OURS-18的跟踪精度指标比ATOM 算法高1.0 个百分点,OURS-50 比DiMP[11]高2.0 个百分点,精度得到了显著提升。对比相关滤波算法和孪生网络算法,当算法的精度水平相当时,相关滤波类的算法比孪生网络判别能力更强,具有更强鲁棒性,综合性能更优。表1 中:箭头向上表示其值越高,性能越好;箭头向下表示其值越低,性能越好。

表1 不同算法在VOT2018数据集上的对比Tab.1 Comparison of different algorithms on VOT2018 dataset

2.2 OTB100评测数据集上的对比

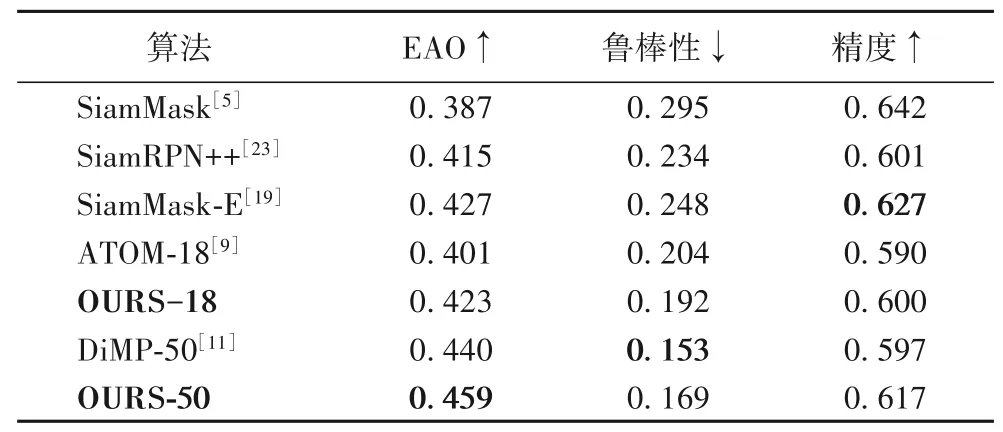

OTB100[22]是视觉跟踪领域广泛使用的标准评测数据库,包含100 个人工标注的视频序列,并包含不同的难度属性,例如尺度变换、非刚性形变、平面内旋转、遮挡等11 种情况。在OTB100数据集中,算法性能主要由成功率衡量。成功率表示数据集中重叠度IOU 得分超过阈值0.5 的帧数占视频总帧数的百分比。OTB100 数据集标注形式不同于前述的VOT 数据集,OTB100 采用正矩形框的方式对目标进行标注,评测方式中无重启机制,仅在视频的第一帧提供标签,然后运行跟踪算法得到成功率,采用一次通过测试(One Pass Evaluation,OPE)的方式进行评估算法性能。表2 分别显示了本文所提OURS-18 跟踪算法和9 个先进算法在OTB100 数据集上跟踪结果对比,表2中粗体部分表示该列指标最好。对比的9个算法分别是:ATOM、ECO-HC(Efficient Convolution Operators for tracking with Hand-Crafted features)[7]、SiamRPN[6]、DeepSRDCF(Deep Spatially Regularized Discriminative Correlation Filter)[24]、Staple[25]、HDT(Hedged Deep Tracking)[26]、CNN-SVM(Convolutional Neural Network-Support Vector Machine)[27]、DSST(Discriminative Scale Space Tracker)[28]和具有3种尺度估计框的SiamFC-3s[4]。表2 展示了总成功率、非刚性形变成功率和平面内旋转成功率三个属性的性能指标。观察可知,本文算法成功率指标0.677 超过ATOM 算法[9]1.3 个百分点;超过ECO-HC[7]3.2 个百分点;超过SiamRPN 算法[6]3.8 个百分点,综合性能提升显著。非刚性形变和平面内旋转场景对于跟踪器来难度较大,本文算法在这两个属性上效果显著,非刚性形变成功率上相较于第二名ATOM[9]提升了2个百分点,达到0.653;平面内旋转属性上相较于第二名ATOM[9]高4.8 个百分点,达到0.685。

表2 不同算法在OTB100数据集上的对比Tab.2 Comparison of different algorithms on OTB100 dataset

2.3 本文算法的可视化效果展示

为了直观展现本文所提算法的效果,对跟踪结果进行了可视化,如图7 所示。本文算法在跟踪第一行的篮球运动员时,尽管有多个相似目标的干扰,仍能准确地将其从背景中分割出来,体现了所提算法的鲁棒性和精度。跟踪第二行的骑自行车的孩子时,尽管受到灌木丛遮挡,但仍能准确地跟踪并分割,体现了跟踪的鲁棒性。在跟踪第三行的赛马时,跟踪器能够将马与人准确地区分,不容易发生模型漂移。可视化实验验证了本文所提算法有效性。

图7 本文算法的跟踪效果示例Fig.7 Examples of tracking results of proposed algorithm

3 结语

本文从跟踪算法的鲁棒性和精度两个方面对现有的相关滤波类的算法进行了改进:一是指出空间位置信息在跟踪任务的重要作用,突破了既有算法仅考虑重叠率的局限性;二是在跟踪算法中引入分割的思想,以此提高跟踪器对目标的估计精度。实验结果表明,空间位置加权重叠度与分割网络结合的方法能够显著提升跟踪器的综合性能。

随着计算机性能的逐步提高,视觉跟踪任务将逐步从“矩形框”级别跟踪,逐渐过渡到“像素”级别跟踪。本文提出的方法缩小了目标跟踪任务与目标分割任务之间的差距,后续可基于本文,将视觉目标跟踪与视觉目标分割两个任务统一结合起来进行深入研究,有望进一步提升算法的性能。