融合空间和通道特征的高精度乳腺癌分类方法

许学斌,张佳达*,刘 伟,路龙宾,赵雨晴

(1.西安邮电大学计算机学院,西安 710121;2.陕西省网络数据分析与智能处理重点实验室(西安邮电大学),西安 710121)

0 引言

癌症是目前世界范围内人类疾病和死亡的主要原因之一。根据世界卫生组织国际癌症研究机构2020年2月发布的《2020 年癌症报告》,在2018 年有960 万人死于癌症,并预计2040年将有2 700万新发病例[1]。对于女性而言,乳腺癌是全球发病率和死亡率最高的癌症,2018 年全球女性乳腺癌发病率为24.2%,死亡率为15%。早期发现在癌症诊断中起着关键作用,可以提高长期生存率[2]。乳腺癌的诊断通常采用放射学图像分析进行初步检查,如乳腺X 线诊断(X-rays)[3]、超声检查(B 超)[4]、热成像[5]等,以确定异常部位。然后,如果检查显示有恶性组织生长的可能,再进行乳腺组织活检。活检即取组织在显微镜下研究是否存在癌症,是鉴别某个部位是否癌变的唯一可靠方法[6]。但是,传统的人工诊断需要具有专业知识的专家进行高强度的工作,主观想法对乳腺肿瘤的诊断结果影响较大,并且缺乏诊断经验的病理学家容易出现诊断错误。研究表明,利用计算机辅助诊断(Computer-Aided Diagnosis,CAD)对乳腺组织病理图像进行自动、精确的分类,不仅可以为医生提供了更加客观、准确的诊断参考,也可以提高医生的诊断效率和诊断的准确率[7]。

虽然乳腺癌诊断的影像自动处理作为一个研究课题已经探索了很多年,但由于需要分析的图像比较复杂,因此仍然具有一定的挑战性。有研究人员利用特征描述符和机器学习算法,对乳腺组织病理图像进行分类。常采用的特征描述符有:局部二值化、尺度不变特征变换、方向梯度直方图等,机器学习分类算法有:主成分分析(Principal Component Analysis,PCA)、支持向量机(Support Vector Machine,SVM)、随机森林等。通过利用特征描述符提取图像的形态和纹理等相关特征信息,然后使用机器学习分类器对其进行分类,从而实现对乳腺组织病理图像的分类[7-8]。Zhang 等[9]提出了一种基于单类核主成分分析(Kernel Principal Component Analysis,KPCA)模型的分类方案,将乳腺癌组织病理学图像分为良、恶性(二分类),准确率达92%。该方法使用了一种简单的数据集,只覆盖了病理图像的重要区域,因此具有较高的准确率;然而,在活检扫描中通常很难找到只包含最重要组织的感兴趣区域(Region Of Interest,ROI)。Spanhol等[10]介绍了一个乳腺癌组织病理学图像数据集(BreaKHis),并在该数据集上使用不同的特征描述符和不同的传统机器学习分类算法将病例分为良性或恶性,准确率范围为80%~85%。Chan 等[11]使用SVM 对40 倍放大的乳腺癌组织病理图像进行分类实验,将乳腺肿瘤分为8 种亚型(多分类),准确率仅为55.6%。可见特征描述符和机器学习算法并不能实现高精度的乳腺癌病理图像分类,特别是乳腺亚型多分类。近年来,随着深度学习的发展,卷积神经网络(Convolutional Neural Network,CNN)在大规模图像识别中取得了巨大的成功。与基于传统机器学习算法不同,CNN是由卷积层、池化层和全连接层等不同操作组成的多层网络,通过不断地自动优化分类损失函数,可以直接从输入的原始图像中学习有用的特征,从而实现对乳腺组织病理图像的分类,避免了人工寻找病理图像的ROI,也提高了分类准确率。在2016 年,Spanhol 等[12]又利用深度卷积神经网络(Deep Convolutional Neural Network,DCNN)模型AlexNet对乳腺癌病理图像进行良性和恶性二分类,准确率为85%~90%,明显高于文献[10]中使用的机器学习方法。詹翔等[13]基于Inception-V3,并对其进行改进,提出一种基于深度卷积神经网络的乳腺病理图像分类方法,二分类实验的平均精度为97%,但是在多分类实验上只有89%。Wei等[14]提出了一种数据增强方法和一种基于CNN 的新型乳腺组织病理图像分类方法BiCNN(breast cancer histopathological image classification method based on deep convolutional neural networks),二分类的准确率达到97%。Jiang 等[15]提出了一种小型的SE-ResNet 模块和一种新的学习率调度器,设计了一种乳腺癌组织病理学图像分类网络(Breast cancer Histopathology image Classification Network,BHCNet),实验结果表明该方法分类性能很好,二分类的准确率为98.87%~99.34%,对多分类的准确率为90.66%~93.81%。

尽管深度学习模型,相比机器学习算法,在乳腺癌组织病理图像分类中表现得更好,提高了对乳腺癌病理图像分类的效率和准确性,并且对乳腺肿瘤良性和恶性二分类的准确率最高也达到了99.34%,但是由于病理图像自身固有的复杂性和多样性的特点,对乳腺肿瘤8 种亚型的分类准确率并不是很高,所以为了满足临床应用的需求,乳腺病理图像多分类问题的准确率仍有待提升。本文利用DenseNet和SENet的设计思想,融合空间特征信息和通道特征信息,提出了一种融合图像空间特征信息和通道特征信息的高精度乳腺癌组织病理图像分类模型,将该网络模型命名为BCSCNet(Breast Classification fusing Spatial and Channel features Network),并且,通过使用数据预处理和数据增强来处理数据集,在乳腺癌组织病理图像数据集(BreaKHis)上进行模型训练和测试,验证了本文算法可以对乳腺癌组织病理图像进行高精度的分类。

1 相关工作

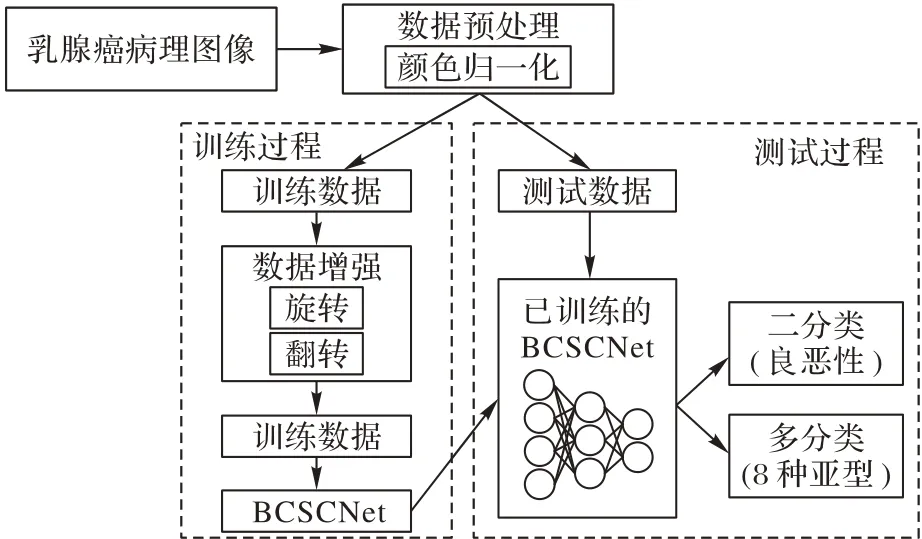

本文提出的分类算法流程如图1 所示,基本流程为:乳腺癌病理图像数据集经过数据预处理之后分为训练数据和测试数据;然后训练数据再经过数据增强得到新的训练数据;接着将得到的数据在乳腺癌病理图像分类网络BCSCNet中进行训练;最后将测试数据输入到训练好的BCSCNet中进行测试,从而完成对乳腺癌病理图像的分类。

图1 乳腺癌病理图像的分类过程Fig.1 Classification process of pathological images of breast cancer

1.1 数据集

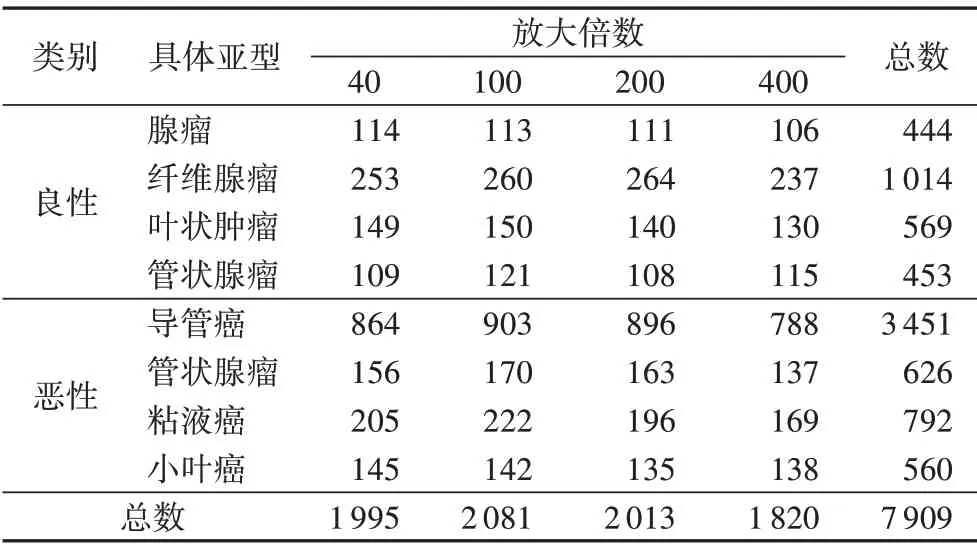

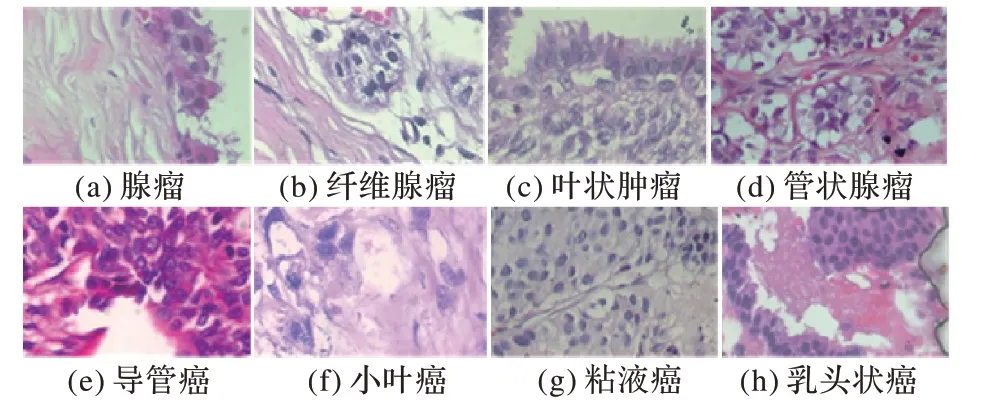

本文使用的数据集为乳腺癌组织病理学数据库(BreakHis)[10],BreakHis 包含良性和恶性乳腺肿瘤的显微活检图像。BreakHis 是目前所公开的乳腺癌组织病理图像数据集中数据量最大、类型较最全面的数据集,并且具有多种不同的放大倍数,识别难度也相对较高,在此数据集上进行实验的说服力要强于其他数据集。数据集共有7 909 张乳腺肿瘤组织显微图像,包括良性样本2 480 张,恶性样本5 429 张,放大倍数有4 种:40、100、200 和400。图像采用PNG 格式,RGB 三通道,700×460像素。该数据集目前包含4种不同亚型的良性乳腺肿瘤:腺瘤、纤维腺瘤、管状腺瘤和叶状肿瘤;以及4 种恶性肿瘤(乳腺癌);导管癌、小叶癌、粘液癌和乳头状癌。表1展示了不同子类型的数据集在不同的放大倍数下数量。8 种不同类型的乳腺病理图像如图2所示,放大倍数为400倍。

表1 不同型的数据集在不同的放大倍数下数量Tab.1 Number of datasets of different subtypes at different magnification

图2 放大倍数为400倍的部分图像数据Fig.2 Partial image data with a magnification of 400

1.2 数据预处理和数据增强

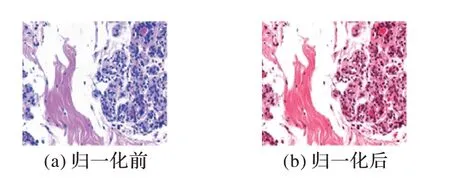

在组织图像中,预处理是去除不同类型噪声的关键步骤,同时对数据进行预处理可以简化数据,提高网络模型的训练速度,从而提升特征提取和识别的可靠性。又因为BreakHis数据集中的病理图像数据采取了不同的染色方式,会给组织病理图像带来颜色上的差异,这虽然对受过专业训练的病理学专家来说不是一个大障碍,但是这对于自动图像处理来说是一个很大的问题,可能会给最终的结果带来很大的影响。因此,需要对原始数据集进行数据预处理,但是直接对原始图像进行灰度处理,会对病理图像造成信息丢失,所以本文使用文献[16]中提出的方法对数据集进行归一化(Normalization),该方法是一种新的结构保留颜色归一化方案,该方案将一幅图像的颜色变换为另一幅图像的颜色,同时可靠地保持了源图像结构信息的不变性。该归一化方案的一个关键步骤是通过稀疏正则非负矩阵分解实现源图像和目标图像的精确着色分离。文献[16]也通过实验证明了所提出的染色分离和颜色归一化技术的优越性能。图3为归一化前后的病理图像。

图3 归一化前后的病理图像Fig.3 Histopathology image before and after normalization

因为数据量过小会使CNN 在训练过程中出现过拟合[17],这意味着网络在训练数据上表现很好,但在测试数据上表现较差,导致CNN 的性能下降。因此为了获得更高的准确率,本文使用数据增强对原始数据集进行数据扩充,即利用已有的数据扩充数据集的过程,比如缩放、翻转和旋转等变换,从而增加训练样本的数量,避免CNN 的过拟合问题。由于乳腺癌的病理图像是具有旋转不变性的,病理学家可以很容易地从不同角度分析乳腺癌的病理图像,而诊断没有任何变化[18]。但是对于CNN 而言却是一张与之前不一样的图像,但是其标签一致,所以经过增强数据训练得到的模型泛化能力也更强了。本文实验主要使用旋转和翻转来增强数据。

1.3 卷积神经网络

近年来,深度学习迅速发展,随即出现了大量的CNN 模型,包括在1998 年提出的LeNet5,以及后来的AlexNet、DenseNet、SENet等。研究证明,CNN已经取得了很大的成功,被计算机视觉界广泛采用,适合处理图像分类、图像识别之类的任务。

一个CNN 的结构主要有若干个卷积层和池化层,并在其后选择至少一个完全连接层,其中卷积层有多个具有可训练权重的卷积核,通过将图像与每个卷积核卷积,并在卷积层中加入偏置,最后产生多个特征图。池化层是一种非线性下采样的过程,可以保存任务的相关信息,增大特征图的感受野,同时去除不相关的细节。前面的卷积层和池化层是对图像进行特征提取,全连接层就是将提取的特征进行分类,通过把特征映射到神经元中从而实现分类。

图4展示的是一个简单的CNN模型,它包含了输入层、卷积层、池化层和输出层(全连接层),其中卷积层和池化层都是两个。第1 层是输入层,输入图像的大小是28×28;第2 层是卷积层1,通过与输入图像进行卷积获得多个不同的特征图,经过卷积层1 的输出特征图大小变为24×24;第3 层是池化层1,通过计算从卷积层1 输出的特征图的局部平均值或最大值增大感受野,池化层1会将特征图大小变为12×12。后面的卷积层2和池化层2除了卷积核的数量和大小不同,其计算方式都与之前类似。最后一层是全连接层,与前面计算出来的特征图进行全连接计算可以输出该模型的最终结果。

图4 简单的CNN模型结构Fig.4 Structure of simple CNN model

2 网络模型

2.1 稠密神经网络

稠密神经网络(DenseNet)是由Huang 等[19]提出,该网络以前馈方式将每一层连接到其他层。一般而言,具有L层的传统卷积网络具有L个连接,每一层与其后一层之间只有一个直接连接,而DenseNet 是采用一种密集连接的方式,在具有L层的DenseNet中共有L(L+1)/2个连接。对于密集连接的每一层,在其前面所有层产生的特征图都用作该层的输入,然后由该层产生的特征图则用作后续所有层的输入。DenseNet通过这种密集连接,重复利用来自前面多层特征图的特征信息,在减少参数的同时提升网络的效率。

DenseNet主要由稠密块(DenseBlock)和过渡层(Transition Layer)组合而成。其中稠密块中具有多个子模块,子模块之间通过密集连接将不同子模块之间的特征图通道进行合并。如第L层出的特征图通道数是n,且第L+1 层经过特征提取之后的特征图通道数为m,则第L+1层输出的特征图通道数为n+m。而过渡层是连接两个相邻的稠密块,并且通过池化层使特征图大小降低,增大感受野的同时减少网络参数。

传统卷积神经网络中,在l层的输出为:

而对于稠密块中的某个子模块,会将前面所有层作为该子模块的输入,即子模块的输出为:

其中:H(⋅)代表非线性组合函数,x代表l层前面的其他层输出的每一个特征图。

DenseNet 通过建立不同层之间的密集连接,进一步减轻了梯度消失问题,同时利用了网络模型的浅层特征,使网络学习到更多的特征信息,达到了特征重用的目的。与ResNet 等其他深度卷积神经网络模型相比,减少大量的训练参数,有效抑制了模型训练过程中出现的过拟合现象,使得DenseNet 的泛化能力更强、性能更优。

2.2 压缩和激励网络

传统的卷积变换,即将输入变为输出,是将各个通道的卷积结果进行求和,其公式可表示为:

其中:U表示该层最终的输出矩阵,U∈RH×W×C;X表示对应层输入特征矩阵,表示由X转为U的卷积操作,代表一个卷积核,输入一个通道上的空间特征,它学习特征空间关系,但由于对各个通道的卷积结果是直接进行相加操作,所以通道特征关系与卷积核学习到的空间关系混合在一起。这种传统的卷积操作只是实现对一个局部区域空间上的特征融合,并没有实现通道间的特征融合,但每个通道的重要程度不同,有的通道更有用,有的通道则不太有用。

为了解决上述传统卷积没有利用特征图通道信息的问题,Momenta 公司的Hu 等[20]提出了一种深度卷积神经网络压缩和激励网络(Squeeze-and-Excitation Network,SENet),其主要创新为压缩-激励(Squeeze-and-Excitation,SE)模块,总体结构如图5 所示,主要包括压缩和激励两个操作。SE 模块利用反向传播来学习每个特征通道的权重系数,这个权重系数代表着该通道的重要程度,然后依照这个权重系数提取通道的特征信息,实现通道间的特征融合,从而提升网络的性能。

图5 SE模块的总体结构Fig.5 Overall structure of SE module

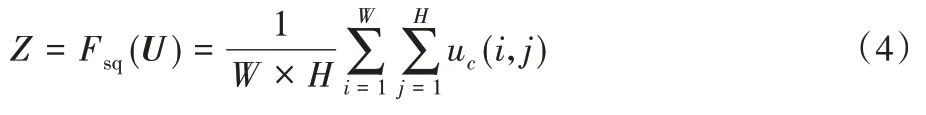

首先是压缩操作,为了使网络模型学习特征通道的信息,通过压缩每一个特征通道将其转化为实数,利用这个实数来代表该实数所对应的的特征通道的全局分布。压缩操作输出的实数数量与输入的特征通道数量相同。这个操作即为图5中的Fsq(⋅),采用全局平均池化(Global AvgPooling,GAP)来实现,计算公式为:

其中:Z为压缩操作得到的结果,W、H为输入特征的尺寸,C为输入特征的通道数,uc(i,j)为输入特征第c通道中第i行第j列的值。

压缩操作得到了全局描述特征,接下来为了学习到多个通道之间的非线性关系,降低模型复杂度以及提升泛化能力,SENet 提出激励操作,采用包含两个全连接(Fully Connected,FC)层的结构,其中第1个FC层起降维作用,第2个FC层恢复原始的维度。这个操作即为图4中的Fex(⋅,W),计算公式为:

其中δ和σ分别代表激活函数ReLU和sigmoid;W1∈分别为两个FC 层的权值矩阵;r为FC 层层数,文中该值为16。

最后将压缩和激励两个操作学习到的各个通道的激活值S乘以U的原始特征,即图5中的Fscale(⋅,⋅)操作,计算公式为:

SE 模块让模型可以更加关注信息量最大的通道特征,而抑制那些不重要的通道特征,实现对一个局部区域通道上的特征融合。

2.3 乳腺癌病理图像分类方法

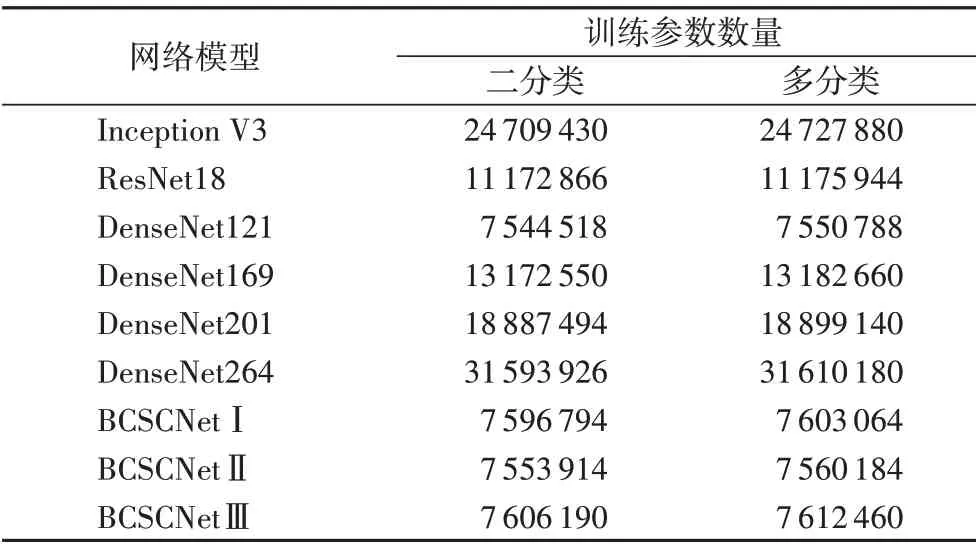

DenseNet 通过密集连接,充分利用每一层的图像特征信息,进一步减轻梯度消失的问题,有效抑制了训练过程中过拟合现象。与ResNet 相比,DenseNet 可以以更少的训练参数达到更优的结果[19,21],所以本文使用的基础网络模型为训练参数数量较少的DenseNet121,训参数总量远远少于ResNet18、DenseNet169、DenseNet201等,具体参数量的对比如表2所示。但是DenseNet 只是实现了空间上的特征融合,而SENet 的创新在于加入SE模块,进而使网络可以学习通道之间的关系和不同通道特征的重要程度。

表2 不同网络模型的训练参数数量Tab.2 The number of training parameters of different network models

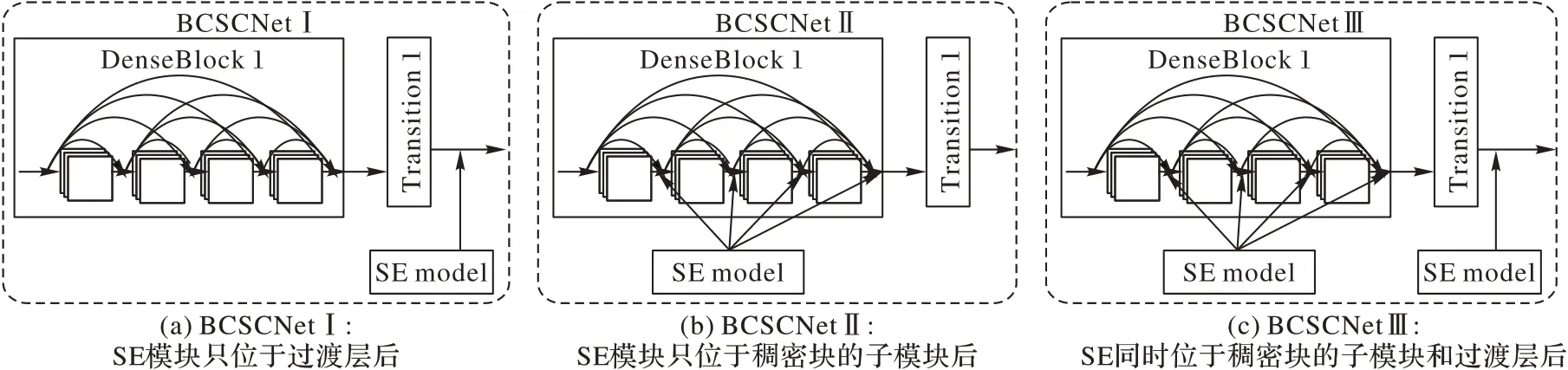

本文借鉴SENet 的思想,在DenseNet121 中引入压缩和激励操作,提出了一种融合了空间特征和通道特征的乳腺癌病理图像分类网络(BCSCNet),使得网络既可以实现空间上的特征融合也可以学习到特征通道之间的关系,进一步提高网络的性能。根据SE 模块的插入位置和插入数量,设计了3 种不同的BCSCNet 网络模型,分别为BCSCNetⅠ、BCSCNetⅡ和BCSCNetⅢ,并通过实验分析找出对乳腺癌组织病理学图像分类精度最高的一种。SE模块插入的位置如图6所示。

图6 不同网络模型SE模块的插入位置Fig.6 SE module insertion locations for different network models

3 种网络模型的详细架构如表3 所示,这3 种不同网络模型的区别在于SE 模块处于网络中的位置和网络中嵌入的SE模块的数量。

表3 三种BCSCNet模型的详细网络架构Tab.3 Detailed network architecture for three kinds of BCSCNet model

从表3 可以看出,几种BCSCNet 具体架构的详细差异。BCSCNetⅠ主要由4 个稠密块、3 个过渡层和3 个SE 模块组成,SE模块嵌入在过渡层之后,其中稠密块1、稠密块、稠密块3、稠密块4 分别由6、12、24、16 个子模块构成。BCSCNetⅡ的SE 模块位于稠密块的子模块之后,主要由4 个稠密块、3 个过渡层和58个SE模块组成,其中稠密块、过渡层和SE模块的结构和BCSCNetⅠ一样,不同的只有SE 模块的位置和数量。BCSCNetⅢ是上述两个类型的结合,将SE 模块嵌入到稠密块的子模块和过渡层的后面,总共有61个SE模块,除了SE模块的位置和数量之外,其他结构和另外两个类型一样。

以BCSCNetⅠ为例,数据从输入网络到输出的步骤为:

1)首先经过卷积核为7×7,步长为2的卷积层;

2)下一层是3×3,步长为2的平均池化层;

3)下一层是稠密块1,其子模块为1×1 卷积和3×3 卷积组成,子模块总共有6个;

4)下一层是过渡层,由一个1×1卷积层、池化窗口为2×2,步长为2 的平局池化层和一个SE 模块组成,所有过渡层结构一样;

5)下一层是稠密块2,子模块结构不变,数量为12个;

6)下一层是过渡层;

7)下一层是稠密块3,子模块结构不变,数量为24个;

8)下一层是过渡层;

9)下一层是稠密块4,子模块结构仍不变,数量为16个;

10)最后一层是由GAP 和FC 构成的分类层,FC 的激活函数为softmax,输出个数根据二分类还是多分类设置2或者8。

3 实验结果与分析

实验使用的计算机配置为:64 位的Windows 10 操作系统,CPU 为Intel Core i5-9400F,内存64 GB,GPU 加速显卡是NVIDIA GeForce RTX 2080 Ti,深度学习框架使用的是TensorFlow2.3。由于本实验是为了对乳腺癌组织病理学图像进行分类,使用的评价指标有准确率(Accuracy)、精准率(Precision)、查全率(Recall)和F1值(F1 Score)。

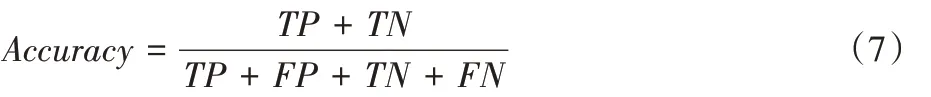

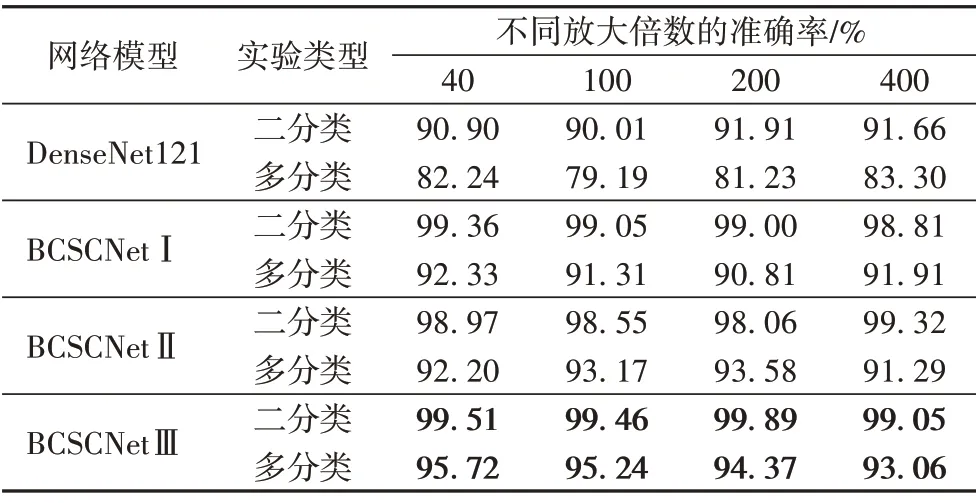

准确率为:

精准率为:

召回率为:

其中:TP(True Positive)代表真正例,即被正确预测为正例的个数;FN(False Negative)代表假负例,即被错误预测为负例的个数;FP(False Positive)代表假正例,即被错预测为正例的个数;TN(True Negative)代表真负例,即被正确预测为负例的个数。

F1值为:

3.1 验证预处理和数据增强的影响

为了验证数据预处理和数据增强对分类结果的影响,本文利用BCSCNetⅠ来进行实验对比。首先将没有经过处理的原始数据集BreaKHis 输入到BCSCNetⅠ进行训练和测试,得到未经数据预处理和数据增强的实验结果。然后再对原始数据进行预处理,为了消除数据集中数据不均衡的影响,选取BreaKHis 数据集中2 000张良性肿瘤病理图像和2 000张恶性肿瘤病理图像作为原始数据集,然后按照训练集、验证集、测试集7∶1∶2 的比例随机进行划分,并进行颜色归一化,接着对划分好的训练集使用数据增强得到训练数据。在此部分的实验都只做了乳腺的良恶性二分类,使用Adam 优化算法更新网络权重参数,学习率为0.001,批大小为16,输入尺寸为224×224,迭代次数为500。

由图7 可知,如果在模型训练过程中没有对原始数据进行数据预处理和数据增强,最终展示的实验结果是:在训练集上的准确率很高,但是验证集上的准确率却比较低,并且会一直波动,不太稳定,即导致过拟合,最终在测试集上的平均准确率只有95.79%。然而,当原始数据经过数据预处理和数据增强之后,不仅在训练集上达到了很高的准确率,在验证集上亦是如此,并且测试集的准确率为98.92%。所以,由上述实验可知,在模型训练过程中对乳腺癌组织病理学图像进行数据预处理和数据增强可以避免过拟合,提高了识别准确率。

图7 训练和验证过程中的准确率变化曲线Fig.7 Accuracy variation curves during training and validation

3.2 参数选择与模型分析

在上述验证数据预处理和数据增强的有效性实验中,所采用的优化方法、学习率和迭代次数等参数只是一个初始选择的设置,可能并不是最适合模型的参数。因此,为了找到最优的参数设置,本文在BCSCNetⅠ模型上根据所设置的参数进行不同的实验对比,得到的结果如表4 所示。在其他参数设置都一样的情况下,分别使用不同的优化方法进行实验,实验结果表明,相较于随机梯度下降(Stochastic Gradient Descent,SGD),使用Adam 优化方法得到的平均准确率更高,并且在训练过程中收敛速度也是Adam 比较快。接着将其他参数固定不变,调整图像大小,得到当输入图像大小为224×224 时,模型准确率最高;然后再通过实验对比,分别得到最优的批大小为32,最优的学习率为0.000 1,最优迭代次数为500。当模型BCSCNetⅠ使用最优的参数设置时,二分类的平均准确率可以达到99.48%。

表4 调整不同参数得到的平均准确率Tab.4 Average accuracy obtained by adjusting different parameters

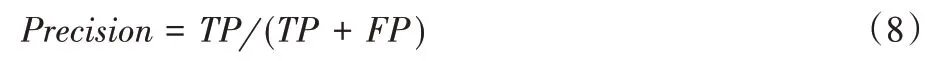

然后,将本文提出的三种模型BCSCNetⅠ、BCSCNetⅡ和BCSCNetⅢ的参数设置为上述实验得到的最优参数,进行二分类和多分类实验。在二分类实验中,随机选取了BreaKHis数据集中2 000 张良性病理图像和2 000 张恶性病理图像,并对选取的图像进行随机划分,然后进行数据预处理和数据增强。在多分类实验中,从BreaKHis 数据集的每一种亚型中随机抽取400 张图像作为多分类实验数据,同样对选取的图像进行随机划分,然后进行数据预处理和数据增强。以上数据都按照训练集、验证集、测试集7∶1∶2 的比例随机进行划分。实验结果如表5 所示。二分类:模型BCSCNetⅠ的准确率为98.81%~99.36%,BCSCNetⅡ的准确率为98.06%~99.32%,BCSCNet Ⅲ的准确率为99.05%~99.89%;多分类:模型BCSCNetⅠ的准确率为90.81%~92.33%,BCSCNetⅡ的准确率为91.29%~93.58%,BCSCNet Ⅲ的准确率为93.06%~95.72%。同时,还与DenseNet121进行实验对比,实验结果表明原始的DenseNet121 对乳腺癌组织病理学图像的分类准确率并不高,二分类准确率为90.01%~91.91%,多分类准确率仅为79.19%~83.30%,明显低于本文方法。

表5 不同模型对于不同放大倍数图像的分类准确率Tab.5 Classification accuracies of different models for images with different magnifications

由实验结果可知,本文提出的乳腺病理图像分类模型BCSCNet,由于融合了空间和通道的特征信息,所以表现出来的分类准确率高于没有插入SE 模块的原始DenseNet121;并且,因为BCSCNetⅢ不止将SE 模块插入到DenseNet 的过渡层中,还插入到稠密块中,因此BCSCNetⅢ可以把稠密块和过渡层的通道特征信息与空间特征信息融合,学习到了更多的图像特征,这使得该网络模型的性能比其他两个网络模型的性能更好。由表2 可知,加入SE 模块只增加较少的计算量,不会对网络的训练时间造成太大的影响。

以上实验表明,本文提出的乳腺癌分类模型BCSCNetⅢ通过调整参数,得到适合模型的最优参数设置,可以对乳腺组织病理图像进行高精度分类,在良恶性二分类和8 种亚型多分类都达到了很高的准确率,所以本文在乳腺癌分类算法中采用的BCSCNet网络模型为BCSCNetⅢ。

3.3 与其他方法的对比分析

为了证明本文方法的优越性,将BCSCNet 与其他乳腺癌组织病理学图像分类方法进行二分类和多分类实验的对比。在以下的实验分析中,BCSCNet 与其他分类方法所使用的数据集都为乳腺癌组织病理学图像数据集BreaKHis。

3.3.1 二分类

二分类实验的对比结果如表6 所示。明涛等[22]提出多尺度通道重校准模型,利用ResNet 设计了一种卷积神经网络msSE-ResNet,该实验在公开数据集BreaKHis 上开展,对乳腺良恶性二分类达到88.87%的准确率,并且可以对不同放大倍数下获取的病理图像具有较好的鲁棒性;Spanhol等[12]利用AlexNet提出了一种用于乳腺病理图像二分类方法,识别准确率最高可以达到90%;Wei 等[14]提出了一种先进的数据增强方法和一种基于深度卷积神经网络GoogleNet 的新型乳腺癌组织病理学图像分类方法(BiCNN),该方法具有较高的分类准确率(97%左右);Han 等[23]提出一种新的基于类结构的深度卷积神经网络(Class Structure-based Deep Convolutional Neural Network,CSDCNN)的乳腺病理图像识别方法,在二分类中实验中具有95.7%~97.1%的准确率;Bardou等[24]设计了一种CNN 拓扑结构并利用数据增强进行二分类实验,最终获得的分类准确率为96.15%~98.33%;Jiang等[15]提出了一种新的学习速率调度器,并且利用小型SE-ResNet 模块设计了一种新的用于乳腺癌组织病理学图像分类的CNN 架构,命名为乳腺癌组织病理学图像分类网络(BHCNet),该方法对乳腺良性恶性的分类准确率高达98.87%~99.34%。

表6 BCSCNetⅢ和其他方法的二分类准确率对比 单位:%Tab.6 Binary classification accuracy comparison of BCSCNetⅢand other methods unit:%

同时,为了更加全面地对网络模型进行评估,将本文方法与上述性能较好的网络模型进行多种评价指标的对比,具体对比结果如表7 所示。二分类的实验结果表明,本文提出的模型BCSCNetⅢ相较于其他乳腺癌组织病理图像分类方法的分类准确率更高,并且通过对比F1 分数等其他指标,证明BCSCNetⅢ的整体性能优于其他方法。

表7 多种分类方法在不同分类任务中的评估结果对比 单位:%Tab.7 Comparison of evaluation results of multiple classification methods in different classification tasks unit:%

3.3.2 多分类

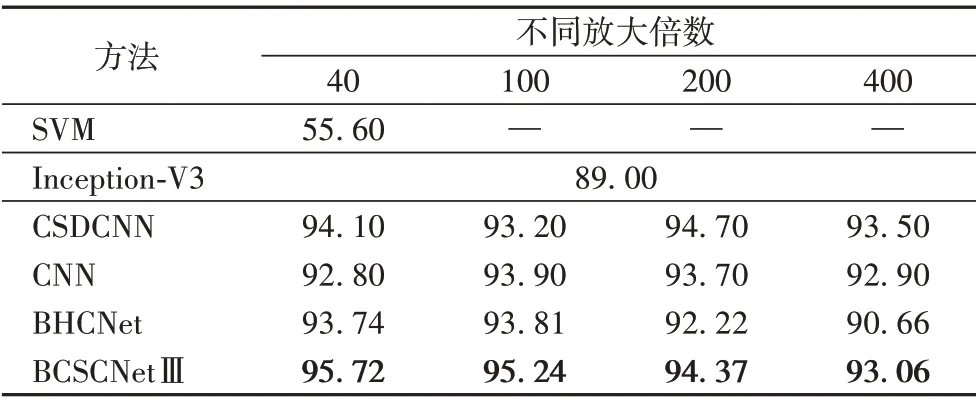

目前对乳腺病理图像进行多分类的研究较少,且识别准确率不高:Chan 等[11]利用支持向量机将乳腺癌肿瘤划分为良性和恶性的8个亚型,40倍放大因子的准确率仅为55.6%;詹翔等[13]基于改进Inception-V3 提出的病理图像分类方法在二分类的识别准确率达到了97%,但在多分类上只有89%;Han等[23]提出的CSDCNN 不止在二分类上表现出色,在多分类实验上也取得了显著的性能,达到平均93.2%的准确率;Bardou等[24]设计的CNN 拓扑结构在多分类实验中同样表现出较好的性能,准确率为92.8%~93.9%;Jiang 等[15]利用小型SEResNet 模块设计的乳腺癌组织病理学图像分类网络BHCNet进行多分类实验,在放大倍数为40、100、200、400 的图像数据上,获得的正确率分别为93.74%、93.81%、92.22%、90.66%。同样,在多分类实验中,除了将以上分类方法得到的分类准确率与本文方法进行对比,也将F1分数等其他指标加入到模型的评价指标中,详细对比结果可由表8得知。

表8 BCSCNetⅢ和其他方法的多分类准确率对比 单位:%Tab.8 Multi-class classification accuracy comparison of BCSCNetⅢand other methods unit:%

以上实验结果与分析证明,无论是对于乳腺癌组织病理图像的二分类任务还是多分类任务,本文提出的乳腺病理图像分类模型BCSCNetⅢ的整体性能都要优于BHCNet 等其他方法。由表2 可知,由于本文所采用的基础网络是DenseNet,相较于ResNet 和GoogleNet 等,网络参数降低了不少,并且SE模块的加入也没有给模型带来太多的参数负担,因此,BCSCNetⅢ只需增加少量的训练参数就可以给最终结果带来较大的增益。

4 结语

本文设计了一种融合图像的空间特征信息和通道特征信息的分类模型BCSCNet,并提出了一种乳腺癌组织病理学图像分类方法,该方法可以实现对乳腺癌组织病理学图像的高精度分类,包括乳腺良恶性二分类和乳腺亚型多分类。BCSCNet 基于CNN 模型DenseNet 和SENet,利用SE 模块学习DenseNet 模型中稠密块和过渡层的通道信息,并将学习到的通道特征信息与稠密块和过渡层所学习的空间特征信息融合,实现图像空间特征和通道特征的融合。根据SE模块插入的数量和位置不同,模型所学习的通道信息不同,可以将BCSCNet 分为BCSCNetⅠ、BCSCNetⅡ和BCSCNetⅢ三种。在此方法中,还使用了一种颜色归一化方法和不同的数据增强操作处理乳腺癌组织病理图像数据库BreaKHis,并通过实验验证了通过数据预处理和数据增强处理数据可以进一步避免模型训练过程中的过拟合以及提升分类性能。最终的实验结果表明,在本文提出的三种BCSCNet 网络模型中,BCSCNetⅢ表现的分类性能最好,二分类任务的识别准确率在99.05%~99.89%,多分类任务的识别准确率在93.06%~95.72%,并且通过与其他乳腺癌组织病理学图像分类模型进行对比分析,证明了本文所提出的乳腺癌组织病理学图像分类模型BCSCNet 的分类性能优于其他方法。在未来的工作中,可以研究不同设备观察到的病理图像,以及病理图像中存在细胞重叠的情况,还可以通过目标定位将病变的主要位置标记出来,使计算机辅助诊断可以满足临床应用的需求,更加有助于乳腺癌的治疗。