基于A3C的多功能雷达认知干扰决策方法

邹玮琦, 牛朝阳, 刘 伟, 高欧阳, 张浩波

(信息工程大学数据与目标工程学院, 河南 郑州 450000)

0 引 言

电子对抗是作战双方为保障己方优势,削弱对方实力而采取的各种电子措施和行动。在现代战场中,针对雷达的电子对抗扮演着越来越重要的角色,而干扰决策是雷达电子对抗领域的关键技术,其任务是对侦察环节所获取的威胁数据进行分析,快速准确地确定干扰决策,并通过评估环节不断调整干扰决策,有效完成干扰任务,极大减少对方雷达的威胁。

随着雷达发展趋于多功能与智能化[1-2],抗干扰能力增强,依赖于“匹配”以及“人为试错”思想的传统干扰决策方法[3-4]决策效率低、准确率不高的缺点愈发明显。为了满足雷达电子对抗的需求,进行具有认知能力的干扰决策方法研究具有重要意义。为此,文献[5]将强化学习[6]中的Q-learning方法引入到雷达干扰决策中,使干扰系统能够通过自主学习确定最佳的干扰策略,但该方案仅适用于雷达工作模式数目已知的情况。因此,文献[7]针对雷达工作模式数目未知条件完成了智能雷达对抗设计过程,提高了雷达干扰系统的实时性与自适应性。在此基础上,文献[8]通过分析多功能雷达工作状态及对应干扰样式构建雷达状态转移图,仿真分析了各参数对干扰决策性能的影响,以及在新状态加入下的决策过程、转移概率对决策路径的影响。由于文献[7]和文献[8]所提方法随着多功能雷达可执行任务个数增多而时间效率逐渐下降,文献[9]将深度Q网络(deep Q network, DQN)引入到多功能雷达干扰决策中,DQN是Q-learning算法与深度学习的结合,直接使用神经网络替代传统表格生成 Q 值,在处理大量状态空间和动作空间时具有明显优势,从而提高了多功能雷达认知干扰决策的时间效率。在干扰决策整体过程中侦察环节、决策环节以及评估环节都需要时间,然而目标方雷达执行任务时间是有限的,双方的对抗稍纵即逝,因此提高时间效率依旧是认知干扰决策的关键。文献[9]在雷达任务数量为25的条件下循环200次的决策完成时间约为40 s,仍然难以满足雷达对抗决策的高实时性要求。针对此问题,在充分研究多功能雷达工作模式和任务转换关系的基础上,本文提出了一种基于异步优势行动者-评论家(asynchronous advantage actor-critic, A3C)的认知干扰决策方法,设计了包括干扰机模型、环境模型(目标方多功能雷达)及其交互机制的认知干扰决策整体框架,制定了干扰决策流程。

1 A3C基本原理

A3C算法[10]是Mnih等在异步强化学习(asynchronous reinforcement learning, ARL)理论基础上提出的一种轻量级深度强化学习算法。该算法引入多线程的概念,使得多个智能体同时进行训练,极大加快了训练速度,同时利用异步的方式,确保每个线程的初始状态和探索方向不同,使得各个线程中样本相关性降低,从而稳定算法,使得该算法在一些领域有着较好表现[11-12]。

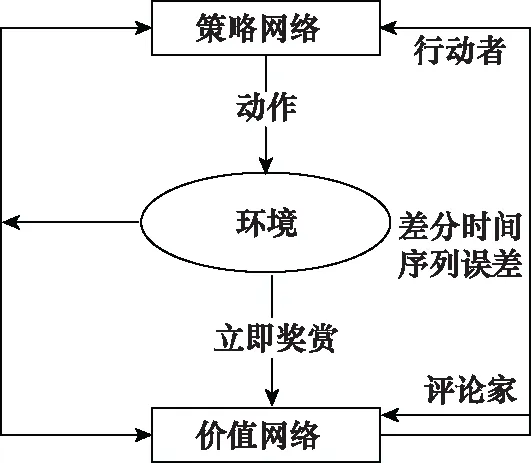

A3C算法在各个线程中延用行动者-评论家[13](actor-critic, AC)算法与深度神经网络相结合构成的AC网络(AC network, ACN),利用深度神经网络的优势使其有利于处理大规模状态空间和动作空间的任务,具体结构图如图1所示。

图1 ACN结构图Fig.1 ACN structure diagram

ACN利用策略网络和价值网络分别表示策略函数和值函数:

(1) 策略网络π(at|st;θ)是用来更新学习模型的策略,计算在状态st所采取动作的概率分布,即行动者部分。其中,θ为策略网络参数。

(2) 价值网络V(st;θv)用来评价在状态st执行动作at的优劣,即评论家部分。其中,θv为价值网络参数。

ACN在进行策略更新的时候,平等对待每一个状态动作对,然而在训练过程中,每一个状态动作对的重要性是不一样的。针对此问题,A3C算法在ACN结构基础上引入优势函数用于评价当前状态动作对的优势。优势函数公式如下:

(1)

式中:rt+i表示即时奖赏;γ∈[0,1]为折扣因子,代表未来奖赏对于累计奖赏的重要程度,当n=1时,其为1步回报优势函数,当n=k时,其为k步回报优势函数。该算法策略网络和价值网络的损失函数如下所示:

(2)

(3)

式中:R表示智能体在当前状态下依据策略选择动作所获得的回报值;V(st;θv)表示该状态下的值函数。

为防止过早收敛到局部最优,A3C算法将策略交叉熵加入到策略网络损失函数aloss中,保证策略进行广泛搜索。

(4)

式中:H(π(st,θ)),为策略交叉熵;c为熵系数,用于控制熵的正则化强度。

2 基于A3C的认知干扰决策方法

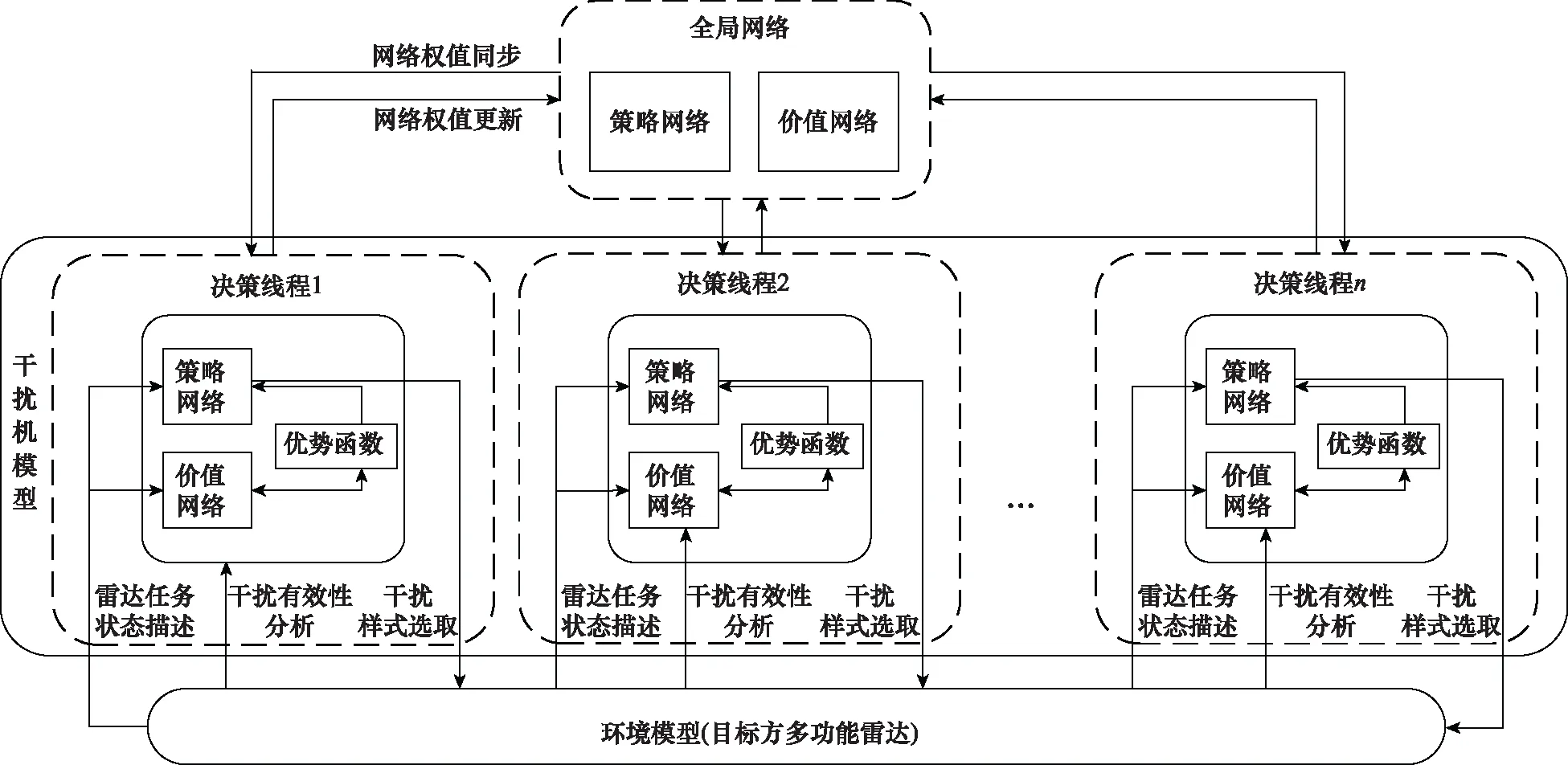

由于A3C算法有利于处理大规模状态空间的任务,并且具有多线程处理能力,计算速度快。本文将A3C强化学习算法应用于认知干扰决策领域,设计了认知干扰决策整体框架,具体如图2所示。其主要包括全局网络以及多个干扰线程。全局网络相当于是一个中央大脑,将各个干扰线程网络参数进行汇总分发。干扰线程包括干扰机模型、环境模型(目标方多功能雷达)以及交互机制,干扰机模型通过干扰样式选取、雷达任务状态描述以及干扰样式有效性评估3个途径与环境进行交互训练。

图2 认知干扰决策整体框架Fig.2 Cognitive jamming decision-making overall framework

2.1 全局网络

全局网络由两部分组成,一是策略网络,其功能是在当前雷达任务状态st下,计算所采取的干扰样式at;二是价值网络,其功能是对当前雷达任务状态st下所采取的干扰样式at进行评估。全局网络与各线程网络具有相同结构,但全局网络自身不进行训练,依托于各个线程中的干扰机模型独立与环境交互进行训练,其仅存储各个线程中干扰机模型策略网络和价值网络的网络参数,同时将自身的网络参数同步至各个线程中的干扰机模型。

2.2 干扰线程

如图2所示,干扰线程主要包括干扰机模型、环境模型(目标方多功能雷达)及其交互机制。

2.2.1 干扰机模型

干扰机模型包括价值网络和策略网络。价值网络的输入为雷达任务状态,输出为采取干扰样式的值函数,并依据值函数与对应回报值得到优势函数。策略网络的输入为多功能雷达某时刻所执行的雷达任务状态以及优势函数,输出为干扰机所采取的干扰样式。策略网络基于概率采取相应干扰样式,然后价值网络判断策略网络采取干扰样式的好坏,策略网络再依据评价值调整网络参数。

2.2.2 环境模型(目标方多功能雷达)

环境模型描述目标方多功能雷达被策略网络输出的干扰样式干扰后,雷达任务的变化情况。当干扰机模型实施选定的干扰样式后,雷达任务状态便发生了相应的变化,为更有效表明干扰前后雷达任务状态的变化情况,本文采用文献[9]中雷达任务关系转换表的方式建立环境模型。

2.2.3 干扰机模型与环境交互机制

各个线程内干扰机模型与环境之间的交互机制主要包括干扰样式选取、雷达任务状态描述和干扰样式有效性评估3个途径。

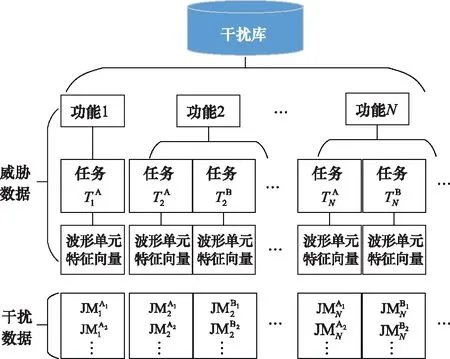

(1) 干扰样式选取

干扰机所采取的干扰样式来源于干扰信息库,其基本结构如图3所示。干扰信息库主要包括雷达威胁数据以及干扰机干扰数据,其中雷达威胁数据部分主要依据多功能雷达信号层级模型[14-15],包括雷达功能层、雷达任务层以及相应波形单元特征向量,负责提供目标多功能雷达的威胁信息。由于当雷达处于不同功能不同任务时,其波形单元不相同,干扰机所采取的干扰样式不尽相同,因此干扰数据部分为雷达的具体功能和任务下对应的有效干扰样式集合。

图3 干扰信息库基本结构Fig.3 Basic structure of jamming information library

(2) 雷达任务状态描述

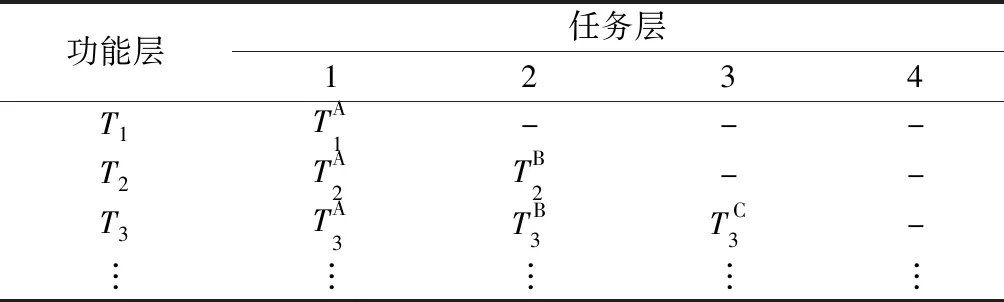

依据多功能雷达信号层级模型构建雷达任务关系表,如表1所示。

表1 雷达任务关系表

当侦测到多功能雷达某时刻执行雷达任务状态,获取该状态下功能层对应的数值(即x值)以及任务层对应的数值(即y值),得到其当前状态坐标值(x,y),并利用当前状态坐标值与目标状态(雷达威胁等级最低)坐标值的差值描述雷达任务状态st。

(3) 干扰样式有效性评估

文献[9]利用雷达任务的转换关系来对干扰样式进行有效性分析。对于多功能雷达而言,其雷达任务有着一定的优先级排序,雷达任务的优先级越高,则意味着其对乙方的威胁等级越高。如果干扰机实施选定的干扰样式后雷达任务的优先级(即威胁等级)降低,则选定的干扰样式有效;如果雷达任务的威胁等级未发生变化或者升高,则选定的干扰样式无效。

文献[9]奖励函数仅将雷达威胁等级变化设置为上升和下降两种状态,未考虑威胁等级数变化不同的情况,因此本文对奖励函数进行修正,将变化的威胁等级数与对应的奖赏值相对应,使得奖励函数的设置更加准确,能够更有效体现采取干扰样式的有效程度。具体设置如下:

(5)

式中:Tn→Tend表示雷达威胁等级转变至最低的状态;Tn→Tn表示雷达威胁等级维持不变;Tn→Tn-i表示雷达威胁等级升高i个等级;Tn→Tn+i则表示雷达威胁等级降低i个等级。

(4) 交互机制

综合上述3个途径,任意干扰线程内干扰机模型与环境交互机制具体如下所示。

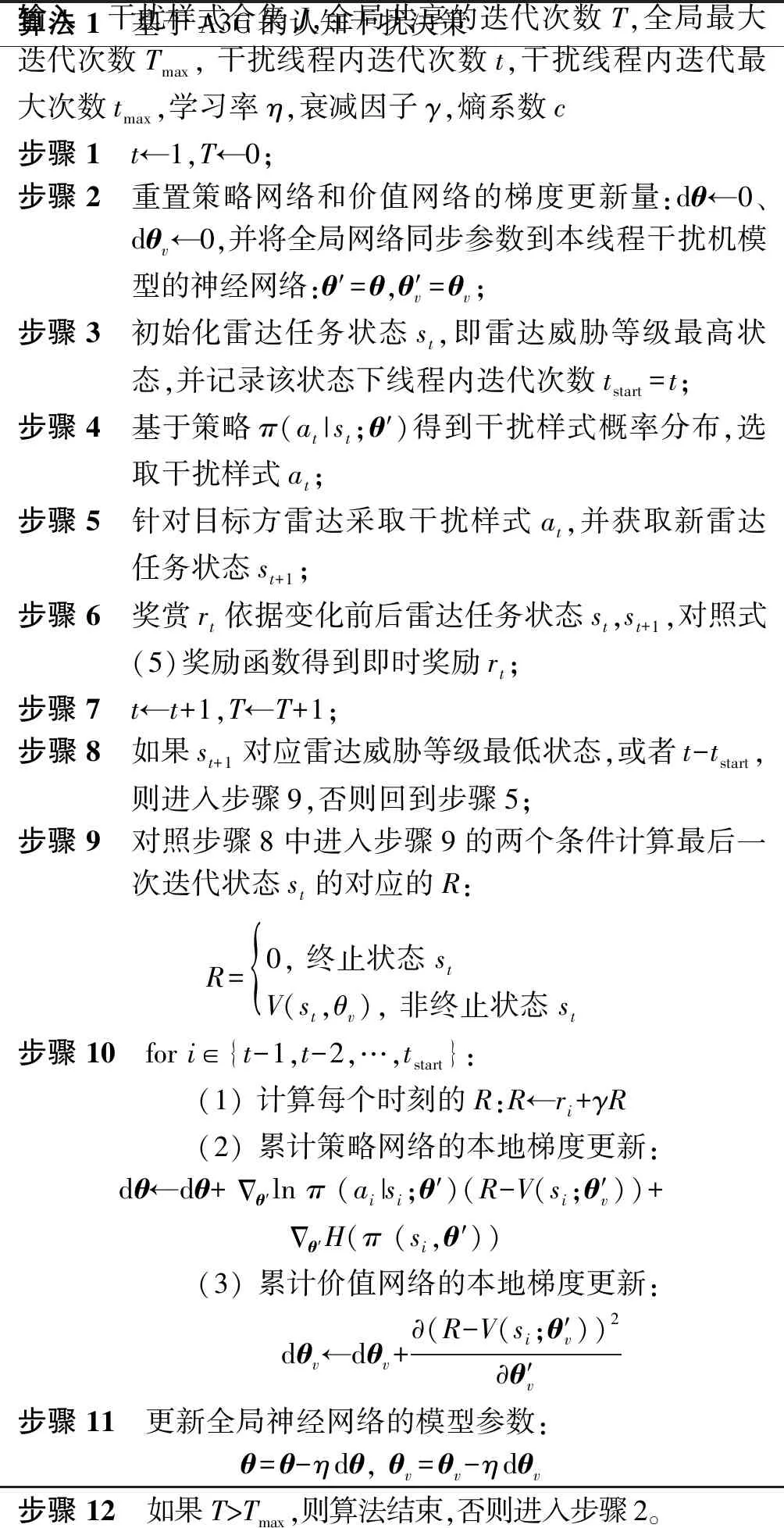

算法 1 基于A3C的认知干扰决策输入 干扰样式合集J,全局共享的迭代次数T,全局最大迭代次数Tmax, 干扰线程内迭代次数t,干扰线程内迭代最大次数tmax,学习率η,衰减因子γ,熵系数c步骤 1 t←1,T←0;步骤 2 重置策略网络和价值网络的梯度更新量:dθ←0、dθv←0,并将全局网络同步参数到本线程干扰机模型的神经网络:θ′=θ,θ′v=θv;步骤 3 初始化雷达任务状态st,即雷达威胁等级最高状态,并记录该状态下线程内迭代次数tstart=t;步骤 4 基于策略π(at|st;θ′)得到干扰样式概率分布,选取干扰样式at;步骤 5 针对目标方雷达采取干扰样式at,并获取新雷达任务状态st+1;步骤 6 奖赏rt依据变化前后雷达任务状态st,st+1,对照式(5)奖励函数得到即时奖励rt;步骤 7 t←t+1,T←T+1;步骤 8 如果st+1对应雷达威胁等级最低状态,或者t-tstart,则进入步骤9,否则回到步骤5;步骤 9 对照步骤8中进入步骤9的两个条件计算最后一次迭代状态st的对应的R:R=0, 终止状态 stV(st,θv), 非终止状态 st {步骤 10 for i∈{t-1,t-2,…,tstart}: (1) 计算每个时刻的R:R←ri+γR (2) 累计策略网络的本地梯度更新:dθ←dθ+Δθ′ln π (ai|si;θ′)(R-V(si;θ′v))+Δθ′H(π (si,θ′)) (3) 累计价值网络的本地梯度更新: dθv←dθv+∂(R-V(si;θ′v))2∂θ′v步骤 11 更新全局神经网络的模型参数:θ=θ-ηdθ, θv=θv-ηdθv步骤 12 如果T>Tmax,则算法结束,否则进入步骤2。

上述基于A3C的认知干扰决策方法能够形成一个实时的闭环结构,干扰机模型能够与环境模型进行自主交互并形成有效干扰决策,表明该方法具有可靠性。同时,该方法为提升时间效率采用了异步的思想,每个干扰线程中干扰机模型的初始状态和探索方向不同,通过共同探索并行计算策略梯度,对参数进行更新,能够最大化探索多样性,确保该方法的稳定性。

3 仿真实验

本文仿真实验环境在个人计算机上搭建,其处理器为Inter(R)Core(TM) i7-10875H CPU@2.30 GHz,拥有8个内核以及16个逻辑处理器;GPU为NVIDIA GeForce RTX 2080,算法采用Python语言和PyTorch深度学习框架进行编写。

本文基于A3C的认知干扰决策方法采用自适应矩估计(adaptive moment estimation, Adam)梯度下降法来进行网络参数更新,具体参数设置如下:学习率η=0.01、一阶矩估计衰减率β1=0.9,二阶矩估计衰减率β2=0.99、超参数ε=10-8,折扣因子γ=0.9。该方法的异步更新方式如下:实验利用16个线程加速训练,每10步或者当前回合结束更新一次网络参数。基于DQN的认知干扰决策方法设置学习率为η=0.01,折扣因子γ=0.9,记忆库总量为2 000,每隔200步估计值网络的参数并传递至真实值网络。Double DQN和Prioritized Replay DQN是DQN的两种改进算法,依据文献[9]的思路将其应用至多功能雷达对抗的认知干扰决策中,作为本文新方法的对比对象,参数设置与基于DQN的认知干扰决策方法一致。

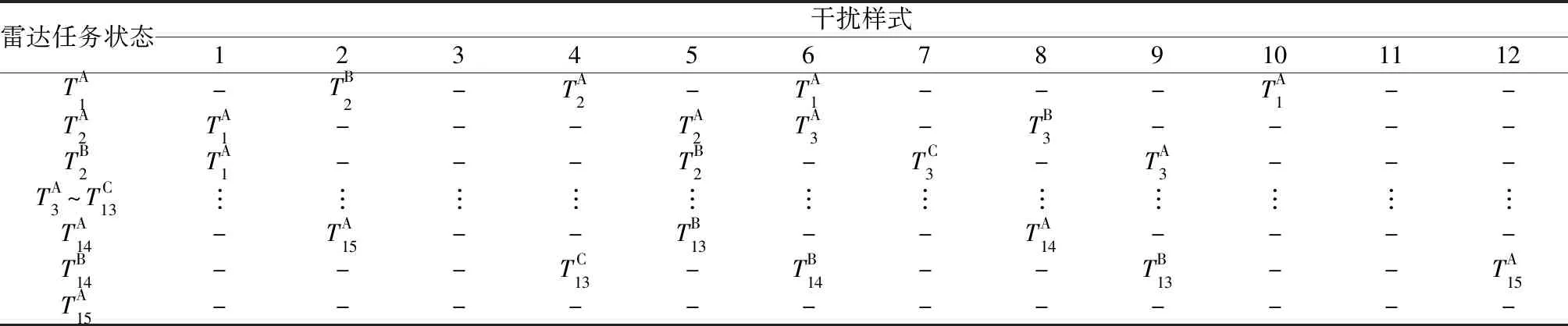

为讨论本文所提方法在雷达任务复杂情况下的决策性能,将文献[9]的雷达任务转换关系表的雷达威胁等级由11个扩充至15个,如表2所示。依据该表进行10次独立实验,每次实验模拟5 000个回合,并对比分析本文所提方法和基于DQN的认知干扰决策系列方法(DQN、Double DQN和Prioritized Replay DQN)的模型训练时间和移动平均奖赏相对值。

表2 雷达任务转换关系表

3.1 模型训练时间

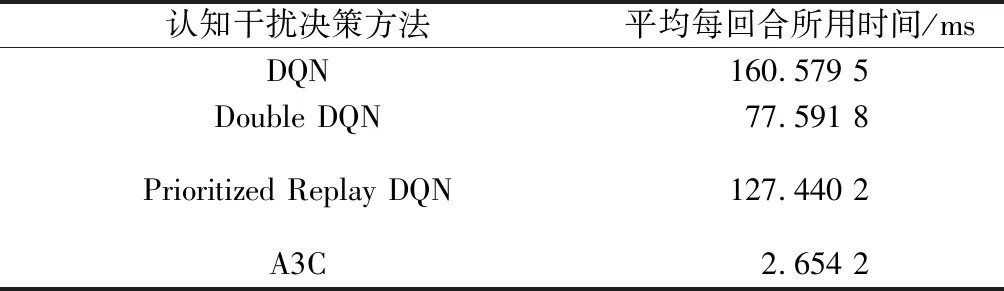

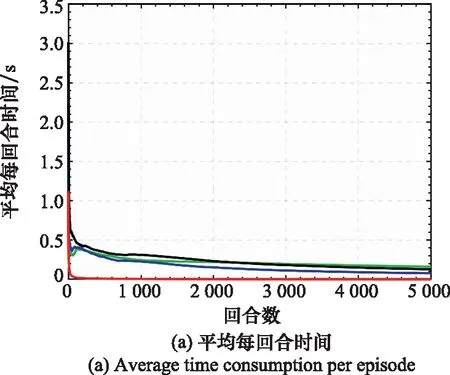

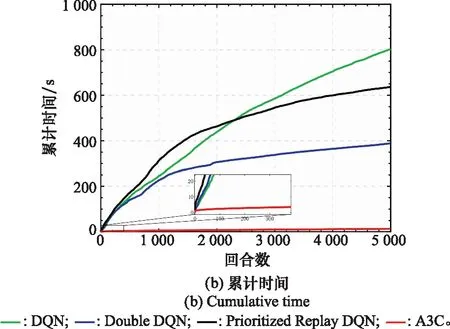

表3数据为不同方法的平均每回合所用时间,图4为不同方法的5 000回合模型训练时间对比图,其中图4(a)为平均每回合时间,图4(b)为累计时间。

表3 平均每回合所用时间比较

图4 模型训练时间对比图Fig.4 Comparison diagram of model training time

从表3中可以看出,相较于基于DQN的认知干扰决策方法,其他3种认知干扰决策方法的平均每回合所用时间均有一定的降低,其中本文所提方法优势最明显,将平均每回合所用时间降低约40%。

从图4(a)可以看出,基于A3C的认知干扰决策方法从一开始平均每回合时间便大幅度低于基于DQN的认知干扰决策系列方法,并在整个阶段保持明显优势。分析原因,基于A3C的认知干扰决策方法具有多线程处理能力,相当于多个干扰机模型并行工作,相较于单线程方法而言优势更加明显,能极大提高时间效率。并由图4(b)局部放大的小图可以看出,该时间曲线并不是线性的,与基于DQN的认知干扰决策系列方法相似,都是类似对数的变化趋势,干扰机模型在工作过程中随着回合数的增加,所获得经验不断积累,每回合所采取的有效干扰样式逐渐减少,相应每回合所用时间不断降低。

综上所述,本文所提方法在雷达任务复杂情况下极大提高了时间效率,更能够满足雷达对抗高实时性要求。

3.2 移动平均奖赏相对值

定义移动平均奖赏如下:

Ri=βRi-1+(1-β)ri

(6)

式中:Ri为当前回合移动平均奖赏;Ri-1为上一回合移动平均奖赏;ri为当前回合奖赏值;β为权重因子,此处取0.99。为使移动平均奖赏能够更直观呈现,本文采取移动平均奖赏相对值,其定义如下:

Rrv-i=Ri/Rmax

(7)

其中,Rrv-i为当前回合移动平均奖赏相对值;Rmax表示单次回合奖赏的理论最大值。移动平均奖赏相对值越高,表示干扰机模型每回合在进行决策的过程中有效干扰样式更多,表示其决策准确度更高。

由于在训练的过程中,网络参数不断更新,非常小的变化都可能导致下一阶段的决策产生大的变动,导致移动平均奖赏相对值在不同回合阶段会出现不同程度的波动,因此本文采取进行10次单独实验最后取平均的方式来反映总体趋势。

图5为不同方法的移动平均奖赏相对值曲线图。由图5可得,在1 500回合之内,本文所提方法相较于其他方法而言有着大幅度的优势,在1 500回合之后,两种改进的DQN认知干扰决策方法逐渐靠近本文所提方法,但基于DQN的认知干扰决策方法效果依旧不理想。分析原因,由于DQN算法存在训练效率低、过估计以及记忆能力有限等缺陷,导致相应方法在雷达任务复杂情况下效果不理想。Double DQN和Prioritized Replay DQN在DQN算法的基础上进行改进,效果有着一定的提升,本文所提方法则在引入优势函数以及策略交叉熵的同时,利用异步的方式确保每个线程的初始状态和探索方向不同,最大化干扰机模型探索环境的多样性,并且能够降低数据的相关性,提升该方法的稳定性,使得决策准确度有明显提高。

图5 移动平均奖赏相对值对比图Fig.5 Comparison diagram of moving average reward relative value

综上所述,在雷达任务复杂情况下,本文所提方法有着更好的决策准确度。

从综合模型训练时间以及移动平均奖赏相对值的对比可以看出,在雷达任务转换关系表扩充条件下,本文方法与基于DQN的认知干扰决策系列方法相比,极大地提高了时间效率,平均决策时间降低30倍以上,同时在移动平均奖赏相对值中所展现的决策准确度上也有明显优势。由此可以看出,在雷达发展趋于多功能化以及雷达对抗趋于智能化的背景下,本文所提方法更能够适应高实时性的复杂雷达对抗环境。

4 结束语

在雷达对抗领域,雷达越来越趋于多功能化和智能化,对认知干扰决策的时间效率和决策准确度要求更高。对此,本文提出一种基于A3C的认知干扰决策方法。研究表明,该方法能够在雷达任务数量更为复杂的情况下,极大地提高时间效率,并在决策准确度上有着明显优势。

在认知干扰决策领域,进一步提高实时性、缩短对抗时间是关键所在,同时针对雷达态势识别和干扰效能评估也是下一步的研究重点。