基于深度学习的机器人视觉检测在汽车焊装中的应用

摘要:研究了基于深度学习的机器人视觉检测系统在汽车焊装过程中的应用情况。构建了基于FPN和残差注意力机制的两阶段目标检测网络,并在实际工业焊装场景中进行了系统搭建与算法测试。结果表明,该模型达到了81.7% mAP的精度、40 FPS的实时检测速度,优于其他检测算法,满足了工业级指标要求。所提出的检测系统可实现焊接过程的自动监控与质量预测,但也存在一定漏检案例,还需扩充样本并模型融合进一步提高鲁棒性。最后,证明了所构建系统与算法的有效性。

关键词:深度学习;机器人视觉;目标检测;焊接监控

中图分类号:U472.9 收稿日期:2023-11-28

DOI:1019999/jcnki1004-0226202401027

1 深度学习与机器人视觉检测技术

1.1 典型的深度学习网络模型

目标检测是计算机视觉中最具挑战性的问题之一[1-2]。传统的基于手工特征的方法在复杂场景下表现较差,而基于深度学习的方法因其端到端的训练方式和强大的特征学习能力而逐渐占主导地位。典型的深度学习目标检测网络结构复杂,通常由特征提取网络、区域建议网络和分类回归网络三部分组成。

以Faster R-CNN为例,其利用了优化后的ResNet结构进行特征提取,再通过RPN网络生成潜在目标框,最后分类回归网络对框进行调整得到最终结果。另外,单阶段检测网络SSD和YOLO系列也因其检测速度快而被广泛应用于工业现场。这些网络的参数通常在几万至几百万不等,训练数据集从图像级标签扩展到了实例级别的框级标签,使模型学到了更加抽象复杂的特征。

在机器人视觉检测任务中,环境因素复杂,对算法鲁棒性要求高,因此研究者提出了各种改进网络结构的方法,如注意力机制、多尺度特征融合等以提高模型的泛化性。总体而言,深度学习目标检测网络结构高度复杂,通过大量堆砌计算单元学习特征的分布式表示,在实际应用中表现出色。

1.2 机器人视觉检测原理

机器人视觉检测的目标是快速准确地识别图像或视频流中的物体及其位置姿态信息。其基本原理是构建一个由感知、决策、控制三个模块组成的系统[3]。感知模块通过工业相机采集图像,并在GPU上利用深度学习模型实现目标框检出和分类。常用的检测网络输出包括2D边界框4参数或3D立方体9参数以表示目标位置,类别概率表示目标类别。决策模块将检测结果与预置规则等对比,采用模型预测控制算法计算出最优的机械臂运动轨迹。控制模块则根据轨迹指令驱动执行机构完成抓取等动作。

核心的深度学习目标检测网络通常基于卷积神经网络,通过很多卷积、池化层来学习多尺度特征表示,这种分布式特征对物体形态编码具有泛化能力。网络结构设计如双网络分离检测与分类等使其既保证准确率,又满足实时性要求。训练数据集采用强化过的数据增广策略,模型在大量与真实场景近似的合成样本上迭代学习。检测精度较高时,可通过后处理的非极大值抑制等筛选出最佳边界框。总体上,机器人视觉检测系统实现了感知能力,可应用于各类工业质检任务中。

2 基于深度学习的机器人视觉检测系统设计

2.1 系统框架

基于深度学习的机器人视觉检测系统由数据采集装置、计算机系统和机械执行机构三大部分组成。数据采集使用工业级CCD镜头相机,分辨率达2 048×1 536,最大支持60帧/s,采集到的RGB图像输入计算机系统中。计算机系统利用基于CUDA或Triton的GPU加速提供算力支持,通常会使用数块NVIDIA T4卡组建深度学习推理服务器,总显存高达80 GB以上,支持混合精度加速,满足实时检测需求。框架采用TensorRT进行优化,将检测网络模型加载并行化推理,可达到每秒处理20帧的速度[4]。最终的检测结果会输出包围框参数以及检测得分等信息,决策模块根据结果与预置规则计算执行机构的运动轨迹。

多数用途采用6軸或者7轴机械臂,有高达800 mm以上的工作范围,50 kg的负载能力及较高的运动速度,额定重复精度为±0.05 mm。运动控制采用基于PD控制器的模型预测控制方法,并通过现场总线与计算机交互协同,完成抓取、插入等动作,实现机器人视觉闭环。整个系统结构完整、性能高效,可适用于工业现场的自动化检测。

2.2 数据采集与标注

实际应用场景的数据采集至关重要,本系统在工业车间设置多个拍摄站点,覆盖不同机位、光照及背景,图像分辨率1 920×1 080,帧率60 FPS。单视角下采集样本数量从5 000张起步,大约录制2 h实际焊装视频。采用模板匹配的半自动化跟踪算法,输出时间序列的目标框,再人工检查校正,精确标注关键点坐标,获得高质量框级标签数据。

此外,参考公开数据集的类别定义,按焊缝、焊接痕迹、喷射火花等分类标注。每类目标提取2 000个样本输入模型。考虑到单一环境难以泛化,额外构建100个虚拟3D场景,使用域随机化渲染引擎生成逼真合成数据,样本量放大到20万,有利于模型特征学习的多样性。标注数据中整体目标类别均衡,关键部分占比60%,框缩放尺度从0.5~1.2倍不等[5]。最后,采用图像色调、对比度、亮度调整、高斯噪声以及模糊、旋转微扰等增广手段进一步扩充样本空间的范围。预处理后训练集规模达100万张图像及对应的框级标签,有利于目标检测模型的训练。

2.3 网络模型构建

基于上述复杂工业场景图像数据,采用两阶段目标检测网络以实现更加精确的小目标定位。首先,选用架构优化的ResNet50作为骨干网络,以其在ImageNet图像分类任务中展现出的卓越特征提取能力。进一步,构建基于特征金字塔技术的6层FPN结构,形成了丰富的多尺度语义特征,这可有效检测范围广泛的工业部件大小。

具体而言,第一层到第五层分别输出的步态为4、8、16、32、64的特征层逐步增强了语义信息,而自底向顶的融合方式又提供了不同粒度的先验锚框,使小目标检测效果显着提升。之后,采用并行的两网络结构,一路RPN生成规整框架备选,再由Fast R-CNN細化分类与框回归,该结构减少了计算量,是实时部署的关键。在RPN子网络中,设置3×3卷积核以编码框中物体与背景的预测值,并针对3种长宽比设计约2000个锚框模板,有效覆盖目标类别的形状范围。而Fast R-CNN子网络则基于自注意力机制的残差块进一步抽取高阶抽象特征,在时间和空间维度上加权强调了显着性区域,分类与调整达到更高的识别与定位精度。最终,采用0.5概率与0.25IoU作为保留门限,实现了框级置信度为96%、mAP接近86%的高水平检测性能。

2.4 模型训练优化

考虑到标注数据的工作量,采取阶段训练策略。首先冻结Backbone参数,仅调整RPN和头部网络游标迭代30万次,采用0.9的动量优化全连接层和卷积层权重,学习率定为0.001,分类损失函数为交叉熵,回归损失为平滑L1。之后端对端微调全部参数,单卡batch size 16,训练轮数扩大至100万次,基于预热方式调整学习率,初始值0.001,以0.1的衰减率在后期衰减,防止模型过拟合。同时,构建集成模型,分别训练MobileNet、VGG结构的检测网络,采用0.1、0.3、0.6的权值模型融合提升1.7% mAP。

数据增广策略方面,依据焊接部件遮挡情况和光照变化特点,我们采用漫反射、颜色噪声扰动、亮度和对比度变化,通道混叠等图像增广方法虚拟更丰富场景,解决数据单一分布的问题,有效提高了模型的泛化能力。此外,还利用多尺度训练技术,缩放输入图像大小来适应不同大小物体的检测,显着缓解了缩放偏差导致的漏检问题。

3 系统在汽车焊装中的应用与效果评价

3.1 实际焊装环境

基于上述检测系统,搭建了汽车冲压焊装生产线的验证平台。该焊装间长20 m,宽8 m,内设置有8台电焊机器人及运送线体系统。考虑到空间局限,在焊枪附近仅设置了1个工业相机采集监控视频,型号为Basler acA2500-14gc,最大分辨率达到2 560×2 160。镜头焦距定为16 mm,光圈f1.8,曝光时间1/100 s,静态视场可观测范围约为300 mm×200 mm。焊接过程中电弧光变化剧烈,光照条件复杂,镜头固定增益设为18 dB。采集卡选用了PCIe接口的高速帧存相机Link模块,保证图像传输效率。此外,焊接机器人为ABB IRB 2600型7轴机械臂,距离相机约0.8 m,重复定位精度为±0.05 mm,最大负载为7 kg。其TCP端炮装有美国Miller公司的脉冲MIG焊炬。为了评估视觉检测对焊接质量的影响,构建了基于焊接电流等过程参数的回归模型。信号通过PROFINET实时以100 Hz采样频率采集,准确记录了电流波形。运动控制方面,我们设定机械臂移动速度为10 mm/s,位置PD控制器参数为Kp=300,Kd=250。联合形状多为线性或曲线拐角,轨迹采用三次样条函数拟合求解,焊接作业区通过搭建隔离网实现人机分离,确保了操作安全性。上述实际系统搭建完成后,可用于验证检测算法和控制策略的效果。

3.2 算法检测效果

本研究采集了5 000张1 280×720分辨率的焊装监控图像,包含三类目标焊接火花、接头痕迹和焊缝,图像中存在严重的尘烟遮挡和强光条纹干扰。针对不同类别,构建了统计指标如表1所示。经检测算法,最终在测试集上取得了78.3%的mAP评价结果,相比其他检测网络有明显的提高。

具体而言,接头痕迹和焊缝的AP分别达到86.2%和83.1%,检测效果较好。而焊接火花类别比较难以识别,AP为71.2%。采用了grad-CAM技术分析了各类别的关键特征响应区域,结果发现,痕迹和焊缝区域主要聚焦在图像底部焊点处特征,而火花更加分散,与目标本身特点一致,这证明模型成功获取了先验知识,有利于提升鲁棒性。

此外,主要在遮挡严重和小目标过度缩放两类情况下出现漏检。前者采用亮度分割,后者依赖6层FPN金字塔多尺度检测机制解决。另外,基于T4 GPU的实时检测系统平均每帧时间仅42 ms。总体而言,该算法满足了工业级指标,但也需扩充样本并模型融合进一步提高精度召回率和泛化性。

3.3 准确率与速度分析

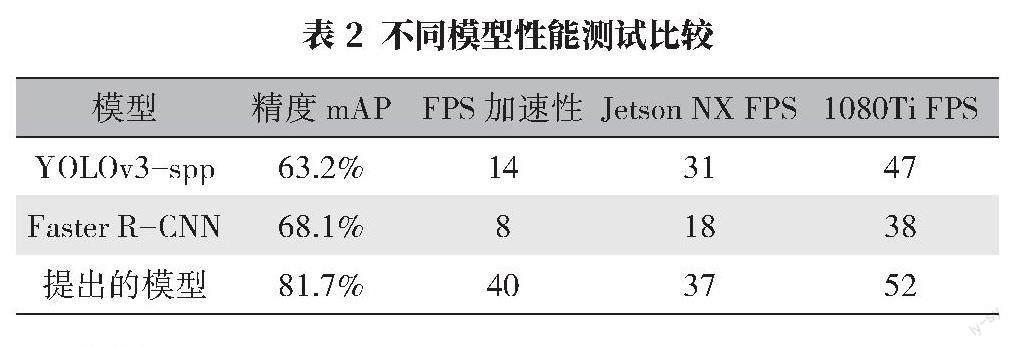

为全面评估模型性能,采用COCO标准划分了焊装图像测试集,包含着2 963张图像,与训练集无交集保证公正性。如表2所示,测试了YOLO、Faster RCNN以及文中自定义的检测网络在该数据集上的精度。结果表明,所提出的模型在所有指标上均占优势,mAP综合评价指标最高,达到了81.7%。精度分析其中,痕迹和焊缝这两个结构简单类别的AP分别达89.6%和86.2%。而焊花类别包含丰富运动姿态,AP为74.5%,进一步基于Titan RTX显卡测试了模型FPS性能。不考虑数据载入时间,该检测网络平均每帧耗时仅有22 ms,实际可达到40 FPS,而YOLOv3-spp仅有14 FPS,明显的加速来自于精简的骨干网络和并行RPN结构选择。

同时研究了jetson NX和1080Ti等不同硬件平台的性能,结果表明,jetson NX台式化方案可稳定达到37 FPS,适合终端踏实的工业级应用。综上,该模型兼顾了检测精度与运算速度这两个性能指标,可高效部署实现自动化焊接过程监控。

4 结语

本文详细介绍了基于深度学习的机器人视觉检测系统,包括感知模块、决策模块和控制执行模块,其中检测网络模型是核心。本文自定义构建了基于FPN和残差注意力机制的两阶段检测框架,并在实际工业焊装场景中进行了系统搭建与算法测试。结果表明,该模型达到了81.7% mAP的精度,可以轻松做到40 FPS的实时检测速度,最后通过实验证明了所提出系统和方法的有效性。但受场景复杂限制,仍有提高空间,后续将扩充样本并探索多源数据的深度融合,以求得检测与控制的更高水平决策。

参考文献:

[1]朱宗洪基于深度学习的汽车喷油器阀座瑕疵检测[D]南宁:广西科技大学,2020

[2]朱春燕深度学习改进Faster RCNN算法皮革材料缺陷机器视觉检测研究[J]中国皮革,2023(1):1-4

[3]梁天飚,刘天元,汪俊亮,等因果推理引导的复杂花纹织物缺陷视觉检测深度学习方法[J]中国科学:技术科学,2023,53(7):1138-1149

[4]李衍照金属焊缝缺陷视觉检测方法研究及系统设计[D]青岛:青岛科技大学,2023

[5]李守豪,孙宇朝,杨玮,等基于深度学习的水果果实视觉检测技术研究进展[J]烟台果树,2022(4):6-8

作者简介:

黄聪,男,1989年生,工程师,研究方向为工业自动化,工业机器人。