自然光线环境中的空间物体快速识别和定位算法研究

江 励,熊达明,汤健华,黄 辉

(五邑大学智能制造学部,广东 江门 529099)

0 引言

新冠肺炎疫情发展至今,不少人工智能防疫应用涌现。在医疗手术、诊治、体温检测、配送和消毒杀菌等众多场景中,机器人能有效代替相关人员进行作业,从而减少或降低了很多不必要的风险。面对机器人代替人工越来越广泛的迫切需求,机器人需要更强的适应能力应对各种更加复杂的工作环境。机器人的自主抓取任务中,基于视觉的定位控制[1-3]已经能够在工业光源环境下较好的完成。但是,当将其放在日常光线环境下时,视觉定位精度往往会大幅度降低而导致任务失败,使得机器人的应用范围大大缩小。本文针对这一问题,提出一种新的智能抓取算法,能够有效改善光线变化对抓取精度所带来的影响。

通常来说,对于空间物体的自主抓取一般需要完成识别、实例分割和定位3个步骤。在目标物的识别与实例分割上目前主要采用的是深度学习算法,根据数据的形式可分为图像的识别与实例分割、点云[4]的识别与实例分割;然后分别利用图像和点云数据进行目标物体的定位。

图像的识别与实例分割[5],目前非常成熟,且应用广泛。彭秋辰等[6]提出了采用双目实例分割与定位的方法,需要将左右目分别做识别和实例分割,再对实例分割的结果用ICP[7]算法进行视差计算,完成对目标物体的识别、分割和定位,取得了不错的效果。但该方法仍然受限于环境光源的影响,同时双目所产生的大量图像数据需要强大的计算力才能够实时计算出结果,实验结果测距误差理论值达到2%。Liu等[8]提出了基于单目视觉和图像编码的移动平台室内定位,定位方法需要事先对物体贴相应的标签而耗时耗力且定位精度不高。Ruan等[9]提出了平行双目立体视觉系统,取得了不错的效果,实验测试中单位距离最大误差达到1.695%,广泛应用于移动机器人的定位和地图构建等任务中。总体来看,目前基于视觉图像的定位方法,还是无法解决光线对定位精度的影响这一瓶颈问题。

点云的识别与实例分割中,Qi等[10-11]提出的处理点云数据的深度学习模型PointNet,已经能够较好做到点云的分割。PointNet模型是利用深度学习模型的方法直接对三维的点云进行分类和分割,这对场景分割来说非常实用。但激光雷达所产生的点云数据十分庞大,基于这些数据完成物体识别和实例分割需要庞大的计算力,导致该方法实时性较差,应用相对较少。

针对以上问题,本文提出了一种基于深度学习的视觉和光学雷达融合定位算法。该方法能够有效解决环境光线变化问题,同时大大降低所需计算力,能够较好地应用于机器人的智能抓取任务中。

1 目标物的识别与分割

1.1 目标物的识别

本文主要是通过在RGB图中识别并分割出目标物体,利用Mask R-CNN[12-13]框架开展目标识别和对象实例分割。如图1所示,卷积骨干架构用于特征提取,网络头对每个Rol单独应用边界框识别和掩码预测。

图1 用于实例分割的Mask R-CNN框架

为验证Mask R-CNN在通用对象实例分割方面的有效性,本文随机选择了10个物体不同组合地进行了100多次的识别率测试,结果如表1所示。

表1 识别率测试

结果表明Mask R-CNN有较好的识别率,识别与分割效果如图2所示,可以发现Mask掩码能很好地覆盖识别的物体。

图2 Mask R-CNN的识别与分割效果

1.2 目标物的实例分割

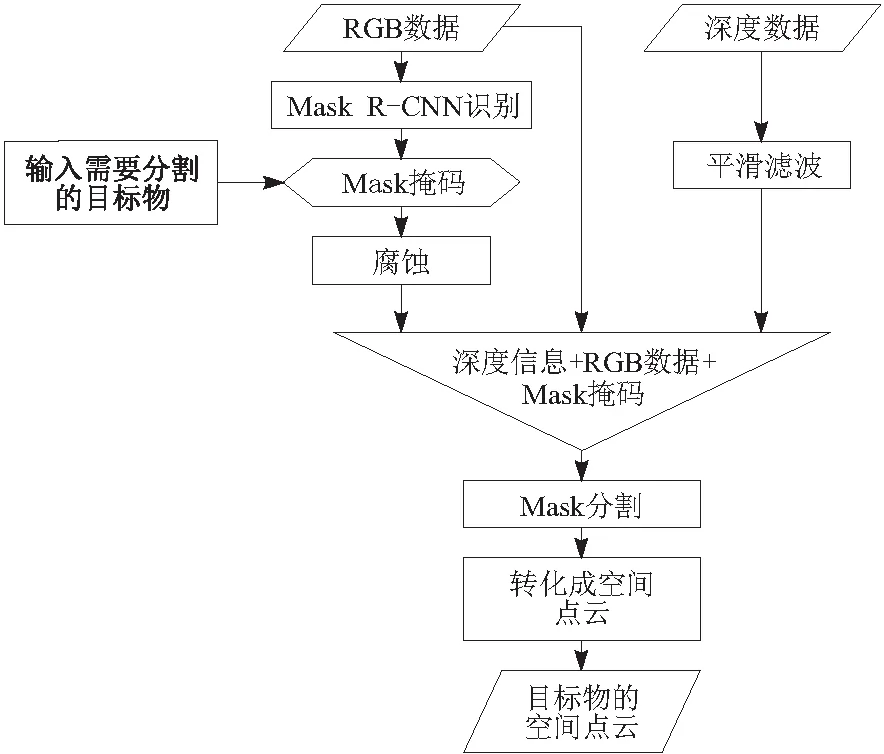

目标物的实例分割主要分为数据采集、掩码获取和Mask分割,流程如图3所示。

图3 目标物分割流程

本文同时采集同一场景下的深度图和RGB图,并且像素坐标是对应的。采集的RGB图经过Mask R-CNN算法后会得到3个输出,分别是目标的类别、包围框的位置和物体的掩码。另外,对传感器得到的深度数据进行了必要的滤波处理。

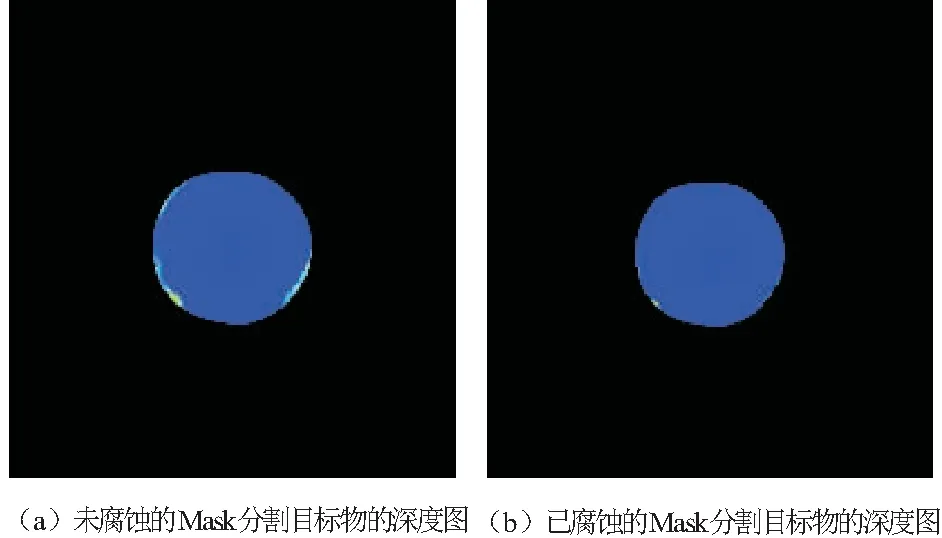

深度图的分割使用Mask掩码,由于RGB图像与深度数据对齐存在误差,所以需要对Mask进行腐蚀处理,以便分割区域完全落在目标物上,处理效果如图4所示。

图4 Mask掩码腐蚀对目标物深度图的效果

经过传感器获取RGB数据和深度数据与深度学习算法后,就完成了对目标物的识别与实例分割。

2 目标物点云的建立

2.1 点云模型的转化

确定物体的空间位置需要相应的点云数据,点云数据可由深度数据转化,即图像坐标系转换为世界坐标系。变换的约束条件是传感器内参,即

(1)

x、y、z为点云坐标系;x′、y′为图像坐标系;D为深度值。

在世界坐标到图像的映射过程中,考虑世界坐标点映射到图像点的过程,表示为

(2)

μ、v分别为图像坐标系下的任意坐标点;μ0、v0分别为图像的中心坐标;xw、yw、zw为世界坐标系下的三维坐标点;zc为传感器坐标的z轴值,即目标到传感器的距离;R、T分别为外参矩阵的旋转矩阵和平移矩阵。

传感器坐标系和世界坐标系的坐标原点重合,因此R为单位阵,T为零矢量,深度值z0与世界坐标系中的zw相同。

由以上的变换矩阵公式,可以计算得到图像点[μv]T到世界坐标点[xwywzw]T的变换式为

(3)

因此,利用此模型就可以将深度图上的二维点坐标转换成三维空间点。

2.2 建立目标物的空间点云

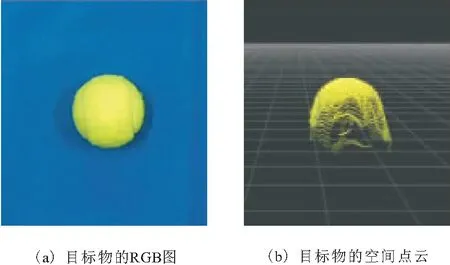

本文将实例分割完的目标物的深度数据,融合RGB信息,利用摄像机模型,即式(3)就可以将其每个二维点坐标转换成基于传感器坐标系的三维空间点,得到的效果如图5所示,这样得到了目标物空间位置的彩色点云数据。

图5 目标物的空间点云显示

3 目标物体定位

本文先用均值法和中值法综合计算分割获得的点云的几何中心,对目标物体进行较粗的空间定位,根据误差的分析对定位算法进行了修正,从而精准定位目标物体。

3.1 目标物粗定位

在均匀分布的点云中,均值法常用来计算重心,然而在不均匀分布的点云或有缺失的点云中,均值法并不能完全胜任求物体的中心。因此,本文通过几组数据分别用均值法和中值法与真实值进行对比,如图6所示,其中真实值是手动用刻度尺设定的物体位置。

图6 中值法和均值法对目标物中心各坐标测距和绝对误差

通过与真实值对比发现,在水平面的x轴方向和y轴方向使用均值法能更好地接近真实值。而在垂直的z轴方向中值法更能接近真实值,其中值法值与真实值相差无几,最大误差仅3.73 mm。

这主要是获取的目标物点云不均匀和不完整导致的,也是传感器单一视角拍摄所不可避免的。尤其在y轴方向越靠近传感器部分点云越密集,显然均值法无法近似为物体中心,而中值法却避免了这个问题。在水平面上的x轴和y轴方向,物体与环境的交接处有明显的拖尾现象,远离传感器中心轴部分的点云被拉长,此时用中值法无法近似物体中心,而均值法却可以消除部分误差。

如图7a,目标物在传感器的右下角位置,得到的目标物空间点云如图7b,可以发现,目标物点云存在明显的拖尾现象。这是由传感器的拍摄角度和深度数据的噪声以及滤波处理所造成的。经过多次实验发现,越偏离传感器中心轴拖尾现象越明显。

图7 目标物点云的拖尾现象

基于以上原因,粗定位采用综合算法即z轴方向采用中值法近似物体中心,x轴和y轴方向本文采用均值法近似物体中心。

3.2 综合修正算法对目标精准定位

虽然x轴和y轴方向用均值法近似物体的中心较为准确,但越偏离传感器中心误差也越大,也越无法满足抓取精度的要求。测试中的最大绝对误差为10.89 mm,因此,需要对近似值进行修正。

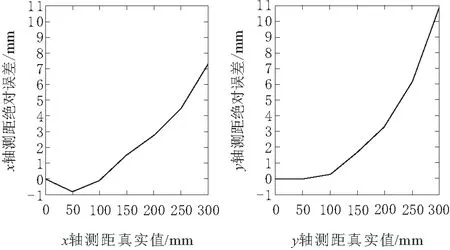

如图8所示,根据x轴和y轴测距的真实值与绝对误差的曲线,可以较为简单高效地将其拟合成二次曲线。

图8 固定水平面上各坐标轴均值法测距的绝对误差

首先,定义x轴的绝对误差为xer,即

xer=xm-xt

(4)

xm为x轴测距的中值法值;xt为x轴测距的真实值。令二次函数为

(5)

(6)

其次,为了得到修正值xa,本文将式(4)和式(5)中的xt用xa替代,即

xa→xt

(7)

从而可以计算得到x轴上的修正值表达式为

(8)

同理,y轴上的修正值表达式为

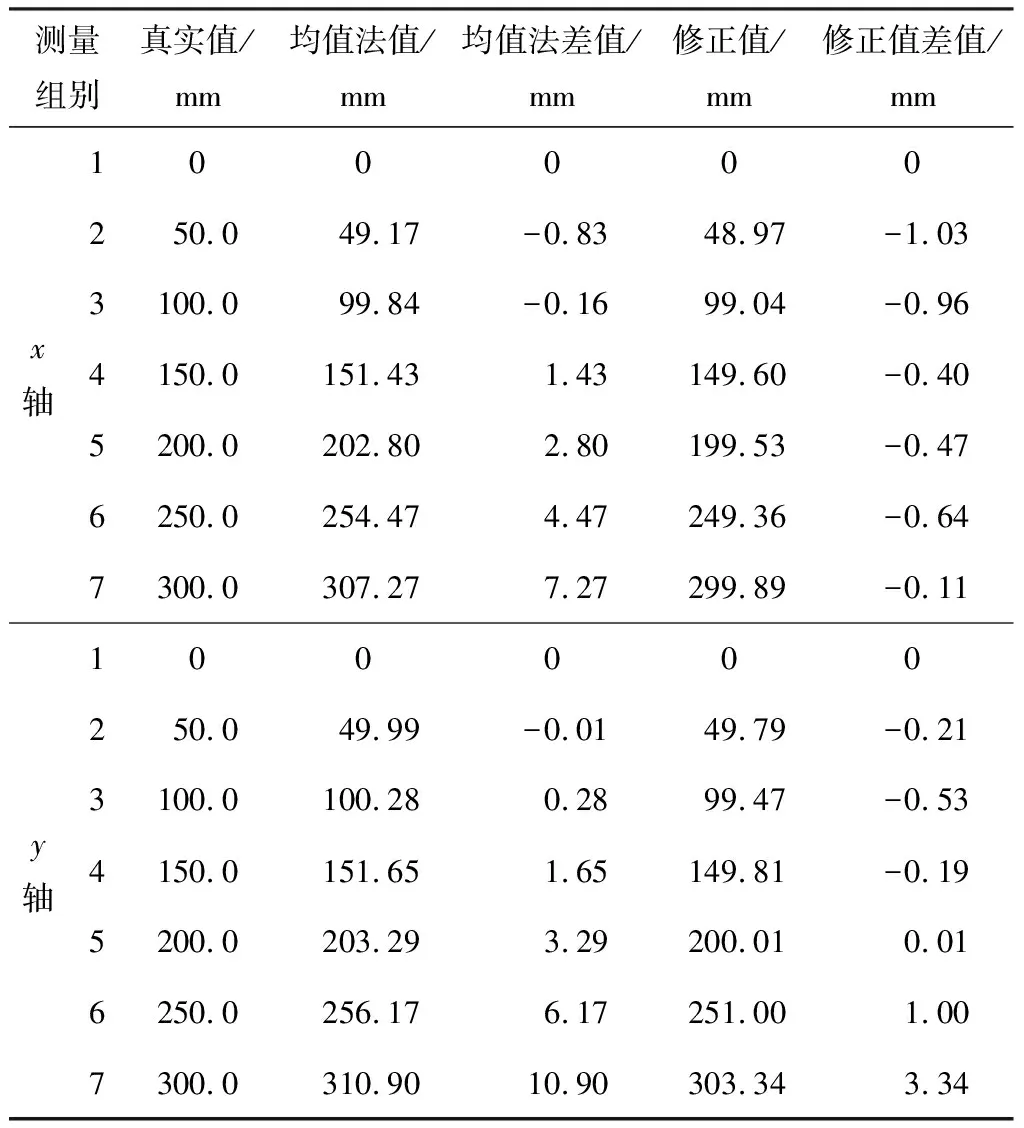

由此,可以计算得到固定水平面上各坐标轴测距修正值。为了直观比较真实值、原值和修正值,本文用7组实验数据绘制了表2。结果表明修正值能更好地接近真实值,最大绝对误差仅3.34 mm,与修正前的最大绝对误差10.90 mm相比,误差减少了69.4%,能满足抓取精度的要求。

表2 修正前后对目标物中心各坐标测距和绝对误差

4 实验

本文实验包含2个:第1个是基于本文算法对目标物定位的精度验证实验;第2个是环境光线对目标物测量精度的影响实验。

4.1 实验器材及运行环境

本文使用的传感器是Intel生产的Real Sense光学雷达摄像头L515,该设备含有RGB彩色传感器和固态光学雷达深度传感器,9 m深度误差为5~14 mm,适用于需要高分辨率和高精度深度数据的室内应用领域,可以同时获取场景内的深度信息及RGB信息。

另外,为验证精度,使用激光跟踪仪Leica AT930,如图9b所示。此款激光跟踪仪是一款精密、稳定的便携式三维测量设备。其他实验器材有可调光照度光源、照度计等。

图9 Leica激光跟踪仪AT930验证算法精度实验

实验程序运行的系统环境是Ubuntu ROS机器人操作系统,配备Titan X显卡,使用的执行器是Aubo i5机械臂。

4.2 对目标物定位精度的验证实验

在验证精度中,本文使用激光跟踪仪来进行对比验证。首先从Mask R-CNN识别并分割出物体点云,然后用修正后的综合法计算得到物体的中心坐标值,与此同时用激光跟踪仪Leica AT930记录L515传感器与目标物体的相对位置,并换算出物体的坐标值。

如图9a所示,首先进行激光跟踪仪坐标系与传感器坐标系的相对坐标系转换,使测量得到的物体坐标值在同一个坐标系下。然后在对角线上取5个具有代表性的位置放置目标物并分别测量,这5个位置分别离传感器坐标原点的距离为1 031.83 mm、937.46 mm、913.11 mm、952.23 mm、1 062.12 mm。最后用本文算法得到的值与跟踪仪测量得到的值用作精度对比,记录对比如表3所示。

表3 精度对比

由表3可以知道,综合修正法得到的定位坐标值与激光跟踪仪得到的测距值基本相吻合,差值波动在±5 mm范围内,z轴方向的波动较大,这是由于在深度上受目标物本身遮挡程度影响。整体上单位距离定位误差在0.5%以内,定位精度较高。

4.3 环境光线对目标物测量精度的影响实验

为了验证环境光照对目标物测量精度的影响,本文使用可调不同光照度的光源来测试测量结果。实验使用200 W、分20个挡位的LED灯源,通过照度计测得照在物体上的实际光照度。在不同挡位的光照下进行固定位置目标物的定位,如图10所示。

图10 可调光源与照度计测光照度

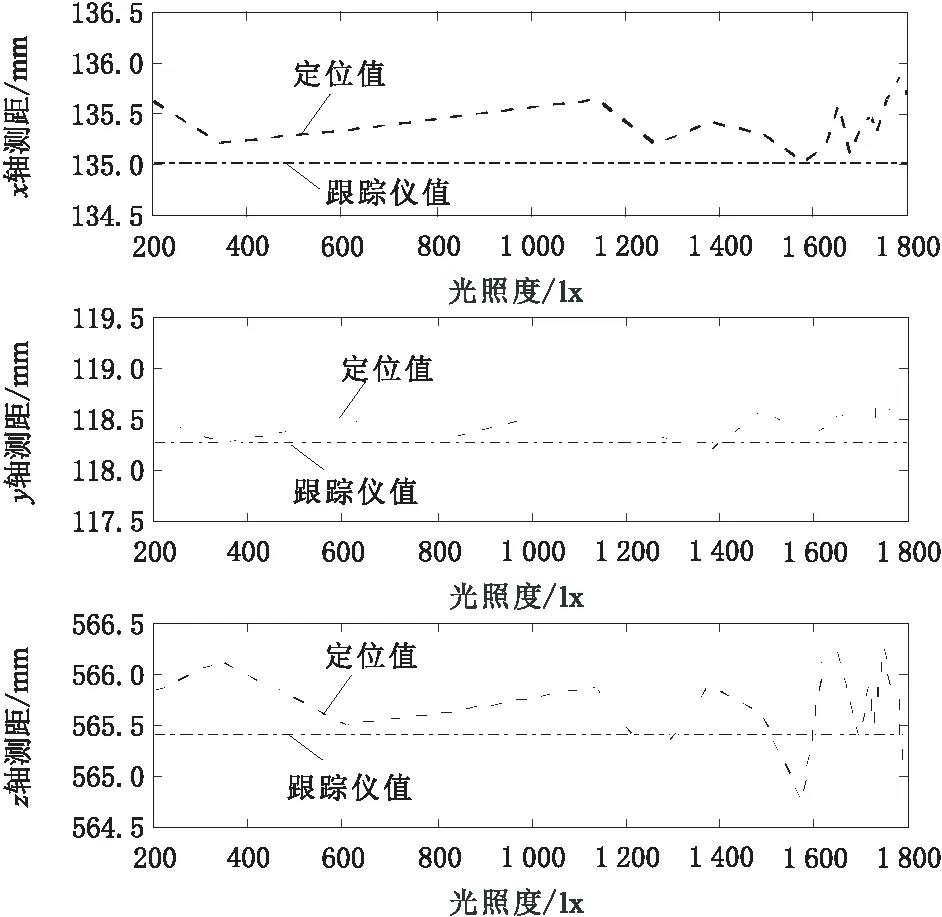

在不同光照度下依次获得固定目标物中心各坐标轴的对应值。光照度与目标物体坐标值的变化关系如图11所示。

图11 不同光照度下目标物中心各坐标测距及精度对比

由图11可知,不同光照度对目标物测量的精度几乎无影响,各轴测距的波动范围在2 mm内。在较弱的光照下,物体也能很好地被识别和精准定位。

5 结束语

本文在自然光线环境中使用了光学雷达深度传感器与深度学习算法相结合,以及用修正的综合法计算目标物的空间位置,达到了对目标物的识别、实例分割与三维空间定位的目的。该算法自主识别率高,空间定位精度高,受照明亮度影响小,单位距离定位误差在0.5%以内,增强了机械臂自主定位的实时性和实用性,对机械臂智能抓取的研究具有较为重要的意义。