基于深度学习的无人机飞行通道辅助系统研究

伍彩云翁 宇白 帆

(沈阳理工大学 装备工程学院,沈阳 110159)

穿越机是一种高动态无人机,体型较小,速度极快。 其通过机载摄像头拍摄的画面经过数字图传返回到屏幕显示端。 控制人员需要穿戴设备,以第一人称视角遥控无人机,并及时调整飞行姿态,以成功完成特定的飞行任务。 由于穿越机的高速运动、周围环境复杂多变等,控制人员无法迅速根据当前速度和环境情况判断航行方向,故飞行轨迹具有很强的随机性。 因此,对于穿越机类型的高动态无人机的研究,尤其是对提供给操作人员的飞行通道辅助系统的设计具有重要意义。

飞行通道辅助系统的设计中,路径规划算法的设计决定了系统的准确性和安全性。 现有的算法主要针对静态环境和动态环境,静态路径规划算法通常使用基于几何模型搜索的A∗算法、D∗算法等,能够快速生成高质量的路径[1-3],但不能应对动态环境下实时路径规划的需求。 相对于其他算法,基于人工势场法的路径规划算法结构简单、计算量小、反应速度快且规划结果安全可靠,适用于高动态情况下实时轨迹预测。 但传统的人工势场法存在容易陷入局部最优解、对障碍物形状敏感等局限性,需要寻找一种自适应能力强的算法解决单独使用人工势场法所存在的问题。

目前,在无人机路径规划的研究中,已有部分研究结果[4-9]。 文献[10]在航迹规划的基础上提出一种无人机安全通道概念,使用改进精英蚁群算法在二维空间进行仿真,将二维仿真转换到三维空间仿真。 文献[11]提出一种新的金字塔为基础的空间分割方法RAPPIDS,实现候选轨迹和环境之间的快速碰撞检测,实现在毫秒内评估数千个候选轨迹。 文献[12]提出的FASTER 算法通过使局部规划器在已知和未知空间中进行的优化获得高速轨迹,通过在已知空间中始终具有安全的备份轨迹确保安全性,在未知杂乱环境中可达到7.8 m/s 的速度飞行。 以上研究结果都存在运算量较大的问题。 深度学习算法是一种非线性建模能力强、自适应性强的智能算法,使用深度学习算法可以通过自适应学习调整参数,从而适应不同的环境和任务需求,提高计算效率。

为此,本文设计一个新的飞行通道辅助系统。提出一种基于景深的人工势场法作为约束实现网络的拟合,设计一个新的轨迹预测网络对无人机的飞行轨迹做出预测,得到当前位置下可能的避障轨迹,提供轨迹辅助指示,快速建立无人机的辅助通道。 该系统充分利用无人机位姿信息(位置、姿态、速度、加速度和坐标系信息)和视角图像,结合深度学习算法的优势,克服传统算法的局限性,使系统在算法复杂度降低的同时具有较高的计算速度,提高路径规划的准确性和安全性。

1 基于景深的人工势场法

传统的人工势场法在势场构建时需要进行全局搜索,涉及大量计算。 本文提出基于景深的人工势场法,使用图像的景深作为斥力场,目标位置和当前速度的合力作为引力场,取代势场构建过程,节省大量的计算资源。 同时使用无人机位姿信息作为引力场,使预测轨迹与当前无人机飞行状态的衔接更加平滑,操作人员可以操控无人机依次通过算法生成的推荐框,以实现无人机安全飞行。

1.1 传统的人工势场法

传统的人工势场法基于场的概念,将路径规划解释为在人工势场中设备受到目标引力和障碍物斥力的合力作用下生成的轨迹[13],通过求解无人机的目标引力和障碍物斥力确定的方程得到无人机轨迹点准确位置,从而得到路径规划的具体信息。

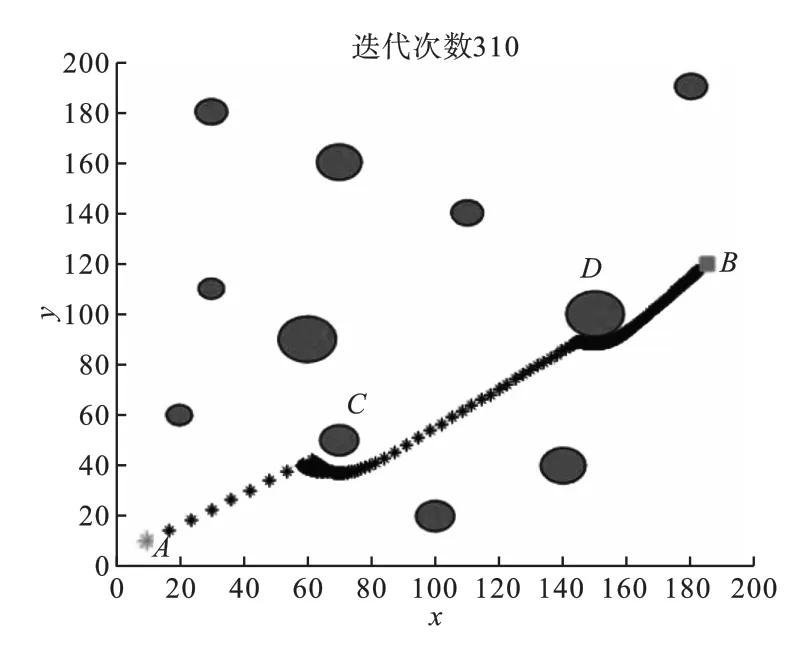

为了对人工势场法进行深入研究,本文分别建立如图1 和图2 所示的不同的势场环境,得到不同的路径规划结果。 图1 所示的实验1 中,无人机从A点出发,在350 次的位置迭代后,轨迹曲线绕过障碍物C和障碍物D,顺利到达目标区域B。

图1 人工势场法实验1Fig.1 The experiment 1 of artificial potential field method

图2 人工势场法实验2Fig.2 The experiment 2 of artificial potential field method

当无人机处于如图2 所示的实验2 环境下,无人机由A点出发,绕过障碍物C之后,在障碍物D、障碍物E及目标点B所构成的势场中,陷入了局部最小值,即使进行500 次迭代也无法通过障碍物通道继续飞行,无法达到目标区域。

实验结果表明,无人机在使用传统人工势场法进行路径规划时,仅使用了目标引力和障碍物斥力信息,无法通过狭窄通道,不能解决高动态无人机飞行通道设计问题。

1.2 单目景深的测试

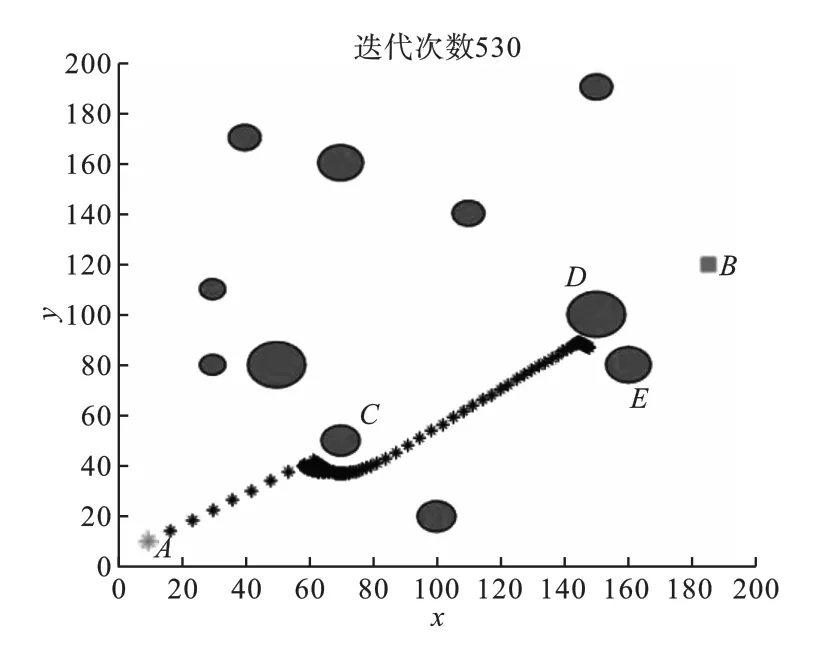

在深度图中,景深表示障碍物到相机的距离,可用以判断无人机是否能够在安全飞行的前提下通过该区域。 本文在相同场景下分别使用深度特征提取网络MiDaS[14]和Monodepth2[15]进行深度图预测实验。 预测结果如图3 所示,包括原图像与预选飞行通道、MiDaS 生成的深度图和Monodepth2 生成的深度图。 本文使用红色预选框标识深度通道可用作飞行候选通道的区域。 比较MiDaS 和Monodepth2 对原图进行的预测效果。结果表明,Monodepth2 的预测结果优于MiDaS,因此本文选择Monodepth2 作为景深势场的预测网络,并基于该网络的输出结果进行基于景深的人工势场法的设计。

图3 深度图预测实验Fig.3 The experiment of depth image estimation

1.3 基于景深的人工势场法

本文将人工势场中的景深梯度对无人机产生的斥力作为斥力势场,将速度方向和目标区域与无人机产生的势当作引力势场。 无人机在飞行过程中三维空间总势场通过引力Fatt和斥力Frep的合力F生成。 深度通道对无人机产生的引力势Uatt(X)为

式中:X代表无人机当前位置(x,y,z);XT是无人机目标区域的位置坐标(xT,yT,zT);ρ(X,XT)表示无人机当前位置和目标中心距离;ζ表示引力在合力中的权重系数。

无人机引力Fatt(X)为引力势场的负梯度,表示为

斥力势由景深对无人机的作用产生,斥力势使无人机远离深度值小的区域,其表达式为

式中:ε(x,xT)是当前深度和目标区域深度间的景深差;ε0是景深影响阈值,当前深度和目标深度差超过阈值,可认为无人机不能从该像素前面通过;η表示斥力势所占权重系数。

斥力势场对无人机产生的斥力Frep(X)表达式为

全局势场函数U以及无人机所受合力F如式(5)、式(6)所示。

相比传统人工势场法通过方程求解以寻找轨迹,本文采用神经网络,使用预测的方式得到斥力势,从而指导神经网络对轨迹进行预测,利用深度学习对景深势作用下的目标运动轨迹进行回归。

2 飞行通道辅助系统

2.1 飞行通道辅助系统结构

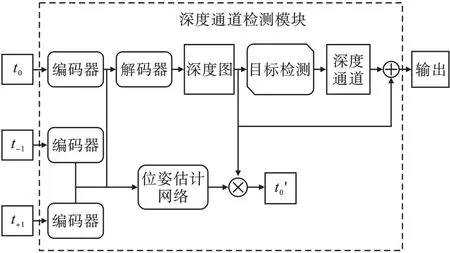

本文提出深度通道轨迹预测网络(DCTN),基于该网络,设计了飞行通道辅助系统,系统框图如图4 所示。 DCTN 主要包含两个子模块:用于获取的可飞行通道的深度通道检测模块(DMDC)以及用于确定飞行轨迹的平面投影及飞行轨迹预测(PMT)模块。 在飞行通道辅助系统中,单目相机获取到图像信息之后,经过DMDC 网络得到深度信息,与此同时,无人机的自主飞行控制器Pixhawk 对从惯性传感器(IMU)获取到的加速度信息进行处理,得到无人机的速度与位姿信息,然后PMT 模块将深度信息、速度与位姿信息进行调整并预测,得到无人机的飞行轨迹和推荐飞行通道,最后将推荐飞行通道传到OSD,反馈给无人机的操控人员,完成辅助飞行通道系统的任务。

图4 飞行通道辅助系统框图Fig.4 Block diagram of flight channel assistance system

2.2 DMDC 的设计

利用文献[16 -18]提出的目标检测网络,本文将深度估计和目标检测串联结合,提出一种DMDC 结构,如图5 所示。 通道检测模块由编码-解码器网络、位姿估计网络以及一个目标检测网络构成。

图5 DMDC 模块Fig.5 DMDC module

首先,单目相机获取t0、t-1、t1三帧图像信息传入DMDC 模块,从图像信息预测出当前帧的深度信息以及可飞行通道。 图像经过编-解码器网络后得到深度特征图,深度特征图传入目标检测网络获取可飞行通道的信息。 该目标检测网络设置为检测单类别且只保留大型目标信息,该模块的输出为带有深度信息的通道,基于此通道,进行用于PMT 的设计。

2.3 PMT 的设计

在DMDC 基础上,本文将人工势场法和深度学习相结合,提出了一种新的轨迹规划方法PMT,模块结构如图6 所示,通过PMT 预测当前位置下可能的避障轨迹,从而提高计算速度。

图6 PMT 模块Fig.6 PMT module

无人机上的IMU 获取到角速度传入Pixhawk,Pixhawk 解算出当前位姿和速度,将速度信息和深度通道信息进行数据预处理。根据在全局势场中的合力可以确定无人机运动的投影平面。在投影平面上使用深度学习算法进行轨迹点预测,从而对预测得到的轨迹点进行曲线拟合得到无人机的预测轨迹。 最后将预测轨迹与推荐通道在OSD 上与画面叠加显示,实现无人机的辅助通道推荐系统。

2.3.1 无人机信息预处理及轨迹平面投影

具体做法分为以下两个步骤。

1)从无人机IMU 获取速度信息表示在三维相机空间。 表示方法如下:将当前无人的速度状态在深度空间上做映射,在深度图中速度的大小及方向由三个映射点(V1、V2、V3)的疏密程度表征,速度值越大,三个坐标越密集,速度值越小,坐标表示越稀疏。

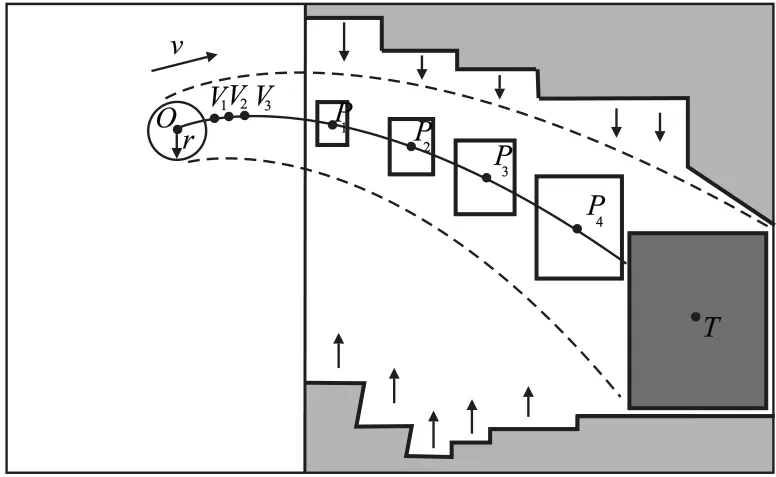

2)根据无人机在当前位置点(O)受到深度通道预测框中心点T以及当前表征速度矢量V的合力作为引力、景深梯度作为其斥力,可以在三维空间内确定一个二维平面,称为预测平面,此平面是将来无人机按照规划的轨迹运动的平面(平面可能不垂直于地面)。 路径预测及拟合将均在此二维平面完成。 平面的投影示意图如图7 所示。 投影平面的方程由三个点共同确定,后续轨迹预测将在此平面上完成。

图7 预测平面的投影Fig.7 Projection of the forecast plane

2.3.2 无人机轨迹预测网络的设计

由于无人机上一状态的速度方向和目标方向存在夹角,不能直接朝目标以直线飞行,需要拟合一条平滑的曲线,以实现无人机平稳到达目标区域的目的。 在预测平面使用深度学习算法预测出路径必经点,结合速度信息、深度通道信息共同进行曲线拟合得出最终飞行预测轨迹。 轨迹预测网络如图8 所示,由五层LDR 和一层LS 构成。LDR 是由Linear、Dropout 层与ReLU 激活函数构成,LS 是由Linear 与Sigmoid 激活函数构成。 预测网络输入O、V1、V2、V3、T的横、纵坐标以及需要预测的四个点(P1、P2、P3、P4)的横坐标。 输入为14 个节点,中间有4 个隐层,网络输出为预测飞行路径上的4 个点的纵坐标。 具体轨迹预测网络参数配置如表1 所示。

表1 轨迹预测网络参数配置Table 1 Trajectory prediction network parameters configuration

图8 轨迹预测网络Fig.8 Trajectory prediction network

轨迹预测得到P1、P2、P3、P4纵坐标,与坐标点O、V1、V2、V3、T结合,调序后将9 个点O、V1、V2、V3、P1、P2、P3、P4、T坐标作为无人机轨迹曲线约束点,使用最小二乘法对调整后的点进行5 次方的回归,得出对应的系数,完成方程的拟合。 根据方程,计算出1 000 个点的坐标,得出在当前画面上的预测飞行路径,此处称为C1。

2.4 训练损失

本文所设计的飞行通道辅助系统中,网络总损失可分成DMDC 模块损失和轨迹预测网络损失。

2.4.1 DMDC 损失

DMDC 损失主要分为两部分:深度图提取误差Ld和通道预测误差Lc。

深度提取模块的损失表达式为

式中:LP为第0 帧图像和重建图像的最小的光度误差;μ为LP损失占整体损失的比重;LS为视差平滑性损失;λ为LS损失占整体损失的比重。

通道预测误差使用目标检测损失衡量,具体损失Lc为

式中:Lobj为置信度损失;Lbbox为边界框损失。

整体深度通道模块的损失Ldc为深度图提取误差Ld和通道预测误差Lc的线性加权和,表达式为

2.4.2 PMT 模块损失

本文所设计的PMT 模块中,轨迹预测网络损失由预测面积损失LS1和监督面积损失Ls0两部分构成。

将OT的横坐标均匀分为1 000份,并以每一份的长度作为宽,以曲线上的点与直线上的点纵坐标差作为长,求对应纵坐标的矩形面积,然后将1 000 份矩形面积的离散积分和近似为真实面积,计算方法见公式(10)。 为使无人机以最快速度抵达目标区域,将预测出的路径C1 与直线OT所包围的面积与零做MSE 损失LS1,其表达式如式(11)所示。 其计算示意图如图9 所示。

图9 曲线面积计算示意图Fig.9 Schematic diagram of curve area calculation

式中:t代表1 000 个点中第t点;yC1t是预测曲线上第t点的纵坐标;yOTt是OT连线上第t点的纵坐标;xT为目标点在投影平面内的横坐标;xO为画面中心在投影平面内的横坐标。

只使用预测面积损失会导致网络为了快速收敛而直接使预测点落到OT直线上,故引入拟合曲线C2 和OT连线直接拟合面积SC2。 将SC2(计算方式见公式(12))作为目标,使其和预测面积做MSE 损失,得到轨迹预测网络的损失,表达式见式(13)。

最后轨迹预测网络的总损失为Lcp,如公式(14)所示。

整体网络的损失为Ldccp,计算方法如公式(15)所示。

上述,为提高操作人员在复杂环境下操控高动态无人机的反应容限、解决传统无人机路径规划算法自适应性差且需要解算大量运动学方程等问题,提出基于深度学习的深度通道轨迹预测网络,根据无人机视角给出实时推荐飞行通道。 由于使用神经网络预测得到推荐通道,能够节省大量的计算资源。

3 实验与分析

为验证本文所设计无人机辅助通道系统的有效性,将深度通道轨迹预测网络DCTN 部署在嵌入式平台Jetson TX2 上,将嵌入式平台搭载到无人机,实验设备如图10 所示。 在自定义的校园环境中进行测试,测试场景为环境复杂的树林。 从单目相机获得的数据中选取一张图像作为输入,如图11 所示。

图10 实验设备Fig.10 Experimental equipment

图11 单目相机获取的图像Fig.11 Images by a monocular camera

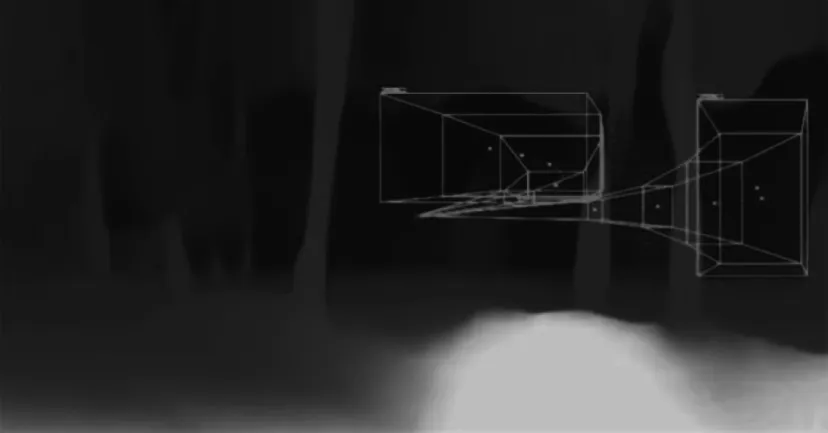

首先,对DMDC 的输出进行可视化,结果如图12 所示。 从可视化结果看出,该图为带有三个深度通道信息的景深图,DMDC 实现了检测深度通道的任务,并将所有检测出的通道作为无人机飞行备选通道。

图12 DMDC 的输出可视化Fig.12 The output visualization of DMDC

PMT 结合DMDC 的输出,并且将从IMU 获取的速度信息进行处理,得到带有辅助推荐通道及推荐飞行轨迹。

DCTN 网络整体输出第15 帧时,推荐给操作人员的飞行轨迹如图13 所示,图中检测框为飞行通道,由左往右共计四条。 DCTN 网络整体输出第17 帧时,如图14 所示,DCTN 网络推荐出两个深度通道及其预测飞行轨迹,对图中的每条轨迹,分别给出四个飞行辅助子通道,操作人员可任意选择一个深度通道,操控无人机依次通过该深度通道中的四个子通道到达目标区域。

图13 四通道的推荐飞行轨迹(第15 帧)Fig.13 The recommended flight path with four channels(15th frame)

图14 二通道的推荐飞行轨迹及飞行辅助通道(第17 帧)Fig.14 The recommended flight path with two channels and flight aid channel(17th frame)

分别将人工势场法和本文所提出的DCTN 算法在Jetson TX2 上进行部署。 其中,人工势场法和RAPPIDS 算法使用深度相机,本文算法使用白光相机,输入图像分辨率为640 ×480。 统计每个算法的100 个轨迹生成所用的时间,计算得到的单个轨迹生成平均时间如表2 所示。 其中,传统人工势场法的单个轨迹平均生成时间为220.9 ms,文献[11]中RAPPIDS 算法单个轨迹平均生成时间为2.49 ms,本文DCTN 算法单个轨迹平均生成时间为5.58 ms。 本文提出的DCTN方法单个轨迹平均生成时间与传统人工势场法相比缩短了39.58 倍。 与RAPPIDS 算法相比,虽然DCTN 算法所用时间略长,但由于DCTN 算法直接使用白光相机,不需要额外的深度信息,本文提出的方法能以较低成本达到与其相同数量级的响应时间。

表2 单个轨迹的平均生成时间Table 2 The average generation time per trajectory

上述实验结果表明,本文所设计的系统可以利用无人机位姿信息和视角图像实现轨迹预测,快速建立无人机的辅助通道,提供轨迹辅助指示,分析网络的推荐路线以及通道,使得操作人员根据环境情况对飞行方向迅速做出判断,能够减轻操作员的操控负担。

4 结论

本文提出了一种新的轨迹规划方法并设计了一个飞行通道辅助系统。 首先,利用单目深度估计算法预测目标的景深,以景深为基础检测出可飞行的深度通道,结合无人机位姿信息,引入人工势场的思想将景深信息作为斥力场,以无人机的位姿信息作为引力场,共同指导预测轨迹网络训练直至达到拟合,生成当前位置下可能的避障轨迹。 该系统与传统路径规划方法相比,不需要解算运动学方程,生成飞行通道由神经网络预测得出,从而节省了大量的计算资源,提升了路径规划的效率。 最后,在嵌入式平台Jetson TX2 进行实验,结果表明本文提出的算法在生成通道以及飞行轨迹方面均达到了设计要求,能够满足穿越机在高动态场景下的辅助应用需求。